《人工神经网络》第7章 联想记忆神经网络

联想记忆 AM(Associative Memory)是神经网络研究的一个重要方面,在许多领域被广泛应用。AM 作为人工神经网络的一种能力,就是将任意的输入矢量集通过线性或非线性映射,变换为输出矢量集。

7.1 联想记忆基本特点

7.1.1 联想记忆的原理

联想记忆网络存贮的是成对的矢量即模式对。设在学习过程中存入 M 个学习样本对 { Xi,Yi },i = 1,2,...,M,若输入样本为 X = Xk + α,其中 Xk 是 M 个存贮学习的样本之一,α 是噪声,要求输出:Y = Yk。因此联想记忆有两种情况:

(1)自联想记忆:存贮的学习模式对一样,即 Xk = Yk。此时,通过输入模式的一部分信息即可恢复模式的全部信息,此过程相当于滤波过程。

(2)异联想记忆:网络存贮的学习模式对不同,Xk ≠ Yk,即网络存贮了两个模式对之间的对应关系。异联想记忆实际上确定了输入模式与输出模式之间的对应关系,它在内容异址存贮、模式分类等方面应用广泛。

联想记忆的运行方式可以分为两类:

(1)映射式:即通过构造一定的映射(变换),使输入直接映射为所需的输出。感知机、多层前向网络、最优线性 AM 网络均属此类。优点是可用一定方法训练网络,现有的绝大多数学习算法均属此类。

(2)AM 按非线性动力学系统的演化过程进行:待识别的模式设为系统的初始状态,将网络按一定的动力学规律演化,网络最终平衡稳定的状态即为输出的模式。Hopfield 网络的联想记忆属于此类。

联想记忆研究的问题:存贮容量、容错性、稳定性、学习算法

以上问题解决之后,AM 网络具备以下能力:尽可能多地存贮输入输出模式对;强壮的鲁棒性和冗余性;并行性计算;分布式存贮;实时快速性;自组织性。

7.1.2 联想记忆的设计原则

联想记忆属于内容寻址过程,即当给定一组信息的部分信息时,可恢复出这组信息的全部内容。一个有效的内容寻址可以存贮大量的记忆样本,并且当用含有部分信息的关键信息去激励 AM 神经网络时,可恢复出每一个记忆模式。

7.2 线性联想记忆(LAM)模型

7.2.1 LAM 模型

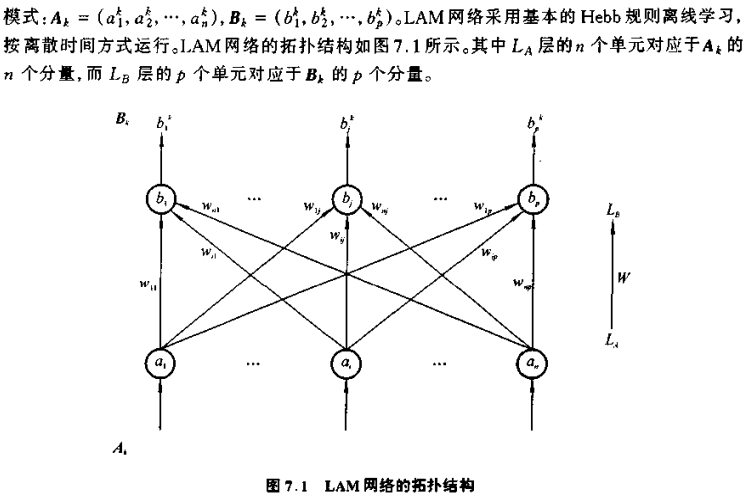

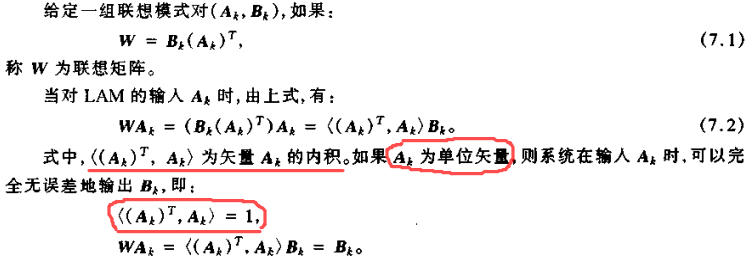

线性联想记忆(Linear Associative Memory),简称 LAM 网络。LAM 常用作异联想模式匹配器,能存贮任意模拟值模式对(Ak,Bk),k=1,2,...,m。在第 k 个模式对中,模拟值模式:

重要性质:

[ 定理 7.1 ] 对于联想记忆矩阵(7.1)式,LAM 要完成精确联想:

Bk = WAk

当且仅当输入模式 Ak(k=1,2,...,m)相互归一化正交(即输入矢量构成 m 维空间的一组正交矢量基)。

当输入模式相互归一化正交时,LAM 的学习等价于 Madalines 的 LMS 学习算法,此时的到的权值是最小二乘法意义下的最优解。与 LMS 算法不同的是,LAM 网络学习对输入模式提出更苛刻的要求,即输入模式必须相互归一化正交。在 LMS 算法中,只要求输入模式线性无关。然而,LAM 只需要一个学习周期就能获得要求的连接权(学习快),而 LMS 算法在合理的学习步长情况下,却需要相当多的学习周期才能近似获得要求的连接权(学习时间长)。

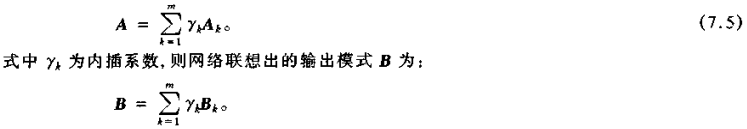

LAM 网络学习能形成内插模式匹配器,可由下面的联想相似性定理描述。

[ 定理7.2 ] 若输入模式 A 可以表示成相互归一化正交模式 Ak(k=1,2,..,m)的线性组合(内插):

LAM 学习的局限性:存贮的模式最大数为 n(LA 层的单元数),不能存贮模式对之间的非线性映射关系(是线性矩阵运算造成的)。

7.2.2 线性联想记忆算法步骤

线性联想记忆算法步骤:

(1)令网络初始连接权为零

(2)对第 k 个模式对(Ak,Bk),连接权的变化量为:

(3)重复步骤(2),当所有模式对都提供给网络后,结束学习。

7.3 双向联想记忆 BAM 模型

7.3.1 离散 BAM

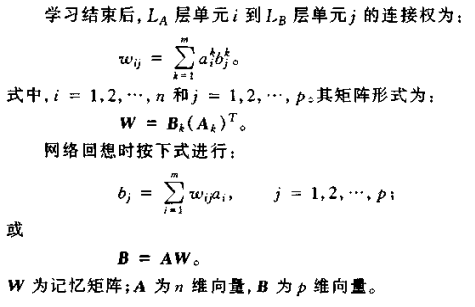

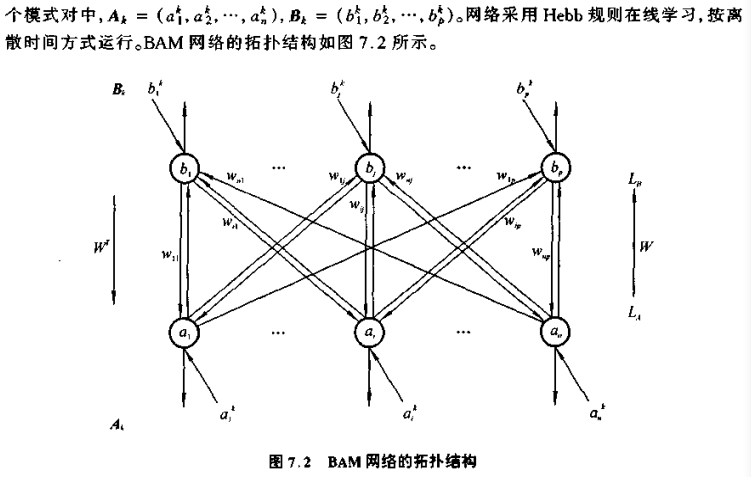

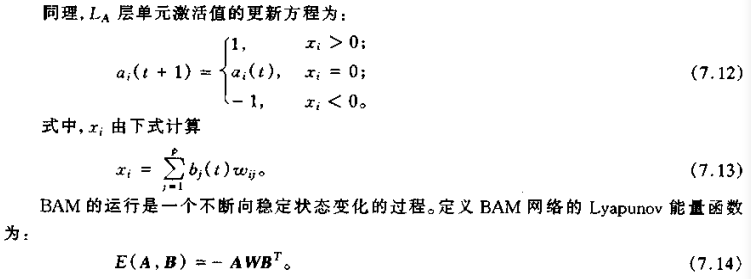

离散双向联想记忆(Discrete Bi-directional Associative Memory)简称BAM。BAM 网络用作异联想最邻近模式适配器,能存贮任意双极值或二值模式对(Ak,Bk)(k = 1,2,...,m)。第 k个模式对中,

图中,LA 层的 n 个单元对应于 Ak 的 n 个分量,而 LB 层的 p 个单元对应于 Bk 的 p 个分量。双向的含义是:可以用 Ak 联想出 Bk,或用 Bk 联想出 Ak;也可以用部分 Ak 和 Bk 联想出完整的 Ak 和 Bk。

[定理 7.3] 当 LA 层和(或)LB 层中某一单元激活状态发生变化时,BAM 网络的能量函数减小;仅当 LA 层和 LB 层中所有单元的激活状态停止变化时,网络稳定。

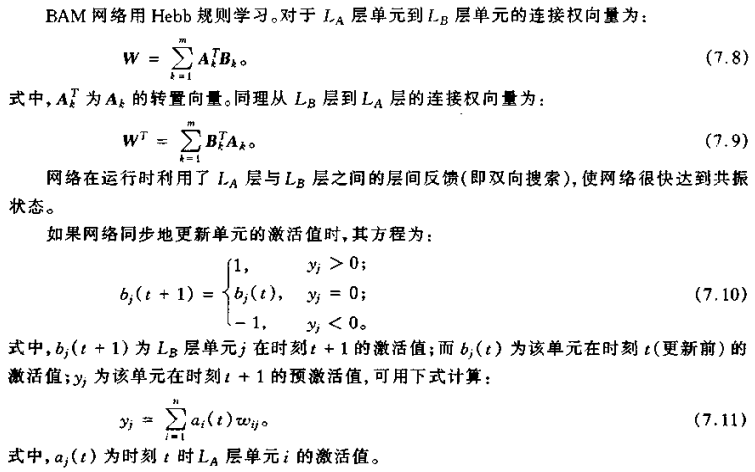

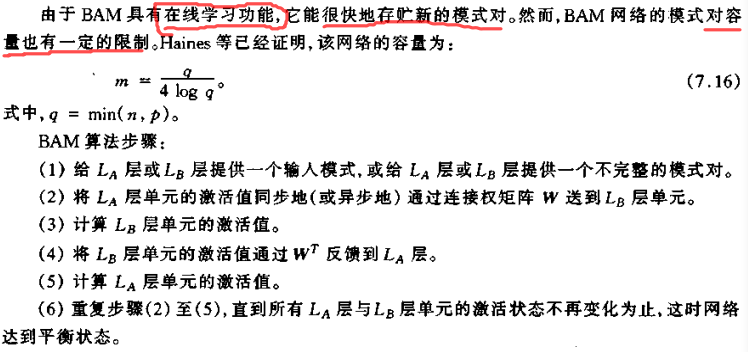

网络总是朝着能量减小的方向变化,当网络单元的激活状态停止变化时,网络处于平衡状态。BAM 网络通过网络的能量函数局部极小点来存贮模式对,并且其补模式对也存贮在相同的局部极小点上。当由不完善(或噪声)模式对联想存贮模式对时,采用异步方式更利于网络收敛;当存贮模式对中的某一模式回想另一模式时,采用同步方式更有利于网络收敛。

7.3.2 自适应 BAM

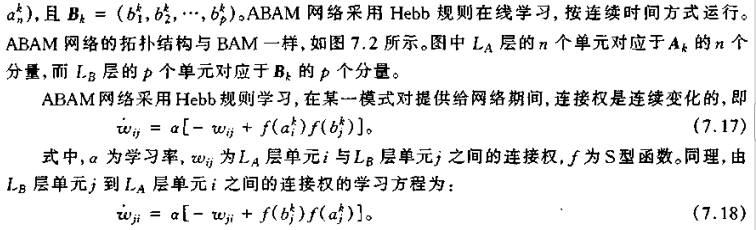

自适应双向联想记忆(Adaptive Bidrectional Associative Memory),简称 ABAM。

ABAM 网络的记忆是可塑的。也就是说,任何一个模式对只要提供给网络足够长的时间,那么学习的结果将是这个模式对覆盖原先存贮的模式对而存贮于网络之中。用采样学习的方法来克服这种不足,即在采样学习期间,各模式对被随机地选出并提供给网络一个不长的时间,这样学习率较低时(a << 1),网络能存贮足够多的模式对。

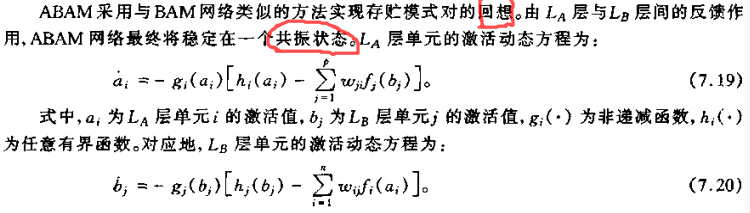

ABAM 是全局稳定的。这个网络的记忆可塑性也是网络的一个优点,能使网络从噪声数据集合中提出数据明显的统计特征。ABAM 一个主要缺点是其较小的模式对存贮容量,只能存贮比 q = min( n,p) 更小数目的模式对。

7.4 时间联想记忆 TAM 模型

时间联想记忆(Temporal Associative Memory)简称 TAM。

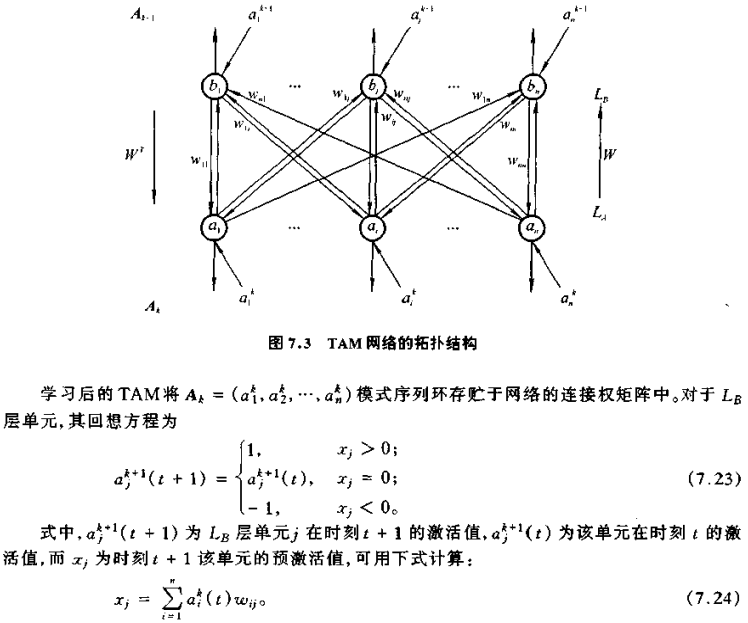

TAM 一个突出特点是能存贮一个模式序列环,且能从该序列中的任意模式开始重演这个序列。这种序列重演功能可用于并行有限状态机等方面。