关系抽取--- 远程监督---《Reinforcement Learning for Relation Classification from Noisy Data》

- 本文解决的问题:

1)不能在句子级别进行预测

2)基于包的方法通常在过滤噪声数据时,至少保留包中的一条数据。这样的做法无法处理一个包中全是噪声数据的情况,而全是噪声数据的包在远程监督方法中很常见 - 本文实现的方式概述:

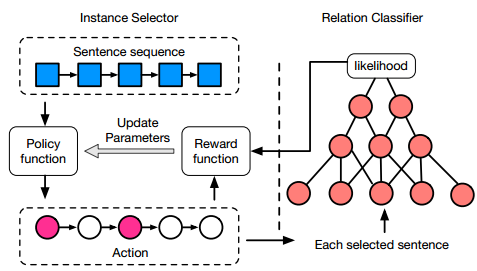

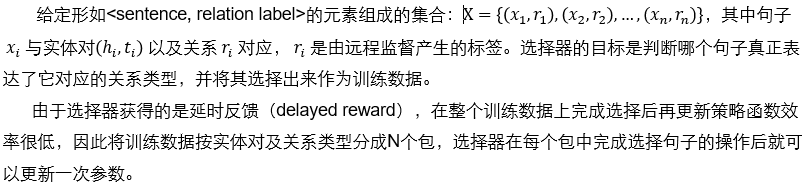

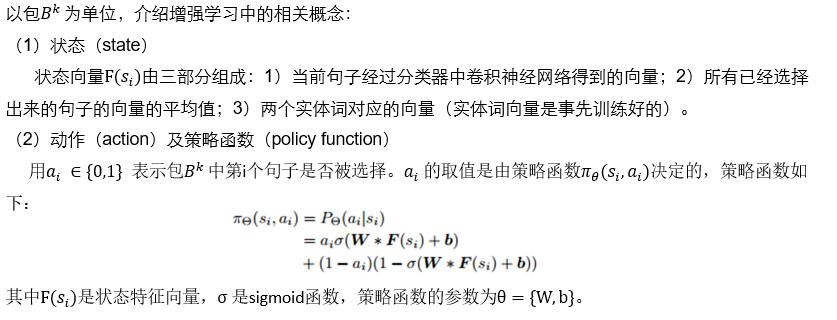

方法包含两个模块:实例选择器(instance selector)和关系分类器(relation classifier)。实例选择器可以从句子包中选择质量高的数据,然后关系分类器进行句子级别的关系分类;为解决第二个问题,当一个包中全是噪声数据时,实例选择器可以过滤掉包中的所有数据。

本方法最大的挑战是如何联合地训练两个模块,尤其是实例选择器不知道包中哪些数据可信,哪些数据不可信。对于选择器采用增强学习(Sutton and Barto 1998)的训练方式,实例选择器满足以下两个特性:1)实例选择器尝试选择句子,并且从关系分类器处获得关于句子质量的反馈(或奖励)2)反馈是延时的,也就是说只有当选择器选择句子的操作结束后才能从分类器处获得反馈。上述两个特性满足增强学习的特点,实际在训练的过程中两个模块相互影响。

- 本文的思想概述:

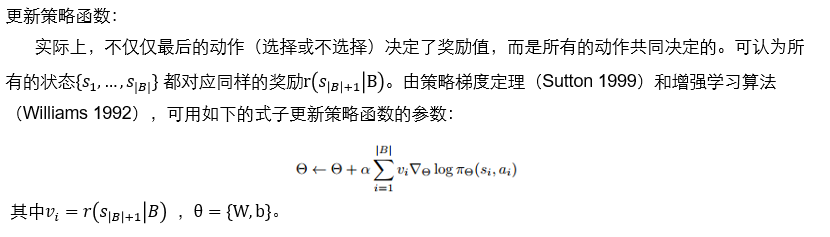

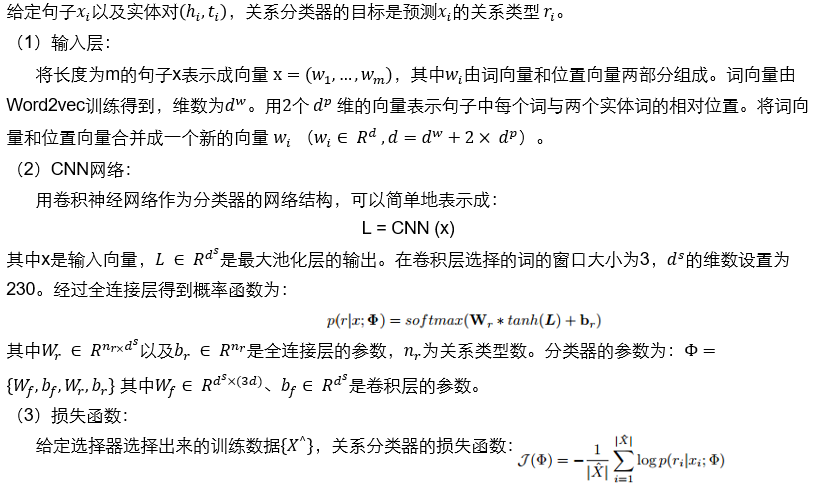

该方法由实例选择器和关系分类器两个模块组成。1)在实例选择器中,每个句子 都对应一个动作(action), 表示句子是否被选择为关系分类器的训练数据。同时每个句子 对应一个状态(state) , 由句子,已经从中选出来的句子以及实体对、组成。实例选择器根据当前的状态和策略函数(policy function),给出动作,根据选择句子并将选出来的句子送给分类器2)对于关系分类器,通过卷积神经网络(CNN)确定句子及实体对的关系类型,同时给出选择器反馈信息(reward),以便选择器进一步训练策略函数。

- 实例选择器:

- 关系分类器

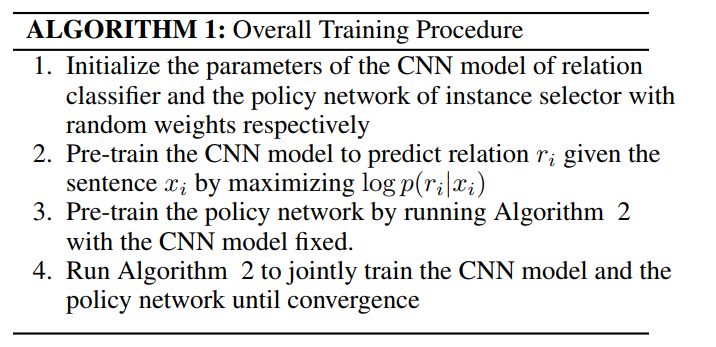

- 训练方法:

在联合训练开始前,分别对选择器和分类器进行预训练。首先预训练分类器,然后固定分类器的参数,对选择器进行预训练,最后联合训练选择器与分类器。

浙公网安备 33010602011771号

浙公网安备 33010602011771号