一键部署ceph(luminous)集群脚本

过年呀!好久不见了,也没有更新公众号!希望各位能理解吧。

现在是不是很无聊?因为的注意到了咱们公众号每天关注的人数数据逐渐回升。大过年的不把你们逼到一定份上应该不会主动学习的吧!

行吧!近期疫情严重,心情还是比较沉重的。大家返程还是要注意安全。

手头环境有限,升级了一下咱们之前的ceph一键部署脚本,修复了很多bug,使用上更加灵活方便。

介绍一下脚本参数:

这里我着重介绍一下osddisk的参数,按我的方式写就行。这个是要做几个OSD。你看我上面配置的参数,在系统中是这样的。

有SDB和SDC两块磁盘。用这两块盘来做osd。脚本会自动檫盘并且初始化做成OSD

那么我们执行完脚本的效果是什么样的呢?

集群默认每个节点都是mon节点,所以大家在部署的时候请选择奇数节点。

执行完脚本后刷新一下session(关闭会话,再登录服务器)即可使用ceph等相关命令。

集群部署完毕我们该如何使用呢?

重新登录服务器后执行下面命令进行测试:

创建存储池:

ceph osd pool create test_pool 128 128 replicated

查看存储池:

用test_pool存储池创建一个10G大小的块设备。

rbd create --size 10240 test_image -p test_pool

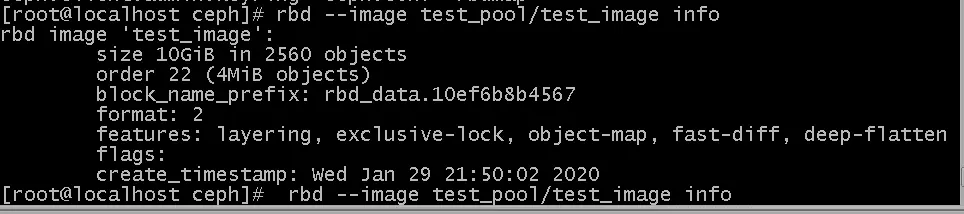

查看刚创建的块设备信息:

rbd info test_pool/test_image

客户端配置:

找一个IP能互通的服务器做ceph客户端,安装ceph客户端软件。

yum -y install centos-release-ceph-luminous.noarch

然后到服务器端进入到/data/ceph/etc目录将 ceph.client.admin.keyring和ceph.conf两个配置文件传送到ceph客户端服务器的/etc/ceph目录下

然后在客户端服务器可以直接查看我们创建的块信息了

rbd --image test_pool/test_image info

然后客户端服务器挂载并使用:

然后可以对这个设备/dev/rbd0进行格式化分区了。等等操作使用了。

波哥在脚本里面自动部署了mgr,当然根据参数你们也可以选择不部署。

根据上面的信息我们的mgr节点是ceph2,输入该节点IP,默认是7000端口就可以看到ceph集群的情况。

附属上新增osd命令:

例如我们在存储服务器上面新增了一块/dev/sdd设备:

檫盘:

docker run --rm --privileged=true \ -v /dev/:/dev/ \ -e OSD_DEVICE=/dev/sdb \ registry.cn-hangzhou.aliyuncs.com/yangb/ceph_luminous:v1.0 zap_device

如果是其他盘符,请修改上面的OSD_DEVICE=/dev/sdb参数

制作OSD:

docker run -d --net=host --name=sdb --privileged=true \ --restart=always \ -v /data/ceph/etc/:/etc/ceph \ -v /data/ceph/lib/:/var/lib/ceph \ -v /dev/:/dev/ \ -e OSD_DEVICE=/dev/sdb \ -e OSD_TYPE=disk \ -e OSD_BLUESTORE=1 \ -e CLUSTER=ceph registry.cn-hangzhou.aliyuncs.com/yangb/ceph_luminous:v1.0 osd_ceph_disk

如果是其他盘符请修改--name=sdb和OSD_DEVICE=/dev/sdb参数

另外为了易于管理各个服务的容器运行情况,波哥还在脚本里面加了一个portainer

masterIP:9000就可以登录设置了。

行了先到这吧,要是觉得波哥写的还可以,请帮忙转发、点赞、分享哦!

谢谢各位!

关注公众号回复: **ceph **获得该一键部署脚本

扫码关注,回复“前端模板”会有

意想不到的收获哦

浙公网安备 33010602011771号

浙公网安备 33010602011771号