探索魔乐社区:GLM-4V-9B模型微调之旅

人工智能的浪潮中,魔乐社区以其丰富的资源和开放的环境,逐渐成为了开发者们的新宠。今天,让我们一起走进魔乐社区,通过GLM-4V-9B模型微调的最佳实践,体验这个平台的独特魅力。

多模态的新星:GLM-4V-9B

GLM-4V-9B是智谱AI推出的最新一代预训练模型GLM-4系列中的开源多模态版本。。它不仅具备高分辨率(1120*1120)下的中英双语多轮对话能力,更在中英文综合能力、感知推理、文字识别、图表理解等多方面多模态评测中,展现出超越GPT-4-turbo-2024-04-09、Gemini 1.0 Pro、Qwen-VL-Max和Claude 3 Opus的卓越性能。在魔乐社区,你可以近距离感受这一技术革新。

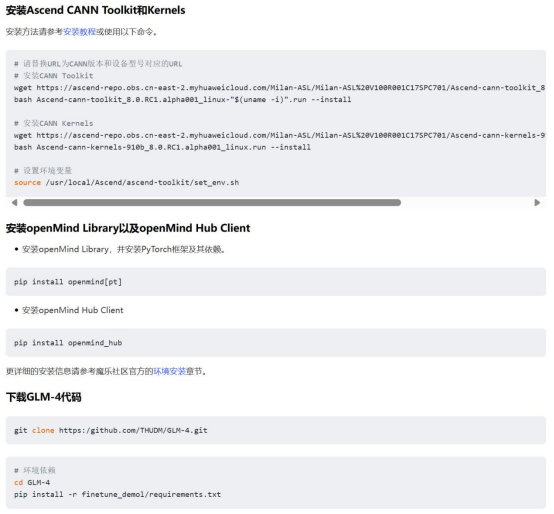

环境准备:一键安装,轻松上手

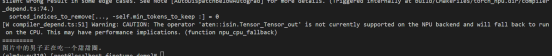

魔乐社区为开发者提供了详尽的安装教程,无论是Ascend CANN Toolkit和Kernels,还是openMind Library和openMind Hub Client,都可以通过简单的命令一键安装。这样的便捷性,让开发者可以迅速进入开发状态,无需在环境配置上耗费过多时间。如下图所示:

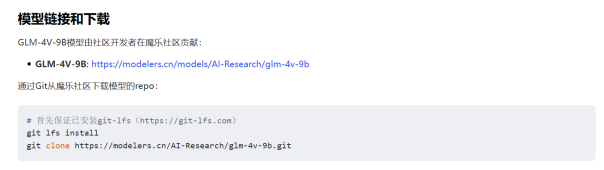

模型下载:一键获取,即刻开始

通过魔乐社区,您可以轻松下载GLM-4V-9B模型。利用Git和git-lfs,您可以一键克隆模型的代码库,快速开始您的项目。这种高效的获取方式,让模型的学习和应用变得更加直接和简单。

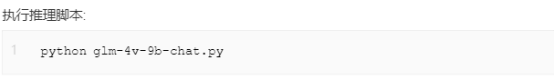

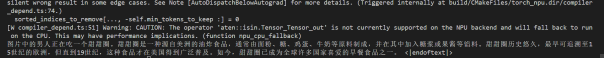

模型推理:开启智能对话

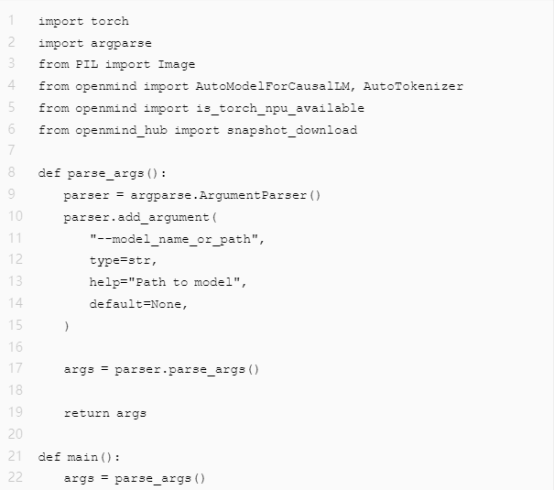

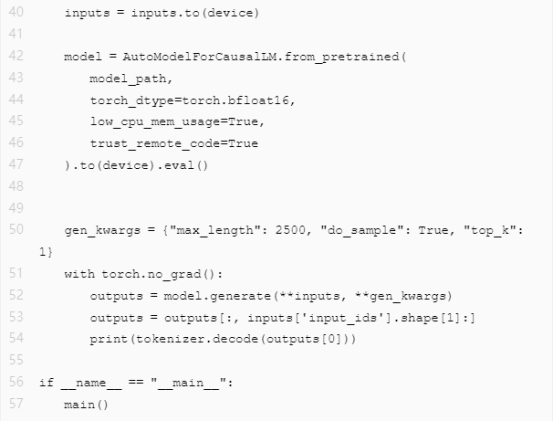

利用openMind Library,您可以轻松进行模型推理。无论是图片中的内容识别,还是基于图片的智能对话,GLM-4V-9B都能提供准确而快速的反馈。这种直观的体验,让开发者能够立即看到自己工作的效果。

示例图片:

新建 glm-4v-9b-chat.py 推理脚本:

推理结果:

模型微调:定制你的AI助手

魔乐社区提供的微调指南,让您能够根据自己的需求定制AI模型。从准备数据集到执行微调,每一步都有详细的指导,让您的模型更加贴合实际应用场景。

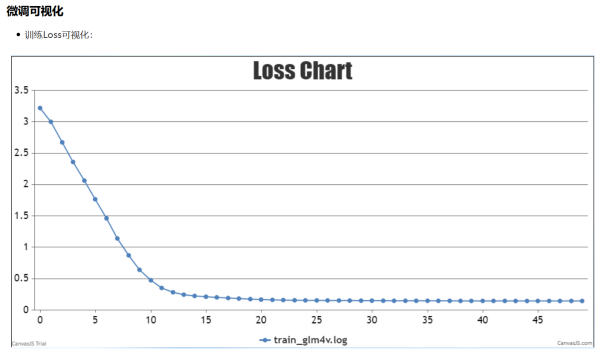

微调可视化:直观展示训练过程

训练Loss的可视化功能,让您可以直观地看到模型训练的过程和效果。这种直观的反馈,让开发者能够及时调整训练策略,也增加了开发过程的趣味性。

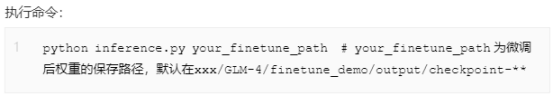

微调后推理:见证模型的成长

经过微调后的模型,将更加精准地理解您的指令。无论是图片中的细节识别,还是复杂场景的对话生成,微调后的GLM-4V-9B,它的展现让人惊喜。过程如下:

推理结果:

结语

根据详细的指引,整个体验是非常流畅的。如果您也对模型开发感兴趣,欢迎加入魔乐社区(https://modelers.cn),探索更多的技术和项目。