基于深度学习的机械器件识别系统(网页版+YOLOv8/v7/v6/v5代码+训练数据集)

摘要:本文深入研究了基于YOLOv8/v7/v6/v5等深度学习模型的机械器件识别系统,核心采用YOLOv8并整合了YOLOv7、YOLOv6、YOLOv5算法,进行性能指标对比;详述了国内外研究现状、数据集处理、算法原理、模型构建与训练代码,及基于Streamlit的交互式Web应用界面设计。在Web网页中可以支持图像、视频和实时摄像头进行机械器件识别,可上传不同训练模型(YOLOv8/v7/v6/v5)进行推理预测,界面可方便修改。本文附带了完整的网页设计、深度学习模型代码和训练数据集的下载链接。

@

完整资源中包含数据集及训练代码,环境配置与界面中文字、图片、logo等的修改方法请见视频,项目完整文件下载请见演示与介绍视频的简介处给出:➷➷➷

演示与介绍视频 :https://www.bilibili.com/video/BV18q421w7KM/

YOLOv8/v7/v6/v5项目合集下载:https://mbd.pub/o/bread/mbd-ZZ2YmJpp

YOLOv8和v5项目完整资源下载:https://mbd.pub/o/bread/mbd-ZZ2YkpZu

YOLOv7项目完整资源下载:https://mbd.pub/o/bread/mbd-ZZ2Ylp9y

YOLOv6项目完整资源下载:https://mbd.pub/o/bread/mbd-ZZ2Yl5xv

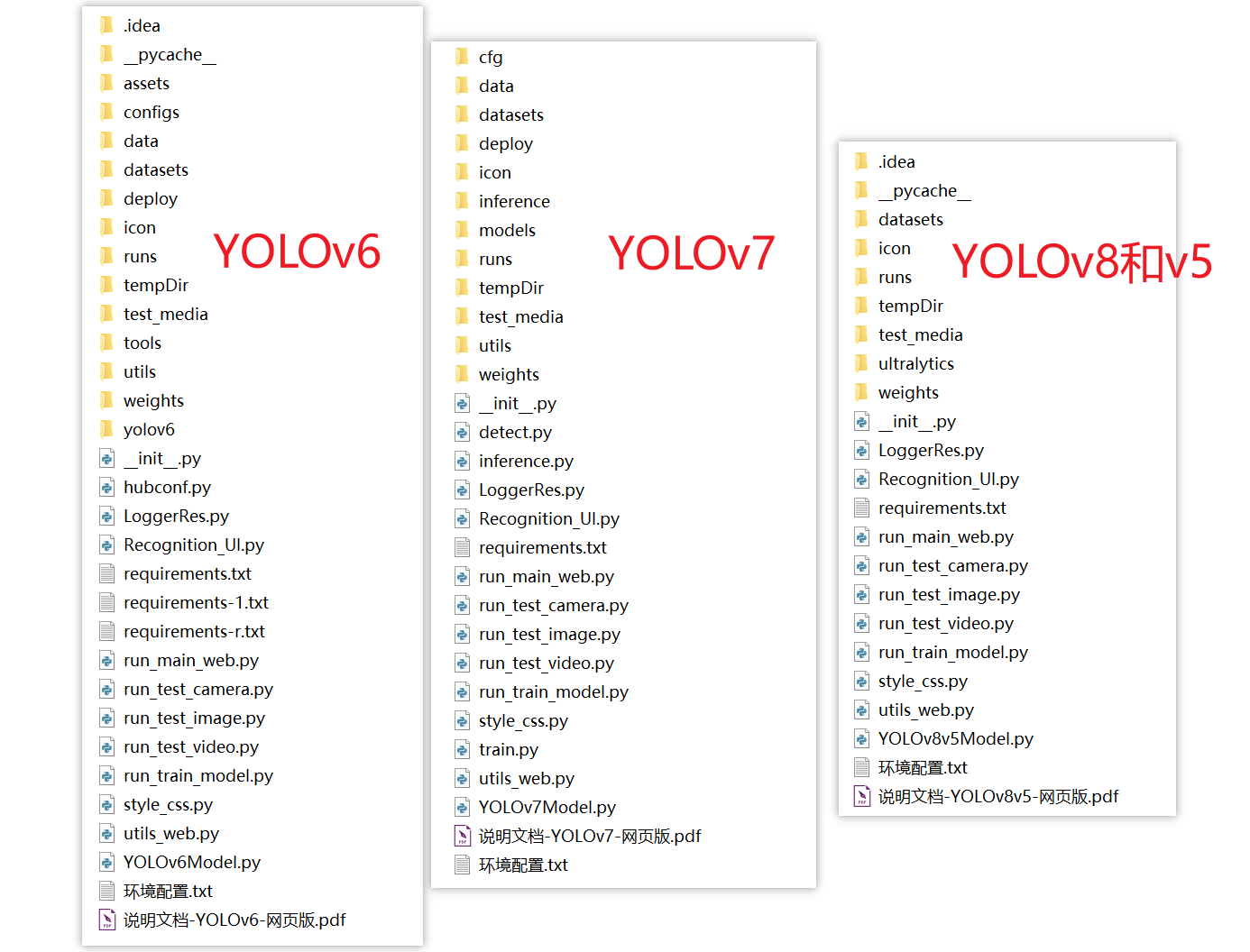

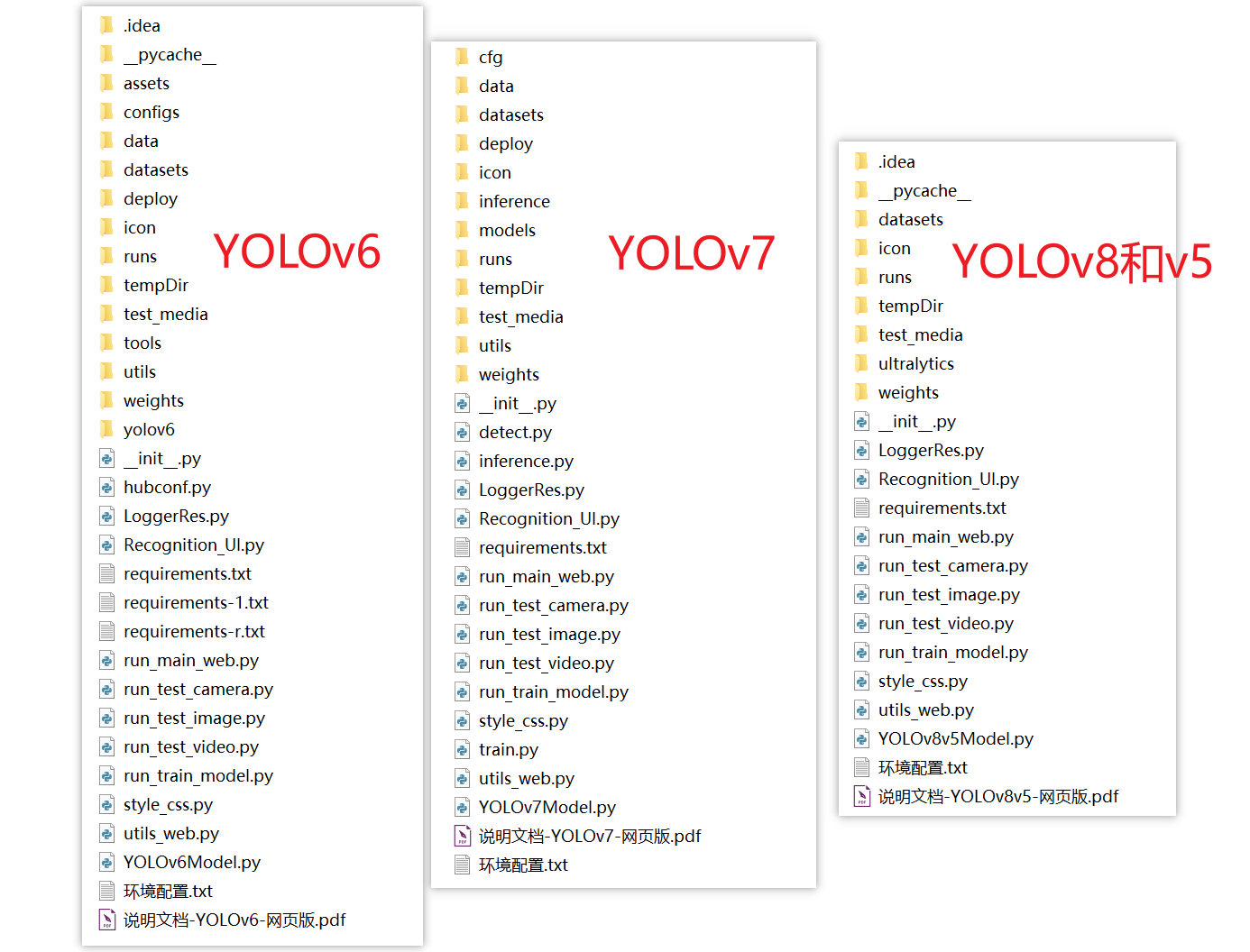

若您想获得博文中涉及的实现完整全部资源文件(包括测试图片、视频,py, UI文件,训练数据集、训练代码、界面代码等),这里已打包上传至博主的面包多平台,见可参考博客与视频,已将所有涉及的文件同时打包到里面,点击即可运行,完整文件截图如下:

1. 网页功能与效果

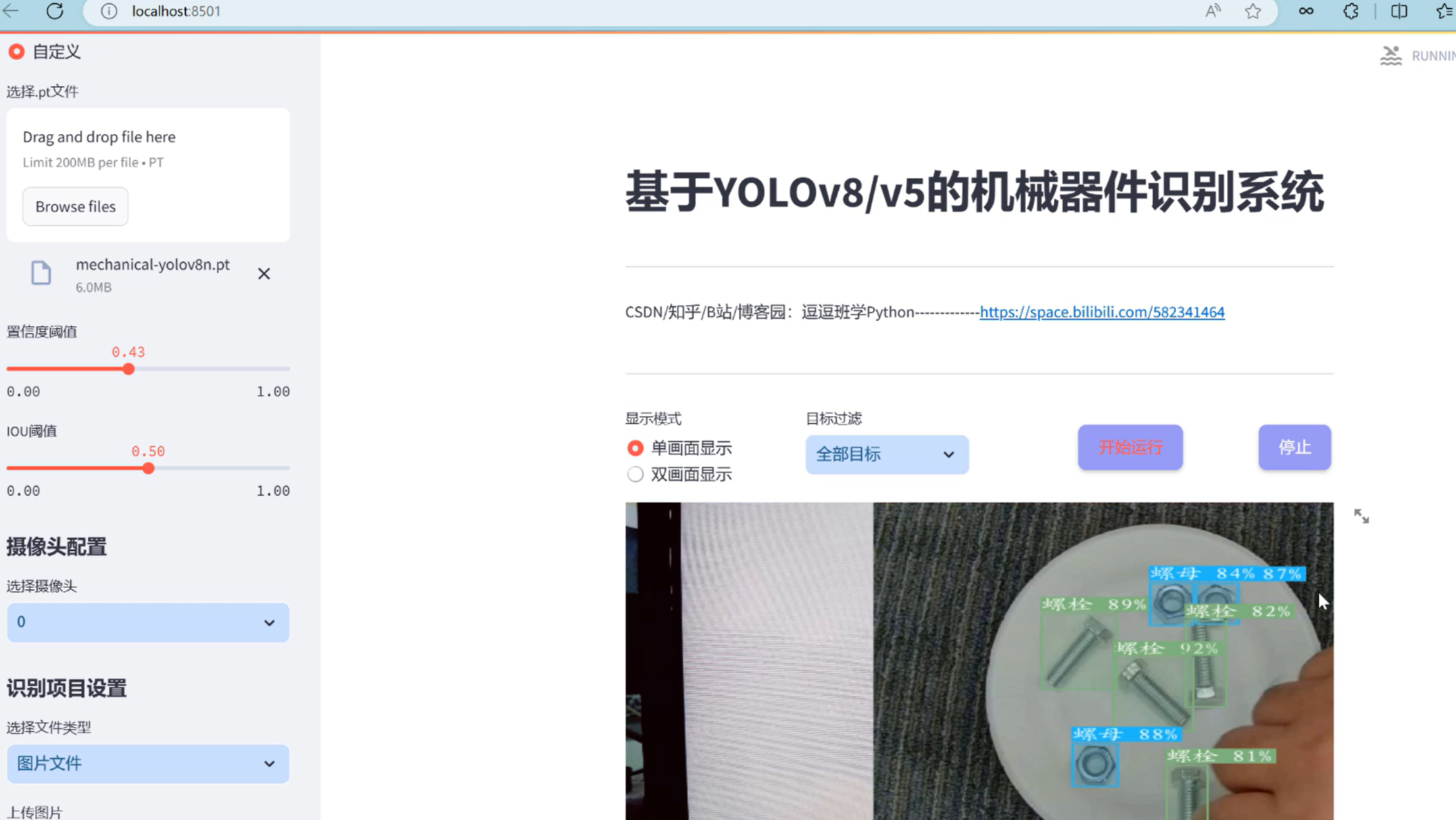

(1)开启摄像头实时检测:本系统允许用户通过网页直接开启摄像头,实现对实时视频流中机械器件的检测。系统将自动识别并分析画面中的机械器件,并将检测结果实时显示在用户界面上,为用户提供即时的反馈。

(2)选择图片检测:用户可以上传本地的图片文件到系统中进行机械器件识别。系统会分析上传的图片,识别出图片中的机械器件,并在界面上展示带有机械器件标签和置信度的检测结果,让用户能够清晰地了解到每个机械器件状态。

(3)选择视频文件检测:系统支持用户上传视频文件进行机械器件识别。上传的视频将被系统逐帧分析,以识别和标记视频中每一帧的机械器件。用户可以观看带有机械器件识别标记的视频,了解视频中机械器件的变化。

(4)选择不同训练好的模型文件:系统集成了多个版本的YOLO模型(如YOLOv8/v7/v6/v5),用户可以根据自己的需求选择不同的模型进行机械器件识别。这一功能使得用户能够灵活地比较不同模型的表现,以选择最适合当前任务的模型。

本系统还集成了一系列高级功能,以提高用户的使用体验和检测效率。用户可以在检测画面中同时或单独显示检测画面和原始画面,便于直观比较检测结果与实际情况。通过可点击的下拉框,用户能够单独标记特定目标并显示结果,这一点对于关注特定类型目标的用户来说极其有用。所有的检测结果都会在页面的表格中显示,用户还可以根据需要动态调整检测算法的置信度阈值和IOU阈值,以优化检测结果的精度和召回率。

为了方便用户进一步分析和记录检测结果,本系统支持点击按钮将检测的表格结果输出到csv文件。此外,所有标记的图片、视频、摄像头画面结果都可以导出为avi图像文件,方便用户保存和分享检测结果。这些高级功能的设计,旨在为用户提供一个全面、灵活、易用的机械器件识别工具,满足不同用户在不同应用场景下的需求。

2. 绪论

2.1 研究背景及意义

在当今的工业制造领域,机械器件识别技术的重要性日益凸显。随着智能制造和自动化生产的不断发展,高效、准确地识别各种机械部件成为提高生产效率、确保产品质量、降低人工成本的关键。传统的机械器件识别方法依赖于复杂的传感器系统或人工检测,不仅成本高昂,而且效率低下,难以适应快速变化的生产需求。随着人工智能技术,尤其是深度学习和机器视觉的飞速发展,基于这些技术的机械器件识别方案为解决这一问题提供了新的思路。特别是YOLO(You Only Look Once)系列算法因其高效的实时处理能力和优异的识别准确率,在机械器件识别领域显示出巨大的应用潜力。通过深度学习模型直接从图像中学习特征,这种方法不仅提高了识别的准确性,还显著降低了对复杂硬件的依赖,为实现快速、低成本的机械部件自动识别开辟了新道路。

国内外的研究也展示了其他深度学习算法的应用,如利用改进的Faster R-CNN和SSD算法进行机械器件检测,这些方法在提高准确率方面取得了显著成果。此外,一些研究专注于优化模型以适应边缘计算设备,使机械器件识别系统更加实用,适用于低功耗设备。

这些进展表明,虽然基于YOLO及其他深度学习算法的机械器件识别技术已经取得显著进步,但仍有许多挑战需要克服。未来的研究可能会探索更高效的算法,改进数据集的构建方法,或开发新的模型训练策略,以进一步提高机械器件识别的准确性和实用性。

基于上述背景,本博客将深入探讨基于YOLOv8/v7/v6/v5的机械器件识别系统的设计与实现,分析其在实际应用中的表现和价值,以期为机械器件识别和研究提供技术支持和新思路。

2.2 国内外研究现状

在目前的研究背景下,机械器件识别领域正处于快速发展之中,众多学者和研究机构投入大量资源进行探索。近年来,随着深度学习技术的进步,尤其是在计算机视觉领域,一系列新型算法被提出并应用于机械器件识别任务中,显著提高了检测的准确率和实时性。YOLO[1]系列作为实时目标检测的代表算法,经历了从YOLOv1到YOLOv8的发展历程。其中,YOLOv4和其后的版本在性能上取得了显著提升。YOLOv4通过引入更多的数据增强技术、更深的网络结构和新的特征融合策略,大幅提高了检测的准确度和速度。随后,YOLOv5[2]在易用性和速度上进一步优化,尽管它并非官方版本,但因其出色的性能和广泛的社区支持成为了业界的热点。YOLOv6[3]和YOLOv7[4]分别围绕模型的轻量化和进一步的性能提升进行设计,特别是在机械器件识别上的表现。而最新的YOLOv8[5]则在此基础上进一步强化了模型的泛化能力和检测效率,使其在机械器件识别等复杂场景中表现更加出色。

数据集的发展同样对机械器件识别技术的进步起到了关键作用。早期研究多依赖于自定义的小规模数据集,这限制了模型泛化能力的评估。近年来,随着公开大规模数据集的增多,如ImageNet和COCO,研究者能够在更多样化的数据上训练和测试模型,从而提高了算法的鲁棒性和泛化能力。特别是,专门针对机械器件设计的数据集,如Mechanical Components Benchmark (MCB),为模型提供了更专业的训练和验证平台。

尽管有了显著的进展,机械器件识别仍面临诸多技术挑战,例如在复杂背景或不同光照条件下保持高准确率,以及处理器件间相似性高导致的误识别问题。此外,随着技术的发展,如何有效地在边缘设备上部署高性能模型也成为了一个重要的研究方向。为了应对这些挑战,研究者正在探索轻量化模型、模型蒸馏技术和自适应调整网络结构的方法。

综上所述,机械器件识别领域的技术进展表明了深度学习在解决复杂视觉任务中的潜力。随着算法的不断优化、数据集的不断丰富以及新技术的应用,未来机械器件识别的准确性和效率有望得到进一步提升。

2.3 要解决的问题及其方案

2.3.1 要解决的问题

在本系统中,我们面临的核心问题与提出的解决方案紧密围绕着基于YOLOv8/v7/v6/v5的深度学习模型进行机械器件识别,以及如何将这些技术集成到一个用户友好的网页应用中。以下是具体的问题和相应的解决方案:

-

机械器件识别的准确性和速度:

机械器件在形状、大小、材质等方面具有极高的多样性。此外,它们可能以不同的姿态或部分被遮挡的情况出现在图像中。因此,系统需要能够快速并准确地识别出这些细微的特征差异。采用最新的YOLO系列模型(v8/v7/v6/v5)为基础,通过深度学习模型的训练推理,能够有效提升识别的速度和准确率。 -

环境适应性和模型泛化能力:

机械器件识别系统可能会被部署在多种环境中,包括光线条件不一、背景复杂多变的工业场景。因此,提高模型的环境适应性和泛化能力是关键。通过对大量多样化的数据集进行训练,以及采用数据增强技术,可以有效提高模型在不同环境下的识别准确性。 -

用户交互界面的直观性和功能性:

为了确保用户能够高效地使用机械器件识别系统,我们通过基于Streamlit的Web界面设计,提供了一个直观且功能丰富的用户界面。用户可以轻松上传图像、视频,甚至实时通过摄像头进行机械器件的识别。同时,支持切换不同的模型文件,让用户根据实际需要选择最合适的识别模型。 -

** 数据处理能力和存储效率**:

考虑到系统将处理大量的图像和视频数据,采用PyTorch作为深度学习技术框架,不仅提升了数据处理的速度,也优化了存储效率。同时,通过合理的数据管理和查询机制,保证了长期运行的稳定性和数据的易访问性。 -

** 系统的可扩展性和维护性**:

在设计系统时,考虑到了未来可能的需求变化和技术升级。系统架构设计允许轻松集成新的模型或技术,保证了其可扩展性。使用PyCharm作为开发IDE,不仅提高了开发效率,也便于系统的维护和升级。

2.3.2 解决方案

-

采用PyTorch技术框架训练深度学习模型:

利用PyTorch框架的灵活性和易用性,针对YOLOv8/v7/v6/v5模型进行优化和训练,确保模型能够快速准确地识别机械器件佩戴状态。 -

基于Streamlit的网页设计:

利用Streamlit框架快速开发交互式网页应用,用户可以在网页中直观地上传图片、视频或接入实时摄像头进行机械器件识别。同时,使用CSS进行美化,提高用户界面的友好度和美观性。 -

深度学习检测算法的网页集成:

将深度学习的检测算法与Streamlit网页应用无缝集成,允许用户轻松切换不同的模型文件进行性能比较,确保了系统的灵活性和实用性。 -

开发工具IDE使用PyCharm:

利用PyCharm强大的开发环境支持,提高开发效率,同时确保代码质量,便于后续的维护和扩展。

通过实施上述解决方案,我们的目标是开发出一个既准确又高效的机械器件识别系统,该系统不仅能够满足工业生产中对机械器件识别的需求,同时也提供友好的用户体验和强大的数据处理能力。

2.4 博文贡献与组织结构

本文针对机械器件识别这一关键的工业视觉任务,提出了一个综合性的研究和实现方案。我们的工作不仅涵盖了深入的文献综述,包括对当前最先进目标检测算法的分析,还详细介绍了机械器件识别系统的设计与实现过程。以下是本研究的主要贡献:

-

全面的文献综述:我们提供了一篇详尽的文献综述,系统地总结了机械器件识别领域内外的研究现状和技术进展,特别是对YOLOv8/v7/v6/v5等先进目标检测算法的详细分析。

-

精细的数据集处理:本文详细阐述了数据集的处理方法,包括数据的采集、预处理、增强技术,以及如何针对机械器件识别任务定制数据集,确保了模型训练的高质量数据输入。

-

算法选择与优化:我们不仅比较了YOLOv7/v6/v5等算法的性能,还着重介绍了YOLOv8的选择和优化理由,提供了基于这些算法的模型训练与推理过程的详细指导。

-

友好的Web界面设计:采用Streamlit框架,设计了美观且用户友好的网页界面,支持图片、视频和实时摄像头的机械器件识别功能,同时允许用户轻松切换不同的模型文件,增强了系统的交互性和灵活性。

-

实验结果与分析:本文提供了一系列基于不同YOLO版本的实验结果,包括性能对比和效果分析,验证了所提方法在机械器件识别任务上的有效性和优越性。

-

资源共享:文章附带了完整的数据集和代码资源包下载链接,为研究人员和工程师提供了一套可直接应用或进一步研究的工具。

后续章节的组织结构如下: 绪论:介绍研究背景、目的和本文的主要贡献;算法原理:详细介绍YOLOv8/v7/v6/v5等算法的工作原理及其在机械器件识别中的应用;数据集处理:讨论使用的数据集及其预处理、增强方法。代码介绍:提供模型训练和预测的详细代码说明,包括环境搭建、参数配置和执行步骤。实验结果与分析:展示各版本YOLO算法在机械器件识别任务上的实验结果,包括准确率、速度等指标的对比分析。系统设计与实现:介绍基于Streamlit的机械器件识别系统的设计与实现细节。结论与未来工作:总结本文的研究成果,并讨论未来的研究方向和潜在的改进空间。

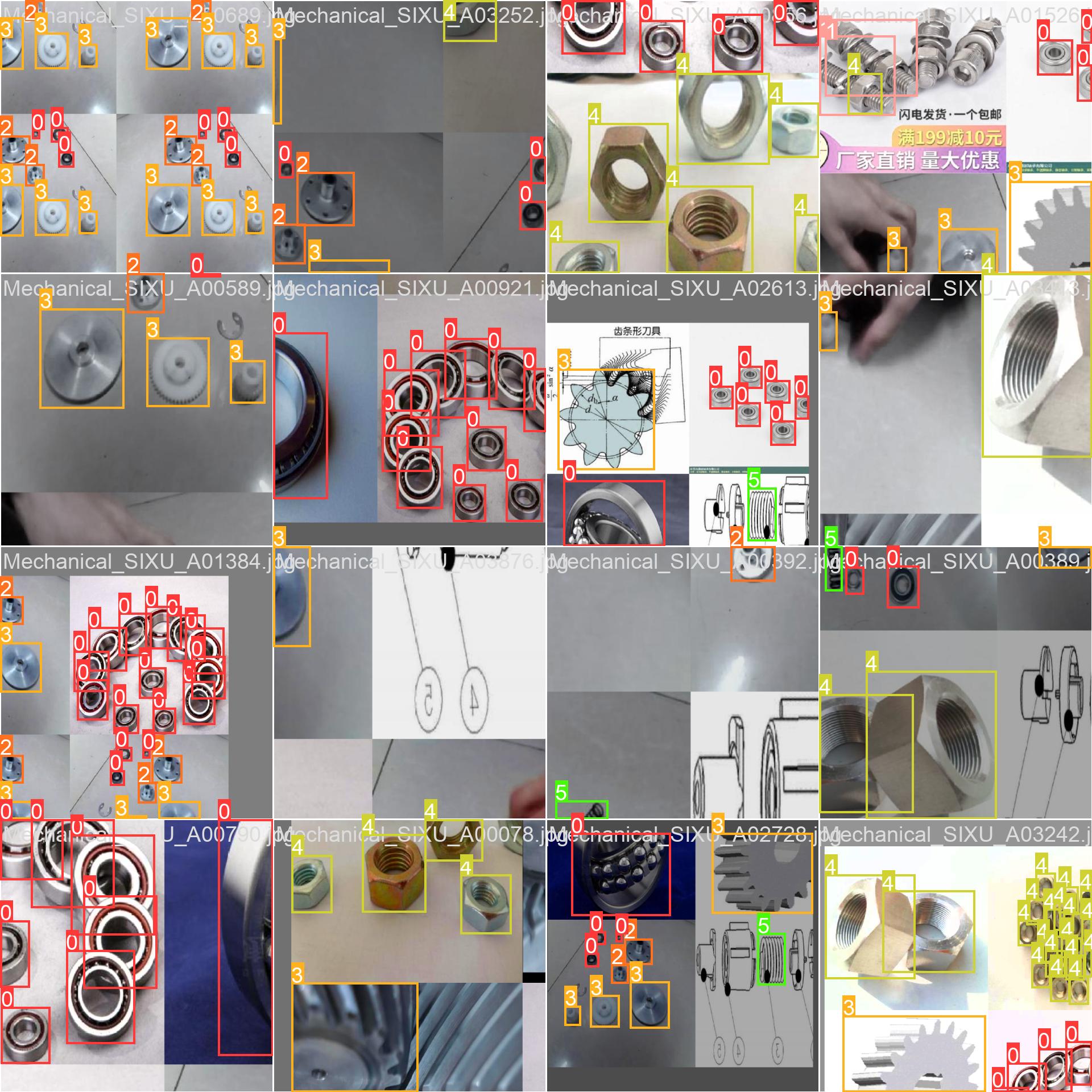

3. 数据集处理

在探索智能化的工业自动化领域,机械器件识别系统的准确性和效率至关重要。为了训练出高效的识别模型,我们精心构建了一个全面的数据集,它不仅覆盖了多种机械器件,而且提供了丰富的场景和背景条件。本数据集共包含5914张图像,这些图像被划分为3931张训练集、1183张验证集和800张测试集,旨在通过这一全面的分布,确保模型能够在各种条件下都表现出色。博主使用的类别如下:

Chinese_name = {'mask': "佩戴机械器件",

'no-mask': "未戴机械器件",}

类别分布的不平衡是我们在训练过程中必须面对的挑战。图像中轴承和齿轮类别的实例数量显著多于其他类别,尤其是弹簧类别的样本最少。这种不平衡可能会导致模型对样本数多的类别过于敏感,而忽略了其他重要类别。为了解决这个问题,我们可能需要采取特定的数据增强策略,如过采样较少样本的类别,或者在模型训练中应用类别权重调整,确保所有类别的器件都能被模型充分学习。

进一步分析数据集,我们发现大部分机械器件的中心位置集中在图像中心区域。这表明,模型在中心区域的识别效果可能较好,但同时也提示我们需关注边缘区域的目标检测能力。为此,我们的数据预处理包括了随机裁剪和填充,以确保模型能够识别位于图像边缘的器件。

另一个值得注意的点是目标尺寸的分布。数据集中的大多数机械器件尺寸相对较小,这对目标检测算法的设计提出了特别要求。我们将利用这一信息优化检测模型中的锚框尺寸,以提高对小型器件的识别精度。

除了尺寸分布,我们还观察到机械器件的形状在数据集中呈现出多样性。不同的器件,如螺帽、齿轮和弹簧,具有不同的形状和外观特征。因此,数据集的多样性不仅反映在器件的类别上,还反映在它们的几何特性上。这一多样性为我们训练出能够适应各种形状和大小机械器件的模型提供了良好基础。

为了确保数据集能够被有效地利用,我们进行了严格的预处理,包括归一化和尺寸调整,以适应模型的输入需求。通过应用多样化的数据增强技术,我们进一步提升了模型的泛化能力,这使得模型不仅可以在理想条件下表现良好,也能在现实世界复杂的工业环境中保持高性能。

总结而言,我们的数据集介绍不仅涉及了数据集的数目和类型,还包括了我们在预处理和数据增强上的精心设计。我们相信,通过这样的数据集和处理策略,结合我们的算法优化,最终将实现一个在现实世界条件下表现出色的机械器件识别系统。

4. 原理与代码介绍

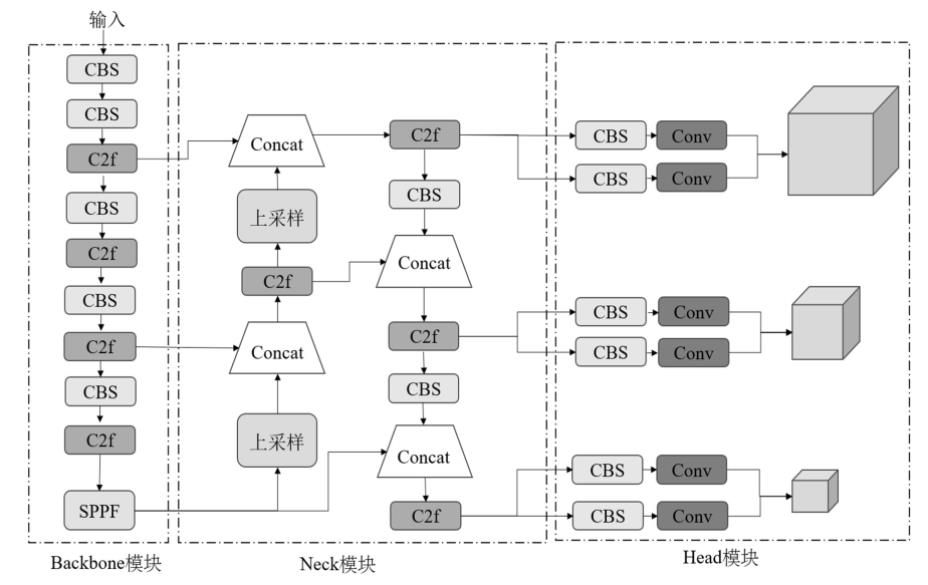

4.1 YOLOv8算法原理

YOLOv8作为一款先进的目标检测算法,代表了YOLO系列算法的最新进展。它继承了YOLO(You Only Look Once)系列算法的核心理念——即在单次推断中同时进行目标的定位和分类。YOLOv8对YOLO系列的架构进行了进一步的优化和改进,提高了在各种场景下检测对象的准确性和速度。

YOLOv8的架构继承了YOLO系列算法的三个主要组成部分:Backbone(主干网络)、Neck(颈部网络)和Head(头部网络)。在Backbone部分,YOLOv8采用了CSP(Cross Stage Partial networks)结构,该结构通过部分跳过连接来减少计算量并提升信息流动效率。CSP结构的关键在于它将网络层次分割,允许部分特征在深层网络中传递,从而提升了特征的利用效率和网络的学习能力。

在Neck部分,YOLOv8引入了SPP(Spatial Pyramid Pooling)和CFP(Coarse-to-fine)结构,这些结构使得网络能够捕捉不同尺度的特征,增强了模型对于不同尺寸目标的检测能力。SPP通过不同尺度的最大池化来聚合上下文信息,而CFP结构则进一步细化了特征,使得特征在多尺度上都能够有效地被网络学习和利用。

YOLOv8的Head部分则是整个网络的决策中心,它负责产生最终的预测结果。在Head部分,YOLOv8继续使用了YOLO系列的多尺度检测策略,能够在不同的特征图上检测不同大小的目标。这种多尺度策略使得YOLOv8在检测小目标和大目标时都表现出色,特别是在复杂场景中,能够有效区分接近的多个小目标,提高了整体的准确性。

在Backbone部分,YOLOv8采用了CSP结构。通过将网络层分割并跨阶段连接,实现了计算负荷的减少和特征信息的增强。这种设计允许部分特征直接传递到网络的深层部分,减少了冗余计算并提高了特征的利用效率。特别是在处理高维度特征时,CSP结构能够更有效地维护特征的丰富性,为后续的特征提取和识别提供了更为鲁棒的基础。

YOLOv8的另一大创新是其对训练过程的优化。利用AutoML技术,算法能够自动地进行超参数调整,这一点对于提升模型在不同数据集上的通用性和最终性能至关重要。此外,YOLOv8在网络结构的设计上也进行了自动化调整,利用神经网络架构搜索(Neural Architecture Search, NAS)技术,来发现最优的模型结构。这一过程利用大规模计算资源,如Cloud TPU或大型GPU集群,以确保搜索过程能够覆盖广泛的网络结构空间,找到最适合特定任务的最佳模型。

最后,YOLOv8在提高模型性能的同时,也考虑到了在实际应用中的效率和速度。它在模型的设计中采取了多种措施来减少计算负担,比如通过模型剪枝和量化技术,来减少不必要的计算和参数,同时保持检测性能。这些优化使得YOLOv8能够在资源有限的设备上运行,同时提供高速和高精度的检测能力。

综合上述技术,YOLOv8不仅在算法的准确性和速度上取得了平衡,同时也具备了良好的可扩展性和适应性。它的创新点在于能够自动地调整和优化模型结构,以适应各种复杂的检测任务,这使得YOLOv8成为当前目标检测领域的一个重要里程碑。

4.2 模型构建

在我们的机械器件识别系统中,我们从几个重要的库中导入了必要的模块。cv2是OpenCV库的一部分,负责处理图像和视频数据。torch是PyTorch的核心,一个强大的深度学习库。Detector和HeatmapGenerator用于模型的构建和输出的可视化。Chinese_name提供了从类别到中文名称的映射。YOLO类和select_device函数来自ultralytics,用于加载YOLO模型并选择合适的计算设备。

import cv2

import torch

from QtFusion.models import Detector

from datasets.label_name import Chinese_name

from ultralytics import YOLO

from ultralytics.utils.torch_utils import select_device

这里设定了模型运行的初始化参数。如果GPU可用,我们将使用GPU来加速模型的运行;否则,我们会回退到CPU。conf设定了置信度阈值,用来判断一个检测是否有效。iou是非极大值抑制中的一个重要参数,用来处理重叠的检测框。

device = "cuda:0" if torch.cuda.is_available() else "cpu"

ini_params = {

'device': device,

'conf': 0.25,

'iou': 0.5,

'classes': None,

'verbose': False

}

count_classes函数接收检测结果和类别名称,返回一个计数列表,表示每个类别的检测数量。它接受检测信息和类别名称列表作为输入,并返回一个与类别名称列表相对应的计数列表。这个功能对于分析模型在不同类别上的表现非常有用。

def count_classes(det_info, class_names):

count_dict = {name: 0 for name in class_names}

for info in det_info:

class_name = info['class_name']

if class_name in count_dict:

count_dict[class_name] += 1

count_list = [count_dict[name] for name in class_names]

return count_list

YOLOv8v5Detector类封装了模型的行为,包括模型加载、图像预处理、预测和后处理。模型加载功能选择适当的设备并加载预训练的YOLO模型,以确保可以立即进行目标检测。预处理功能在当前实现中直接返回传入的图像,但为未来可能的图像转换留出了空间。预测功能是模型的核心,它接受输入图像并使用YOLO模型产生检测结果。这个过程将图像中潜在的每个目标封装为一系列预测结果,其中包括类别、边界框和置信度分数。后处理函数进一步解析YOLO模型的原始输出,将其转换成一种更加结构化和可读性强的格式。这个步骤至关重要,因为它使最终用户能够轻松理解和使用模型的预测结果。

class YOLOv8v5Detector(Detector):

def __init__(self, params=None):

super().__init__(params)

self.model = None

self.img = None

self.names = list(Chinese_name.values())

self.params = params if params else ini_params

def load_model(self, model_path):

self.device = select_device(self.params['device'])

self.model = YOLO(model_path)

names_dict = self.model.names

self.names = [Chinese_name[v] if v in Chinese_name else v for v in names_dict.values()]

self.model(torch.zeros(1, 3, *[self.imgsz] * 2).to(self.device).type_as(next(self.model.model.parameters())))

def preprocess(self, img):

self.img = img

return img

def predict(self, img):

results = self.model(img, **ini_params)

return results

def postprocess(self, pred):

results = []

for res in pred[0].boxes:

for box in res:

class_id = int(box.cls.cpu())

bbox = box.xyxy.cpu().squeeze().tolist()

bbox = [int(coord) for coord in bbox]

result = {

"class_name": self.names[class_id],

"bbox": bbox,

"score": box.conf.cpu().squeeze().item(),

"class_id": class_id,

}

results.append(result)

return results

def set_param(self, params):

self.params.update(params)

最后,提供了一个设置参数的方法,允许用户在运行时根据需求调整模型的置信度和IOU阈值。这意味着用户可以动态调整模型的行为,以获得更好的检测效果,例如,在精确度更重要的情况下提高置信度阈值,或者在召回率更重要时降低它。

通过这些方法,我们可以实现从加载模型到获取检测结果的完整流程。最终,这些代码片段的整合不仅提高了检测效率,而且通过优化后的参数设置和预处理策略,进一步提升了检测的准确率。这些都是机械器件识别系统的技术核心。

4.3 训练代码

在本篇博客中,我们将探讨如何使用YOLOv8模型来训练一个机械器件识别系统。这一过程不仅涉及到深度学习模型的加载和初始化,还包括数据集的准备以及训练参数的配置。以下表格详细介绍了YOLOv8模型训练中使用的一些重要超参数及其设置:

| 超参数 | 设置 | 说明 |

|---|---|---|

学习率(lr0) |

0.01 | 决定了模型权重调整的步长大小,在训练初期有助于快速收敛。 |

学习率衰减(lrf) |

0.01 | 控制训练过程中学习率的降低速度,有助于模型在训练后期细致调整。 |

动量(momentum) |

0.937 | 加速模型在正确方向上的学习,并减少震荡,加快收敛速度。 |

权重衰减(weight_decay) |

0.0005 | 防止过拟合,通过在损失函数中添加正则项减少模型复杂度。 |

热身训练周期(warmup_epochs) |

3.0 | 初始几个周期内以较低的学习率开始训练,逐渐增加到预定学习率。 |

批量大小(batch) |

16 | 每次迭代训练中输入模型的样本数,影响GPU内存使用和模型性能。 |

输入图像大小(imgsz) |

640 | 模型接受的输入图像的尺寸,影响模型的识别能力和计算负担。 |

环境设置与模型加载:首先需要导入必要的库,以便在训练过程中使用它们的功能。

import os

import torch

import yaml

from ultralytics import YOLO # 用于加载YOLO模型

from QtFusion.path import abs_path # 用于获取文件的绝对路径

这些库提供了文件路径操作、深度学习功能和模型加载的能力。特别是ultralytics库中的YOLO类,这是我们训练YOLO模型的核心工具。

接下来,我们根据当前系统是否支持CUDA(即NVIDIA GPU加速)来设置设备变量。这一步对于加速训练过程至关重要。

device = "0" if torch.cuda.is_available() else "cpu"

数据集准备:我们首先设置了工作线程和批量大小,这些参数会影响数据加载的速度和内存使用。这里,workers指定了用于数据加载的工作线程数量,batch则设置了每个批次的图像数量。

workers = 1 # 工作进程数

batch = 8 # 每批处理的图像数量

为了正确地加载和处理训练数据,我们需要指定数据集配置文件的路径:

data_name = "Mechanical"

data_path = abs_path('datasets/Mechanical/mechanical.yaml', path_type='current') # 数据集的yaml的绝对路径

unix_style_path = data_path.replace(os.sep, '/')

这段代码构建了数据集配置文件的路径,并使用abs_path函数转换为绝对路径,以避免路径相关的错误。

紧接着,我们对数据集配置文件进行了一系列的读取和修改操作,以确保它指向正确的数据目录:

directory_path = os.path.dirname(unix_style_path)

with open(data_path, 'r') as file:

data = yaml.load(file, Loader=yaml.FullLoader)

if 'path' in data:

data['path'] = directory_path

with open(data_path, 'w') as file:

yaml.safe_dump(data, file, sort_keys=False)

训练模型:在数据集配置就绪后,我们加载了预训练的YOLO模型,并设置了任务类型为detect,准备开始训练。在这里,我们传递了所有必要的参数,包括图像大小imgsz,训练轮数epochs和训练任务的名称。此训练任务将执行120个时期的训练,这是一个在实践中通常需要根据实际情况调整的参数。

model = YOLO(abs_path('./weights/yolov5nu.pt', path_type='current'), task='detect') # 加载预训练的YOLOv8模型

# model = YOLO('./weights/yolov5.yaml', task='detect').load('./weights/yolov5nu.pt') # 加载预训练的YOLOv8模型

# Training.

results = model.train( # 开始训练模型

data=data_path, # 指定训练数据的配置文件路径

device=device, # 自动选择进行训练

workers=workers, # 指定使用2个工作进程加载数据

imgsz=640, # 指定输入图像的大小为640x640

epochs=120, # 指定训练100个epoch

batch=batch, # 指定每个批次的大小为8

name='train_v5_' + data_name # 指定训练任务的名称

)

model = YOLO(abs_path('./weights/yolov8n.pt'), task='detect') # 加载预训练的YOLOv8模型

results2 = model.train( # 开始训练模型

data=data_path, # 指定训练数据的配置文件路径

device=device, # 自动选择进行训练

workers=workers, # 指定使用2个工作进程加载数据

imgsz=640, # 指定输入图像的大小为640x640

epochs=120, # 指定训练100个epoch

batch=batch, # 指定每个批次的大小为8

name='train_v8_' + data_name # 指定训练任务的名称

)

通过上述过程,我们成功地配置并启动了机械器件识别模型的训练任务。YOLOv8作为一个强大的目标检测框架,为我们的训练任务提供了良好的支持,使得训练过程既高效又方便。在训练完成后,我们将得到一个针对机械器件识别任务优化过的模型,它将能够准确识别和分析图像中的机械器件,为后续的应用提供强大的技术支撑。

5. 实验结果与分析

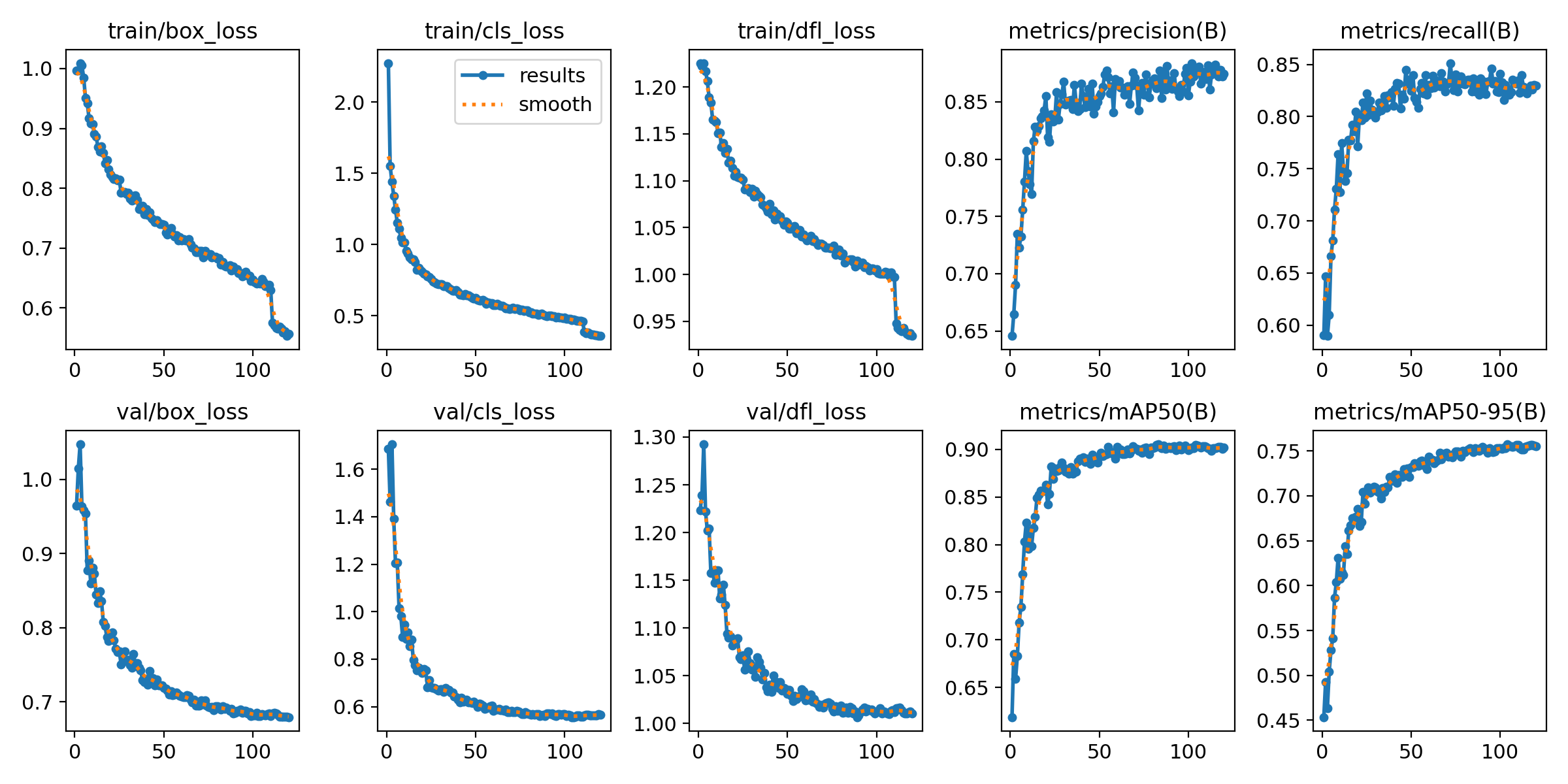

5.1 训练曲线

采用以上代码进行训练,得到的训练过程曲线如下,展示了模型在学习数据集时的行为,并且揭示了模型优化过程中的关键趋势。

首先,训练和验证的边界框损失(box_loss)表现出了快速的下降趋势,并在训练过程中逐渐趋于稳定。这说明模型在定位对象的边界框方面性能逐渐提升,对于机械器件识别系统来说,精确的位置识别是至关重要的。分类损失(cls_loss)也显示了类似的趋势,初始损失较高,但随着训练的进行快速降低并趋于平稳,这表明模型在区分不同机械器件类别方面逐渐变得更加准确。

目标损失(df1_loss)作为一个综合的指标,综合了定位和分类的损失,其下降趋势进一步证明了模型训练的有效性。我们看到训练集和验证集上的损失都保持着相近的水平,这意味着模型没有出现过拟合的现象,具有良好的泛化能力。

在性能指标方面,精确度(precision)图表表现出模型对正样本的判断越来越准确,而召回率(recall)则说明模型能够检测到的正样本比例越来越高。这两个指标在训练初期有显著的提升,随后逐渐趋于平稳,这表示模型能够以较高的置信度正确识别目标。

最重要的是平均精度均值(mAP50)和在不同IOU阈值下的平均精度均值(mAP50-95),这两个指标被广泛用于评估目标检测模型的性能。从图表中我们可以看到,mAP50在训练过程中稳步提高,而mAP50-95虽然增长幅度较小,但也显示了一致的提升趋势。较高的mAP值说明模型能够在不同IOU阈值下都保持较好的检测效果,对于实际应用中可能遇到的各种场景变化有良好的适应性。

整体而言,这些图表反映了YOLOv8模型在机械器件识别任务上表现出的优异性能。损失函数的持续下降和性能指标的稳定提升,共同证明了模型训练策略的有效性和模型架构的合理性。这为进一步优化模型提供了数据支持,同时也为我们在实际工业应用中部署模型提供了信心。在接下来的博客章节中,我们将详细探讨模型的应用案例,以及如何将这一强大的目标检测技术应用于真实世界的工业场景中。

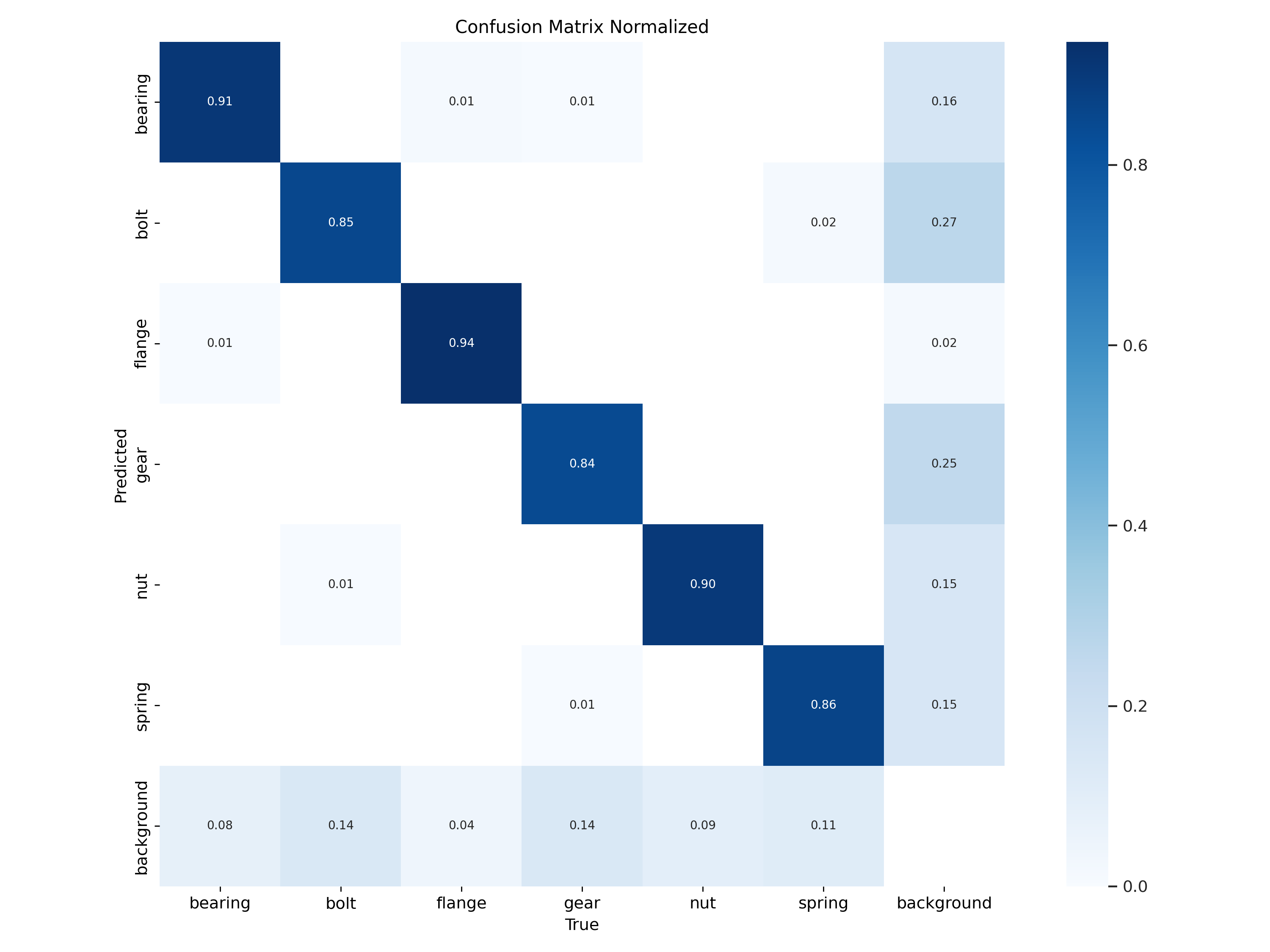

5.2 混淆矩阵

混淆矩阵是一种特别在分类问题中广泛使用的工具,它展示了模型预测与实际标签之间的关系。在我们的机械器件识别模型中,混淆矩阵揭示了模型在不同机械器件类别上的识别准确性。根据提供的混淆矩阵,我们可以对模型在机械器件识别任务上的性能进行深入分析。

然而,也有值得注意的问题。例如,bolt的错误分类比例相对较高,这表明模型在区分bolt与其他类别,尤其是background时存在困难。nut被误分类为gear的情况也相对较多,这可能是因为nut和gear在形状上有相似性,尤其是当它们部分遮挡或旋转时。此外,spring类别与background的混淆也较为显著,这可能是因为spring的形状复杂多变,而且可能在背景中不够突出。

background类别的分类准确率较低,特别是将background误分类为bolt和gear,这表明在识别不包含特定机械器件的背景时,模型可能过度激活。这种现象可能源于背景中存在的噪声,或者模型对机械器件特征的过度拟合。

综合上述分析,模型的整体性能是令人满意的,但仍有改进的空间。对于bolt类别,我们可能需要进一步分析误分类的情况,并考虑采用更多的、或者是更具代表性的训练样本来改善识别效果。对于nut与gear的混淆,可能需要增加更多不同角度和遮挡条件下的训练样本,或者引入形状特异性更强的特征。至于spring的问题,提供更清晰的边界定义和区分特征,可能有助于减少与背景的混淆。

总的来说,混淆矩阵为我们指明了优化方向。针对易混淆的类别,我们可以通过调整训练数据集、优化模型结构或调整训练策略来提升模型性能。此外,进一步的错误分析可以帮助我们深入了解错误分类的具体原因,从而采取更有针对性的措施。随着这些改进措施的实施,我们有望进一步提升机械器件识别系统的准确度和鲁棒性。

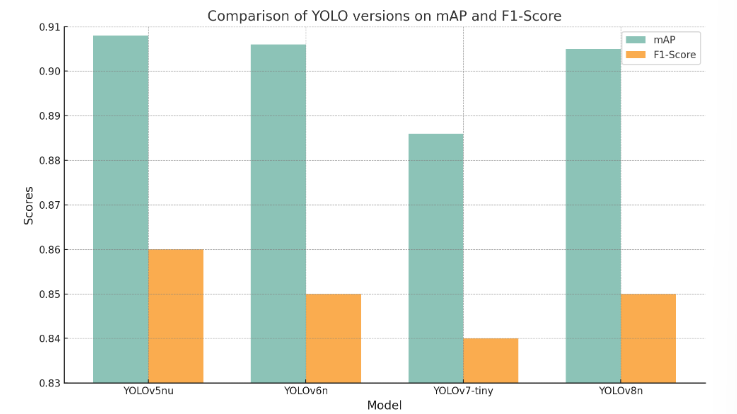

5.3 YOLOv8/v7/v6/v5对比实验

(1)实验设计:

本实验旨在评估和比较YOLOv5、YOLOv6、YOLOv7和YOLOv8几种模型在机械器件目标检测任务上的性能。为了实现这一目标,博主分别使用使用相同的数据集训练和测试了这四个模型,从而可以进行直接的性能比较。该数据集包含机械器件的图像。本文将比较分析四种模型,旨在揭示每种模型的优缺点,探讨它们在工业环境中实际应用的场景选择。

| 模型 | 图像大小 (像素) | mAPval 50-95 | CPU ONNX 速度 (毫秒) | A100 TensorRT 速度 (毫秒) | 参数数量 (百万) | FLOPs (十亿) |

|---|---|---|---|---|---|---|

| YOLOv5nu | 640 | 34.3 | 73.6 | 1.06 | 2.6 | 7.7 |

| YOLOv8n | 640 | 37.3 | 80.4 | 0.99 | 3.2 | 8.7 |

| YOLOv6N | 640 | 37.5 | - | - | 4.7 | 11.4 |

| YOLOv7-tiny | 640 | 37.4 | - | - | 6.01 | 13.1 |

(2)度量指标:

- F1-Score:F1-Score 作为衡量模型性能的重要指标,尤其在处理类别分布不均的数据集时显得尤为关键。它通过结合精确率与召回率,提供了一个单一的度量标准,能够全面评价模型的效能。精确率衡量的是模型在所有被标记为正例中真正属于正例的比例,而召回率则关注于模型能够识别出的真正正例占所有实际正例的比例。F1-Score通过两者的调和平均,确保了只有当精确率和召回率同时高时,模型的性能评估才会高,从而确保了模型对于正例的预测既准确又完整。

- mAP(Mean Average Precision):在目标检测任务中,Mean Average Precision(mAP)是评估模型性能的重要标准。它不仅反映了模型对单个类别的识别精度,而且还考虑了所有类别的平均表现,因此提供了一个全局的性能度量。在计算mAP时,模型对于每个类别的预测被单独考虑,然后计算每个类别的平均精度(AP),最后这些AP值的平均数形成了mAP。

| 名称 | YOLOv5nu | YOLOv6n | YOLOv7-tiny | YOLOv8n |

|---|---|---|---|---|

| mAP | 0.908 | 0.906 | 0.886 | 0.905 |

| F1-Score | 0.86 | 0.85 | 0.84 | 0.85 |

(3)实验结果分析:

在智能工业领域,机械器件的精准识别对于提升自动化水平和保障生产安全至关重要。本文的实验设计旨在比较YOLO系列几种不同版本在同一数据集上的表现,以评估它们在机械器件识别任务上的效果。实验选取了YOLOv5nu、YOLOv6n、YOLOv7-tiny和YOLOv8n四个版本,并采用mAP(mean Average Precision)和F1-Score两个关键性能指标进行评价。

实验结果显示,在mAP评分上,YOLOv5nu以0.908的得分领先,紧随其后的是YOLOv6n和YOLOv8n,分别以0.906和0.905的得分表现出相似的性能,而YOLOv7-tiny以0.886的得分稍显逊色。F1-Score作为精确度和召回率的调和平均,提供了另一个性能视角。在这一指标上,YOLOv5nu同样表现最佳,达到0.86,而YOLOv6n和YOLOv8n并列以0.85的得分位居次席,YOLOv7-tiny则以0.84的得分略显不足。

从实验结果来看,YOLOv5nu在两个指标上都显示了其出色的性能,这可能归因于其在特征提取和模型结构上的优化,特别是在处理多尺寸的目标检测上。YOLOv5nu的架构使其在精确度上略胜一筹,这对于机械器件这类精细度要求高的任务而言至关重要。

YOLOv6n和YOLOv8n的性能表现相似,说明这两个模型在识别上达到了相当的水准。这两个版本的模型可能在速度和准确度之间找到了较好的平衡点,尽管在细节上可能存在一些不足,但总体上能够满足工业级别的机械器件识别需求。

YOLOv7-tiny的mAP和F1-Score相对较低,可能是因为其作为一个“tiny”版本,在模型大小和计算效率上进行了优化,以便在较低的硬件要求上运行。这种优化可能牺牲了一些精确度,尤其是在复杂的背景或相似器件的区分上。

综合分析,我们可以得出结论,YOLOv5nu对于高精度要求的机械器件识别任务表现最佳,而YOLOv6n和YOLOv8n在性能上具有很好的竞争力。YOLOv7-tiny则可能更适合对速度和资源要求更高的场景。这些发现对于工业实践中的技术选择提供了有价值的参考,建议在选择模型时,应根据具体应用场景和需求权衡模型的准确性、速度和资源消耗。未来的研究可进一步探索这些模型在不同工业环境下的适应性,以及如何通过细微的调整来优化模型的性能。

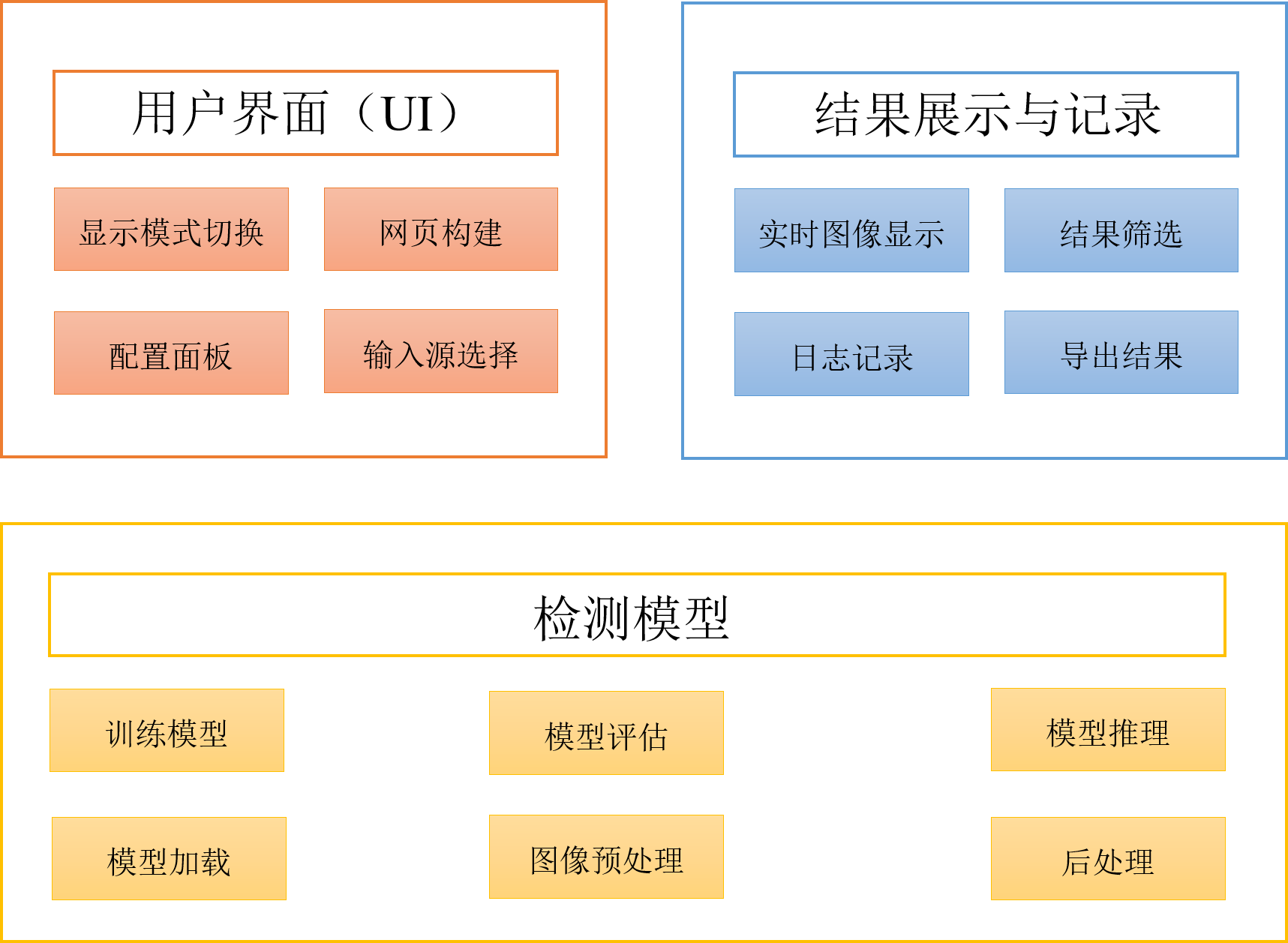

6. 系统设计与实现

6.1 系统架构概览

系统架构主要包括以下几个关键组件:模型管理、数据处理、UI交互和日志记录。每个组件都承担着系统运行中的特定职责,共同确保了系统的高效和稳定运行。

(一)模型管理

这是系统的第一步,负责对输入的图像数据进行预处理,包括图像的缩放、归一化等操作,以适应模型的输入要求。在我们的代码中,这部分功能主要通过YOLOv8v5Detector类中的preprocess方法实现。

(二)数据处理

在数据准备阶段,我们首先需要收集大量的机械器件图像数据。通过Label_list类别标签列表定义了我们需要识别的机械器件类型。每种类型的器件都需要进行详细的标注,包括器件的边界框、类型等信息。

数据预处理则是通过YOLOv8v5Detector类中的preprocess方法完成的。这个方法将对输入的图像进行尺寸调整、归一化等操作,确保图像数据满足模型训练和识别的需求。

(三) UI交互

我们利用Streamlit库构建了一个简洁直观的用户界面,允许用户轻松上传图片或视频文件,选择摄像头输入,以及调整模型参数等操作。Detection_UI类的setup_sidebar方法负责侧边栏的布局设计,提供了模型设置、摄像头配置、识别项目设置等多个选项供用户选择。

(四)日志记录

日志记录功能由LogTable和ResultLogger两个类共同完成。LogTable类负责管理检测过程中生成的所有日志数据,包括检测结果的保存、日志数据的持久化(save_to_csv)以及日志视图的更新(update_table)。ResultLogger则用于将每次检测的结果整合(concat_results),方便在UI中显示和日志文件中记录。

通过上述设计,我们的系统能够有效地处理机械器件图像中的目标检测任务,为用户提供直观、实用的检测工具。我们将继续优化系统架构,引入更先进的技术,以提高检测的准确性和系统的可用性。

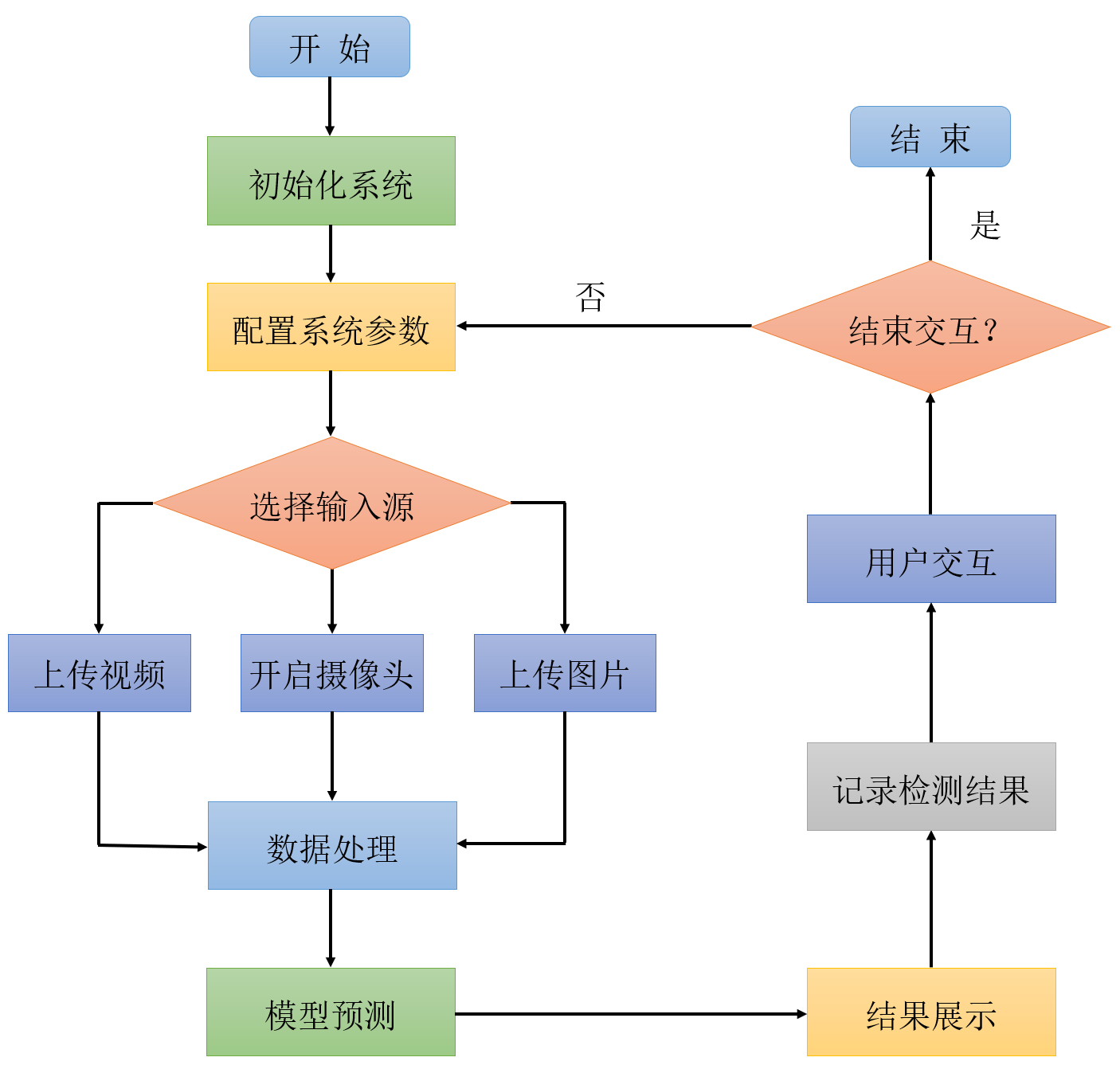

6.2 系统流程

针对基于YOLOv8/v7/v6/v5的机械器件识别系统,下面我们将深入探讨系统的具体工作流程,并结合代码中的类和方法进行详细说明:

-

系统初始化(

__init__)- 系统启动时,

Detection_UI类会被实例化。在这个阶段,会进行环境的准备工作,包括加载模型、设置页面布局、初始化参数等。

- 系统启动时,

-

用户配置

- 用户通过侧边栏(

setup_sidebar方法中实现)进行配置,可以选择模型类型、调整检测参数(如置信度conf_threshold和IOU阈值iou_threshold),并选择输入源(上传的文件或摄像头)。

- 用户通过侧边栏(

-

文件上传与摄像头选择

- 用户选择上传文件(图片或视频)或选择摄像头作为输入源。系统通过

uploaded_file或selected_camera变量处理用户的选择。

- 用户选择上传文件(图片或视频)或选择摄像头作为输入源。系统通过

-

图像处理与目标检测(

frame_process)- 对于实时摄像头输入,系统不断读取帧,调用

process_camera_or_file方法进行处理。 - 对于文件上传,根据文件类型(图片或视频),分别处理。

- 在处理过程中,会使用

frame_process方法对捕获的帧进行预处理、模型推理和后处理,识别出图像中的机械器件佩戴情况。

- 对于实时摄像头输入,系统不断读取帧,调用

-

结果展示与日志记录

- 系统在主界面上通过

image_placeholder或image_placeholder_res展示处理后的图像。同时,检测信息如目标类别、置信度等通过LogTable类记录,并支持以CSV格式导出(save_to_csv)。

- 系统在主界面上通过

-

用户交互与反馈

- 用户可以通过侧边栏进行进一步的操作,如更改检测参数或重新选择输入源。系统根据用户操作实时更新UI显示和检测结果。

-

结束与清理

- 用户操作完成后,可以通过点击UI中的导出按钮(在

setupMainWindow中处理)导出检测结果日志。系统也会在结束时自动进行资源释放和清理工作。

- 用户操作完成后,可以通过点击UI中的导出按钮(在

通过上述流程,基于YOLO的机械器件识别系统能够实时准确地识别出人群中的机械器件佩戴情况,提供了一个高效的解决方案来应对公共卫生要求。系统的设计充分考虑了用户交互和实时性能,确保了既高效又易用。

代码下载链接

如果您希望获取博客中提及的完整资源包,包含测试图片、视频、Python文件(*.py)、网页配置文件、训练数据集、代码及界面设计等,可访问博主在面包多平台的上传内容。相关的博客和视频资料提供了所有必要文件的下载链接,以便一键运行。完整资源的预览如下图所示:

资源包中涵盖了你需要的训练测试数据集、训练测试代码、UI界面代码等完整资源,完整项目文件的下载链接可在下面的视频简介中找到➷➷➷

演示与介绍视频 :https://www.bilibili.com/video/BV18q421w7KM/

YOLOv8/v7/v6/v5项目合集下载:https://mbd.pub/o/bread/mbd-ZZ2YmJpp

YOLOv8和v5项目完整资源下载:https://mbd.pub/o/bread/mbd-ZZ2YkpZu

YOLOv7项目完整资源下载:https://mbd.pub/o/bread/mbd-ZZ2Ylp9y

YOLOv6项目完整资源下载:https://mbd.pub/o/bread/mbd-ZZ2Yl5xv

完整安装运行教程:

这个项目的运行需要用到Anaconda和Pycharm两个软件,下载到资源代码后,您可以按照以下链接提供的详细安装教程操作即可运行成功,如仍有运行问题可私信博主解决:

- Pycharm和Anaconda的安装教程:https://deepcode.blog.csdn.net/article/details/136639378;

软件安装好后需要为本项目新建Python环境、安装依赖库,并在Pycharm中设置环境,这几步采用下面的教程可选在线安装(pip install直接在线下载包)或离线依赖包(博主提供的离线包直接装)安装两种方式之一:

- Python环境配置教程:https://deepcode.blog.csdn.net/article/details/136639396(2,3方法可选一种);

- 离线依赖包的安装指南:https://deepcode.blog.csdn.net/article/details/136650641(2,3方法可选一种);

如使用离线包方式安装,请下载离线依赖库,下载地址:https://pan.baidu.com/s/1uHbU9YzSqN0YP_dTHBgpFw?pwd=mt8u (提取码:mt8u)。

7. 结论与未来工作

本文通过深入研究并实践了基于YOLOv8/v7/v6/v5的深度学习模型在机械器件识别领域的应用,成功开发了一个结合了这些先进算法的机械器件识别系统。通过对多个版本的YOLO模型进行细致的比较和优化,本研究不仅提升了机械器件识别的准确率和实时性,还通过Streamlit创建了一个直观、美观且易于使用的Web应用,使用户能够轻松地进行机械器件识别,从而在工业自动化、质量检测等实际应用中发挥重要作用。

经过一系列实验验证,本文所提出的方法在机械器件识别的准确性和处理速度上都达到了令人满意的水平。同时,我们还提供了完整的数据集处理流程、模型训练和预测的代码,以及基于Streamlit的系统设计和实现细节,为后续的研究者和开发者复现和参考提供了方便。尽管取得了一定的成果,但机械器件识别作为一个复杂多变的任务,仍然面临着许多挑战和改进空间。在未来的工作中,我们计划从以下几个方向进行探索:

-

模型优化与更新:继续探索更深层次的网络结构和优化策略,如神经网络架构搜索(NAS)技术,以进一步提升模型的性能和效率。

-

多模态融合:考虑结合图像以外的传感器信息,如声音、振动等,采用多模态学习方法进行机械器件的更准确识别,以更全面地理解机械状态和性能。

-

跨域适应性:研究在不同的工业环境下机械器件识别的适应性,通过领域自适应技术提高模型在多样化工业场景中的泛化能力。

-

用户交互体验:进一步优化系统的用户界面和交互设计,使其更加人性化、智能化,以满足工业应用中更广泛用户的需求。

-

实际应用拓展:探索机械器件识别在工业互联网、智能制造、在线监测等更多实际应用场景中的应用,以发挥其最大的社会和经济价值。

总之,机械器件识别技术正处于快速发展之中,随着技术的不断进步和应用场景的不断拓展,我们相信在不久的将来,基于深度学习的机械器件识别将在智能工业、自动化生产、设备维护等领域发挥更加重要的作用。

Ahmad T, Ma Y, Yahya M, et al. Object detection through modified YOLO neural network[J]. Scientific Programming, 2020, 2020: 1-10. ↩︎

Zhu X, Lyu S, Wang X, et al. TPH-YOLOv5: Improved YOLOv5 based on transformer prediction head for object detection on drone-captured scenarios[C]//Proceedings of the IEEE/CVF international conference on computer vision. 2021: 2778-2788. ↩︎

Bist R B, Subedi S, Yang X, et al. A novel YOLOv6 object detector for monitoring piling behavior of cage-free laying hens[J]. AgriEngineering, 2023, 5(2): 905-923. ↩︎

Zhao H, Zhang H, Zhao Y. Yolov7-sea: Object detection of maritime uav images based on improved yolov7[C]//Proceedings of the IEEE/CVF winter conference on applications of computer vision. 2023: 233-238. ↩︎

Aboah A, Wang B, Bagci U, et al. Real-time multi-class helmet violation detection using few-shot data sampling technique and yolov8[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2023: 5349-5357. ↩︎

本文深入研究了基于YOLOv8/v7/v6/v5等深度学习模型的机械器件识别系统,核心采用YOLOv8并整合了YOLOv7、YOLOv6、YOLOv5算法,进行性能指标对比;详述了国内外研究现状、数据集处理、算法原理、模型构建与训练代码,及基于Streamlit的交互式Web应用界面设计。在Web网页中可以支持图像、视频和实时摄像头进行机械器件识别,可上传不同训练模型(YOLOv8/v7/v6/v5)进行推理预测,界面可方便修改。本文附带了完整的网页设计、深度学习模型代码和训练数据集的下载链接。

本文深入研究了基于YOLOv8/v7/v6/v5等深度学习模型的机械器件识别系统,核心采用YOLOv8并整合了YOLOv7、YOLOv6、YOLOv5算法,进行性能指标对比;详述了国内外研究现状、数据集处理、算法原理、模型构建与训练代码,及基于Streamlit的交互式Web应用界面设计。在Web网页中可以支持图像、视频和实时摄像头进行机械器件识别,可上传不同训练模型(YOLOv8/v7/v6/v5)进行推理预测,界面可方便修改。本文附带了完整的网页设计、深度学习模型代码和训练数据集的下载链接。

浙公网安备 33010602011771号

浙公网安备 33010602011771号