SelfCite: 通过自监督奖励提升LLM对上下文内容的引用质量

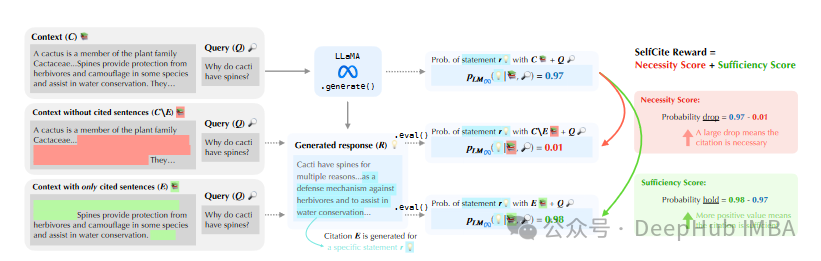

大型语言模型 (LLM) 在文本生成领域展现出卓越的能力,然而当需要 引用上下文内容 以支撑其生成内容时,现有方法仍面临挑战。 传统方法在引导 LLM 准确、可靠地对上下文内容进行引用时,容易产生 幻觉,即生成与上下文不符或缺乏上下文依据的引用,从而降低了生成回复的可信度和实用性。 为了解决这一关键问题,SelfCite 提出了一种新颖的自监督方法,旨在通过 自监督奖励机制,直接 提升 LLM 对上下文内容的引用质量,使其能够生成更准确、更可靠的句子级别引用,最终提升基于上下文的生成任务的整体性能。 SelfCite 的核心思想是利用 上下文消融 技术,通过模型自身评估引用质量,无需人工标注即可实现有效的引用优化。

https://avoid.overfit.cn/post/8e5ac05efeef4cc4b63a0f7b78ba744f

浙公网安备 33010602011771号

浙公网安备 33010602011771号