STAR: 利用时空注意力机制和动态频率损失的视频超分辨率增强框架

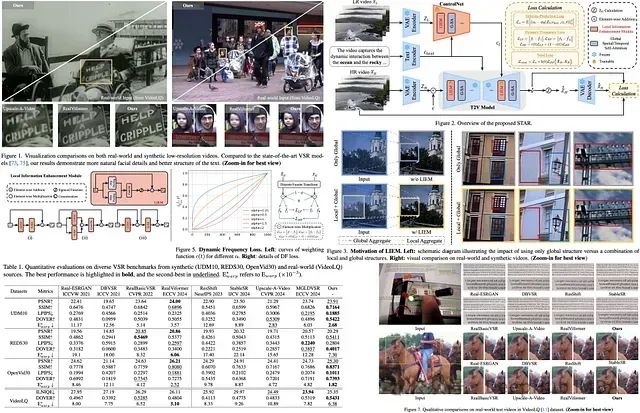

STAR (Spatial-Temporal Augmentation with Text-to-Video Models) 提出了一种创新的视频超分辨率解决方案,针对现有模型中存在的过度平滑和时间一致性不足等问题进行了系统性改进。该方法基于文本到视频(T2V)扩散模型架构,通过优化时序建模能力,有效处理复杂退化场景下的视觉伪影,同时解决了强生成模型导致的保真度损失问题。STAR的核心创新在于引入局部信息增强模块(LIEM)用于增强空间细节重建能力,并设计了动态频率(DF)损失函数,通过在扩散过程中对频率分量进行自适应调节来提升重建质量。实验表明,该方法在合成数据集和真实场景数据集上均优于现有最先进的方法。

https://avoid.overfit.cn/post/3e63ac5ec2844de6bd4d0675d13f7752

浙公网安备 33010602011771号

浙公网安备 33010602011771号