知识蒸馏技术原理详解:从软标签到模型压缩的实现机制

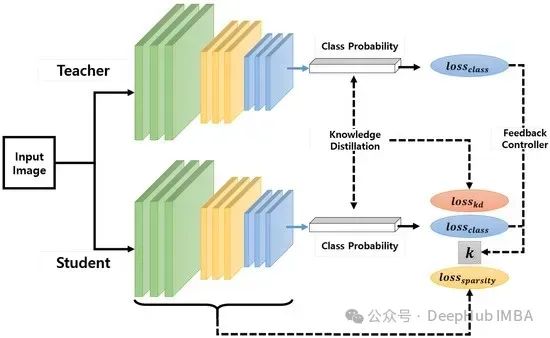

知识蒸馏是一种通过性能与模型规模的权衡来实现模型压缩的技术。其核心思想是将较大规模模型(称为教师模型)中的知识迁移到规模较小的模型(称为学生模型)中。本文将深入探讨知识迁移的具体实现机制。

知识蒸馏原理

知识蒸馏的核心目标是实现从教师模型到学生模型的知识迁移。在实际应用中,无论是大规模语言模型(LLMs)还是其他类型的神经网络模型,都会通过softmax函数输出概率分布。

https://avoid.overfit.cn/post/7645b073386c4cc88759c6ff418bf0e6

浙公网安备 33010602011771号

浙公网安备 33010602011771号