TorchOptimizer:基于贝叶斯优化的PyTorch Lightning超参数调优框架

超参数优化是深度学习模型开发过程中的一个核心技术难点。合适的超参数组合能够显著提升模型性能,但优化过程往往需要消耗大量计算资源和时间。本文介绍TorchOptimizer,这是一个基于贝叶斯优化方法的超参数优化框架,专门用于优化PyTorch Lightning模型的超参数配置。

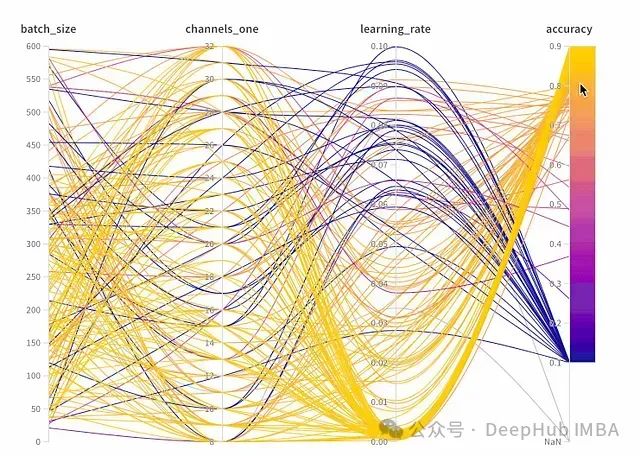

TorchOptimizer是一个集成了PyTorch Lightning框架和scikit-optimize贝叶斯优化功能的Python库。该框架通过高斯过程对目标函数进行建模,实现了高效的超参数搜索空间探索,并利用并行计算加速优化过程。主要功能如下:

贝叶斯优化机制:摒弃传统的网格搜索和随机搜索方法,采用高斯过程构建目标函数的概率模型,实现智能化的超参数组合选择。

并行计算架构:实现多CPU核心并行评估不同超参数配置,显著提升优化效率。

Lightning生态集成:专为PyTorch Lightning设计,完整支持callbacks机制和日志系统,实现无缝对接。

可配置搜索空间:基于scikit-optimize的维度规范,支持构建具有约束条件的复杂超参数搜索空间。

https://avoid.overfit.cn/post/f90c2a7c04994ae8ab73bd5ca98b46ff

浙公网安备 33010602011771号

浙公网安备 33010602011771号