PyTorch FlexAttention技术实践:基于BlockMask实现因果注意力与变长序列处理

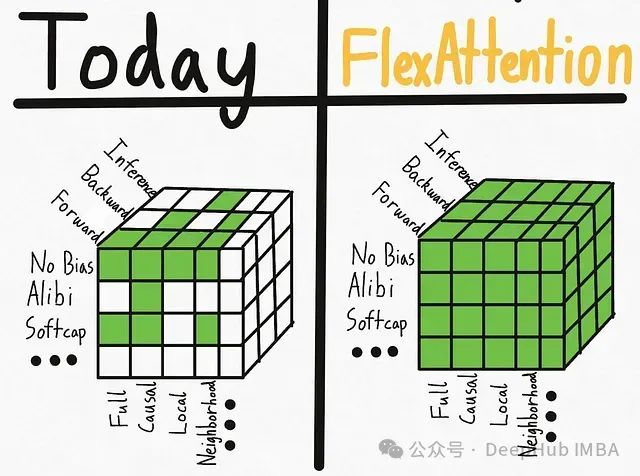

本文介绍了如何利用torch 2.5及以上版本中新引入的FlexAttention和BlockMask功能来实现因果注意力机制与填充输入的处理。

鉴于目前网络上缺乏关于FlexAttention处理填充输入序列的完整代码示例和技术讨论,本文将详细阐述一种实现方法,该方法同时涵盖了因果注意力机制的实现。

本文不会详细讨论FlexAttention的理论基础,如需了解更多技术细节,建议参考PyTorch官方博客。

https://avoid.overfit.cn/post/96d77c0f872c43dd8c752b687af7babf

浙公网安备 33010602011771号

浙公网安备 33010602011771号