基于图神经网络的大语言模型检索增强生成框架研究:面向知识图谱推理的优化与扩展

在大型语言模型(LLMs)相关的人工智能突破中,图神经网络(GNNs)与LLMs的融合已成为一个极具前景的研究方向。这两类模型的结合展现出显著的互补性,能够协同增强LLMs的推理能力和上下文理解能力。通过从知识图谱(KGs)存储的海量信息中进行智能化检索,该结合能够生成准确且不含幻觉的答案。

本文对面向知识图谱问答(Q&A)的GNN-LLM组合架构进行了多维度探索。研究重点关注了两种用于LLM检索增强生成(RAG)的GNN架构:He等人提出的G-Retriever,以及Mavromatis和Karypis提出的最新GNN检索增强生成(GNN-RAG)框架。后者采用RAG方式实现了基于ReaRev GNN架构的知识图谱问答。

我们首先运用PyTorch Geometric和G-Retriever构建GNN-LLM架构的探索性模型,从理论和实现两个维度建立对核心问题的基础认知。然后研究聚焦于最新提出的GNN-RAG架构,通过敏感性研究和架构改进,探索提升其知识图谱问答性能的方法。最后研究通过引入反思机制和教师网络的概念,对上述两种GNN-LLM架构的图推理能力进行了创新性扩展。这些概念基于GNN实现,并与近期语言模型研究中的思维链概念存在关联。本文主要聚焦于架构中GNN部分的优化与分析。

基线模型架构

在开始之前,我们首先简要概述G-Retriever和ReaRev(GNN-RAG模型的GNN组件)的原始架构,以此作为背景并引出本文的创新贡献。

G-Retriever

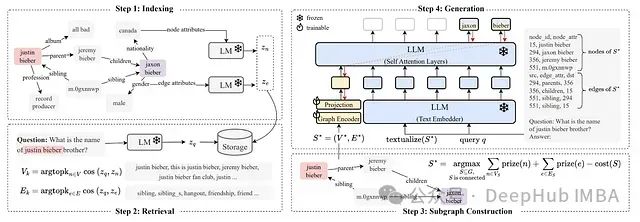

G-Retriever是He等人开发的基于图的LLM RAG模型架构。该架构首先使用预训练语言模型对现有知识图谱的节点、边和子图进行嵌入表示。随后将这些嵌入向量索引并存储在数据结构中,以实现高效的近邻检索。此步骤被称为索引阶段。在检索阶段,系统使用相同的语言模型对问题q进行编码,并通过k近邻算法识别与该问题最相关的节点和边。在子图构建阶段,系统采用PCST(Prize-Collecting Steiner Tree)优化算法进一步筛选这些选定的节点和边,构建与问题最相关的原始知识图谱的最优子图。

https://avoid.overfit.cn/post/0fcd46db11c845ffac9bbcbeccad55d9

浙公网安备 33010602011771号

浙公网安备 33010602011771号