TimeMOE: 使用稀疏模型实现更大更好的时间序列预测

传统上,预测这些趋势涉及针对每种情况的专门模型。最近的进展指向了可以处理广泛预测问题的"基础模型"。

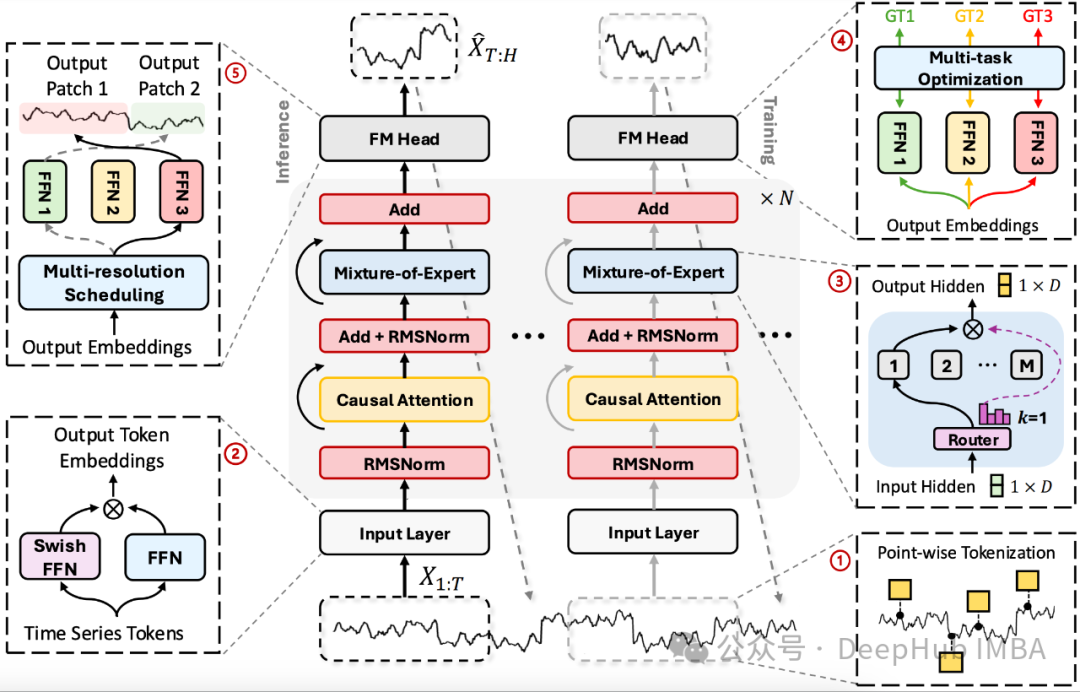

这是9月份刚刚发布的论文TimeMOE。它是一种新型的时间序列预测基础模型,"专家混合"(Mixture of Experts, MOE)在大语言模型中已经有了很大的发展,现在它已经来到了时间序列。

想象一下有一个专家团队,每个专家都有自己的专长。TimeMOE的工作原理与此类似。它不是为每个预测使用整个模型,而是只激活最适合特定任务的一小部分"专家"。这使得TimeMOE可以扩展到数十亿个参数,同时保持效率。

TimeMOE的研究目的主要包括:

- 开发一种可扩展的、统一的时间序列预测基础模型架构。

- 通过利用稀疏混合专家(MOE)设计,在提高模型能力的同时降低计算成本。

- 探索时间序列领域的缩放定律,验证增加模型规模和训练数据量是否能持续改善性能。

- 创建一个大规模、高质量的时间序列数据集(Time-300B),用于预训练更强大的预测模型。

- 在零样本和微调场景下评估模型的通用预测能力。

https://avoid.overfit.cn/post/6edf19076ad7460291afb38be5dd687d

浙公网安备 33010602011771号

浙公网安备 33010602011771号