PiSSA :将模型原始权重进行奇异值分解的一种新的微调方法

我们开始看4月的新论文了,这是来自北京大学人工智能研究所、北京大学智能科学与技术学院的研究人员发布的Principal Singular Values and Singular Vectors Adaptation(PiSSA)方法。

PiSSA和LoRA一样,都是基于这样的前提:对模型参数的改变会形成一个低秩矩阵。

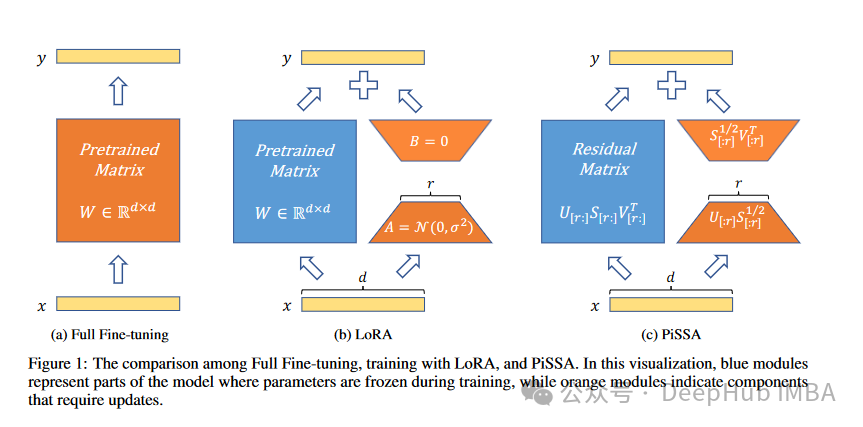

这种方法通过将模型中的矩阵表示为两个可训练矩阵的乘积,辅以一个用于错误校正的残差矩阵,优化了紧凑的参数空间。利用奇异值分解(SVD),PiSSA初始化主奇异值和奇异向量以训练这两个矩阵,同时在微调过程中保持残差矩阵静态。

PiSSA与LoRA的架构相一致,继承了诸如可训练参数减少、轻松部署等好处。但是与LoRA不同,使用PiSSA进行微调的过程与完整模型过程相似,会避免无效的梯度步骤和次优结果。

在LLaMA 2-7B、Mistral-7B-v0.1和Gemma-7B模型的多个任务的比较实验中,PiSSA凭借卓越的表现脱颖而出。以主奇异值和向量初始化的微调适配器产生了更好的结果。

https://avoid.overfit.cn/post/33c2c6c983364b629c1e01479836bacc

浙公网安备 33010602011771号

浙公网安备 33010602011771号