SiMBA:基于Mamba的跨图像和多元时间序列的预测模型

这是3月26日新发的的论文,微软的研究人员简化的基于mamba的体系结构,并且将其同时应用在图像和时间序列中并且取得了良好的成绩。

语言模型的发展正在从大型语言模型(LLMs)向小型语言模型(SLMs)转变。llm和slm的核心都是transformers,它是llm和slm的构建模块。虽然transformers通过其注意力网络已经证明了其跨领域的卓越性能,但注意力存在许多问题,包括低归纳偏置和输入序列长度的二次复杂度。

状态空间模型(ssm)在处理信息密集数据建模方面效率较低,特别是在计算机视觉等领域,并且在基因组数据等离散场景中面临挑战。为了解决典型状态空间模型难以有效处理长序列的问题,最近提出了一种选择性状态空间序列建模技术Mamba。但是Mamba却有稳定性问题,当扩展到计算机视觉数据集的大型网络时,训练损失不收敛。

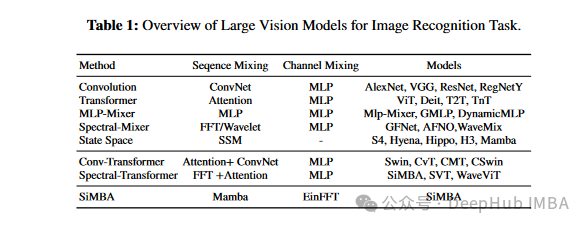

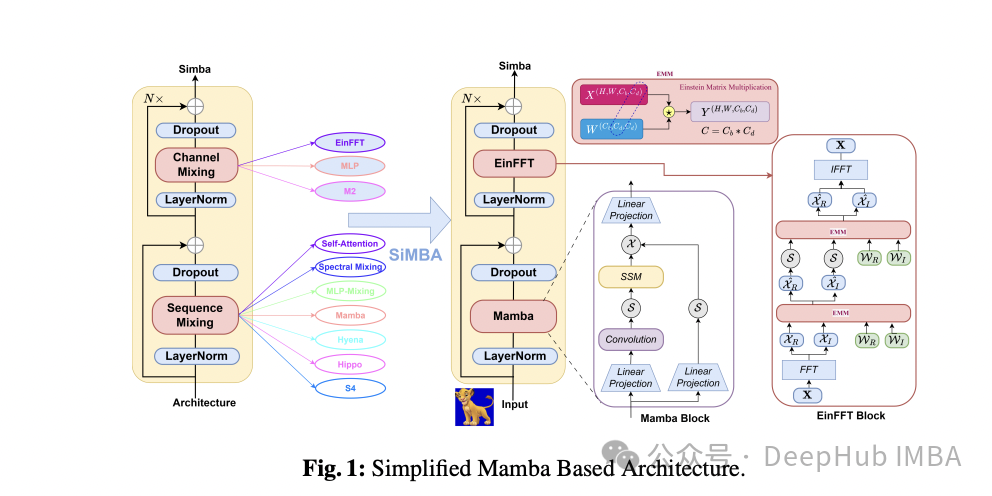

来自微软的研究人员介绍了SiMBA,这是一种引入EinFFT进行通道建模的新架构。SiMBA体系结构将Mamba用于序列建模,并引入EinFFT作为一种新的通道建模技术。有效地解决了在扩展到大型网络时在Mamba中观察到的不稳定性问题。该方法突出了基于卷积模型、transformers模型、mlp混频器、频谱混频器模型和状态空间方法的各种模型。论文还介绍了将卷积与transformers或频谱方法相结合的混合模型。

SiMBA的信道混合包含三个主要组件:频谱变换、使用爱因斯坦矩阵乘法的频谱门控网络和逆频谱变换。EinFFT通过在复数表示上应用爱因斯坦矩阵乘法来利用频域信道混合。这使得能够提取具有增强的全局可见性和能量集中度的关键数据模式。Mamba结合MLP进行信道混合可以弥补小规模网络的性能差距,但对于大型网络可能存在同样的稳定性问题。结合EinFFT, Mamba解决了小型和大型网络的稳定性问题。

浙公网安备 33010602011771号

浙公网安备 33010602011771号