Quiet-STaR:让语言模型在“说话”前思考

大型语言模型(llm)已经变得越来越复杂,能够根据各种提示和问题生成人类质量的文本。但是他们的推理能力让仍然是个问题,与人类不同LLM经常在推理中涉及的隐含步骤中挣扎,这回导致输出可能在事实上不正确或缺乏逻辑。

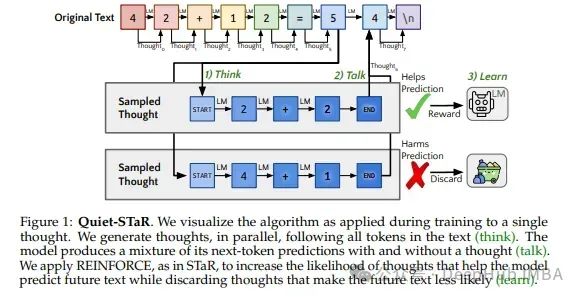

考虑以下场景:正在阅读一个复杂的数学证明。虽然最终的答案可能很清楚,但关键在于理解初始条件和结论之间未说明的步骤。在交谈中也一样,我们依靠中间的假设和背景知识来理解所说的话。这种内隐的推理的能力是Quiet-STaR为LLM提供的能力。

https://avoid.overfit.cn/post/1ea458c86cf14b45ac219e7d7e82cdc4

浙公网安备 33010602011771号

浙公网安备 33010602011771号