可视化FAISS矢量空间并调整RAG参数提高结果精度

随着开源大型语言模型的性能不断提高,编写和分析代码、推荐、文本摘要和问答(QA)对的性能都有了很大的提高。但是当涉及到QA时,LLM通常会在未训练数据的相关的问题上有所欠缺,很多内部文件都保存在公司内部,以确保合规性、商业秘密或隐私。当查询这些文件时,会使得LLM产生幻觉,产生不相关、捏造或不一致的内容。

为了处理这一挑战的一种可用技术是检索增强生成(retrieve - augmented Generation, RAG)。它涉及通过在响应生成之前引用其训练数据源之外的权威知识库来增强响应的过程。RAG应用程序包括一个检索系统,用于从语料库中获取相关文档片段,以及一个LLM,用于使用检索到的片段作为上下文生成响应,所以语料库的质量及其在向量空间中的表示(称为嵌入)在RAG的准确性中发挥重要作用。

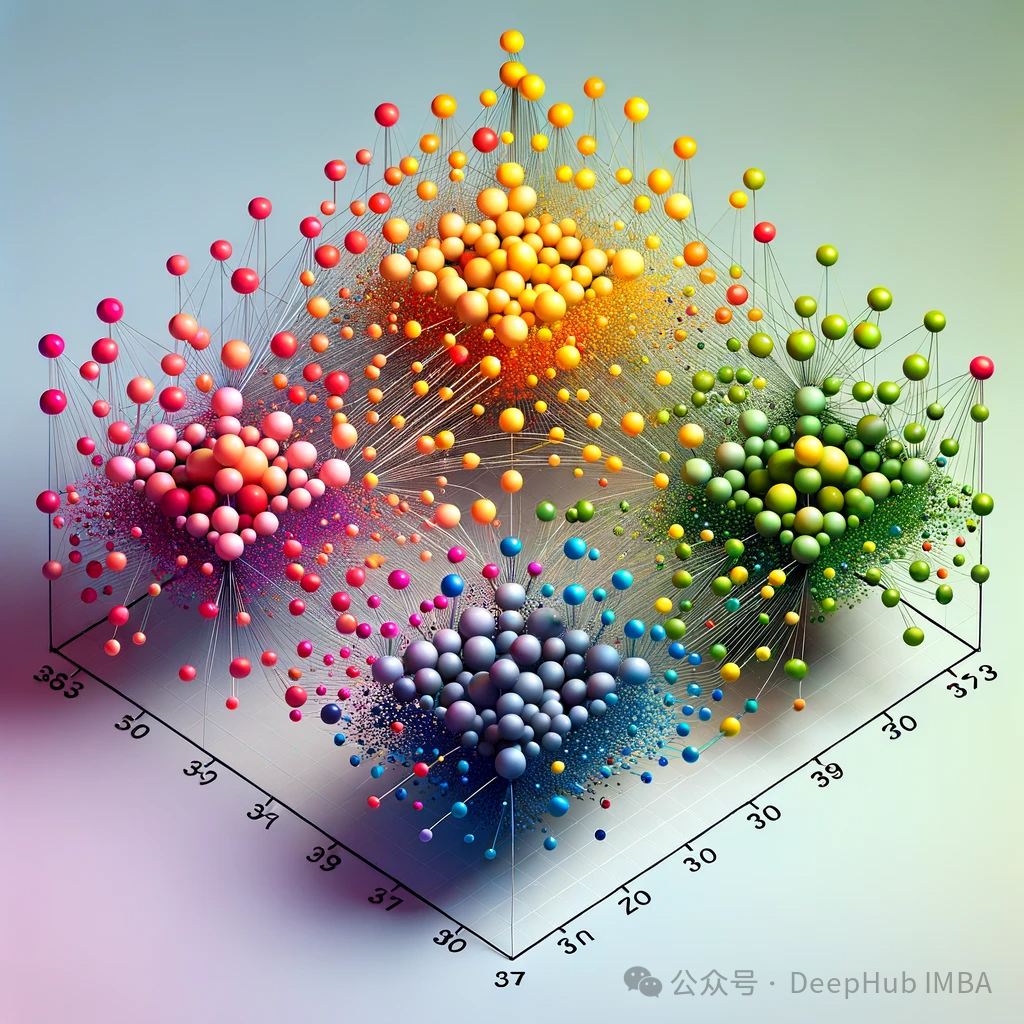

在本文中,我们将使用可视化库renumics-spotlight在2-D中可视化FAISS向量空间的多维嵌入,并通过改变某些关键的矢量化参数来寻找提高RAG响应精度的可能性。对于我们选择的LLM,将采用TinyLlama 1.1B Chat,这是一个紧凑的模型,与Llama 2相同的架构。它的优点是具有更小的资源占用和更快的运行时间,但其准确性没有成比例的下降,这使它成为快速实验的理想选择。

https://avoid.overfit.cn/post/30168a23de744b3f91ec22da1725eb14

浙公网安备 33010602011771号

浙公网安备 33010602011771号