使用LM Studio在本地运行LLM完整教程

GPT-4被普遍认为是最好的生成式AI聊天机器人,但开源模型一直在变得越来越好,并且通过微调在某些特定领域是可以超过GPT4的。在开源类别中出于以下的原因,你可能会考虑过在本地计算机上本地运行LLM :

- 脱机:不需要互联网连接。

- 模型访问:在本地运行模型,可以尝试开源模型(Llama 2、Vicuna、Mistral、OpenOrca等等)。

- 隐私:当在本地运行模型时,没有信息被传输到云。尽管在使用GPT-4、Bard和claude 2等基于云的模型时,隐私问题可能被夸大了,但在本地运行模型可以避免任何问题。

- 实验:如果你看到了生成人工智能的价值,可以通过测试了解模型的细节并知道还有什么可用。

- 成本:开源模型是免费的,其中一些可以不受限制地用于商业。

对许多人来说,运行本地LLM需要一点计算机知识,因为它通常需要在命令提示符中运行它们,或者使用更复杂的web工具,如Oobabooga。

LM Studio是一个免费的桌面软件工具,它使得安装和使用开源LLM模型非常容易。

但是请记住,LM Studio并不开源,只是免费使用

但是LM Studio是我目前见到最好用,也是最简单的本地测试工具,所以如果是本机测试使用的话还是推荐试一试他。

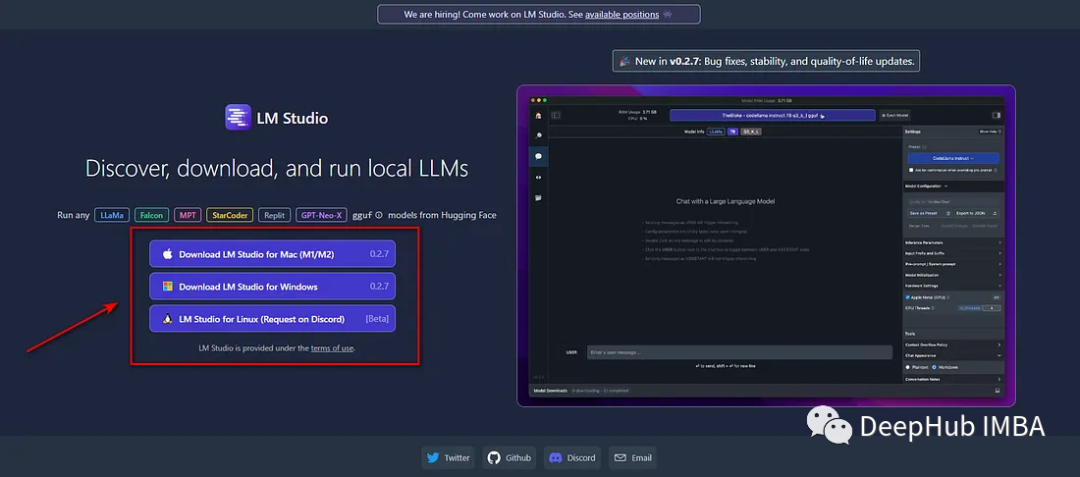

首先进入“lmstudio.ai”,下载并安装适合操作系统的版本:

LM Studio,选择要安装的LLM。

https://avoid.overfit.cn/post/bc8b0a511ea94cad81b581ef5bd19d39

浙公网安备 33010602011771号

浙公网安备 33010602011771号