DeepSpeed-MoE:训练更大及更复杂的混合专家网络

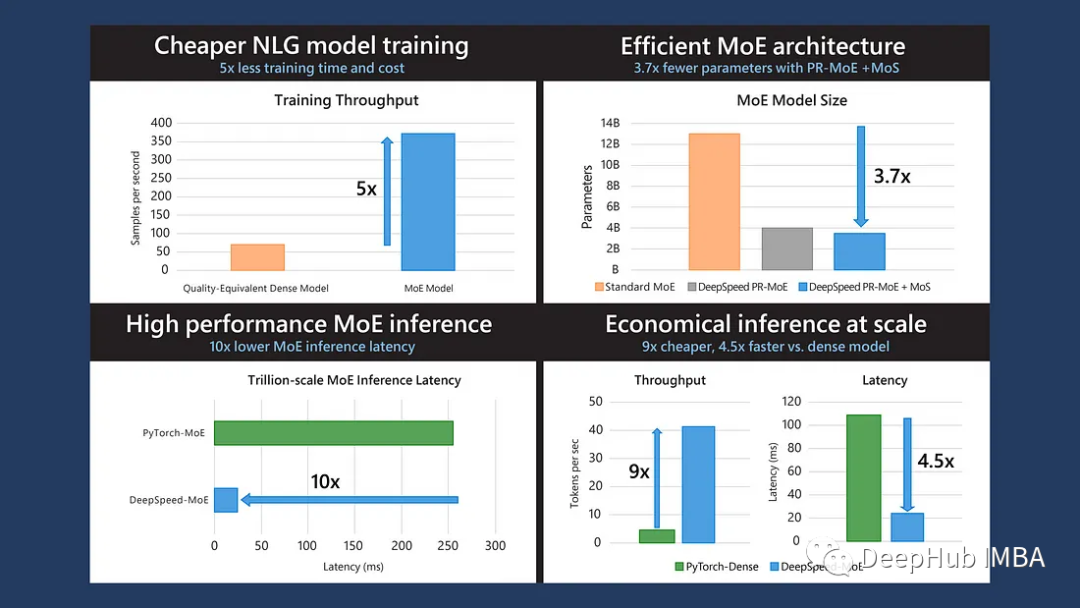

这是微软发布在2022 ICML的论文,MoE可以降低训练成本,但是快速的MoE模型推理仍然是一个未解决的问题。所以论文提出了一个端到端的MoE训练和推理解决方案DeepSpeed-MoE:它包括新颖的MoE架构设计和模型压缩技术,可将MoE模型大小减少3.7倍;通过高度优化的推理系统,减少了7.3倍的延迟和成本;与同等质量的密集模型相比,推理速度提高4.5倍,成本降低9倍。

https://avoid.overfit.cn/post/745c466e10d3494faa54b21191fa762c

浙公网安备 33010602011771号

浙公网安备 33010602011771号