注意力机制中的掩码详解

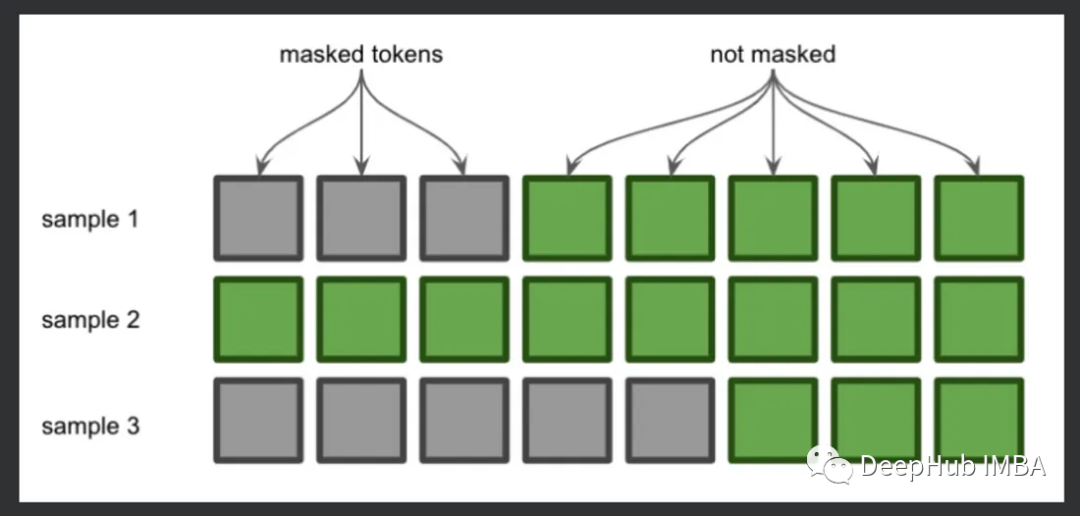

注意力机制的掩码允许我们发送不同长度的批次数据一次性的发送到transformer中。在代码中是通过将所有序列填充到相同的长度,然后使用“attention_mask”张量来识别哪些令牌是填充的来做到这一点,本文将详细介绍这个掩码的原理和机制。

我们先介绍下如果不使用掩码,是如何运行的。这里用GPT-2每次使用一个序列来执行推理,因为每次只有一个序列,所以速度很慢:

https://avoid.overfit.cn/post/0538d928a1c14940b3861437ea2fcffa

浙公网安备 33010602011771号

浙公网安备 33010602011771号