LayerNorm 在 Transformers 中对注意力的作用研究

LayerNorm 一直是 Transformer 架构的重要组成部分。如果问大多人为什么要 LayerNorm,一般的回答是:使用 LayerNorm 来归一化前向传播的激活和反向传播的梯度。

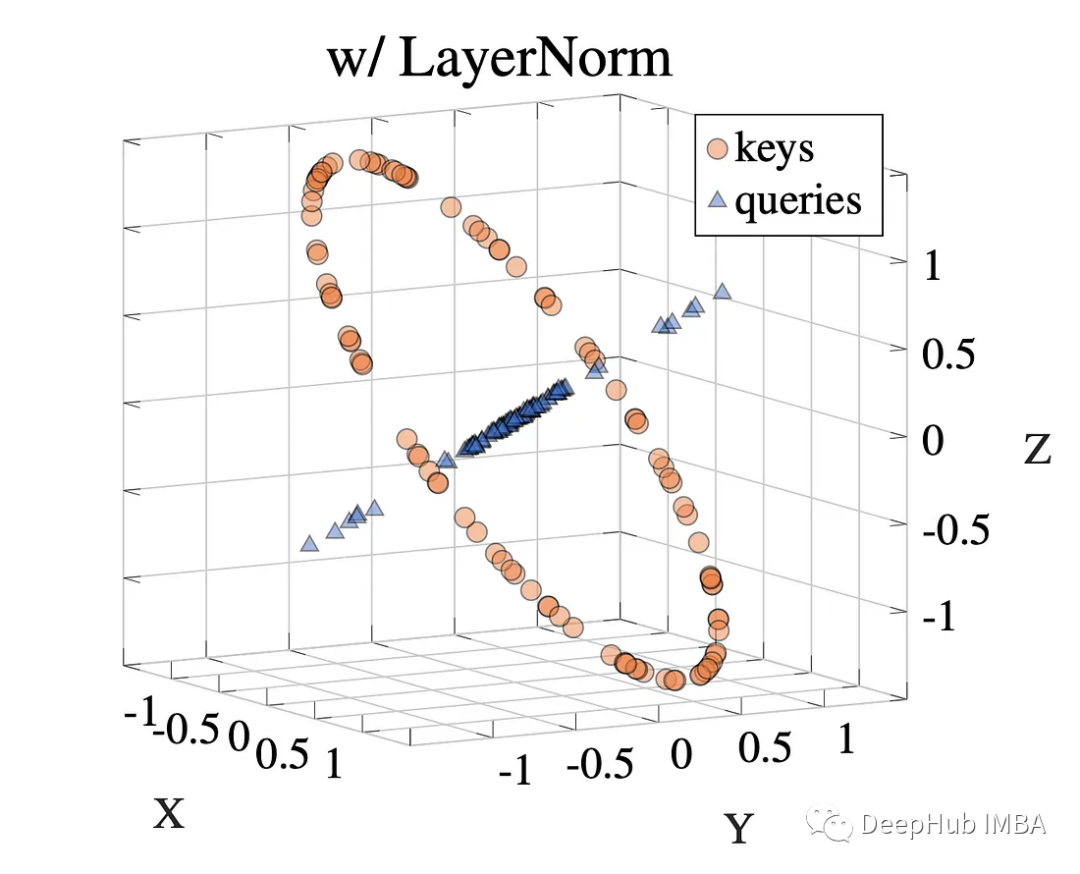

其实这只是部分正确:Brody、Alon 和 Yahav 的一篇题为“On the Expressivity Role of LayerNorm in Transformer's Attention”的新论文表明,LayerNorm 的作用要深得多。

完整文章:

https://avoid.overfit.cn/post/ac6bbc9b20fb4bd292009d0a5370bb46

浙公网安备 33010602011771号

浙公网安备 33010602011771号