KL散度和交叉熵的对比介绍

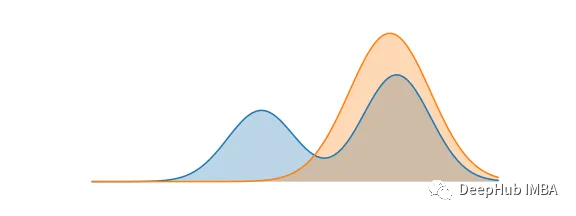

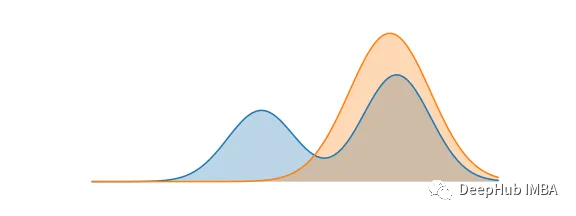

KL散度(Kullback-Leibler Divergence)和交叉熵(Cross Entropy)是在机器学习中广泛使用的概念。这两者都用于比较两个概率分布之间的相似性,但在一些方面,它们也有所不同。本文将对KL散度和交叉熵的详细解释和比较。

完整文章:

https://avoid.overfit.cn/post/030de9dfd01e45e5ba23bf1a9b36c70b

KL散度(Kullback-Leibler Divergence)和交叉熵(Cross Entropy)是在机器学习中广泛使用的概念。这两者都用于比较两个概率分布之间的相似性,但在一些方面,它们也有所不同。本文将对KL散度和交叉熵的详细解释和比较。

完整文章:

https://avoid.overfit.cn/post/030de9dfd01e45e5ba23bf1a9b36c70b