设置机器名

sudo vi /etc/sysconfig/network

reboot重启后生效

设置IP与机器名的映射

sudo vi /etc/hosts

按照<IP地址><主机名>的方式加入,注意这里用的是tab不是空格

然后ping hadoop检验是否成功

关闭防火墙

sudo chkconfig iptables off

接下来关闭SELinux,gentenforce查看

如果不是disabled就修改 /etc/selinux/config 文件

将 SELINUX=enforcing 改为 SELINUX=disabled,执行该命令后重启机器生效

接下来配置jdk,jdk配置我的其他博客有这里不说。

接着 更新Openssl

yum update openssl

下载 hadoop-1.1.2-bin.tar.gz 安装包,解压该安装包并把该安装包复制到 /app 目录中

cd /home/shiyanlou/install-pack

tar -xzf hadoop-1.1.2-bin.tar.gz

rm -rf /app/hadoop-1.1.2

mv hadoop-1.1.2 /app然后在 Hadoop-1.1.2 目录下创建子目录

cd /app/hadoop-1.1.2

mkdir -p tmp hdfs hdfs/name hdfs/data

ls进入 hdfs 目录中,使用chmod -R 755 data命令把 hdfs/data 设置为 755,否则 DataNode 会启动失败

2.3.3 配置 hadoop-env.sh

1.进入 hadoop-1.1.2/conf 目录,打开配置文件 hadoop-env.sh

cd /app/hadoop-1.1.2/conf

vi hadoop-env.sh2.加入配置内容,设置 hadoop 中 jdk 和 hadoop/bin 路径

export JAVA_HOME=/app/lib/jdk1.7.0_55

export PATH=$PATH:/app/hadoop-1.1.2/bin3.编译配置文件 hadoop-env.sh,并确认生效

source hadoop-env.sh

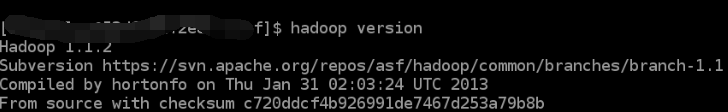

hadoop version

2.3.4 配置 core-site.xml

1.sudo vi core-site.xml

2.在配置文件中,按照如下内容进行配置

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://hadoop:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/app/hadoop-1.1.2/tmp</value>

</property>

</configuration>

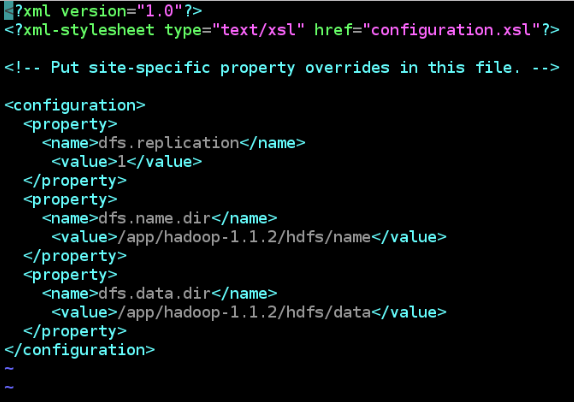

2.3.5 配置 hdfs-site.xml

1.sudo vi hdfs-site.xml

2.在配置文件中,按照如下内容进行配置

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.name.dir</name>

<value>/app/hadoop-1.1.2/hdfs/name</value>

</property>

<property>

<name>dfs.data.dir</name>

<value>/app/hadoop-1.1.2/hdfs/data</value>

</property>

</configuration>

2.3.6 配置 mapred-site.xml

1.vi mapred-site.xml

2.在配置文件中,按照如下内容进行配置

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>hadoop:9001</value>

</property>

</configuration>

设置主从均为hadoop

1.设子主节点

vi master2.设置从节点

vi slaves格式化 namenode

cd /app/hadoop-1.1.2/bin ./hadoop namenode -format

启动 hadoop

./start-all.sh

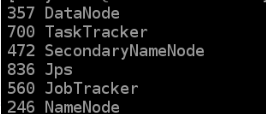

使用 jps 命令hadoop的进程启动的怎么样

至此,hadoop就配置完成

===========

参考:实验楼

posted on

posted on