会员

周边

新闻

博问

闪存

众包

赞助商

Chat2DB

所有博客

当前博客

我的博客

我的园子

账号设置

会员中心

简洁模式

...

退出登录

注册

登录

datieren

博客园

首页

新随笔

联系

订阅

管理

2025年5月11日

正交基

摘要: 正交基 = 一组两两正交的向量,用来描述一个子空间。 只有“整组”才叫正交基,单个 只是组里的成员而已。

阅读全文

posted @ 2025-05-11 12:23 2426051714

阅读(35)

评论(0)

推荐(0)

2025年5月9日

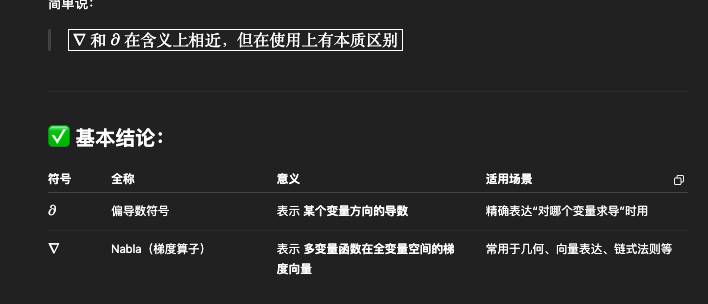

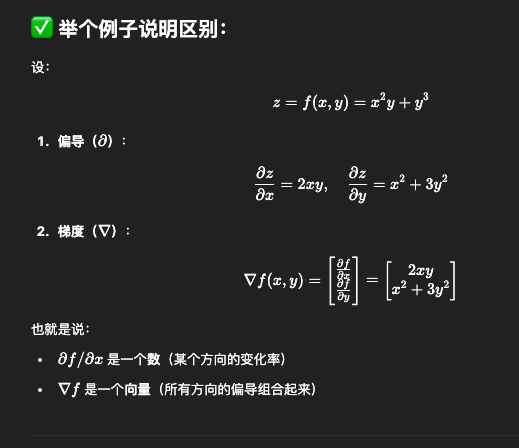

∂和∇区别

摘要:

评论(0)

推荐(0)

2025年2月28日

etf分类器

摘要: feature, logit, out = node.model(data) # PyTorch,模型的.model(data)调用通常涉及到两个主要步骤:前向传播和激活输出的计算。这里没有直接涉及到反向传播,因为反向传播是在损失函数计算之后,通过调用损失函数的.backward()方法来执行的。

阅读全文

posted @ 2025-02-28 10:27 2426051714

阅读(93)

评论(0)

推荐(0)

2025年1月19日

题目

摘要: 要突出问题和方法

阅读全文

posted @ 2025-01-19 09:10 2426051714

阅读(8)

评论(0)

推荐(0)

2025年1月13日

AttributeError: module 'torch' has no attribute '_six'

摘要: torch 2.4.1 torchvision 0.13.0 升级torchvision 0.19.1

阅读全文

posted @ 2025-01-13 22:24 2426051714

阅读(16)

评论(0)

推荐(0)

2025年1月11日

collections.OrderedDict

摘要: 在Python的collections模块中,OrderedDict是一个非常有用的类,它是一个字典的子类,能够记住元素插入的顺序。这在需要保持键值对顺序的场景中非常有用,尤其是在处理需要顺序操作的数据时。 可以像创建普通字典一样创建OrderedDict,但OrderedDict会记住元素插入的顺

阅读全文

posted @ 2025-01-11 19:55 2426051714

阅读(127)

评论(0)

推荐(0)

2024年12月31日

model

摘要: 所有的网络都要继承nn.Module,这个类中封装好了很多函数,例如train(),to, cuda, state_dict, load_state_dict等; train model.train() 并不是真的执行训练, 而是PyTorch 中 nn.Module 的一个方法,用于将模型设置为训

阅读全文

posted @ 2024-12-31 08:59 2426051714

阅读(26)

评论(0)

推荐(0)

2024年12月17日

Non-iid之标签偏移和特征偏移

摘要: 标签偏移: 标签偏移指的是不同客户端之间类标签的先验概率(P(y))不同。这意味着在某些客户端上某个或某些类别的样本比其他客户端多或少。 特征偏移: 顾名思义,是输入的数据细节部分发生偏移,但标签是一样的。例如,同样一只猫,光源不同,背景不同,特征P(x)不同(特征偏移),但P(y|X)保持不变。

阅读全文

posted @ 2024-12-17 15:44 2426051714

阅读(119)

评论(0)

推荐(0)

logits

摘要: logits通常指的是一个神经网络模型最后一层(输出层之前的层)输出的原始预测值,尚未经过归一化或激活函数(如softmax函数)处理的值。这些值在经过激活函数处理后,可以转换成概率分布,用于多分类问题中每个类别的概率预测。 全连接层输出的是logits,然后logits经过激活函数得到最后的预测值

阅读全文

posted @ 2024-12-17 09:07 2426051714

阅读(293)

评论(0)

推荐(0)

2024年12月6日

特征向量、神经元以及特征空间

摘要: 特征向量和神经元的区别和联系: 特征向量是神经元的输出;但不是神经元本身,神经元是计算单元,它是将上一层的输出,即特征向量,经过权重和偏置后,再经过激活函数的激活,最终形成神经元的输出。 特征向量和特征空间: 如果是其中一层的输出,例如最后一层通常是数据的最高表示,那么所有可能输出的特征向量共同组成

阅读全文

posted @ 2024-12-06 10:47 2426051714

阅读(57)

评论(0)

推荐(0)

下一页

公告