图文讲解基于centos虚拟机的Hadoop集群安装,并且使用Mahout实现贝叶斯分类实例 (5)

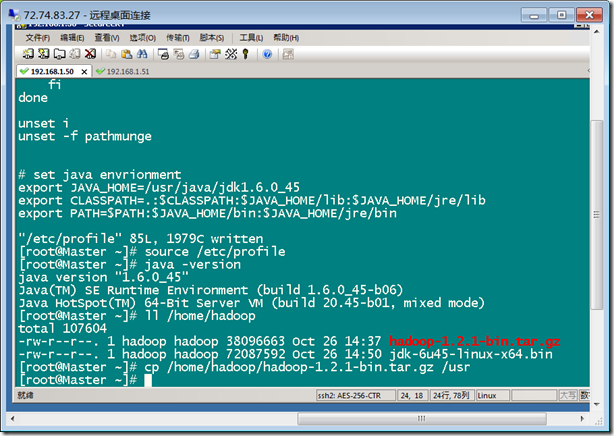

Root用户登录Master, 把 /home/hadoop目录下的hadoop-bin.tar.gz文件复制到 /usr文件夹下。

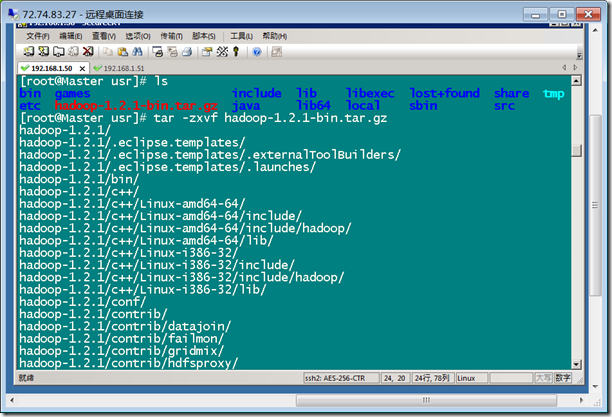

进入 /usr文件夹,解压 hadoop-bin.tar.gz文件: tar –zxvf hadoop.tar.gz

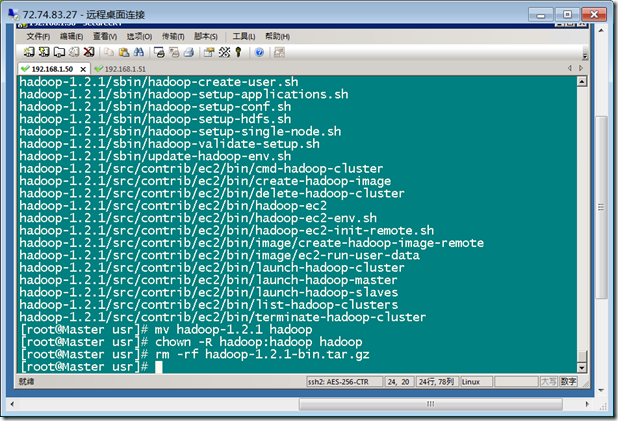

解压后并重命名为hadoop :mv hadoop-1.0.0 hadoop

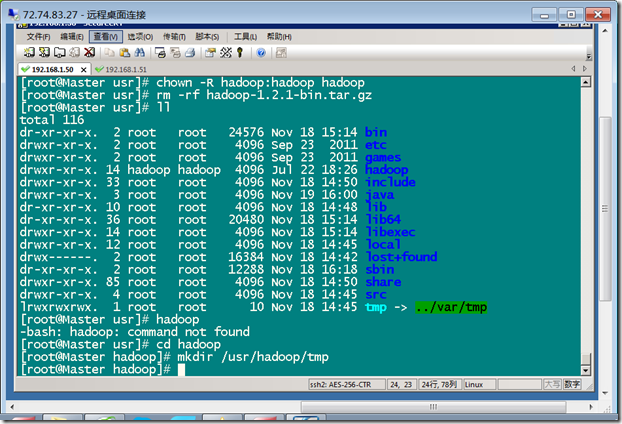

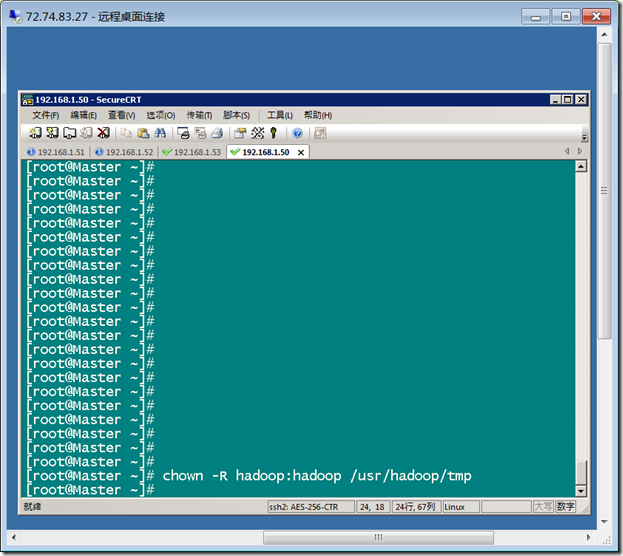

配置hadoop文件用户权限: chown -R hadoop:hadoop hadoop

删除 hadoop.tar.gz: rm -rf hadoop.tar.gz

在 /usr/hadoop文件夹下创建文件夹tmp

把 hadoop用户的权限赋予 tmp文件夹

chown -R hadoop:hadoop /usr/hadoop/tmp

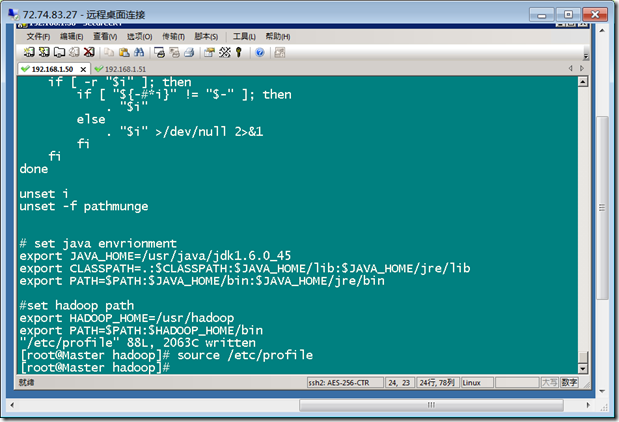

配置环境变量: vim /etc/profile

#set hadoop path

export HADOOP_HOME=/usr/hadoop

export PATH=$PATH :$HADOOP_HOME/bin

使用 source /etc/profile 使之生效

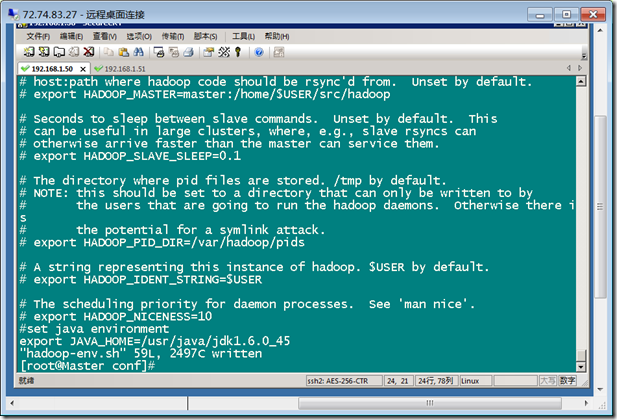

进入 /usr/hadoop/conf 文件夹下,修改配置文件 hadoop-env.sh: vim hadoop-env.sh

在末尾添加:

#set java environment

export JAVA_HOME=/usr/java/jdk1.6.0_45

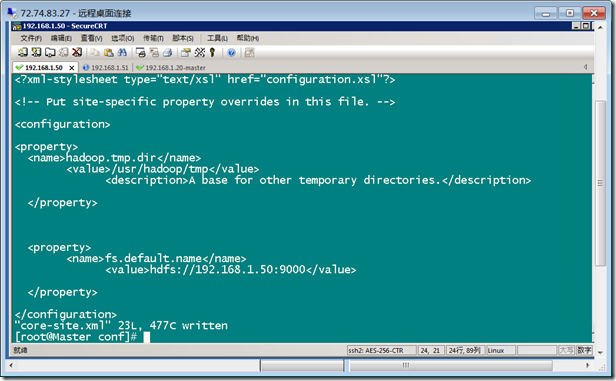

配置 core-site.xml文件,在configuration中间添加:

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/hadoop/tmp</value>

<description>A base for other temporary directories.</description>

</property>

<property>

<name>fs.default.name</name>

<value>hdfs://192.168.1.50:9000</value>

</property>

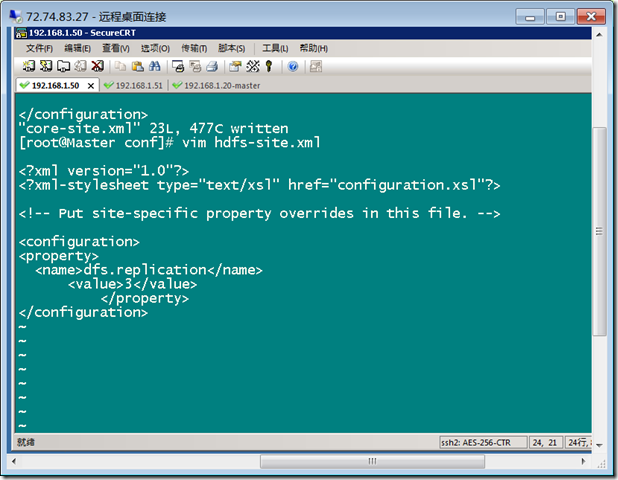

配置 vim hdfs-site.xml, 在configuration 中添加:

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

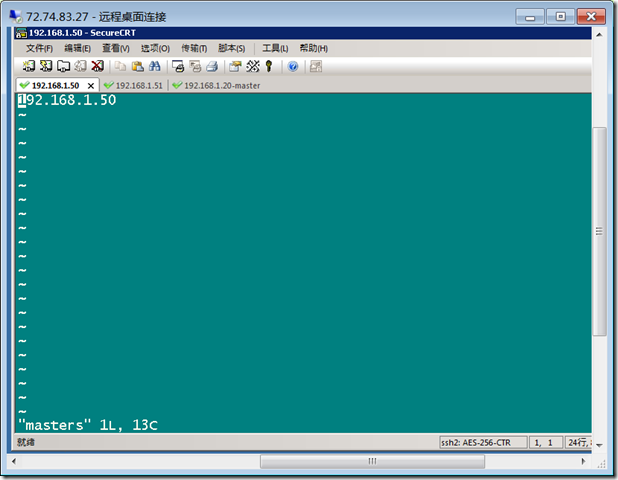

配置masters文件,将localhost 改为 Master的ip地址: 192.168.1.50

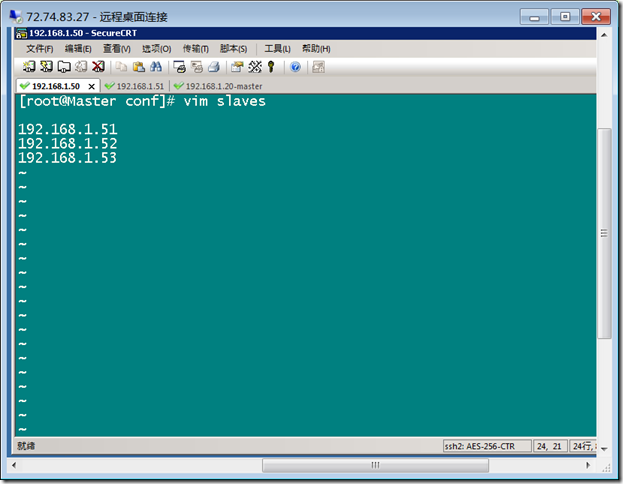

修改 slaves 文件: vim slaves

localhost 改为:

192.168.1.51

192.168.1.52

192.168.1.53

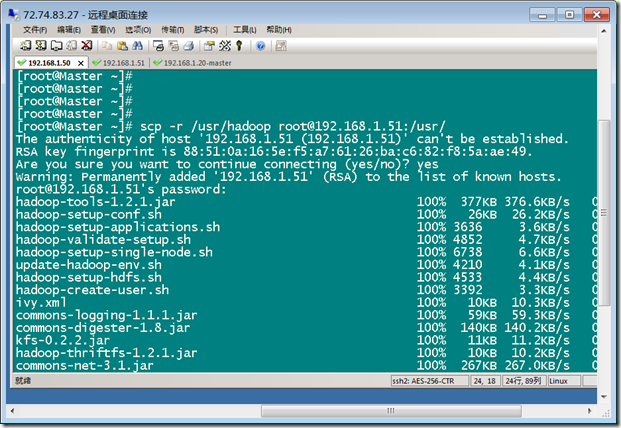

作为对于slave节点的安装,把master的hadoop文件夹复制到slave的/usr 文件夹下即可。

Master root复制hadoop 到 slave1:scp -r /usr/hadoop root@192.168.1.21:/usr/

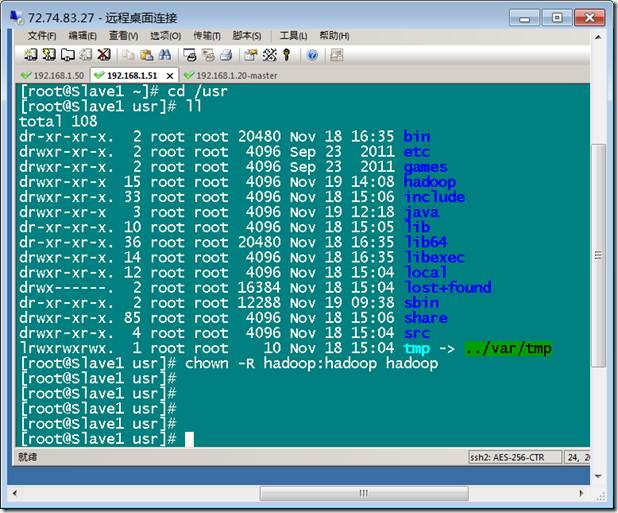

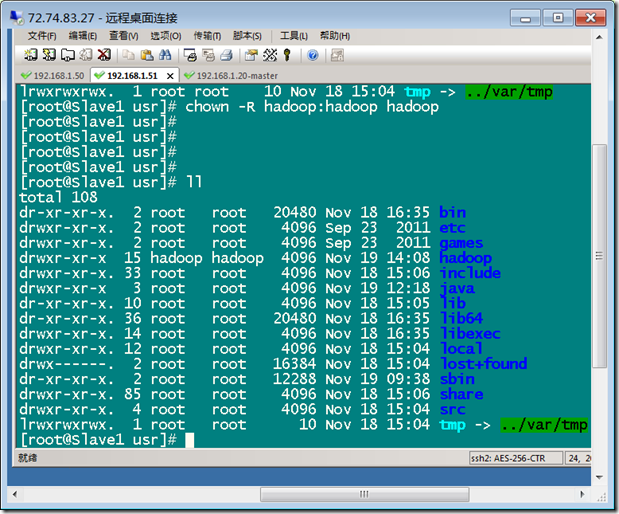

slave 节点,进入/usr文件夹,发现已经复制过来的hadoop文件夹,进而修改其访问权限。

chown -R hadoop:hadoop hadoop 使之可以被hadoop用户访问。

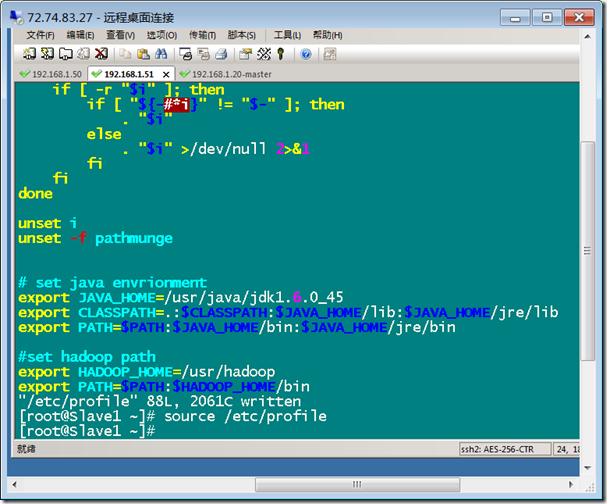

配置 slave的环境变量:

vim /etc/profile, 在最后添加

#set hadoop path

export HADOOP_HOME=/usr/hadoop

export PATH=$PATH:$HADOOP_HOME/bin

最后 source /etc/profile ,使之生效。

浙公网安备 33010602011771号

浙公网安备 33010602011771号