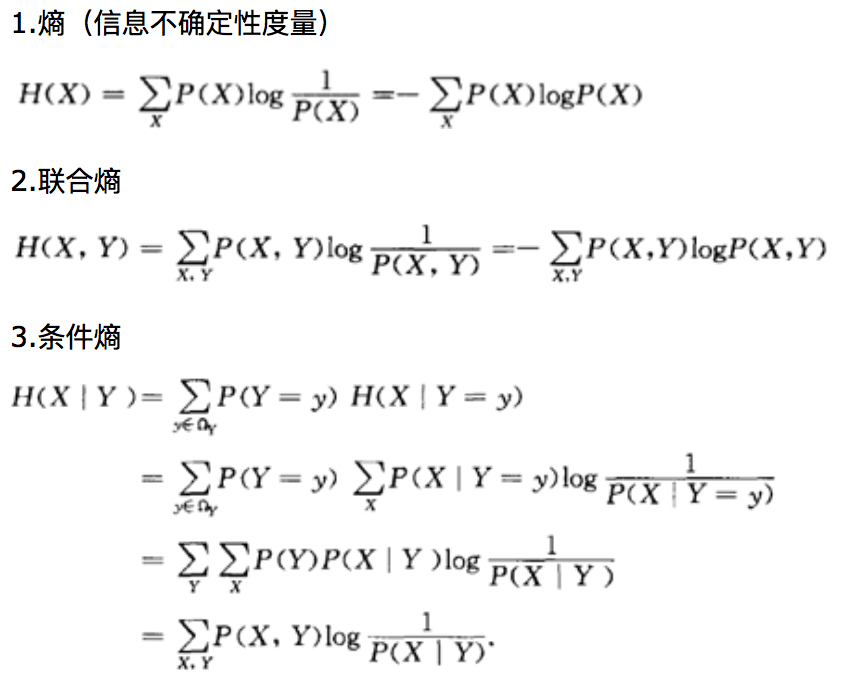

熵、联合熵、条件熵、相对熵(即KL散度)、交叉熵和互信息

条件熵 H(X|Y)表示在已知随机变量 Y 的条件下随机变量 X 的不确定性

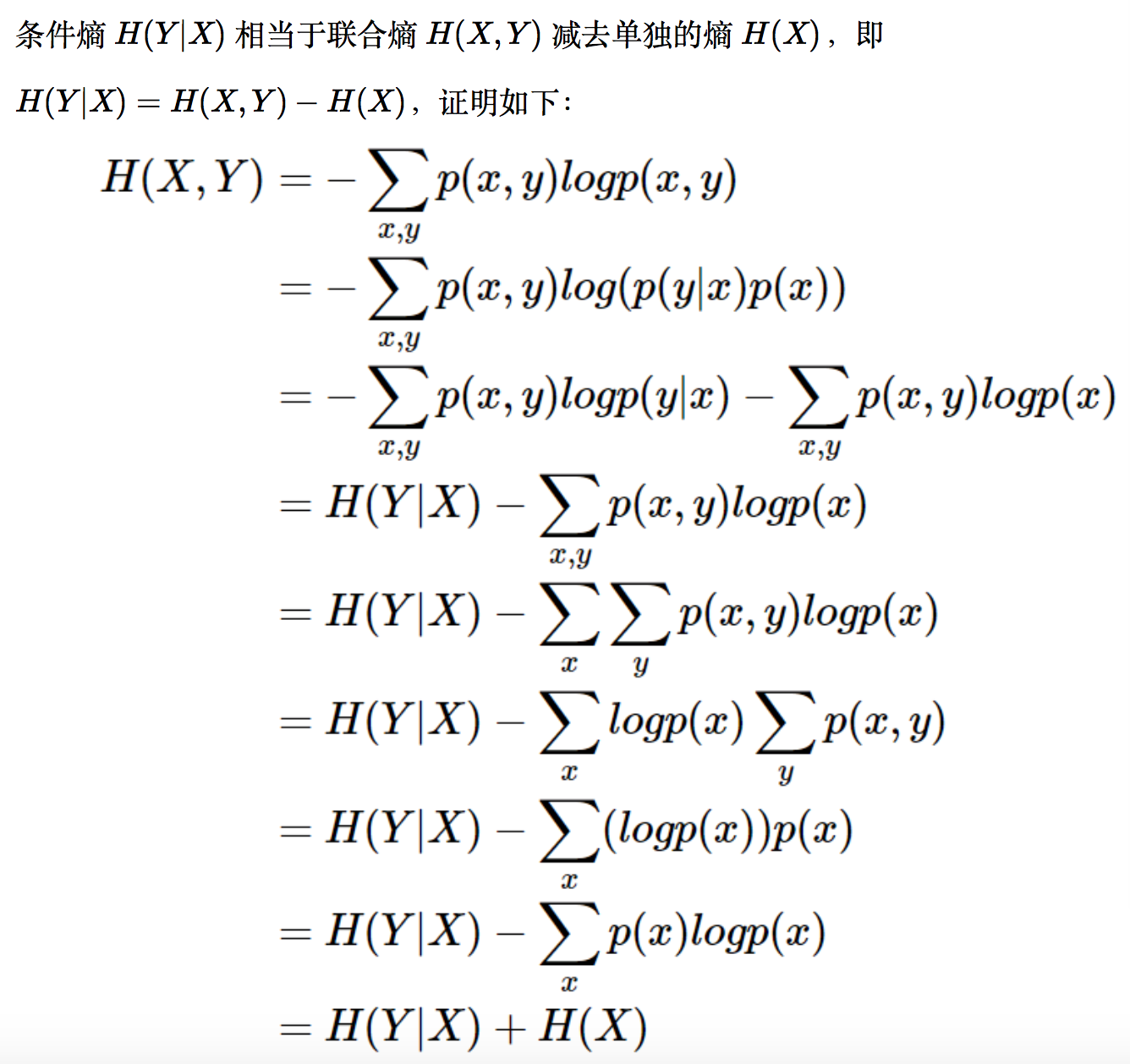

条件熵,联合熵和熵之间的关系如下:

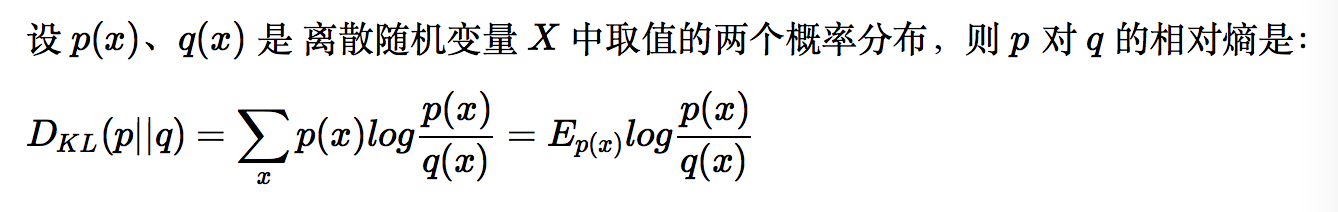

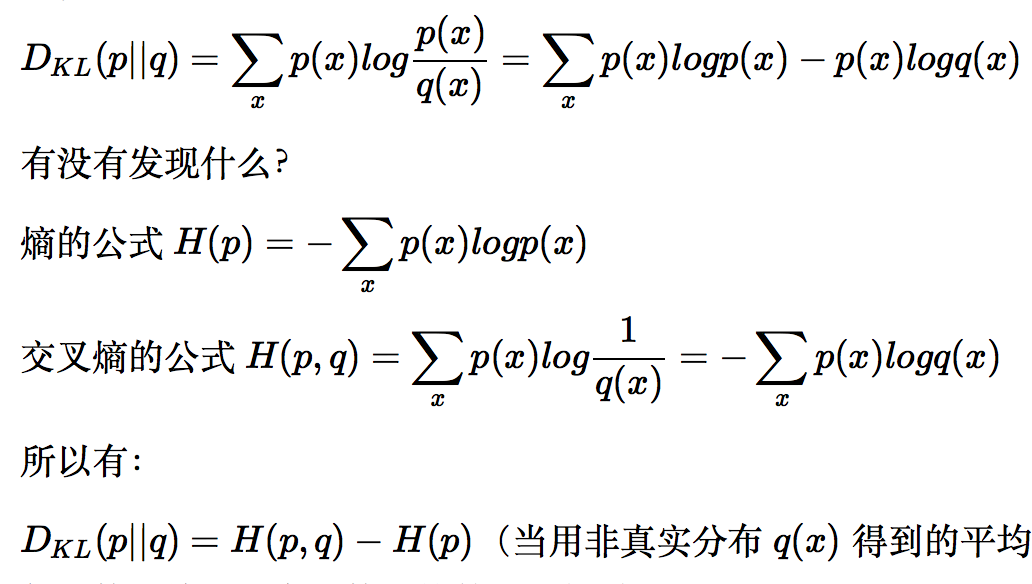

相对熵:用来衡量两个概率分布之间的差异,也叫KL散度

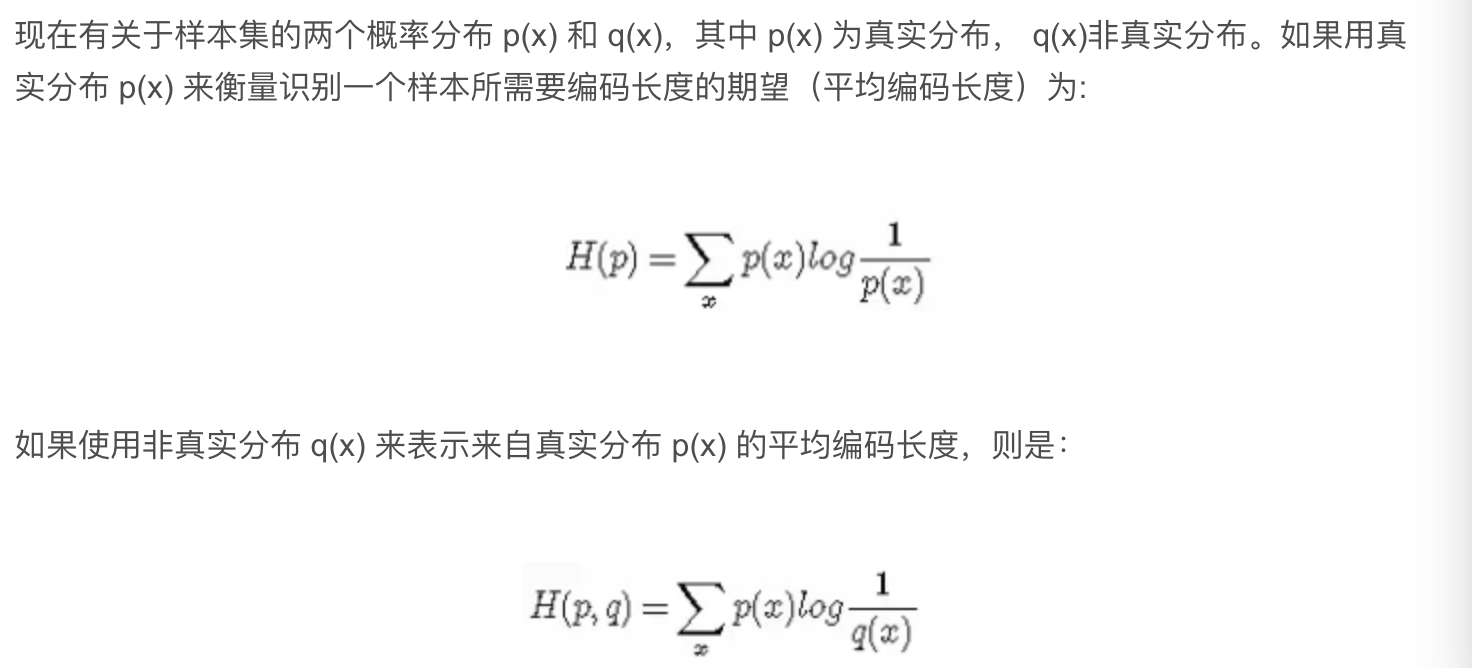

交叉熵:

相对熵,熵和交叉熵的关系如下:

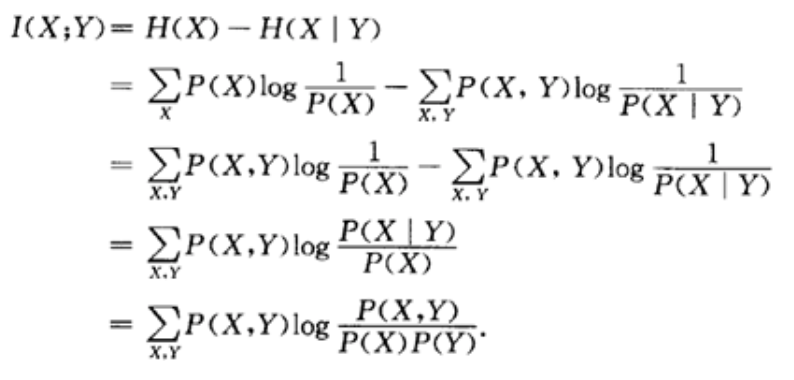

互信息:

互信息意义是:由于知道 y 值而造成的 x 的不确定性的减小(即Y的值透露了多少关于X 的信息量)

ps:以上内容来自

https://www.cnblogs.com/kyrieng/p/8694705.html

https://blog.csdn.net/fendouaini/article/details/79841779

https://www.cnblogs.com/jizhiyuan/p/3423821.html

浙公网安备 33010602011771号

浙公网安备 33010602011771号