你可能把A/B测试做错了

大卫奥格威说过,“永远不要停止试验,你的广告也就永远不会停止改进”。

在当今的网络世界中,类似于吆喝科技 AppAdhoc A/B Testing 这样的工具越来越多,AB测试和转化优化越来越习以为常。

尽管A/B测试的工具简单到让你奶奶都可以轻易创建并发布一个试验,UserTesting.com 发现90%的内部A/B测试都失败了。某A/B测试供应商发现在其平台上运行的每7个试验中只有1个得出统计显著的结果。这意味这只有约十分之一的试验会显著影响转化率,甚至大多数的情况下,对于重要指标的改进来说,A/B测试能带来的影响是很低的。

A/B测试只是一种没有实质性推动的噱头么?我觉得可能不是,也许只是你做错了的结果。以下是我们对于过去5年来很多公司(包括大企业和小公司)所进行的A/B测试调研后所发现的普遍纯在的问题。

生搬硬套的试验

当你还是个学生的时候,生搬硬套的学习往往是在容易简单记住并通过测验时所采用的。

但A/B测试和你之前的测验不一样,它所测试的是你网站上的独立的流量或访客。这些试验通常都是在这些流量及访客没有意识到的情况下进行的。

如果你大致研究过关于A/B测试的案例和博客,你就会发现以下这些过于简单的问题:

行动召唤CTA必须在最醒目的地方

视频能够帮助更好的转化

长文比短文好

短文比长文好

单页付款比多步骤付款好

多步骤付款比单页付款转化高

更少填写的表单比多要的好

……

针对以上的每一点结论,我发现优胜结果在各种的市场以及受众中都最终进行验证。

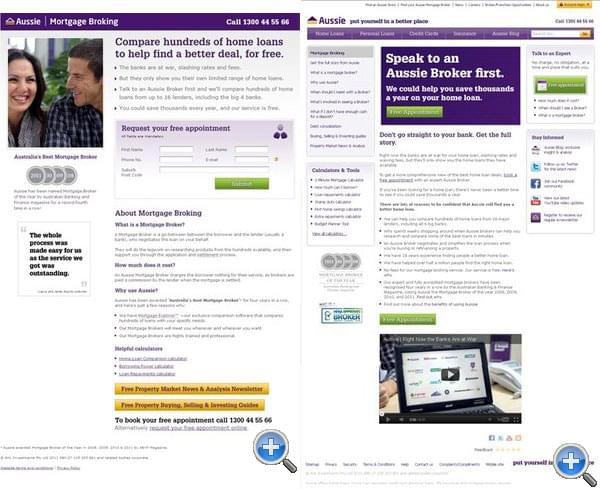

下图是一个例子,Aussie 澳大利亚领先的房屋租赁和贷款中介公司,针对其首页所做的关于视频的AB测试。

我经常听到人们说,网页上的视频内容一定能够提高你的网页转化率。事实正好相反,上图中没有视频的版本实际上多产生64%的贷款申请线索。

如果你是以一种简单的生搬硬套的方式来考虑A/B测试,那么很难能产生100%或更大转化率改善或者能够具有大于平均百分比的优胜试验。

你照搬这些教条式的想法来做A/B测试很可能无法得到最优的试验结果。

人类采取合理的样本规模更加复杂,而不是简单被这样的显著变化所说服。(毕竟这是我们尝试去影响的实验)。我们自身也有很大的不同,比如独特的梦想、希望、目标、需求、要求、个性等等。

“散弹枪”式试验

回顾那些在A/B测试上重点投入人力物力的公司的结果,你经常可以发现一种我所谓的“散弹枪式试验”。

结果=速度×平均影响×优胜率

想要最大化你的A/B测试结果,你应该同时努力提高试验的速度、每次试验的平均影响和试验的优胜率。

“散弹枪”式的试验指的是仅仅关注速度却忽视平均影响或优胜率的试验方式。优化团队在整个A/B测试中不能只关注试验的速度,没有优胜率和平均影响差的试验堆积是非常可怕的。他们测试能测试的一切,但当你检查每个结果的时候会注意到,那只是乱枪打鸟罢了。

偶尔你会听到,“好吧,至少我们学到一些东西”(这也许是真的)。但是学习又不影响业务的关键指标并且很难量化。

在“散弹枪”式试验遍布的组织中,没有什么想法试图确定哪些试验可能带来高或低的影响。唯一能确定的就是测试构思没有任何可遵循的具体办法。

恐惧的按钮颜色试验

提出试验的想法不难,为试验的目标受众提供具有高度潜在影响的对照试验想法是巨大的挑战。

当你读到类似于修改按钮的用词就提升77%的点击率或者谷歌测试41种灰度按钮来测试最佳方案的时候,你也许会认为这些类型的测试简单易行又常常能带来巨大的成效。

但没什么可以从真心更进一步

为了能找到更大的胜者测试,它有助于更大更深的思考。你不应该只关注于解决简单的变化。如果你的A/B测试可以在几行 jQuery 中实现的话,那么它可能太小了。

想想你的客户,他们在这个市场追寻什么?你知道他们在追寻什么?或者他们知道这些事实么?如果你不确定的话,请在感谢页面上通过调查问卷来了解下他们为什么今天没有购买或注册。

你的价值定位是什么?有没有清晰的在网站中体现?理想的市场价值主张是什么?

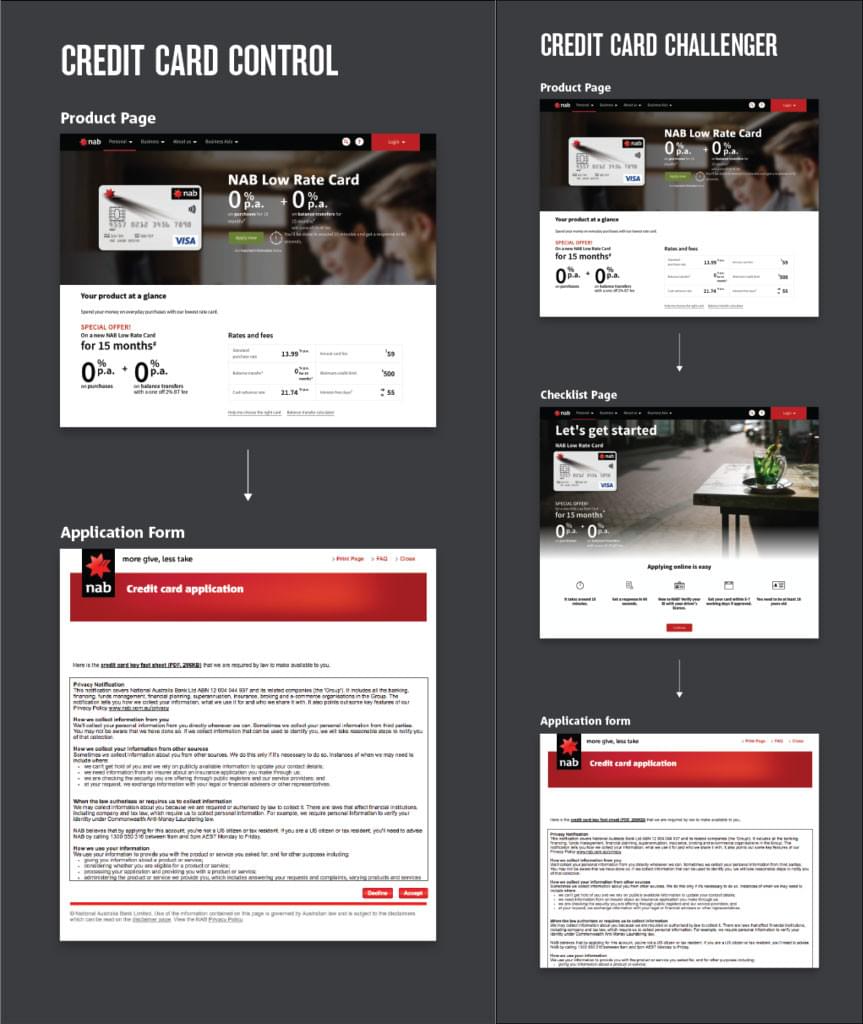

让我们看看下面这个案例,国有澳大利亚银行(NAB)的两步注册。

哪个版本更好?第二个。将近40%的被访人员错误的理解“Credit Card Control”版本A。结果是,在99%的置信区间下,表格的转化率增加23.6%,每次访问应用次数增加9.5%。这是个不错的例子,预测用户的行为往往都不靠谱。

突破围栏限制

真正有用的是寻找“最好的分离试验”来了解哪些改变对其他人有效。当然这也是让人头疼的地方。

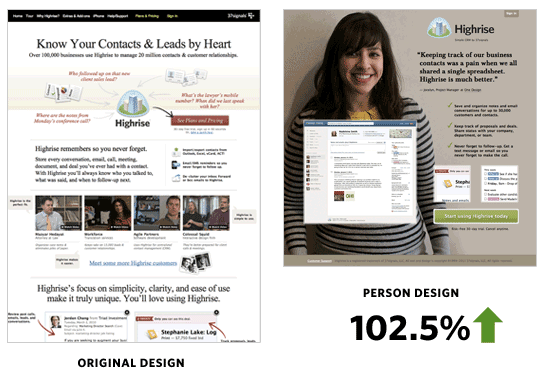

37signals 尝试提升转化率,他们全新设计了主页,如下所示:

新版本的转换率提升102.5%。他们不只是改变一个行动召唤或者标题,二是彻底重新设计了主页(基于专家所认为的可能奏效的部分)并修改:

标题

文案

背景图

整体视觉设计

行动召唤文案

行动召唤颜色

价值主张的传达方式

这次改版的 ROI 不错,在流量相同的情况下注册翻番。当然也可以小修小补,但如果你不突破的话,几乎可以肯定的是你永远也不会实现大胜利。此外,另一个优点是,你得到统计显著将会更快一些。

统计环节的失败

到目前为止,我们主要处理分离试验的想法是,如何确保能够喜迎合适的受众,让你提供的产品和服务令人信服。可试验本身呢?也许你最大的失误在于:

过早下结论 和/或 没有足够大的样本

如果你做了大量的试验,你也许会遇到的一个情况是,当你开始一个新的A/B测试的时候,通常前几天的结果是很可怕的,试验有可能有些问题,如下所示:

在上图所示的A/B测试结果中,我们看到测试版本的数据跳水了90%。新接触A/B测试的人认为这也许是尝试,仅仅为了消除变化而已。

A/B测试(和统计分析)的终极规则是不要过早就下结论。上文提到的试验运行了一个星期之后(这需要勇气和所采集数据的准确性来保持试验的正常运行),结果显示如下:

仅仅在十天后,先前数据表现糟糕的测试版本完成大逆转,最终有95%的可能性优于原始版本。如果你过早下结论的话,你绝对就不知道这些了。

在此我建议你先设置最低的试验时间(需要跟进流量来估算),将其锁定后后开始试验。

如果有疑问的话(或者结果太好无法确信),可以在新的A/B测试中重新进行完全相同的试验。

做正确的A/B测试

当你开始进行A/B测试的时候,小的增量变化和修改是很好的,但真正的A/B测试结果的关键是大测试、常测试、正确的想法、足够大的样本以及避免过早下结论。

如果结果看上去不错像是真的,不要害怕测试和重新测试。A/A测试是你的好朋友。

花时间更好的了解你的目标受众,他们如何与你希望的行动保持一致,以及在这写潜在客户采取行动后会发生什么。搞定这些,你就会把你的竞争对手甩得远远的。

本文由 mili @ 吆喝科技 编译自:https://www.sitepoint.com/ab-testing-youre-doing-it-wrong/