LVS-DR群集+DR实验部署

一、DR模式数据包流向分析

(1)客户端发送请求到Director Server(负载均衡器),请求的数据报文(源IP是CIP(客户端IP),目标IP是VIP(集群虚拟IP))到达内核空间。

(2)Director Server和Real Sexver(节点服务器)在同一个网络中,数据通过二层数据链路层来传输。

(3)内核空间判断数据包的目标IP是否为本机VIP,此时IPVS(IP虚拟服务器)比对数据包请求的服务是否是集群服务,是集群服务就重新封装数据包。修改源MAC地址为Director Server的MAC地址上,修改目标MAC地址为Real Server的MAC地址,源IP地址与目标IP地址没有改变,然后将数据包发送给Real Server。

(4)到达Real Server的请求报文的MAC地址是自身的MAC地址,就接收此报文。数据包重新封装报文(源IP地址为VIP,目标IP为CIP),将响应报文通过lo接口传送给物理网卡然后向外发出。

(5)Real Server直接将响应报文传送到客户端。

注:若跨网段,则报文通过路由器经由Internet返回给用户

二、DR模式的特点

(1)Director Server和Real Server必须在同一个物理网络中。

(2)Real Server 可以使用私有地址,也可以使用公网地址。如果使用公网地址, 客户端可以通过互联网对RIP(节点服务器)进行直接访问,相当于IP隧道模式。

(3)Director Server作为群集的访问入口,但不作为网关使用。

(4)所有的请求报文经由Director Server,但回复响应报文不能经过Director Server。

(5)Real Server的网关不允许指向Director Server IP,即Real Server发送的数据包不允许经过Director Server。

(6)Real Server上的lo接口配置集群的VIP地址。

三、LVS-DR 中的 ARP 问题

1、在局域网中具有相同的IP地址,势必会造成各服务器ARP通信的紊乱

- 当客户端根据VIP发起请求,路由器进行ARP广播发送到LVS-DR集群时,因为负载均衡器和节点服务器都配置VIP并且都连接在相同的网络中,它们都会接收到ARP广播,如果都做出响应将做成路由器ARP缓存表紊乱

解决方法:

- 使用虚接口 lo:0 承载VIP地址

- 设置内核参数 arp_ignore=1

#节点服务器系统只响应目的IP为本地物理网卡IP的ARP请求,而不对目的IP为虚拟网卡的VIP的ARP请求做出响应

2、节点服务器进行数据转发若以VIP将再次造成路由器ARP表紊乱

- RealServer返回报文(源IP是VIP,目标IP为客户端IP)经路由器转发,重新封装报文时,需要先获取路由器的MAC地址发送ARP请求时,Linux默认使用IP包的源IP地址(即VIP)作为ARP请求包中的源IP地址,而不使用发送接口的IP地址,如ens33接口,路由器收到请求后在寻址的同时也将更新ARP缓存表,

- 原有的VIP对应调度器的MAC地址将更新为VIP对应节点服务器地址,之后客户端请求将不在通过调度服务器

解决方法:

- 对节点服务器进行处理,设置内核参数 arp_announce = 2

#节点服务器系统不使用响应数据包的源IP地址也就是VIP地址作为转发ARP请求的源地址,使用发送报文的物理网卡的IP地址作为ARP请求的源IP地址,防止对路由器VIP与MAC的对照关系进行更改以致于之后的数据包不再到达调度器

实验部分:DR模式 LVS负载均衡群集部署

1、实验部署:

- DR负载调度器:20.0.0.6

- VIP:20.0.0.100

- Web节点服务器1∶20.0.0.7

- Web节点服务器2∶20.0.0.8

- NFS服务器∶ 20.0.0.9

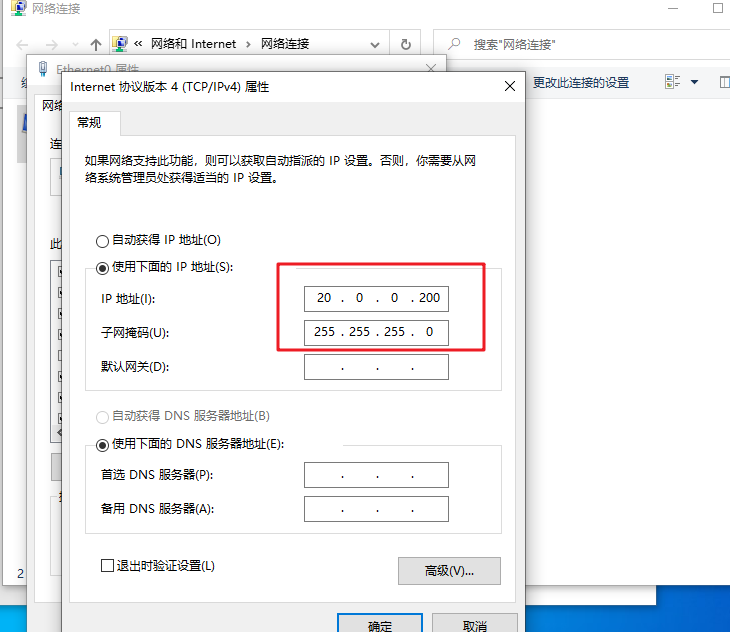

- 客户端∶ 20.0.0.200

实验详细步骤:

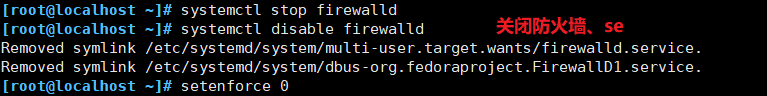

准备实验环境,关闭防火墙,se安全(所有主机)

[root@localhost ~]# systemctl stop firewalld

[root@localhost ~]# systemctl disable firewalld

Removed symlink /etc/systemd/system/multi-user.target.wants/firewalld.service.

Removed symlink /etc/systemd/system/dbus-org.fedoraproject.FirewallD1.service.

[root@localhost ~]# setenforce 0

一、配置负载调度器(20.0.0.6)

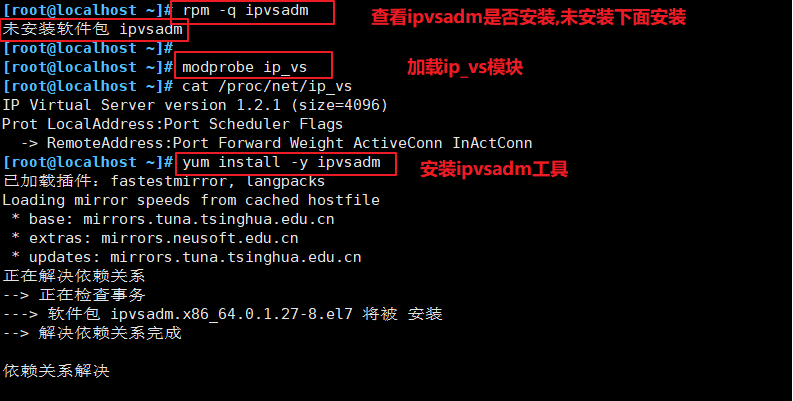

1、加载ip_vs模块,安装ipvsadm工具

[root@localhost ~]# rpm -q ipvsadm

未安装软件包 ipvsadm

[root@localhost ~]#

[root@localhost ~]# modprobe ip_vs #加载ip_vs模块

[root@localhost ~]# cat /proc/net/ip_vs #查看是否加载

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

[root@localhost ~]# yum install -y ipvsadm #安装 ipvsadm 工具

已加载插件:fastestmirror, langpacks

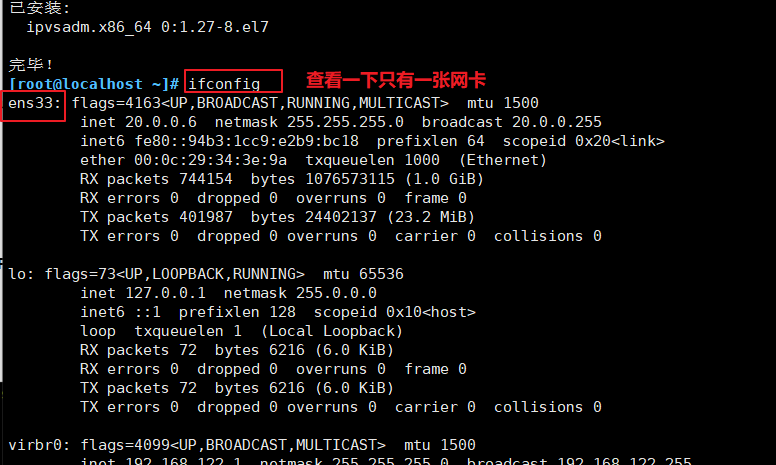

2、配置虚拟 IP 地址(20.0.0.100)

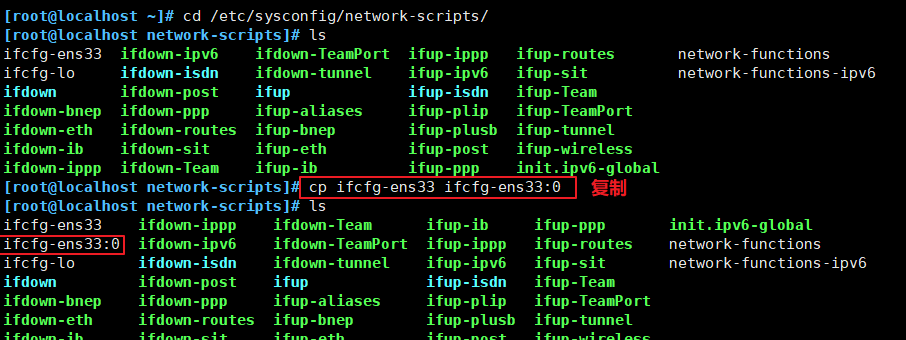

[root@localhost ~]# cd /etc/sysconfig/network-scripts/ #永久配置虚拟网卡ens33:1

[root@localhost network-scripts]# ls

ifcfg-ens33 ifdown-ipv6 ifdown-TeamPort ifup-ippp ifup-routes network-functions

ifcfg-lo ifdown-isdn ifdown-tunnel ifup-ipv6 ifup-sit network-functions-ipv6

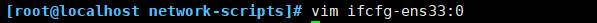

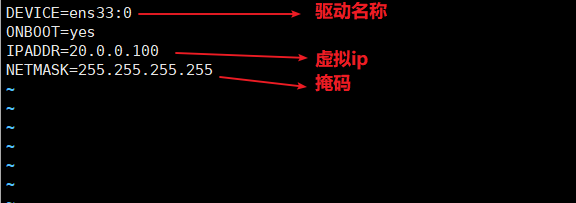

[root@localhost network-scripts]# vim ifcfg-ens33:0

#只保留以下这几项即可

DEVICE=ens33:0

ONBOOT=yes

IPADDR=20.0.0.100 #设置VIP

NETMASK=255.255.255.255 #将子网掩码设为1表示唯一IP

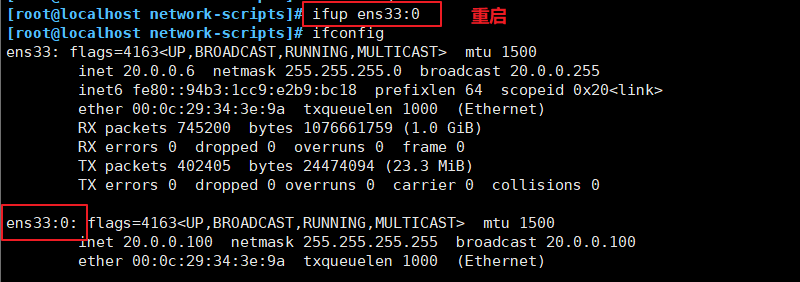

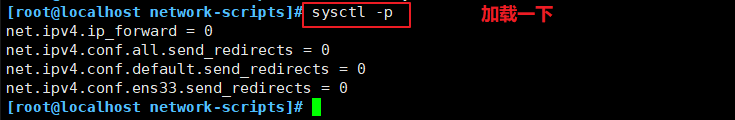

3、调整proc响应参数

#由于LVS负载调度器和各节点需要共用VIP地址,需要关闭icmp的重定向,不充当路由器。

vim /etc/sysctl.conf

net.ipv4.ip_forward = 0

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0

sysctl -p #重载一下配置

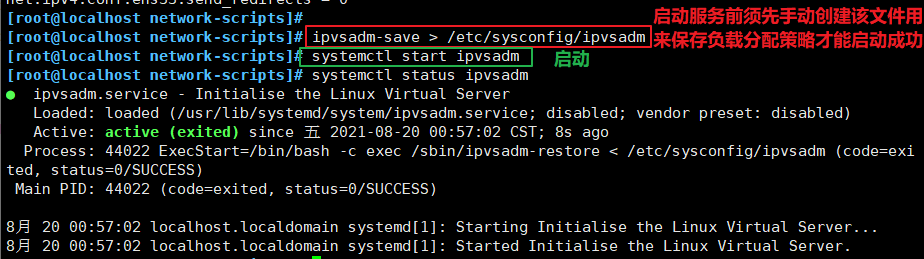

4、配置负载分配(调度)策略

ipvsadm-save > /etc/sysconfig/ipvsadm #启动服务前须先手动创建该文件用来保存负载分配策略才能启动成功

systemctl start ipvsadm #启动

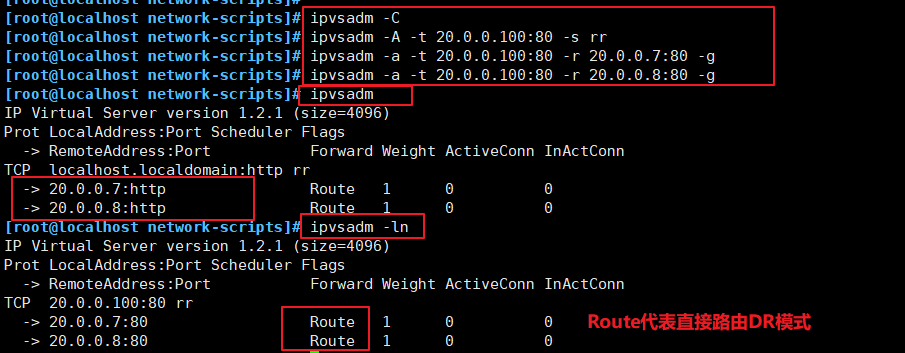

ipvsadm -C #清空规则

ipvsadm -A -t 20.0.0.100:80 -s rr #添加LVM群集,指定为轮询算法;-t:指定VIP地址及TCP端口

ipvsadm -a -t 20.0.0.100:80 -r 20.0.0.7:80 -g #添加节点服务器;-a:表示添加真实服务器(节点服务器);-r:指定RIP地址及TCP端口

ipvsadm -a -t 20.0.0.100:80 -r 20.0.0.8:80 -g #若隧道模式,-g替换为-i;-g:表示使用DR模式

ipvsadm # 激活

#查看节点状态, Route代表DR模式

ipvsadm -ln

ipvsadm-save > /etc/sysconfig/ipvsadm #保存配置策略

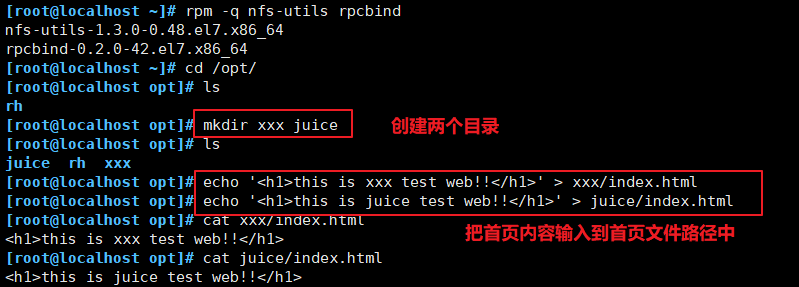

二、部署 NFS 共享存储

[root@localhost ~]# rpm -q nfs-utils rpcbind #查看是否安装nfs服务

nfs-utils-1.3.0-0.48.el7.x86_64

rpcbind-0.2.0-42.el7.x86_64

[root@localhost ~]# cd /opt/

[root@localhost opt]# ls

rh

[root@localhost opt]# mkdir xxx juice # 创建xxx、juice 两个目录

[root@localhost opt]# ls

juice rh xxx

[root@localhost opt]# echo '<h1>this is xxx test web!!</h1>' > xxx/index.html

[root@localhost opt]# echo '<h1>this is juice test web!!</h1>' > juice/index.html

[root@localhost opt]# chmod 777 xxx/ juice/ #给上权限

[root@localhost opt]# ls

juice rh xxx

[root@localhost opt]# cat xxx/index.html

<h1>this is xxx test web!!</h1>

[root@localhost opt]# cat juice/index.html

<h1>this is juice test web!!</h1>

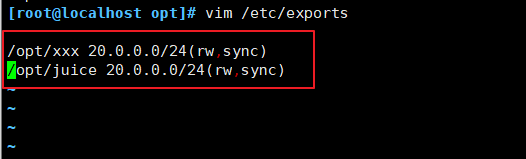

[root@localhost opt]# vim /etc/exports

/opt/xxx 20.0.0.0/24(rw,sync) #添加共享目录的路径、网段、权限 ;同步

/opt/juice 20.0.0.0/24(rw,sync)

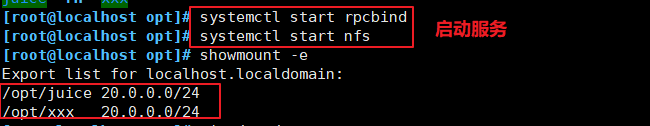

[root@localhost opt]# systemctl start rpcbind #启动 bind 服务

[root@localhost opt]# systemctl start nfs #启动 nfs 服务

三、配置节点服务器 (20.0.0.7和20.0.0.8)

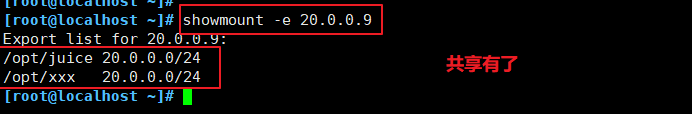

(1)先去节点服务器1 查看一下共享目录列表有没有(20.0.0.7)

(2)节点服务器2 查看一下共享目录列表(20.0.0.8)

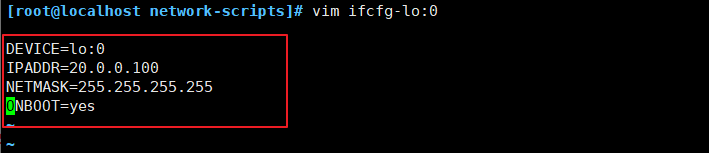

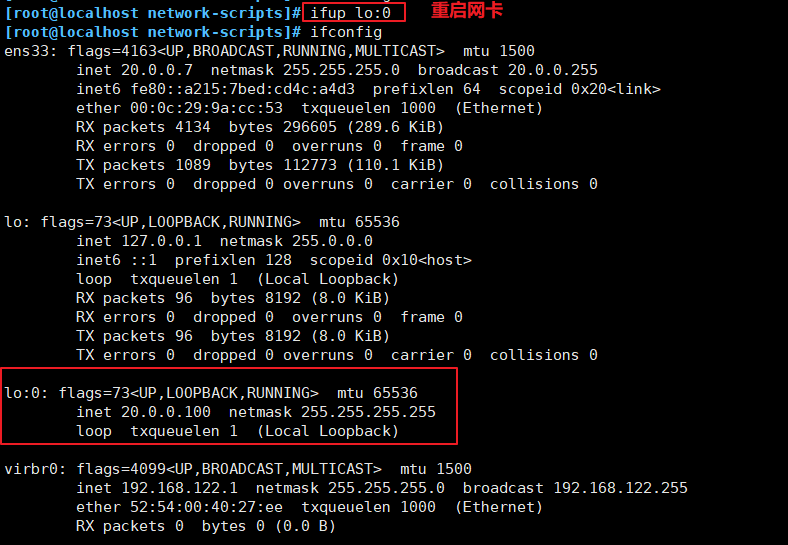

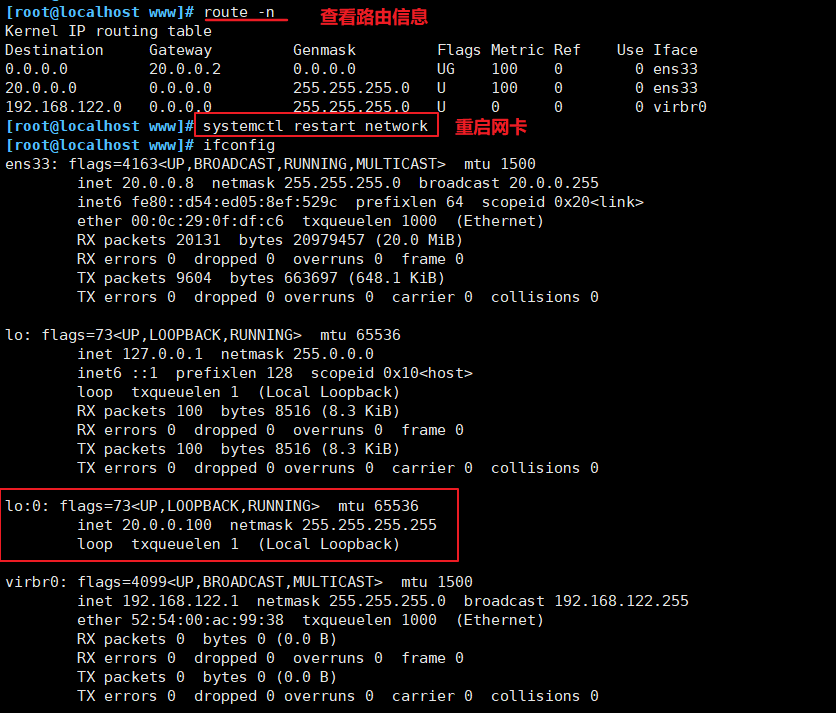

1、配置虚拟 IP 地址

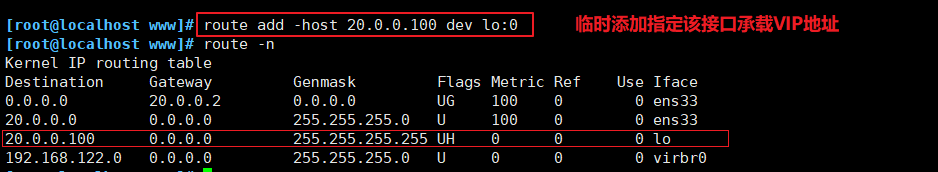

#此地址仅用作发送 Web响应数据包的源地址,并不需要监听客户机的访问请求 (改由调度器监听并分发)。因此使用虚接口lo∶0来承载VIP地址,并为本机添加一条路由记录,将访问VIP的数据限制在本地,以避免通信紊乱。

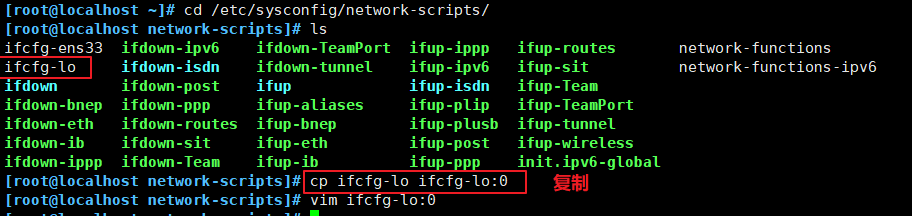

cd /etc/sysconfig/network-scripts/

cp ifcfg-lo ifcfg-lo:0 #复制网卡

vim ifcfg-lo:0 #修改配置

DEVICE=lo:0

ONBO0T=yes

IPADDR=192.168.150.200

NETMASK=255.255.255.255 #与之前DR服务器相同,设置相同VIP

ifup lo:0

或 systemctl restart network (自己实验环境可以这样重启) #重启网卡

ifconfig

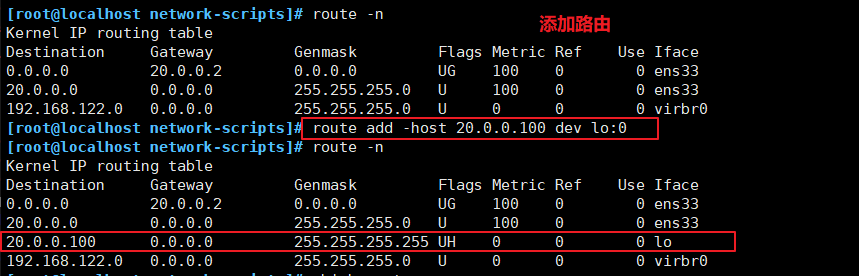

route add -host 192.168.150.200 dev lo:0 #临时添加指定该接口承载VIP地址

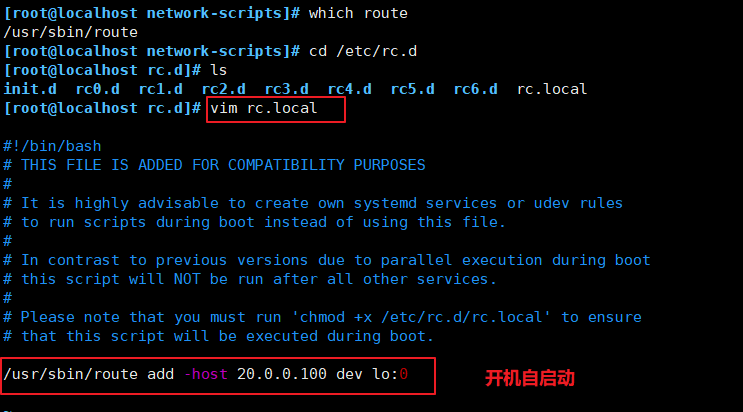

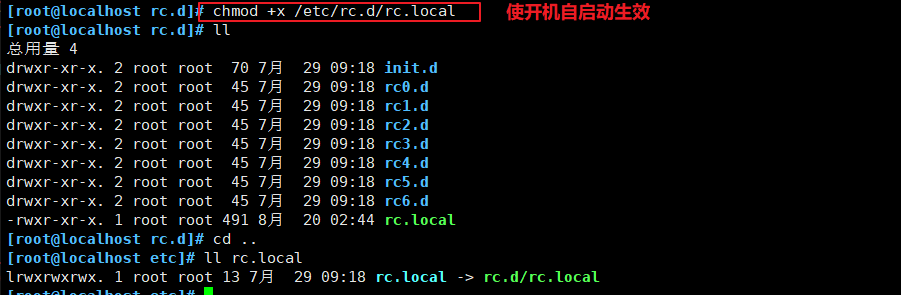

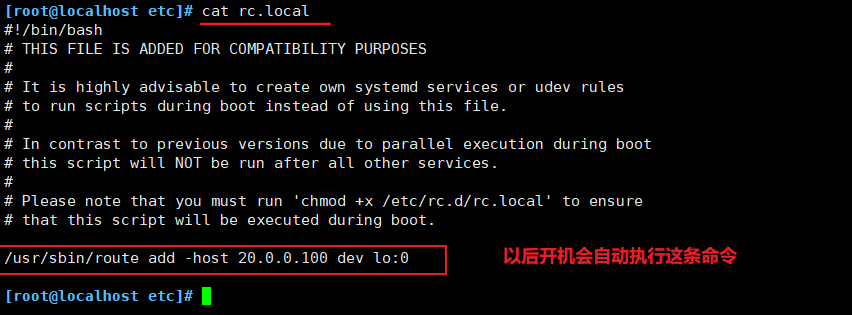

vim /etc/rc.d/rc.local #添加到该文件开机自动执行该命令

/usr/sbin/route add -host 192.168.150.200 dev lo:0

chmod +x /etc/rc.d/rc.local

2、调整内核的 ARP 的响应参数以阻止更新VIP的MAC地址,避免发生冲突

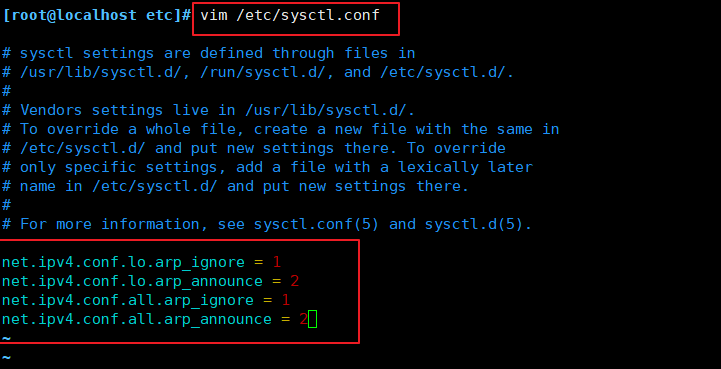

vim /etc/sysctl.conf

.......

net.ipv4.conf.lo.arp_ignore = 1 #系统只响应目的IP为本地IP的ARP请求

net.ipv4.conf.lo.arp_announce = 2 #系统不使用IP包的源地址来设置ARP请求的源地址,而选择发送接口的IP地址

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

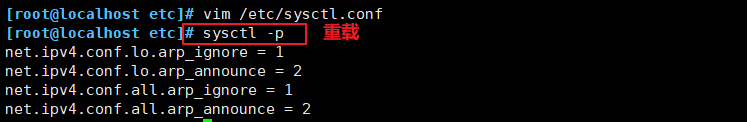

sysctl -p

或者

临时添加:

echo "1" >/proc/sys/net/ipv4/conf/lo/arp ignore

echo "2" >/proc/sys/net/ipv4/conf/lo/arp announce

echo "1" >/proc/sys/net/ipv4/conf/all/arp ignore

echo "2" >/proc/sys/net/ipv4/conf/all/arp announce

sysctl -p

附:

arp_announce : INTEGER

0:允许使用任意网卡上的IP地址作为arp请求的源IP,通常就是使用数据包a的源IP。

1:尽量避免使用不属于该发送网卡子网的本地地址作为发送arp请求的源IP地址。

2:忽略IP数据包的源IP地址,选择该发送网卡上最合适的本地地址作为arp请求的源IP地址。(一般DR模式设为2)

arp_ignore : INTEGER

定义对目标地址为本地IP的ARP询问不同的应答模式。

0:响应任意网卡上接收到的对本机IP地址的arp请求(包括环回网卡上的地址),而不管该目的IP是否在接收网卡上。

1:只响应目的IP地址为接收网卡上的本地地址的arp请求。(一般DR模式设为1)

2:只响应目的IP地址为接收网卡上的本地地址的arp请求,并且arp请求的源IP必须和接收网卡同网段。

3:如果ARP请求数据包所请求的IP地址对应的本地地址其作用域(scope)为主机(host),则不回应ARP响应数据包,如果作用域为全局(global)或链路(link),则回应ARP响应数据包。

4~7:预留。

8:不回应所有的arp请求。

sysctl.conf中包含all(全局)和eth/lo(具体网卡)的arp_ignore参数,取其中较大的值生效

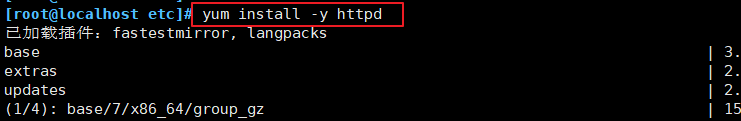

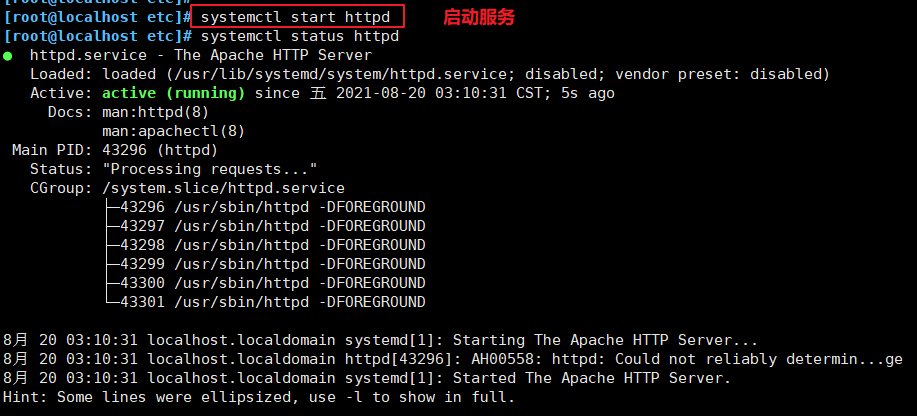

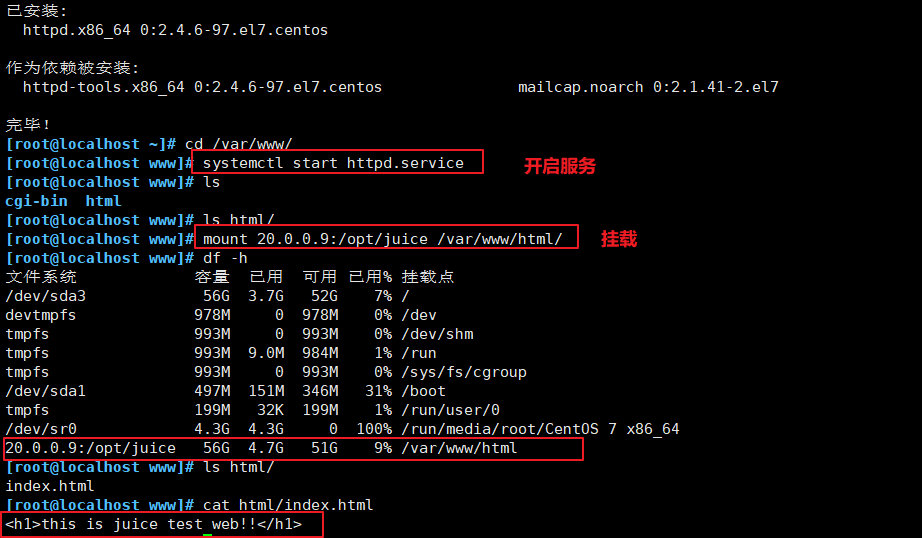

3、启动http服务挂载共享的首页文件(安装 apache 或 nginx 服务,两者都可以,有Web服务才可以承载)

yum -y install nfs-utils rpcbind httpd

systemctl start rpcbind

systemctl start nfs

systemctl start httpd

mount 20.0.0.9:/opt/xxx /var/www/html/

节点服务器1(20.0.0.7)

mount 20.0.0.9:/opt/xxx /var/www/html/

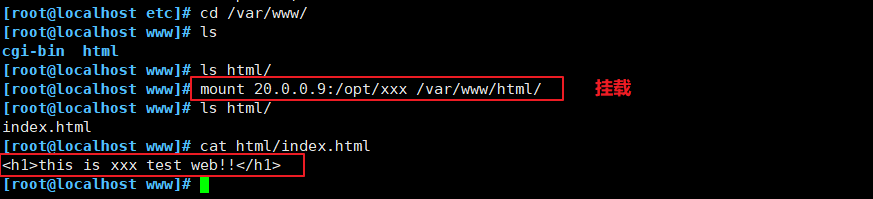

同样的,节点服务器2(20.0.0.8) 也按相同方法修改配置(嫌麻烦可以把节点服务器1的配置复制过来即可)

这里在节点服务器1(20.0.0.7)上操作:

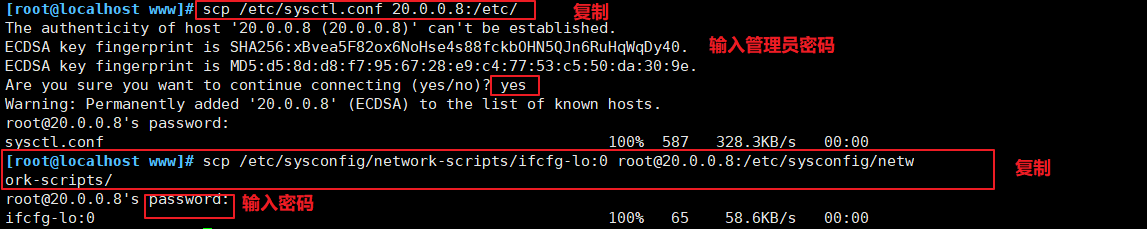

(1)在节点服务器2 上安装 httpd 服务,开启服务并挂载

mount 20.0.0.9:/opt/juice/var/www/html/

(2)添加路由

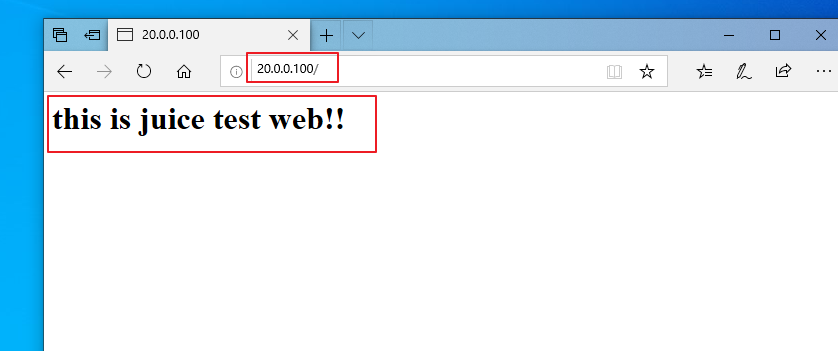

四、测试 LVS 群集

在客户端使用浏览器访问http://20.0.0.100/

感谢您的阅读,如果您觉得阅读本文对您有帮助,请点一下“推荐”按钮。本文欢迎各位转载,但是转载文章之后必须在文章页面中给出作者和原文连接。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· AI与.NET技术实操系列:基于图像分类模型对图像进行分类

· go语言实现终端里的倒计时

· 如何编写易于单元测试的代码

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 分享一个免费、快速、无限量使用的满血 DeepSeek R1 模型,支持深度思考和联网搜索!

· 25岁的心里话

· 基于 Docker 搭建 FRP 内网穿透开源项目(很简单哒)

· ollama系列01:轻松3步本地部署deepseek,普通电脑可用

· 按钮权限的设计及实现