(原)softmax loss特征为何径向放射状分布(直观理解,非公式推导。。。)

转载请注明出处:

https://www.cnblogs.com/darkknightzh/p/12592291.html

本文仅为本人的一点理解,如有不正确的地方,或者读者已经懂了,则不用浪费时间看本文了O(∩_∩)O

softmax loss定义如下:

其中为分类层的权重,为分类层的输入特征,为分类层的偏置。

上式为softmax,即当前样本分为第i类的概率。

论文中当分类层为2个类别时,可视化后的特征(即上面公式中的)如下,均为径向放射状分布(图片来自center loss的论文)。

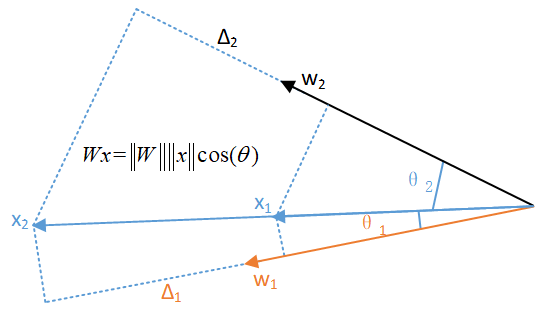

特征径向放射状分布,原因如下图所示。假设和为分类层两个类别的权重向量。为某个特征(图中对应和,指代优化前后的特征),且假定该特征对应类别为。由softmax loss的公式可见,若使得loss更小,需要当前样本正确分类的概率更大,进一步需要更大(或者说增长的比增长的更大)。

在忽略偏置的情况下,由于,即模长和模长和及的夹角的乘积。若假定不变,则有两种方式:

① 增大,导致特征模长越来越大。

② 增大,即降低及的夹角,因而导致在方向上径向分布。

综合起来,特征便呈现径向放射状分布。

下面举一个简单的例子。假设在和上投影是0.4,0.3,投影是0.8,0.6,由于cos作为权重,导致最终在上增加的幅度大于在上增加的幅度,样本被分为第一类的概率增大(loss减小),因而下一时刻(即)会越来越呈现放射状(离原点越来越远,对应分类概率越来越大);另一方面,还需要分类正确,即到的夹角小于到的夹角,因而最终特征会沿着对应的方向径向分布;综合起来,特征会呈现径向放射状分布。

posted on 2020-03-29 14:50 darkknightzh 阅读(799) 评论(0) 编辑 收藏 举报

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 地球OL攻略 —— 某应届生求职总结

· 提示词工程——AI应用必不可少的技术

· Open-Sora 2.0 重磅开源!

· 周边上新:园子的第一款马克杯温暖上架