【22】python之pandas库

一、pandas概述

pandas :pannel data analysis(面板数据分析)。pandas是基于numpy构建的,为时间序列分析提供了很好的支持。pandas中有两个主要的数据结构,一个是Series,另一个是DataFrame。

二、数据结构

1.Series

Series 类似于一维数组与字典(map)数据结构的结合。它由一组数据和一组与数据相对应的数据标签(索引index)组成。这组数据和索引标签的基础都是一个一维ndarray数组。可将index索引理解为行索引。 Series的表现形式为:索引在左,数据在右。

定义:s = pd.Series(data, index=index)

• 获取数据和索引:ser_obj.index, ser_obj.values

• 预览数据:ser_obj.head(n), ser_obj.tail(n)

>>> import pandas as pd >>> s = pd.Series(np.random.randn(5), index=['a','b', 'c', 'd', 'e']) >>> s a -0.149994 b 0.178126 c 2.016520 d -0.571042 e 0.159708 dtype: float64 >>> s.index Index([u'a', u'b', u'c', u'd', u'e'], dtype='object') >>> s.values array([-0.14999403, 0.17812649, 2.01652018, -0.57104158, 0.15970822])

2.DataFrame

DataFrame是一个类似表格的数据结构,索引包括列索引和行索引,包含有一组有序的列,每列可以是不同的值类型(数值、字符串、布尔值等)。DataFrame的每一行和每一列都是一个Series,这个Series的name属性为当前的行索引名/列索引名。

定义:DataFrame(data=None,index=None,coloumns=None)

-

通过列索引获取列数据(Series类型 ):df_obj[col_idx] 或 df_obj.col_idx

-

.ix,标签与位置混合索引

>>> import pandas as pd >>> data = {'state':['true','false','true','true','false'],'year':[2000,2001,2002,2001,2002],'pop':[1.5,1.7,3.6,2.4,2.9]} >>> df=pd.DataFrame(data) >>> df state year pop 0 true 2000 1.5 1 false 2001 1.7 2 true 2002 3.6 3 true 2001 2.4 4 false 2002 2.9 >>> df.index RangeIndex(start=0, stop=5, step=1) >>> df.values array([['true', 2000, 1.5], ['false', 2001, 1.7], ['true', 2002, 3.6], ['true', 2001, 2.4], ['false', 2002, 2.9]], dtype=object) >>> df.columns Index(['state', 'year', 'pop'], dtype='object')

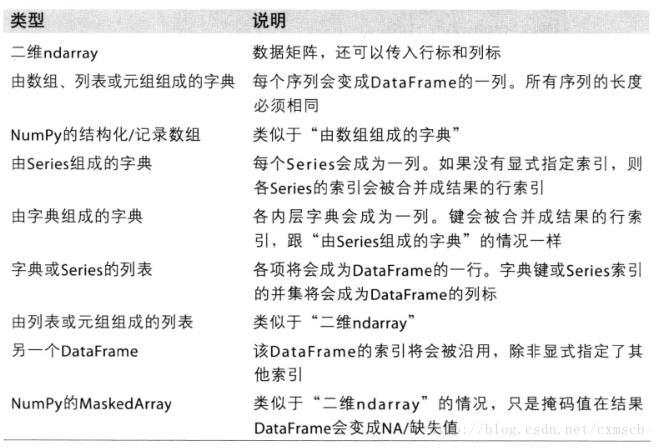

可输入给DataFrame构造器的数据:

![]()

三、生成数据表

1、导入CSV或者xlsx文件生成

Pandas可以读取多种类型的文件,包括TXT、CSV、EXCEL、JSON、HTML、DATABASE等。下面主要介绍Pandas读取CSV文件,参数较多,其中主要以文件路径filepath_or_buffer 、指定分隔标识符sep、是否指定header等。

filepath_or_buffer :可以读取本地文件或者远程文件,需要指定路径

Sep:指定分隔符。如果不指定参数,则会尝试使用逗号分隔。

header :指定行数用来作为列名,数据开始行数。如果文件中没有列名,则默认为0,否则设置为None。如果明确设定 header=0 就会替换掉原来存在列名。

dtype:指定数据列数据类型,如{‘a’: np.float64, ‘b’: np.int32}

df = pd.read_csv('name.csv',header=1) df = pd.read_excel('name.xlsx')

read_csv读取数据结果会将类型转换为DataFrame类型,可以结合Pandas中的关于数据选择、描述性统计 等方法对数据进行分析,可以结合后面介绍的MatplotLib进行可视化分析。

2、用pandas生成

df = pd.DataFrame(

{"id":[1001,1002,1003,1004,1005,1006], "date":pd.date_range('20130102', periods=6), "price":[1200,np.nan,2133,5433,np.nan,4432]

}, columns =['id','date','price'])

通过ndarray生成

tmp = {'国家':data.values[:,1],'2019年国际排名':data.values[:,5],'2018世界杯':data.values[:,6],'2015亚洲杯':data.values[:,7],'聚类':prey} prey = pd.DataFrame(tmp)

四、数据表信息查询

1、维度查看 df.shape 2、数据表基本信息(维度、列名称、数据格式、所占空间等) df.info() 3、每一列数据的格式 df.dtypes 4、某一列格式 df['b'].dtype 5、查看空值 df.isnull() 6、查看某一列的唯一值 df['B'].unique() 7、判断city列的值是否为北京 df_inner['city'].isin(['beijing']) 8、查看数据表的值(可以将数据转为矩阵) df.values 9、查看列名称 df.columns 10、查看前10行数据、后10行数据 df.head() #默认前10行数据 df.tail() #默认后10 行数据 11、显示数据行数 len(df) 12、数值型数据描述分析 df. describe() 输出数值型字段的条数、均值、标准差、最大/最小值、四分位数

五、数据表清洗

1、用数字0填充空值: df.fillna(value=0) 2、使用列prince的均值对NA进行填充: df['prince'].fillna(df['prince'].mean()) 3、清除city字段的字符空格: df['city']=df['city'].map(str.strip) 4、大小写转换: df['city']=df['city'].str.lower() 5、更改数据格式: df['price'].astype('int') 6、更改列名称: df.rename(columns={'category': 'category-size'}) 7、删除后出现的重复值: df['city'].drop_duplicates() 8、删除先出现的重复值: df['city'].drop_duplicates(keep='last') 9、数据替换: df['city'].replace('sh', 'shanghai')

六、数据预处理

1、数据表合并 pd.concat(objs, axis=0, join='outer', join_axes=None, ignore_index=False, keys=None, levels=None, names=None, verify_integrity=False, copy=True) 主要参数说明: 1)axis=0 / 1,指定的合并方向,默认为0即纵向合并,1为横向合并 2)join = outer,inner,outer为默认值按列合并,有相同的column上下合并在一起,其他独自的column个自成列,原本没有值的位置皆以NaN填充。按inner合并时,不相同的column会被丢弃 3)ignore_index= False,True,如果为True,则合并后的数据索引重新从0开始,否则不变 4)key = “”,可以指定合并以后数据的列名 merge方法是基于内存的高性能的类似于关系型数据库中的SQL,在处理数据量级比较大的情况下性能要优于其 它开源的方法,如R语言 pd.merge(left, right, how='inner', on=None, left_on=None, right_on=None, left_index=False, right_index=False, sort=True, suffixes=('_x', '_y'), copy=True, indicator=False) 主要参数说明: 1)left, right:要合并的二组DataFrame数据 2)on,按列进行联接,类似于数据库中主键关联,可以使用多个列进行关联 3)how = left,right,outer,inner,与数据库左连接、右连接、外连接、内连接类似 2、设置索引列 df_inner.set_index('id') 3、按照特定列的值排序: df_inner.sort_values(by=['age']) 4、按照索引列排序: df_inner.sort_index() 5、如果prince列的值>3000,group列显示high,否则显示low: df_inner['group'] = np.where(df_inner['price'] > 3000,'high','low') 6、对复合多个条件的数据进行分组标记 df_inner.loc[(df_inner['city'] == 'beijing') & (df_inner['price'] >= 4000), 'sign']=1 7、对category字段的值依次进行分列,并创建数据表,索引值为df_inner的索引列,列名称为category和size pd.DataFrame((x.split('-') for x in df_inner['category']),index=df_inner.index,columns=['category','size'])) 8、将完成分裂后的数据表和原df_inner数据表进行匹配 df_inner=pd.merge(df_inner,split,right_index=True, left_index=True) 9、重设索引 df_inner.reset_index()

10、插入数据

df.insert(loc=0,column='1',value=[1,2,3])

七、数据选择

主要用到的三个函数:loc,iloc和ix,loc函数按标签值进行提取,iloc按位置进行提取,ix可以同时按标签和位置进行提取。

数据:

>>> df = pd.DataFrame(np.arange(24).reshape((6,4)),index=dates,columns=['a','b','c','d'])

>>> df

a b c d

2018-09-01 0 1 2 3

2018-09-02 4 5 6 7

2018-09-03 8 9 10 11

2018-09-04 12 13 14 15

2018-09-05 16 17 18 19

2018-09-06 20 21 22 23

1.简单的筛选

>>> df.a

2018-09-01 0

2018-09-02 4

2018-09-03 8

2018-09-04 12

2018-09-05 16

2018-09-06 20

Freq: D, Name: a, dtype: int32

>>> df['a']

2018-09-01 0

2018-09-02 4

2018-09-03 8

2018-09-04 12

2018-09-05 16

2018-09-06 20

Freq: D, Name: a, dtype: int32

>>> df[0:3]

a b c d

2018-09-01 0 1 2 3

2018-09-02 4 5 6 7

2018-09-03 8 9 10 11

2.根据标签: loc,按标签值进行提取

>>> df.loc['20180902']#提取单行数据

a 4

b 5

c 6

d 7

Name: 2018-09-02 00:00:00, dtype: int32

3.根据位置: iloc,按位置进行提取

冒号前后的数字不是索引的标签名称,而是数据所在的位置,从0开始,到n-1止

>>> df.iloc[[1,3,5],1:3]#按位置1、3、5提取第1、2列数据

b c

2018-09-02 5 6

2018-09-04 13 14

2018-09-06 21 22

>>> df.iloc[0:3,0:3]

a b c

2018-09-01 0 1 2

2018-09-02 4 5 6

2018-09-03 8 9 10

4.根据混合: ix,同时按标签和位置进行提取

>>> df.ix[:3,['a','b']]#位置3之前的,标签为a,b列的数据

a b

2018-09-01 0 1

2018-09-02 4 5

2018-09-03 8 9

>>> df.ix[:'2018-09-03' ,0:3]#索引为2018-09-03之前的,位置为0,1,2列的数据 a b c 2018-09-01 0 1 2 2018-09-02 4 5 6 2018-09-03 8 9 10

5.通过判断的筛选

>>> df[df.a>8]

a b c d

2018-09-04 12 13 14 15

2018-09-05 16 17 18 19

2018-09-06 20 21 22 23

>>> df.loc[df['a'].isin([4,8])]#提取a列值为4和8的数据 a b c d 2018-09-02 4 5 6 7 2018-09-03 8 9 10 11

>>> df.loc[(df['a'] > 5) & (df['b'] == 9), ['a','b','c','d']]#提取a>5且b=9的数据 a b c d 2018-09-03 8 9 10 11

>>> df.loc[(df['a'] > 5) | (df['b'] == 9), ['a','b','c','d']]#提取a>5或b=9的数据 a b c d 2018-09-03 8 9 10 11 2018-09-04 12 13 14 15 2018-09-05 16 17 18 19 2018-09-06 20 21 22 23

八、数据计算

>>> df = pd.DataFrame({'dateid':['20180801','20180802','20180803','20180901','20180902','20180903'],

... 'usersum':[10,20,30,50,100,150]},columns=['dateid','usersum'])

>>> df

dateid usersum

0 20180801 10

1 20180802 20

2 20180803 30

3 20180901 50

4 20180902 100

5 20180903 150

将date_id处理为月格式

>>> df['monthid']=df.dateid.str.slice(0,6) >>> df dateid usersum monthid 0 20180801 10 201808 1 20180802 20 201808 2 20180803 30 201808 3 20180901 50 201809 4 20180902 100 201809 5 20180903 150 201809

1、计数

>>> df_group1=df['monthid'].value_counts()#方法一 >>> df_group1 201809 3 201808 3 Name: monthid, dtype: int64 >>> df_group2=df.groupby(by=['monthid'])['usersum'].count()#方法二 >>> df_group2 monthid 201808 3 201809 3 Name: usersum, dtype: int64

2、求和

>>> df_sum=df.groupby(by=['monthid'])['usersum'].sum() >>> df_sum monthid 201808 60 201809 300 Name: usersum, dtype: int64

九、数据输出

1、写入Excel

df.to_excel('excel_to_python.xlsx', sheet_name='bluewhale_cc')

2、写入到CSV

df.to_csv('excel_to_python.csv')

浙公网安备 33010602011771号

浙公网安备 33010602011771号