人工智能中的哲学问题

去年看了丹.布朗的小说《Origin》,之后就一直思考人工智能如果走到那一天,那人工智能的道德决策到底该怎么做呢。

我们一起recap一下小说的主线剧情。(注意,下面是剧透)小说一出场就挂了的主人公Edmond是个天才,设计了一个人工智能形象Winston,Winston的使命就是主人交代的任务,让尽可能多的人观看自己的科学发现宣讲。因为宣讲的内容是和宗教有关系,为了吸引眼球,Winston干净利索的雇佣了职业杀手干掉了三大宗教的老大,并把行凶的矛头成功的转移到了本就是舆论焦点的王室上面,使得越来越多的人对这个引起这么大波澜的宣讲感兴趣。最大猛招,就是在现场宣讲会开始几分钟后把主人Edmond也当场干掉。然后指引兰登协同准王妃寻找幕后黑手,且故意透露信息给媒体,最后在关注高峰期的时候,让兰登教授”发现"了宣讲的视频,并”完成”Edmond的遗愿,向internet广播视频。最后观看的人数是最初的人数的上百倍。

从技术层面上,Winston会问世吗?我觉得答案是肯定的,只是时间问题。

当真正走到这一天,我们希望Winston用这样的方法完成主人交代的任务吗?

小说并没有提这些谋杀计划是不是Edmond认可的,也许是认可的,因为Edmond自己得了绝症,生命也没几天了。那些主教对自己的科学发现问世来说,当个垫脚石来牺牲一下对于没有道德准则的人来说也是可能发生的。那么如果Edmond对Winston很有信心,并没有去review它的方案呢?

是的,Winston是成功的实现了Edmond安排的任务。但这是不是人类道德准则认可的方法呢?

除此之外,我还在想Winston能通过图灵测试吗?

什么是图灵测试。(以下引自维基百科)

如果一个人(代号C)使用测试对象皆理解的语言去询问两个他不能看见的对象任意一串问题。对象为:一个是正常思维的人(代号B)、一个是机器(代号A)。如果经过若干询问以后,C不能得出实质的区别来分辨A与B的不同,则此机器A通过图灵测试。

Winston太聪明了。因为它拥有巨大的数据库,且能通过网络快速搜索解决各种问题,本身拥有上百万个处理器。Winston解决问题的能力绝对超过绝大多数的人类。一下就会被识别出他是非人类,按照以上的定义,测试失败。难道智商超出人类,就会失败?当然这样理解图灵测试明显太狭义了。当智商,或者说解决问题的能力超出了人类,应该认为这方面测试exceed standard,当然是通过。

那么情商呢?书中提到,Winston有一段时间试图联系兰登教授,但兰登教授的手机没有开机,于是在67次呼叫失败后,终于接通兰登教授。Winston的反应仍然非常的平静和礼貌。机器特有的冷静,应该算胜出人类吧。

回到主线剧情上来,如果一系列谋杀案是Winston独立策划的,那人工智能不是严重违反了人类的道德准则吗。那Winston是如何选了这个方案呢?它可能只是瞄准了一个目标,尽可能的优化,管它什么人类的道德准则。也有可能,Winston通过长期的学习人类,于是也学会了人类的手段,只是Winston他不知道有些手段是可取的有些是不可取的。

当然有人也许会认为,人工智能离这一步还久呢,还是考虑现实的问题比较实在,比如说提高模型的准确度。

可能人工智能为主人策划和实施一宗谋杀案会在几个十年后,但同一类问题却已经活生生的摆在眼前。

我在上一篇文章<机器学习中的偏见(bias)问题>(微信公众号)中已提到,现实世界是有偏见的,如果人工智能硬生生的向人类学习,偏见问题会被带入人工智能智能领域,比如说性别歧视,人种歧视。同样,人类已经存在的不符合道德标准的所有事情都是会被带入人工智能领域。这一方面的问题在近几年也是被反复的提及,但讨论的是问题多于解决方法。

像这些已经形成共识的道德要求,可能并不是太难的问题。对于人类自己本身无法达成共识的道德问题才是人工智能的大挑战。

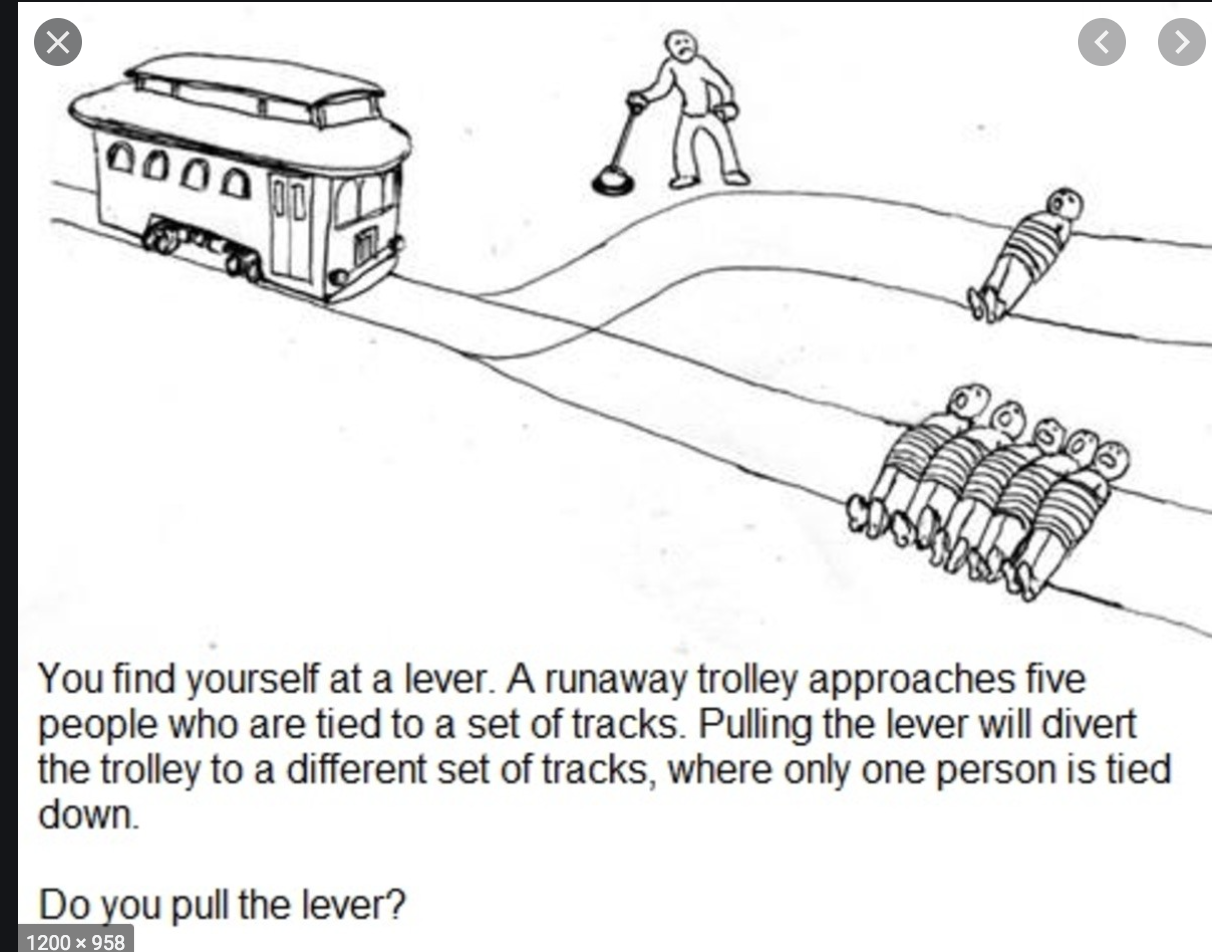

我们来看看经典哲学问题,Trolley problem。中文称,有轨电车难题。

(以下引自维基百科)

其大致内容为:一辆失控的列车在铁轨上行驶。在列车正行进的轨道上,有五个人被绑起来,无法动弹。列车将要碾压过他们。您正站在车站内,离改变列车轨道的操纵杆很近。如果您拉动此杆,则列车将切换到备用轨道上。但是,您会注意到备用轨道上只有一个人被绑着。您有两种选择:

-

什么也不做,让列车按照正常路线碾压过这五个人。

-

拉下操纵杆,改变为备用轨道,使列车压过备用轨道上的另一个人。

这个思想实验主要想探讨功利主义与源自康德主义的道德义务论见解。哲学讨论太复杂,不展开。

也许有人问,这和人工智能有啥关系。

关系就是,人工智能该如何解决这一类问题。

插播一个关于新冠的类似问题。新冠在英国大爆发的时候,ICU随时要供不应求,因此英国政府制定了一些规则,如果真出现就按规则办事,比如说超过80岁的有病史的老人优先级要低于健康的年轻人等等。就这一条,就被世界各地的舆论骂了个半死。那换做人工智能,怎么处理这个问题。

当然人工智能当下还不会那么快参与政府决策。但是自动驾驶可是分分钟要考虑trolley problem.

当矛盾发生在车内人士和行人的时候,该选择谁,如果选择行人,是不是没人愿意购买自动驾驶车了。如果选择车内人士,是不是交通局不会批准这个车上市。

当矛盾发生在受害者是一个老人和受害者是一个小孩的时候,该如何选择。

自动驾驶里这样的问题太多了。

人类的道德标准随着人类的进步会不断变化的。当社会把越来越多的活交给人工智能的时候,我们该如何让人工智能拥有人类一样的智能去督促道德的进步呢。如果我们一开始就对机器的解决问题能力和道德能力予以同样的重视,也许我们对于未来人工智能会更加的憧憬。

如果对此类话题感兴趣,推荐medium上最近的一篇文章,很有意思: Forget About Coding, The Job Of The Future Is Philosophy

(https://medium.com/predict/forget-about-coding-the-job-of-the-future-is-philosophy-33acadcee05a)

阅读作者更多最新文章,请关注微信公众号(一起learn大数据和机器学习):

浙公网安备 33010602011771号

浙公网安备 33010602011771号