强化学习的数学原理-07时序差分方法

引入

这三个例子是层层递进的,都可以用

TD learing of state values

这个算法是求解给定策略

下面是

- 在

- 一般第二个式子很多地方都会省略,但这里写出来更清楚

为什么把

这是因为算法是要将

对上面的方程进行等价变形

上面的方程在描述一件事情:

对上面方程两边求绝对值.

因为

所以就有:

上面的式子就说明在下一个时刻

如何理解

- 描述在两个时刻上面的

- 描述

上面的

TD learing of action values Sarsa

假设我们有一些

有了上面的

算法是 的首字母的缩写

和之前使用

上面算法只是对

实际上

注意上面

关于传统的

TD learing of action values Expected Sarsa

这个算法和下面的

算法实际上是没有那么重要的,但是从一个经典算法出发,然后去推广改进,这种思路对于做研究来说是非常常见的

相比于原始的

TD learing of action values n-step Sarsa

先复习一下

- 存在问题,在

和 , 方法是 的, 是 而

是一种特殊的 的

TD learing of optimal action values:Q-learning

终于结束了

下面是

上面的就是大名鼎鼎的

在

- 一个是

- 另一个是

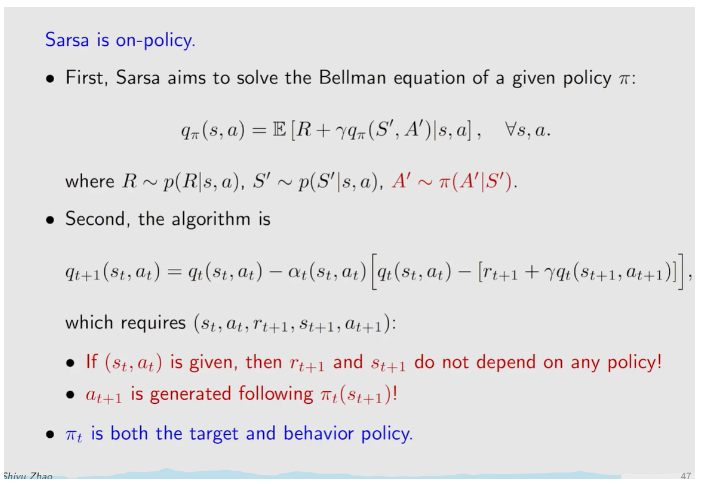

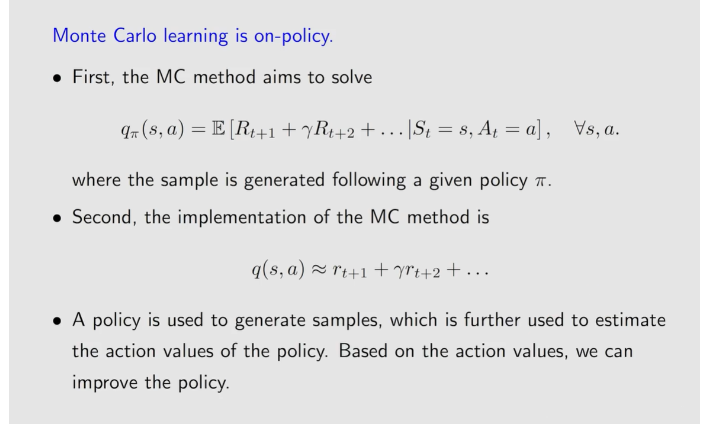

on-policy:

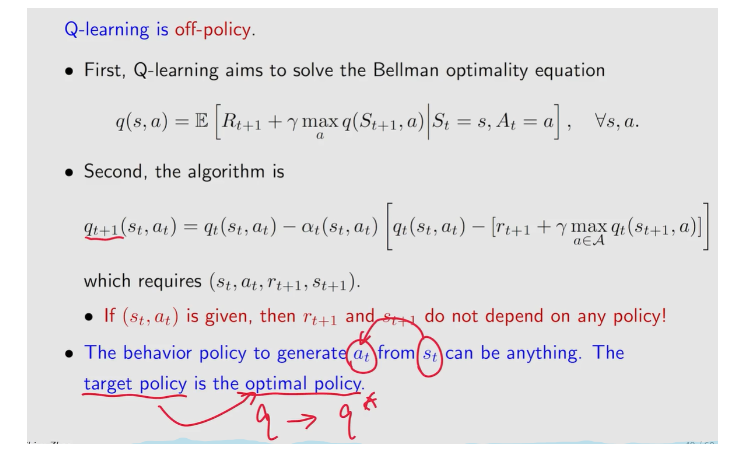

off-policy:

如何判断一个算法是

- 看算法在解决什么数学问题

- 可以看执行算法需要什么东西

两种

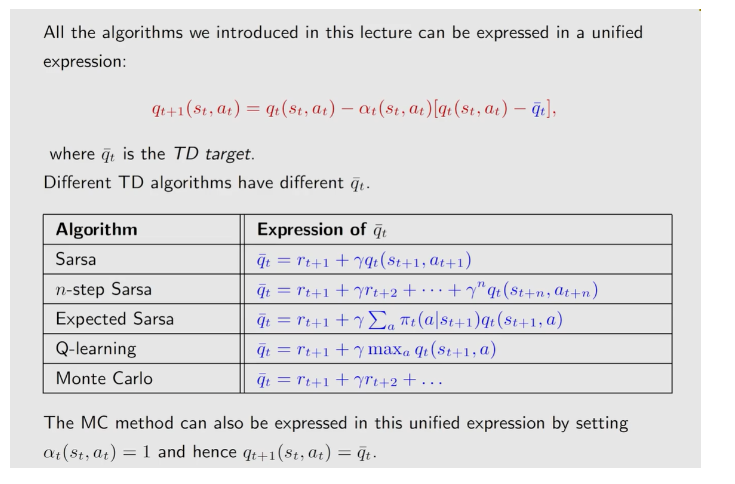

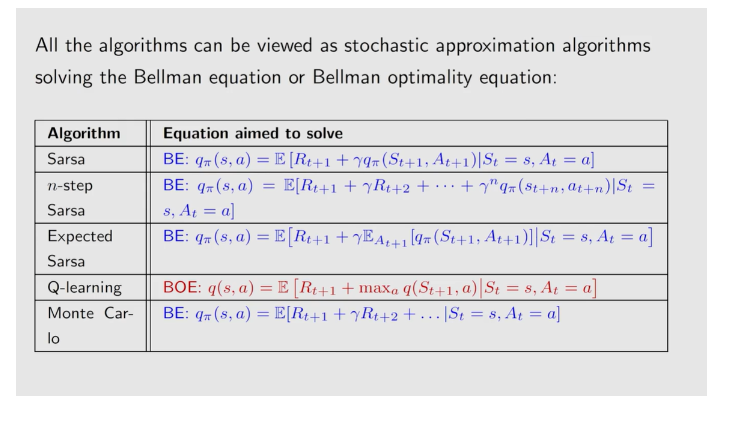

a unified point of view

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· C#/.NET/.NET Core优秀项目和框架2025年2月简报

· DeepSeek在M芯片Mac上本地化部署