强化学习的数学原理-03贝尔曼最优公式

最优策略和公式推导

首先定义一个策略比另一个策略好:

如何有上面式子成立,那么就说

基于上面的定义,于是就可以定义最优

对于所有的状态s,和所有的策略

那么

贝尔曼最优公式:

对于贝尔曼最优公式实际上是一个最优化问题

我们已知的有

是未知的并且需要求解的

对于贝尔曼公式是已知到,对于贝尔曼最优公式 是未知的需要求解的。

贝尔曼最优公式的矩阵形式

- 贝尔曼最优公式(BOE)非常elegant,它的形式非常简介,可以刻画最优的策略和最优的state value

右侧最优化问题

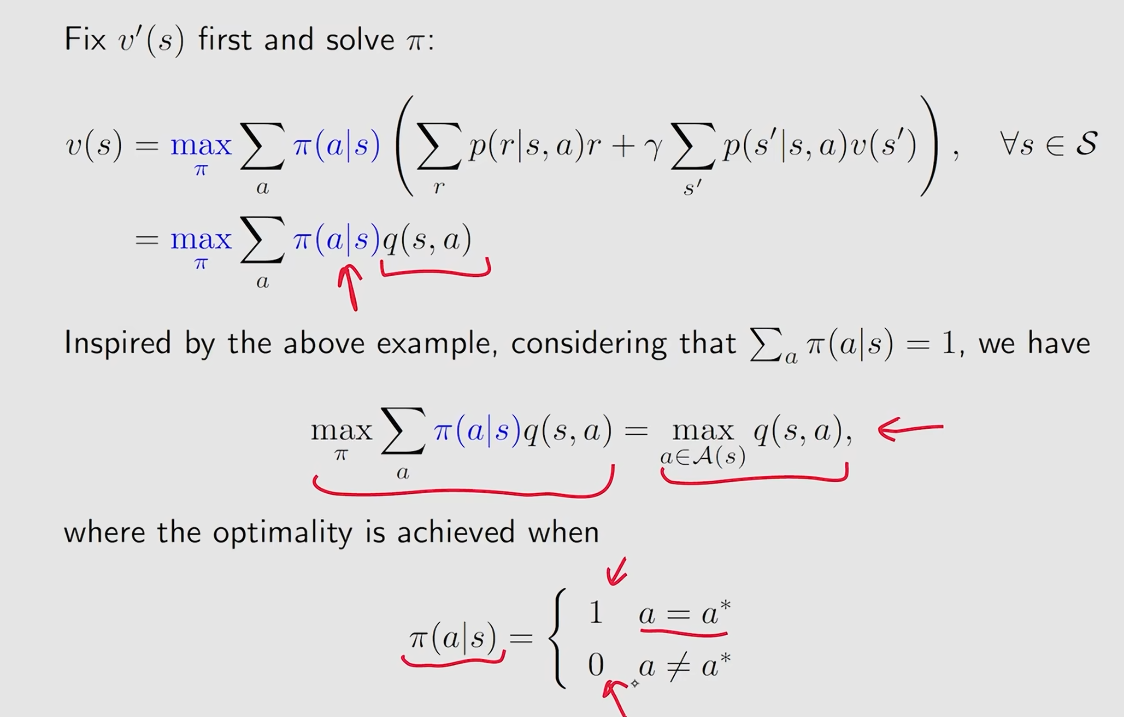

如何求解贝尔曼最优公式?

考虑下面的问题:

上面的式子中也是含有两个未知量

先看右边的部分当

然后将

于是

下面解决贝尔曼最优方程

考虑我们有3个

也就是

为了不失一般性这里假设一个最大值,假设

通过上面的例子就可以知道如果

公式求解以及最优性

贝尔曼最优公式的矩阵形式

我们把贝尔曼最优公式写成一个函数形式

于是最优公式就化成了

这里的

于是问题就转化成了求解

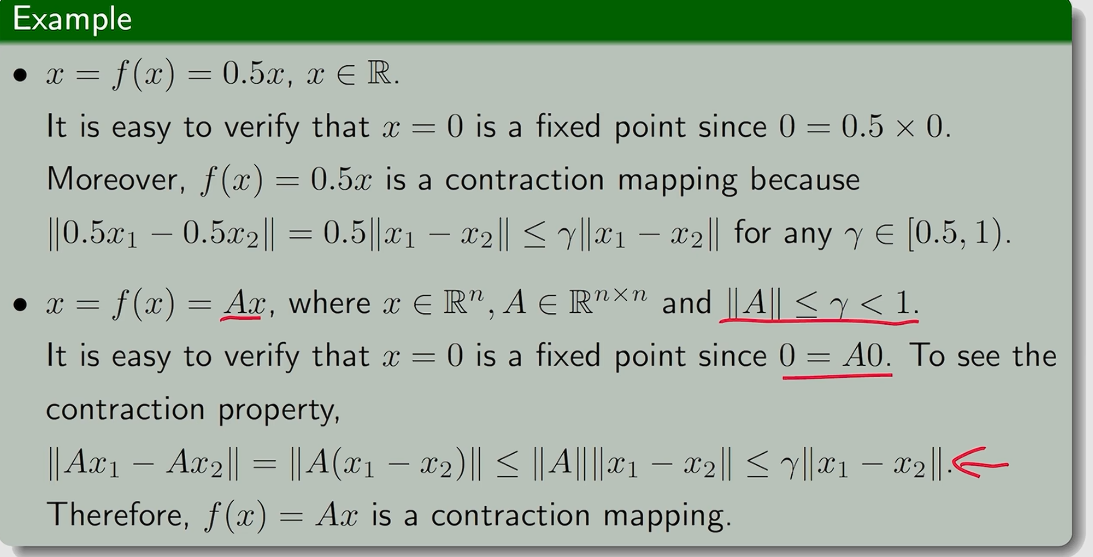

Contraction mapping theorem(压缩映射定理)

关于这个定义的详细介绍在这 | 中文数学 Wiki | Fandom

在说压缩映射定理之前需要引入一些概念

Fixed point(不动点):

然后

Contraction mapping or Contractive function:

Theorem(Contraction Mapping Thorem):

对于任何形如

存在性:存在一个不动点

唯一性:不动点

求解不动点的算法:这是一个迭代式的算法,不断令

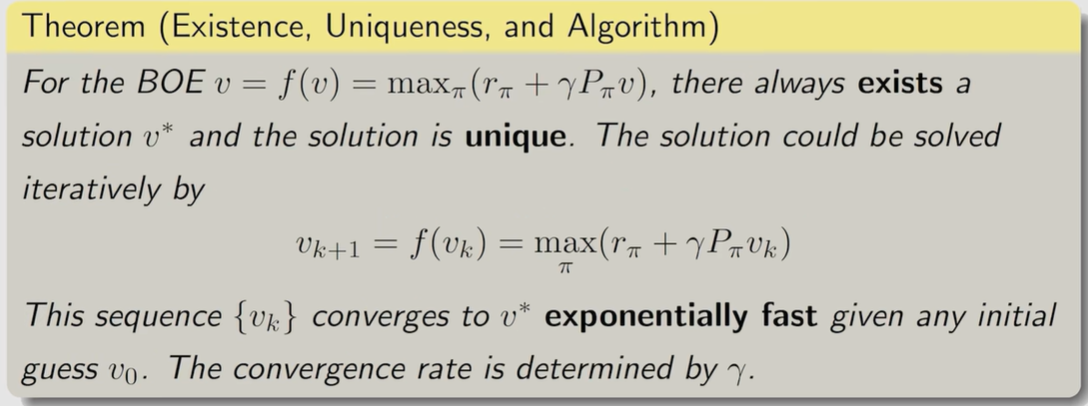

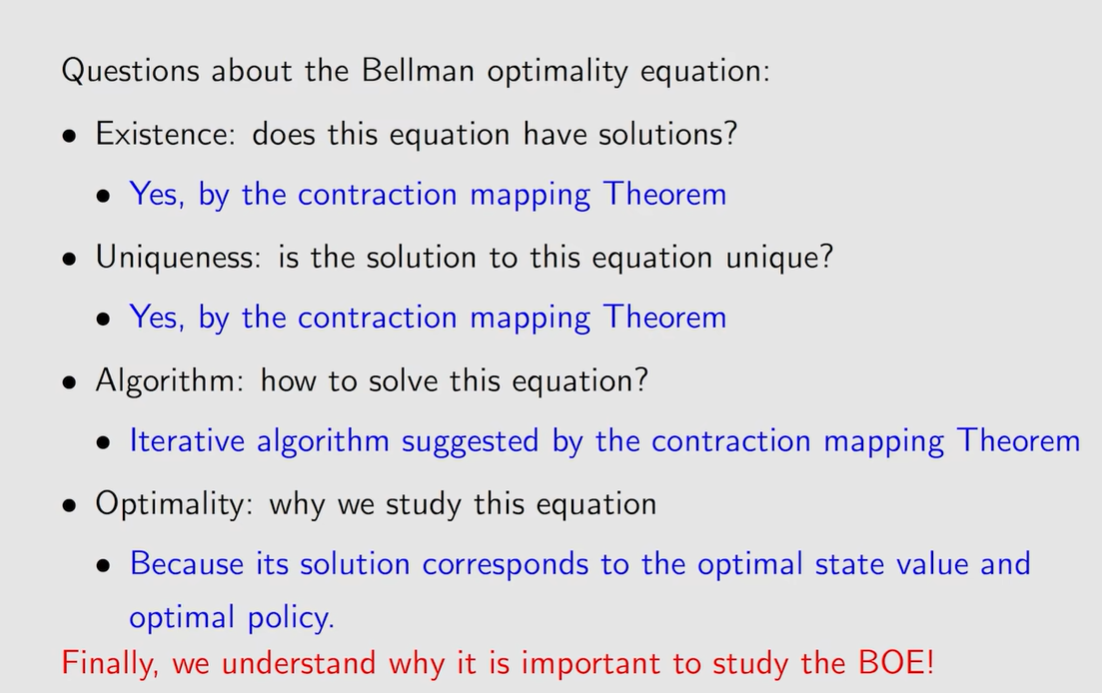

解决贝尔曼最优公式

有了上面的压缩映射定理就可以解决贝尔曼最优公式了

为了应用压缩映射定理,首先需要证明下式中

这个是可以得到证明的。

知道了

分析最优策略(analyzing optimal policies)

求解贝尔曼最优公式就是已知红色量求出上面公式中黑色的量

公式中的三个量决定了optimal policy

- Reward design:

- System model:

- Discount rate:

-

当

-

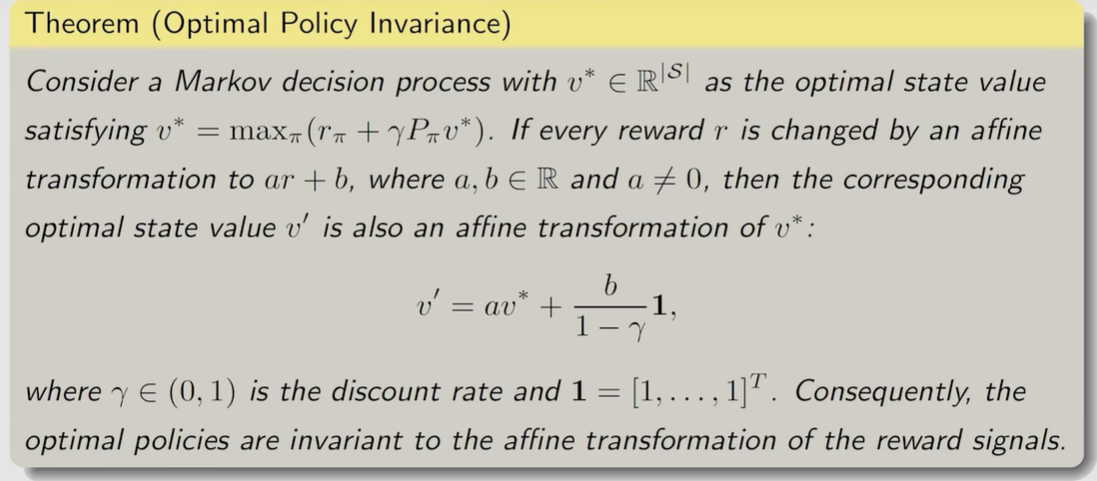

改变

下面观察如果对

- 实际上进行线性变换是不会改变最优策略的。

- 这个问题实际上并不关注

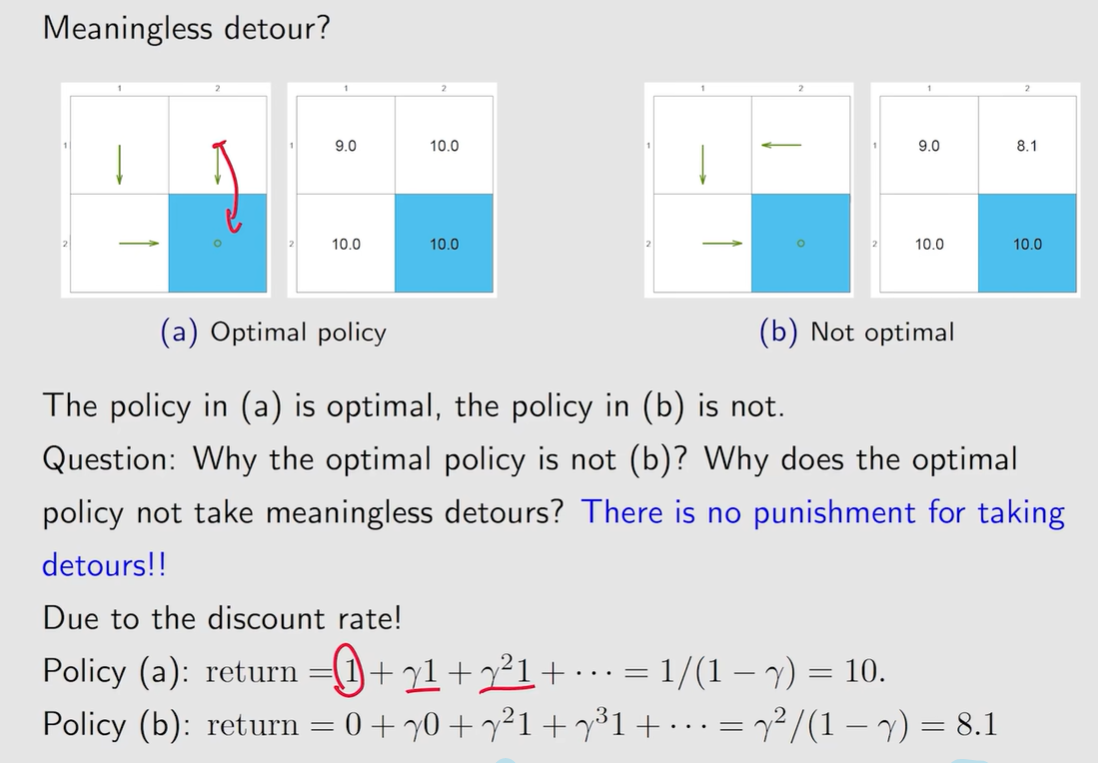

关于无意义的绕路:因为有

Summary

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· C#/.NET/.NET Core优秀项目和框架2025年2月简报

· DeepSeek在M芯片Mac上本地化部署

2022-10-24 meet