强化学习的数学原理-01基本概念

state:

对于下面的网格地图来说:

state space:

Action:

Action space of a state:

state transition: 当采取了一个

Forbidden area:有两种情况,一种是forbidden are可以到达,但是会得到相应的惩罚,另一种是forbidden area不可到达,相当于有一堵墙。

Tabular representation:可以用表格来描述state transition

只能能表示确定的情况

相比于上面的表格,更一般的做法是使用下面这种方法

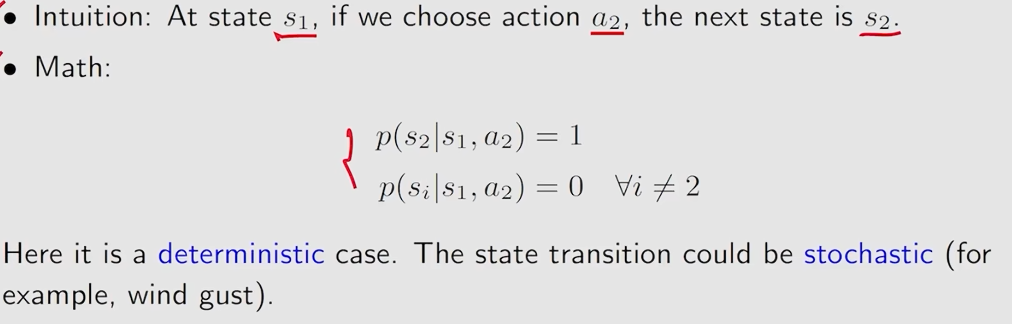

state transition probability:使用概率来描述state transition

Policy:告诉agent在一个状态应该采取什么动作

上面图片中的情况是确定性的策略,同时也有不确定的策略

Reward:reward是action采取一个action后得到的实数,一个正的reward代表鼓励采取这样的action,一个负的reward代表惩罚这样的action。

reward可以理解成一个

reward依赖于当前的

trajectory:是一个

Return:沿着trajectory,所有的reward相加得到得就是return

return的作用可以用来评估一个策略的好坏

discount return:

从上图可以看到上面的trajectory是无限长的,对应的return是发散的。

为了解决这个问题引入一个

上面的return就可以用discount return来表示

episode\trial:一个有限步的trajectory被称为episode,也就是有terminal states的trajectory。

可以采用方法将episodic转化为continue的,在terminal state时无论采取什么action都会回到terminal state。

MDP:Markov decision process,马尔可夫决策过程是一个框架framework

一个马尔可夫决策过程中有很多关键的元素:

set:

- State:

- Action

- Reward

Probability distribution:

- State transition probability:在一个状态s,采取action a,转移到状态

- Reward probability:在状态s,采取action a,得到reward r的概率

Policy:

在状态s,采取action a的概率

Markov property:memoryless property

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· C#/.NET/.NET Core优秀项目和框架2025年2月简报

· DeepSeek在M芯片Mac上本地化部署