flink维表查询

flink维表查询

flink维表查询redis之flink-connector-redis

https://blog.csdn.net/zilong00007/article/details/123410595

https://github.com/topics/bahir

https://github.com/apache/bahir-flink

zookeeper可视化界面

- Apache ZooKeeper Web UI

Apache ZooKeeper Web UI是一个基于Web的可视化界面,可以用于管理和监控ZooKeeper集群。它提供了一个易于使用的用户界面,可以查看和管理ZooKeeper节点、监控集群状态等。Apache ZooKeeper Web UI是一个开源项目,可以从GitHub上获取源代码。

- Exhibitor

Exhibitor是一个开源的ZooKeeper管理工具,提供了一个易于使用的Web界面,可以用于管理和监控ZooKeeper集群。Exhibitor提供了一些有用的功能,如自动备份、节点管理、监控集群状态等。Exhibitor还可以与Nagios、Ganglia等监控工具集成,方便用户进行集群监控和告警。Exhibitor的源代码可以从GitHub上获取。

Apache ZooKeeper Web UI,

ZooInspector,zkui,zkdash,ZooKeeperAssistant,

prettyZoo

https://www.cnblogs.com/peak-c/p/6473056.html

https://www.jianshu.com/p/3c298fa142b8

https://cloud.tencent.com/developer/article/2241212

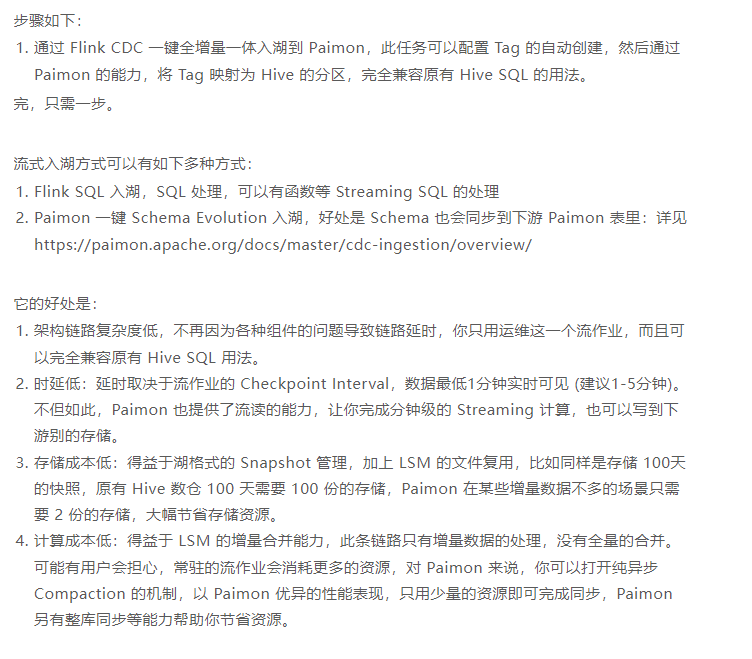

Flink + Paimon 数据 CDC 入湖最佳实践

Apache Paimon 最典型的场景是解决了 CDC (Change Data Capture) 数据的入湖,看完这篇文章,你可以了解到:

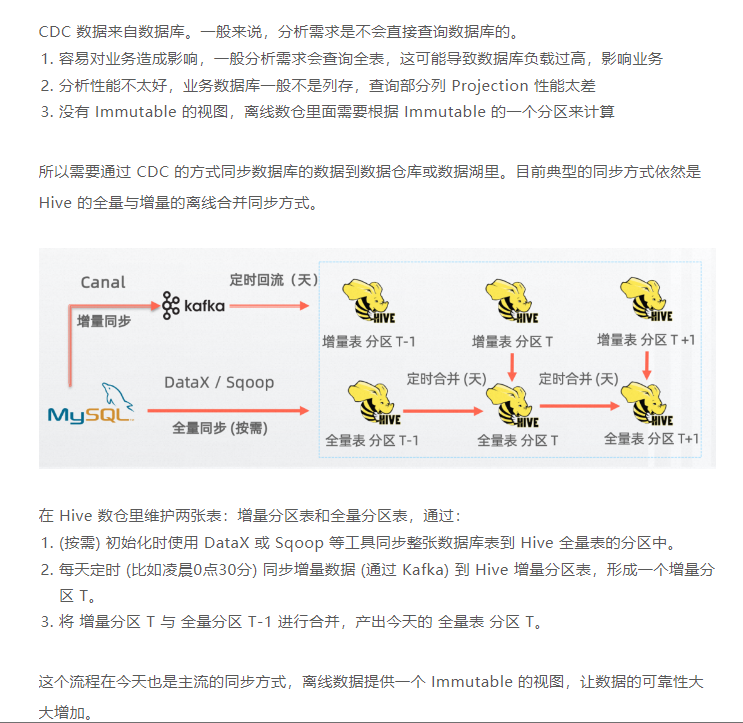

为什么从 CDC 入 Hive 迁移到 Paimon?

CDC 入 Paimon 怎么样做到成本最低?

Paimon 对比 Hudi 有什么性能优势?

Paimon 从 CDC 入湖场景出发,希望提供给你 简单、低成本、低延时 的一键入湖。本文基于 Paimon 0.6,0.6 正在发布中,可提前在此处下载:https://paimon.apache.org/docs/master/project/download/

但是它的问题不少:

架构链路复杂度高:由于链路复杂,每天产出全量分区容易有问题导致不能按时产出,新增业务也比较复杂,全量和增量割裂。

时延高:至少 T + 1 延时,而且需要等全量和增量合并完成。

存储成本高:每天全量表一个分区存储所有数据,意味着 100 天就需要 100 倍的存储成本。

计算成本高:每天需要读取全量数据,与增量数据进行全量合并,在增量数据不多时浪费严重。

是时候该做一些改变了。

Rocketmq、Rabbitmq、Kafka、Mongo、Elasticsearch、Logstash、Kibana、Nacos、Skywalking、Seata、Spark、Zookeeper安装

已经安装好了宝塔面板、并且可以在Docker栏目,选择docker安装,会把docker和docker-compose都安装好了

https://www.bt.cn/new/download.html

yum install -y wget && wget -O install.sh https://download.bt.cn/install/install_6.0.sh && sh install.sh ed8484bec

绑定成功后,进入面板主界面,会推荐安装套件。这里有LNMP和LAMP两个选项,二者不同的地方是Web服务器不同。前者使用Nginx服务器,后者使用Apache服务器。由于我们的服务器配置比较低,所以选择性能更好的Ngnix服务器,即左边的LNMP套件。(LNMP和LAMP中的L代表Linux,N代表Nginx,M代表Mysql,P代表PHP,A代表Apache)

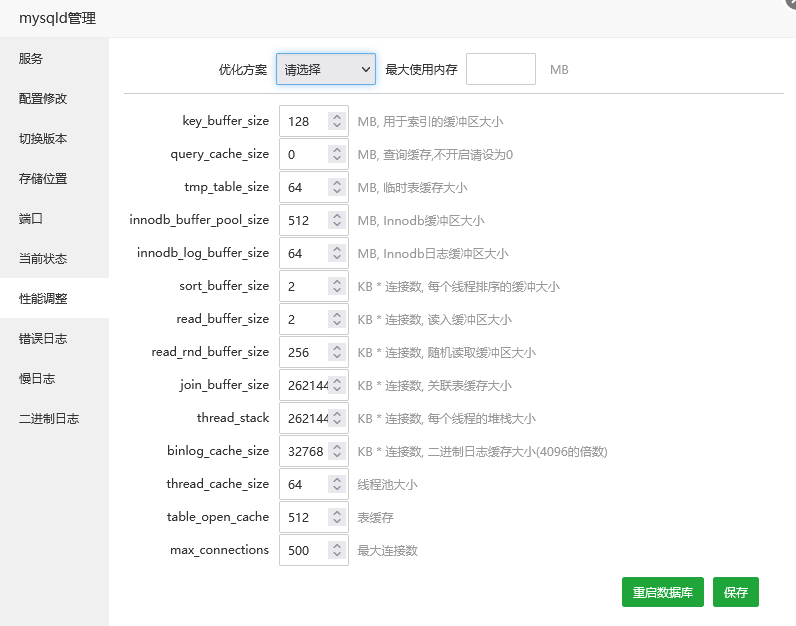

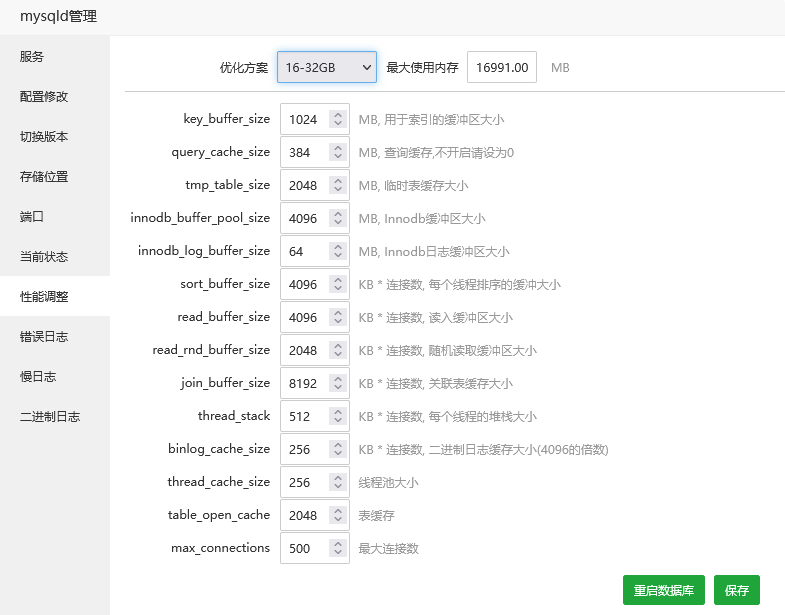

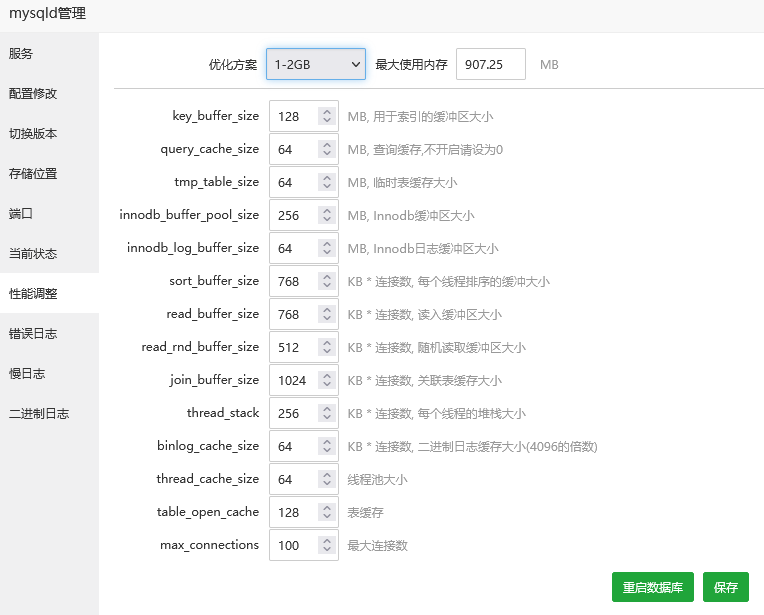

mysql调优

[client]

#password = your_password

port = 3306

socket = /tmp/mysql.sock

[mysqld]

port = 3306

socket = /tmp/mysql.sock

datadir = /www/server/data

default_storage_engine = InnoDB

performance_schema_max_table_instances = 400

table_definition_cache = 400

skip-external-locking

key_buffer_size = 128M

max_allowed_packet = 100G

table_open_cache = 512

sort_buffer_size = 2M

net_buffer_length = 4K

read_buffer_size = 2M

read_rnd_buffer_size = 256K

myisam_sort_buffer_size = 32M

thread_cache_size = 64

query_cache_size = 64M

tmp_table_size = 64M

sql-mode=NO_ENGINE_SUBSTITUTION,STRICT_TRANS_TABLES

explicit_defaults_for_timestamp = true

#skip-name-resolve

max_connections = 500

max_connect_errors = 100

open_files_limit = 65535

log-bin=mysql-bin

binlog_format=mixed

server-id = 1

expire_logs_days = 10

slow_query_log=1

slow-query-log-file=/www/server/data/mysql-slow.log

long_query_time=3

#log_queries_not_using_indexes=on

early-plugin-load = ""

innodb_data_home_dir = /www/server/data

innodb_data_file_path = ibdata1:10M:autoextend

innodb_log_group_home_dir = /www/server/data

innodb_buffer_pool_size = 512M

innodb_log_file_size = 256M

innodb_log_buffer_size = 64M

innodb_flush_log_at_trx_commit = 1

innodb_lock_wait_timeout = 50

innodb_max_dirty_pages_pct = 90

innodb_read_io_threads = 2

innodb_write_io_threads = 2

[mysqldump]

quick

max_allowed_packet = 500M

[mysql]

no-auto-rehash

[myisamchk]

key_buffer_size = 128M

sort_buffer_size = 2M

read_buffer = 2M

write_buffer = 2M

[mysqlhotcopy]

interactive-timeout

https://zhuanlan.zhihu.com/p/631397374

在Kafka中,key是可选的,可以重复。key是一个短字符串,用于在分区中标识消息。当您发布消息到Kafka时,可以提供一个key,如果没有提供,则会使用空字符串作为默认key。

如果使用相同的key发布多个消息,这些消息将被分配到同一个分区中。请注意,分区是基于key的哈希值计算的,因此相同的key将在分区中具有相同的哈希值。

以下是一些关于Kafka key的信息:

Key的长度限制:Kafka中key的长度限制取决于您的Kafka实例配置。默认情况下,key的长度限制为1,000个字节。

Key的类型:key的类型取决于您的应用程序需求。它可以是字符串、整数、字节数组等。

Key的作用:key用于在分区中标识消息,并且可以用于查询和过滤消息。例如,如果您希望只订阅特定分区的消息,可以使用key来实现。

需要注意的是,如果您使用相同的key发布多个消息,并且这些消息很重要,确保它们的顺序在分区中得到保留。请参考Kafka的分区倾斜问题来了解更多信息。

Redis 客户端

与其他 Redis 客户端不同,RedisInsight 是 Reids 官方出品,地主家的亲儿子。

https://mp.weixin.qq.com/s/nO99g2kq8gSCSQQIGkUg7w

https://redis.com/redis-enterprise/redis-insight/

Tiny RDM

如果你之前用过 Redis Desktop Manager 的话,可以直接切换到Tiny RDM。布局以及操作方式都很一致。最近 Redis Desktop Manager 的官网好像挂了,不知道是不是不维护了。

浙公网安备 33010602011771号

浙公网安备 33010602011771号