卷积神经网络_简单笔记

原文网址 https://blog.csdn.net/v_JULY_v/article/details/51812459

神经元:

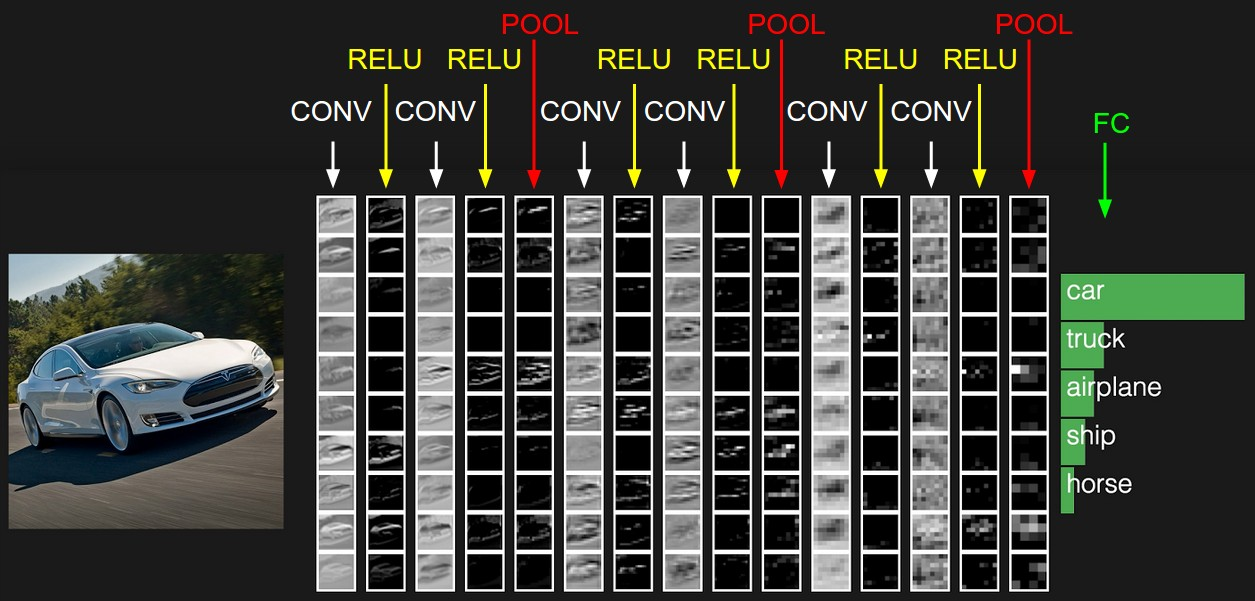

卷积神经网络之层级结构:

CONV:卷积计算层,线性乘积求和,

RELU:激活层,也就是激活函数

POOL:池化层,简言之,就是取区域平均或最大。

FC:全连接层

CNN之卷积计算层:当我们给定一个X的图案,计算机为了识别出来这个图案就是X,它会存储一张标准的X图案,然后把需要识别的位置图案跟标准的X图案进行对比,如果两者一致,则判定位置图案就是一个X图案,而当图案有一些平移或者稍微变形的时候,为了能够识别出来,这时候CNN是把位置图案和标准X图案一个局部一个局部的进行对比,而未知图案和标准X图案的局部一个一个比对时的过程,就是卷积操作。

对图像(不同的数据窗口数据)和滤波矩阵(一组固定的权重:因为每个神经元的多个权重固定,所以又可以看做一个恒定的滤波器filter)做内积(逐个元素相乘再求和)的操作就是所谓的卷积操作,也是卷积神经网络的名字由来,一个神经元所对应的的一组固定权重就可以理解成一个滤波器,不同的滤波器会得到不同的输出数据。比如颜色深浅轮廓,相当于如果想提取图像的不同特征,则用不同的滤波器filter。

在CNN中,滤波器filter(带着一组固定权重的神经元)对局部输入数据进行卷积计算,每计算完一个数据窗口内的局部数据后,数据窗口不断平滑移动,直到计算完所有数据,在这个过程中,有这么几个参数。

a:深度depth,神经元个数,决定输出的depth厚度,同时代表滤波器个数

b.步长stride,决定滑动多少步可以到边缘

c.填充值zerp-padding,在外围边缘补充若干圈0,方便从初始位置以步长为单位可以刚好滑动到末尾位置。通俗讲就是为了总长能被步长整除。

RELU激励层:就是激活函数,f(x) = max(0, x),relu激活函数就是当x小于零的时候值为零,当输入大于零时,输出等于输入。

池化层:池化,简言之,就是取区域平均或最大。

全连接层:深度神经网络的最后一层往往是 全连接层+softmax(分类网络),全连接层将权重矩阵与输入向量相乘再加上偏执,得到分类的得分,而softmax将K个类别的得分归一化为(0,1)的概率,

作者:cumtchw

出处:http://www.cnblogs.com/cumtchw/

我的博客就是我的学习笔记,学习过程中看到好的博客也会转载过来,若有侵权,与我联系,我会及时删除。