一、准备工作

三台虚拟机:master、node1、node2

#克隆的时候选择 完整克隆 和 链接克隆 的区别

完整克隆:克隆出两台独立的虚拟机

链接克隆:依赖master,假如说把master删了,那么node1、node2就都挂了

链接克隆较完整克隆更加节省空间

时间同步

ntpdate ntp.aliyun.com

JDK的版本-jdk1.8

java -version

修改主机名

三台分别执行 vim /etc/hostname 并将内容指定为对应的主机名

关闭防火墙

关闭防火墙:systemctl stop firewalld

查看防火墙状态:systemctl status firewalld

取消防火墙自启:systemctl disable firewalld

静态IP配置

1、编辑网络配置文件

vim /etc/sysconfig/network-scripts/ifcfg-ens33

TYPE=Ethernet

BOOTPROTO=static

HWADDR=00:0C:29:E2:B8:F2

NAME=ens33

DEVICE=ens33

ONBOOT=yes

IPADDR=192.168.190.100

GATEWAY=192.168.190.2

NETMASK=255.255.255.0

DNS1=192.168.190.2

DNS2=223.6.6.6

需要修改:HWADDR(mac地址,centos7不需要手动指定mac地址)

IPADDR(根据自己的网段,自定义IP地址)

GATEWAY(根据自己的网段填写对应的网关地址)

2、关闭NetworkManager,并取消开机自启

systemctl stop NetworkManager

systemctl disable NetworkManager

3、重启网络服务

systemctl restart network

免密登录

# 1、生成密钥

ssh-keygen -t rsa

# 2、配置免密登录

ssh-copy-id master

ssh-copy-id node1

ssh-copy-id node2

# 3、测试免密登录

ssh node1

配置好映射文件:/etc/hosts

192.168.52.110 master

192.168.52.120 node1

192.168.52.130 node2

二、搭建Hadoop集群

1、上传安装包并解压

# 使用xftp上传压缩包至master的/usr/local/soft/module/

cd /urs/local/soft/module/

# 解压

tar -zxvf hadoop-2.7.6.tar.gz -C /usr/local/soft/

2、配置环境变量

vim /etc/profile

JAVA_HOME=/usr/local/soft/jdk1.8.0_171

HADOOP_HOME=/usr/local/soft/hadoop-2.7.6

export PATH=$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

# 重新加载环境变量

source /etc/profile

3、修改Hadoop配置文件

cd /usr/local/soft/hadoop-2.7.6/etc/hadoop/

core-site.xml

#<configuration>下面的内容在这中间加</configuration>

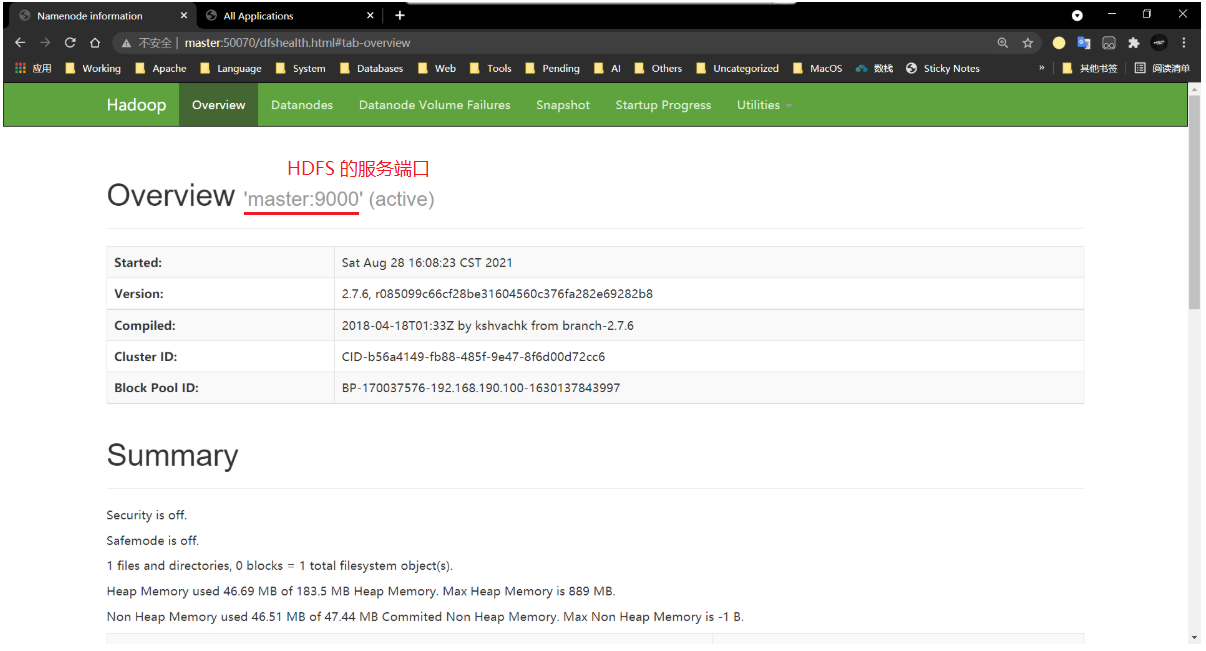

#这里配的是HDFS的入口 master:9000

<property>

<name>fs.defaultFS</name>

<value>hdfs://master:9000</value>

</property>

#这里配置的是Hadoop运行时产生的数据存放的目录tmp

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/soft/hadoop-2.7.6/tmp</value>

</property>

#这里配置的是垃圾回收的间隔时间 1440分钟 -- 1天

<property>

<name>fs.trash.interval</name>

<value>1440</value>

</property>

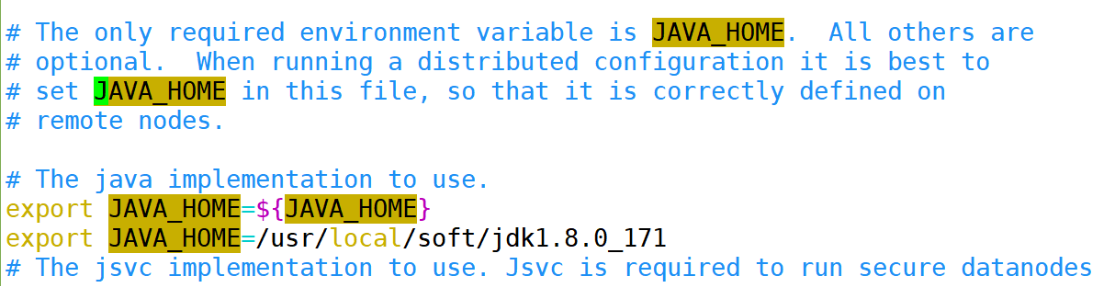

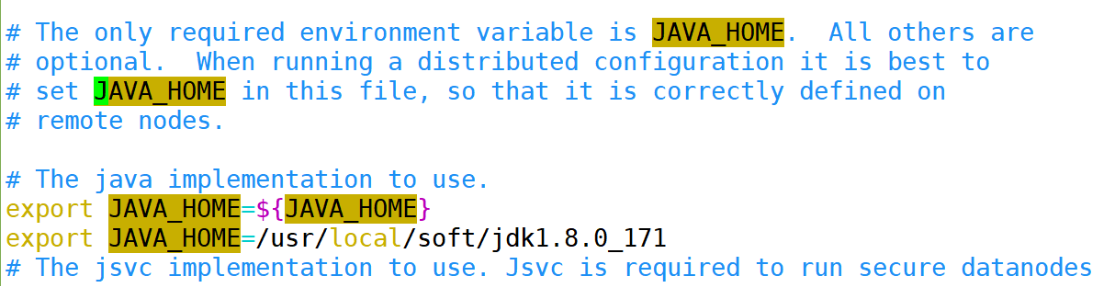

hadoop-env.sh

export JAVA_HOME=/usr/local/soft/jdk1.8.0_171

hdfs-site.xml

#不要副本

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

#关闭权限验证

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

mapred-site.xml.template

# 1、重命名文件

cp mapred-site.xml.template mapred-site.xml

# 2、修改 vim mapred-site.xml

#用yarn资源管理平台

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>master:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>master:19888</value>

</property>

slaves

#其中默认是localhost,如果你想搭建伪分布式,就用localhost

node1

node2

yarn-site.xml

#指定resourcemanager在master节点上启动

<property>

<name>yarn.resourcemanager.hostname</name>

<value>master</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

#表示对日志文件进行压缩

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

#设置日志存活时间604800秒--一周

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

4、分发Hadoop到node1、node2

# scp 远程发送命令

# `pwd` 用反引号表示其中的命令会先运行,然后运行结果会将之替换掉

cd /usr/local/soft/

scp -r hadoop-2.7.6/ node1:`pwd`

scp -r hadoop-2.7.6/ node2:`pwd`

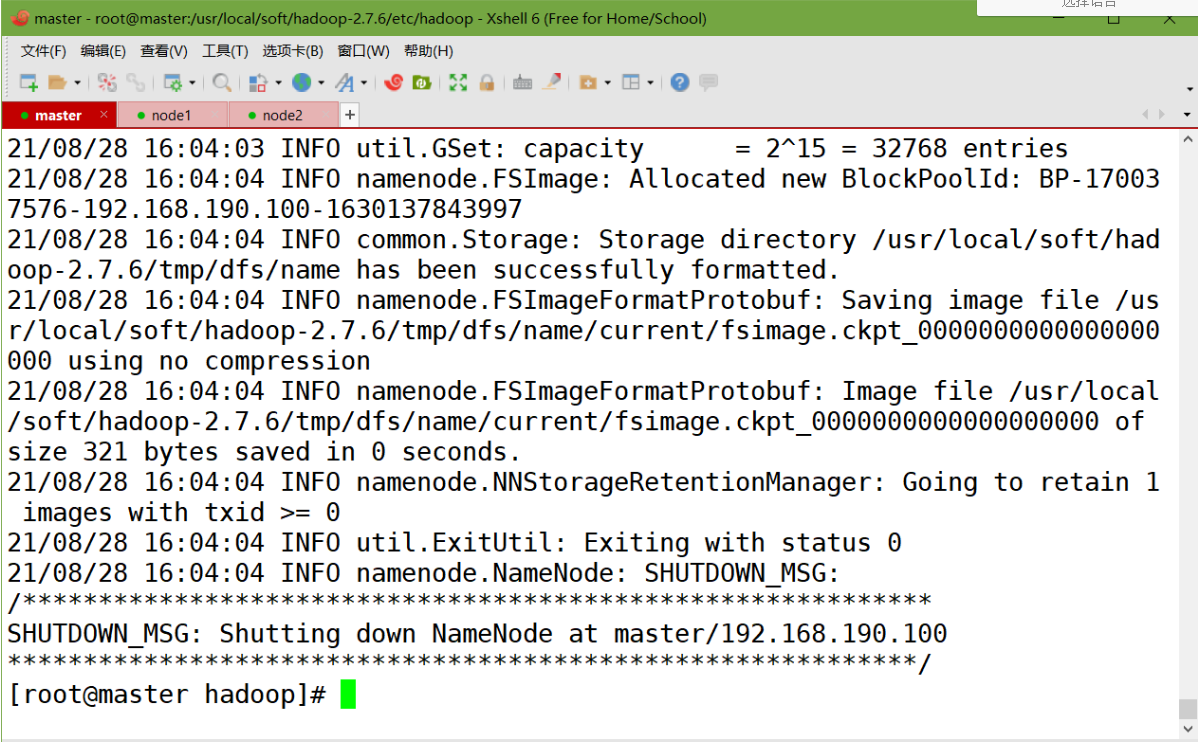

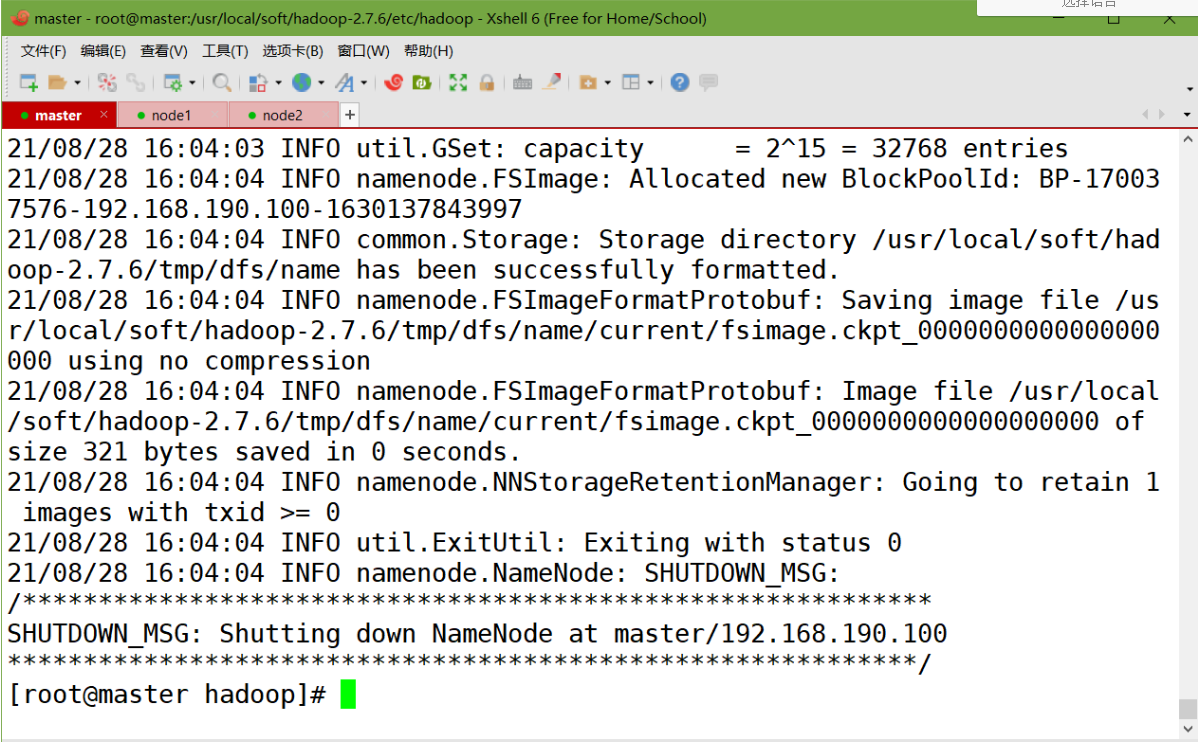

5、格式化namenode(第一次启动的时候需要执行)

hdfs namenode -format

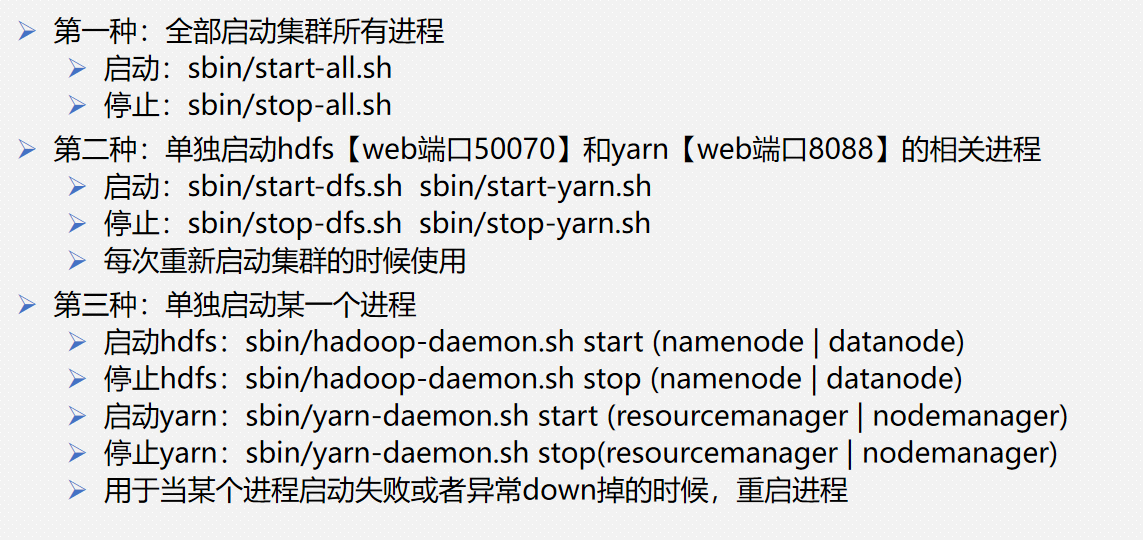

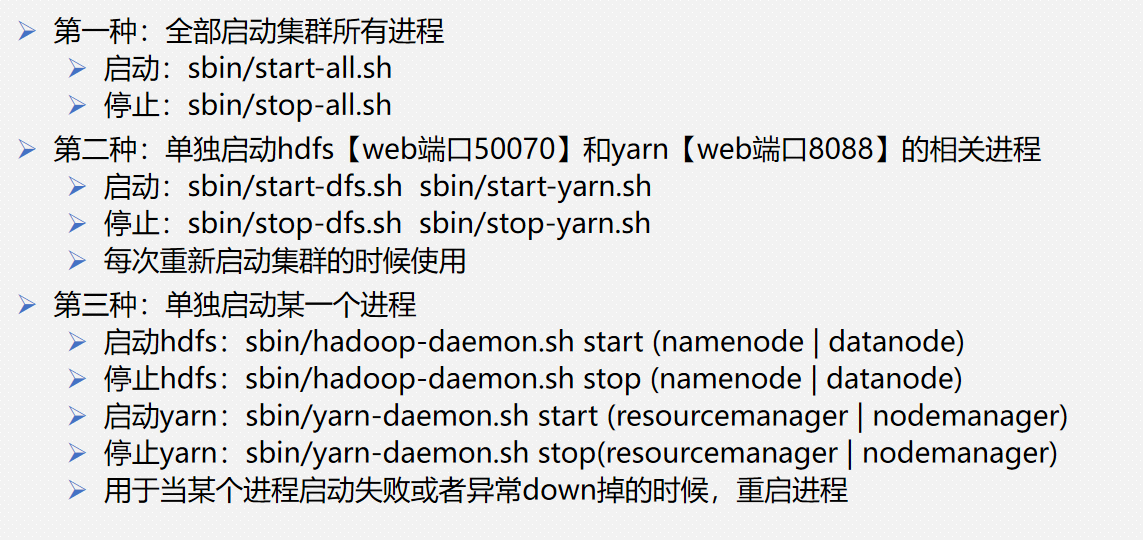

6、启动/关闭Hadoop集群

#启动

start-all.sh

#关闭

stop-all.sh

7、检查master、node1、node2上的进程

master:

[root@master soft]# jps

2597 NameNode

2793 SecondaryNameNode

2953 ResourceManager

3215 Jps

#由于我们在配置Hadoop的时候并没有设置主节点的备用节点

#所以这里的SecondaryNameNode并不是备用节点的意思

#而是另有用处

node1:

[root@node1 jdk1.8.0_171]# jps

11361 DataNode

11459 NodeManager

11559 Jps

node2:

[root@node2 ~]# jps

11384 DataNode

11482 NodeManager

11582 Jps

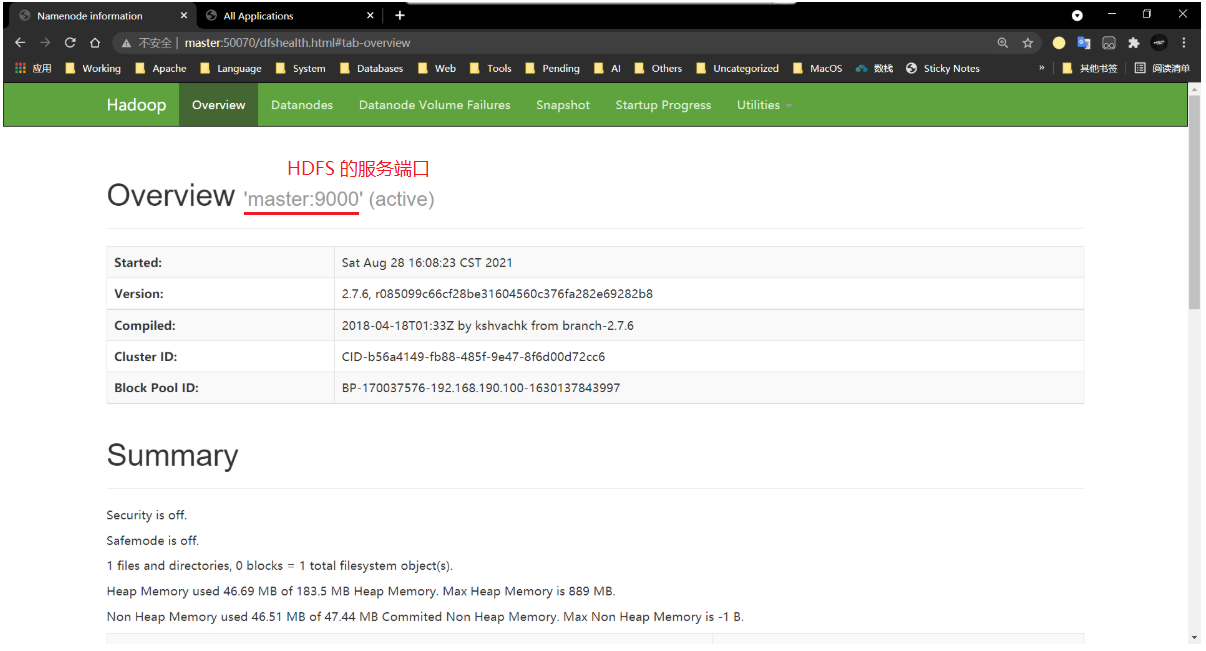

8、访问HDFS的WEB界面

http://master:50070

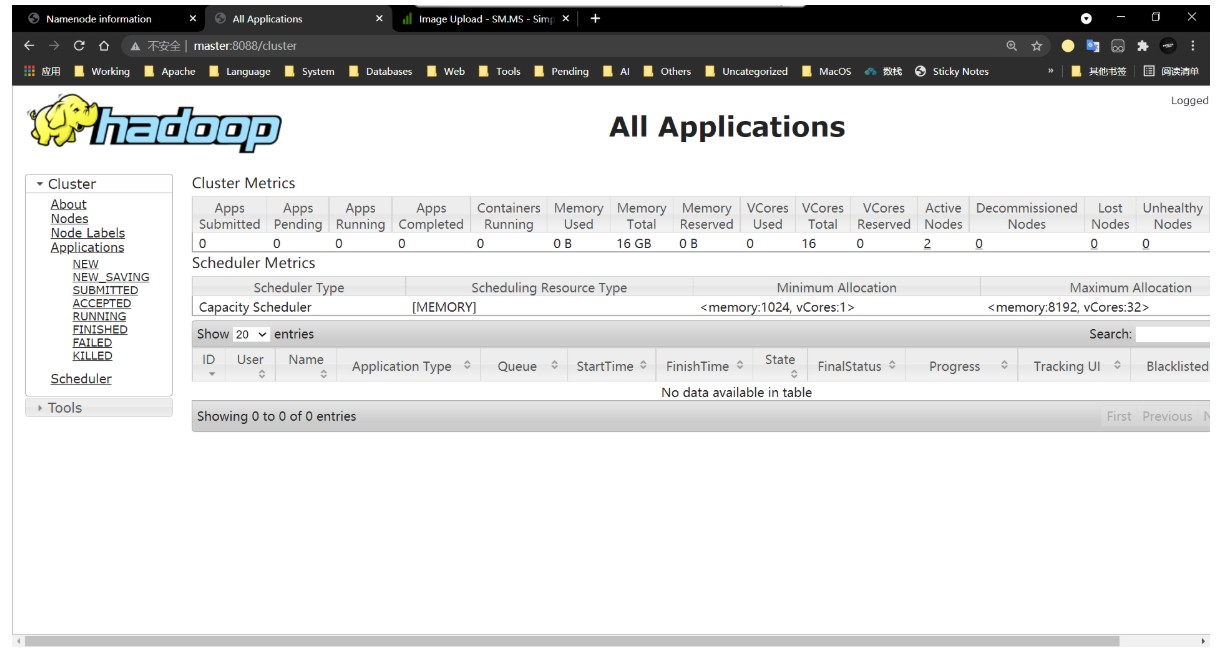

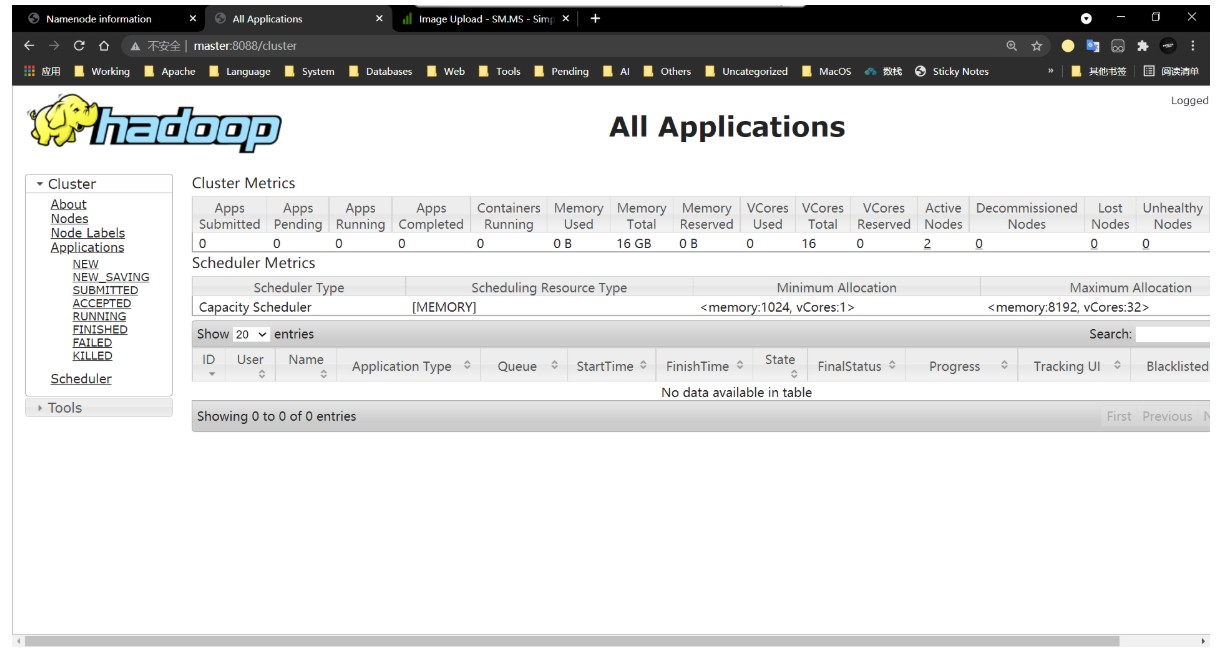

9、访问YARN的WEB界面

http://master:8088

Hadoop常用命令