配置分布式集群环境 Distributed Cluster System(多台虚拟机)hadoop 不成功

首先配置初始化虚拟机

sudo apt-get install openjdk-8-jdk

加上Hadoop-daemon.sh start datanode 否则无法启动

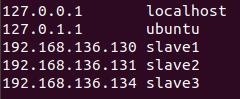

在/etc/hosts 配置slave host,要保证主机与slave 不重名,机器名称在/etc/hostname中修改

$ ssh-keygen -t rsa NOTE: Leave file name and other things blank. $ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys $ chmod 0600 ~/.ssh/authorized_keys $ ssh localhost

详细的步骤

https://www.cnblogs.com/jesse123/p/9122114.html

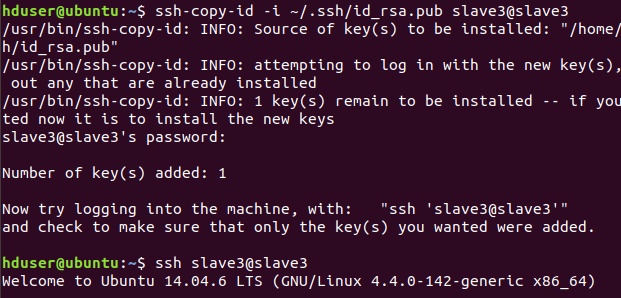

在master上免密码登录slave

ssh-copy-id -i ~/.ssh/id_rsa.pub slave1@slave1

ssh-copy-id -i ~/.ssh/id_rsa.pub slave2@slave2

ssh-copy-id -i ~/.ssh/id_rsa.pub slave3@slave3

显示成功

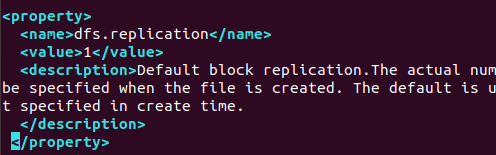

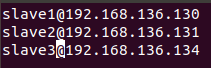

3个datanode

vim /$HADOOP_HOME/etc/hadoop/hdfs-site.xml

将datanode改为3

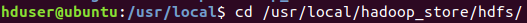

还记得原来我们将namenode 和datanode存在 /usr/local/hadoop_store/hdfs里面

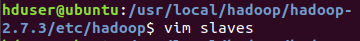

进入修改datanode节点

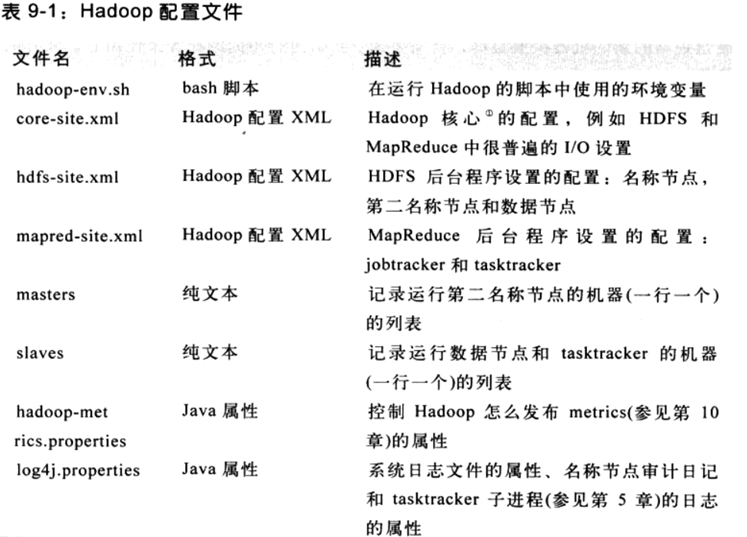

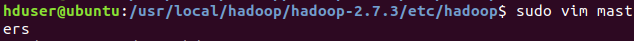

HADOOP the definitive guid 第二版的影印版,在配置hadoop集群中介绍到,其实,masters设置的是运行secondary namenode的结点,并且可以在masters里面设置多个结点来运行secondary namenode。

参考:https://blog.csdn.net/duchang110/article/details/18451145

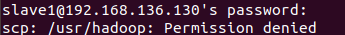

开始拷贝整个hadoop文件

sudo scp -r ./hadoop-2.7.3/ slave1@192.168.136.130:/usr/hadoop

原因是对方主机用户slave1并没有权限

并且对方root用户并没有设置ssh密钥

所以曲线救国

sudo scp -r ./hadoop-2.7.3/ slave1@192.168.136.130:/home/slave1/

成功

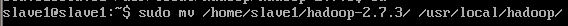

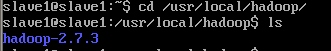

然后从/home/slave1 迁移到 /usr/local/hadoop

成功

成功

安装openjdk8 失败, 由于ubuntu14不支持openjdk8

sudo apt-get install openjdk-8-jdk

故安装openjdk7

配置环境

但是没有datanode

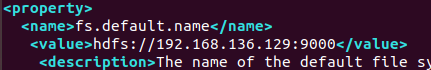

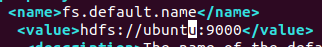

修改 core-site.xml

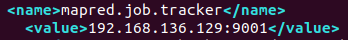

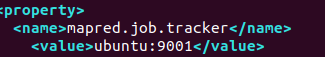

修改mapred-site.xml 设置jobtrack对应节点地址

再启动看看

运行 hadoop namenode –format,会初始化namenode,记录集群元数据,即datanode的信息等。

不成功 还是没有datanode

修改 slave节点只有slave1

增加masters作为secondnamenode节点

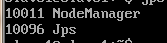

在slave1上同操作

还是不行

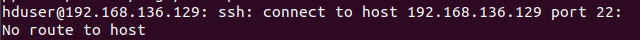

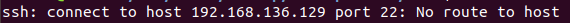

ssh的问题

ssh 192.168.136.129 不成功

ssh ubuntu成功

core-site.xml改成

修改mapred-site.xml

运行

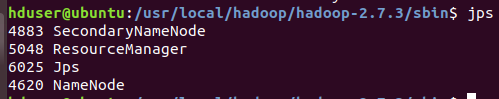

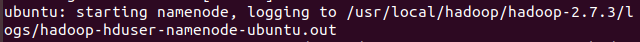

namenode解决了

datanode不出来

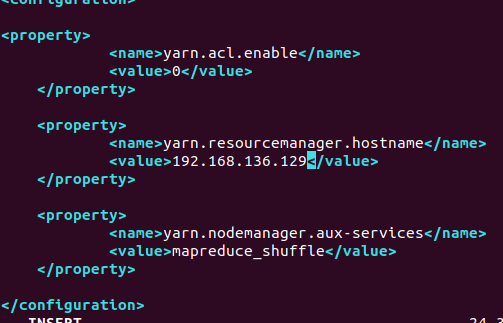

yarn-site.xml

运行

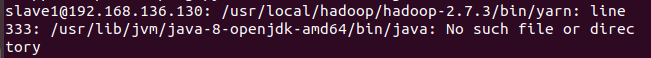

slave机上的版本不一样

重新安装ubuntu 18.0.4在node1上

安装ssh vim net-tool pdsh

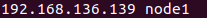

在主机上/etc/hosts 加上node1节点

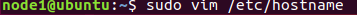

在node1上 修改主机名

修改主机名

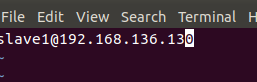

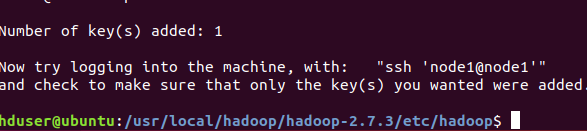

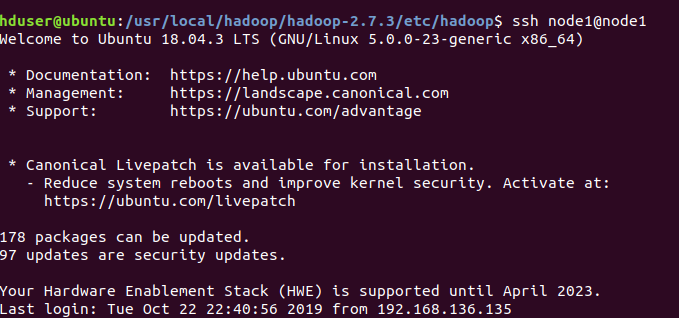

修改成功后重启电脑,从主机ssh node1@node1成功

在/etc/hosts中修改

127.0.1.1 node1

192.168.136.129 ubuntu

192.168.136.130 slave1

192.168.136.131 slave2

192.168.136.134 slave3

主机上修改slave文件,加上node1

sudo vim /usr/local/hadoop/hadoop-2.7.3/etc/hadoop/slave

加上node1@192.168.136.139

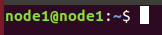

无密钥登录node1

ssh-copy-id -i ~/.ssh/id_rsa.pub node1@node1

成功

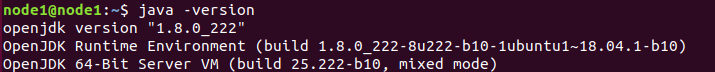

然后在node1上安装java环境

sudo apt-get install openjdk-8-jdk

用java -version查看

成功

至此slave机的环境搭建完毕,至于~/.bashrc 稍后会一起复制

复制hadoop

sudo scp -r /usr/local/hadoop/ node1@node1:/usr/local/

不成功没有权限,曲线救国

sudo scp -r /usr/local/hadoop/ node1@node1:/home/node1/

sudo mv /home/node1/hadoop/ /usr/local/成功

在主机上复制~/.bashrc到node1

scp -r ~/.bashrc node1@node1:~/

成功后重启node1

主机:hadoop namenode -format

/usr/local/hadoop/hadoop-2.7.3/sbin$ start-all.sh

最终不成功