国产大模型 ChatGLM3 应用开发

智谱AI GLM 大模型家族

https://github.com/THUDM

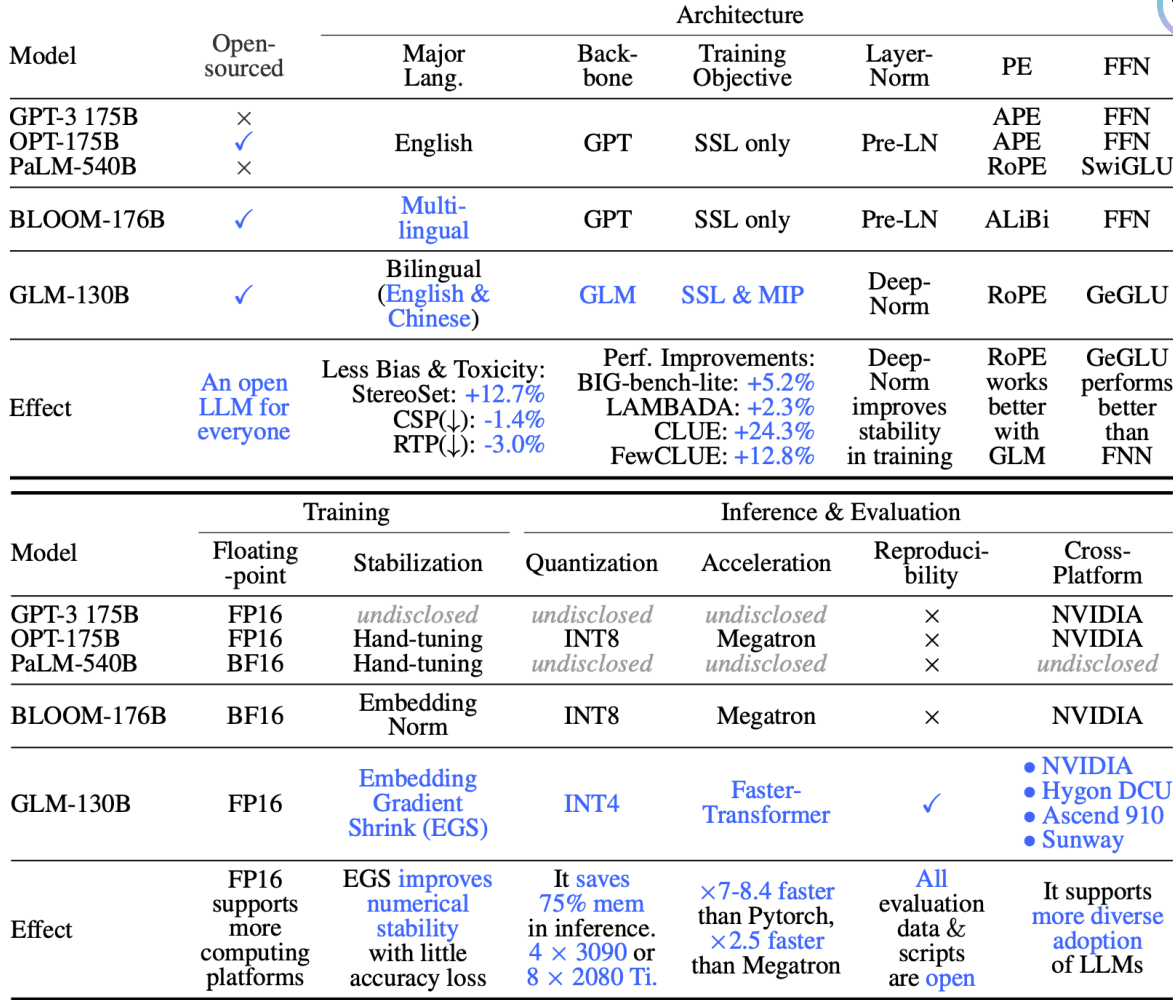

GLM-130B:开源双语大语言模型(ICLR 2023)

双语支持:支持英文和中文。

• 性能(EN):在LAMBADA上比GPT-3 175B(+4.0%)、 OPT-175B(+5.5%)和BLOOM-176B(+13.0%)更好,并 且在MMLU上略优于GPT-3 175B(+0.9%)。

• 性能(CN):在7个零样本CLUE数据集上比ERNIE TITAN 3.0 260B显著提高(+24.26%),并且在5个零样本FewCLUE数据集 上提高了(+12.75%)。

• 快速推理:使用单个A100服务器,在SAT和FasterTransformer 上都支持快速推理(最多快2.5倍)。 • 可复现性:所有结果(30多项任务)可以通过开源代码和模型检 查点轻松复现。

• 跨平台:支持NVIDIA、Hygon DCU、Ascend 910和Sunway的 训练与推理(即将发布)。

千亿规模 大模型对比

GLM-130B 硬件资源需求

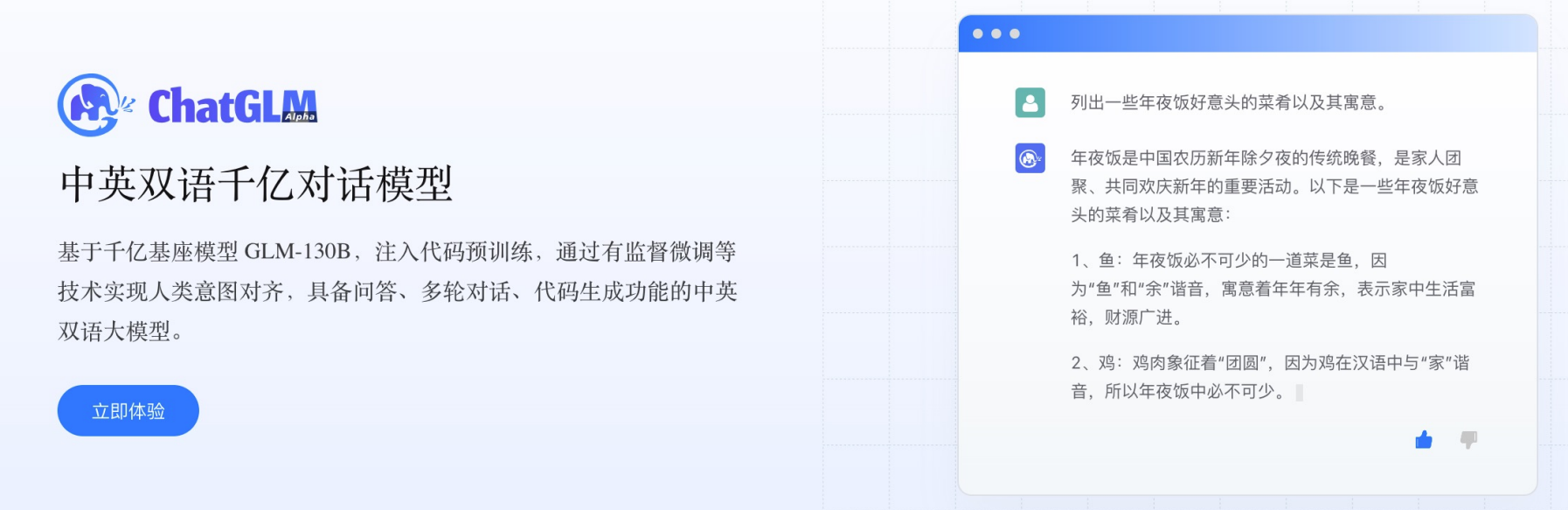

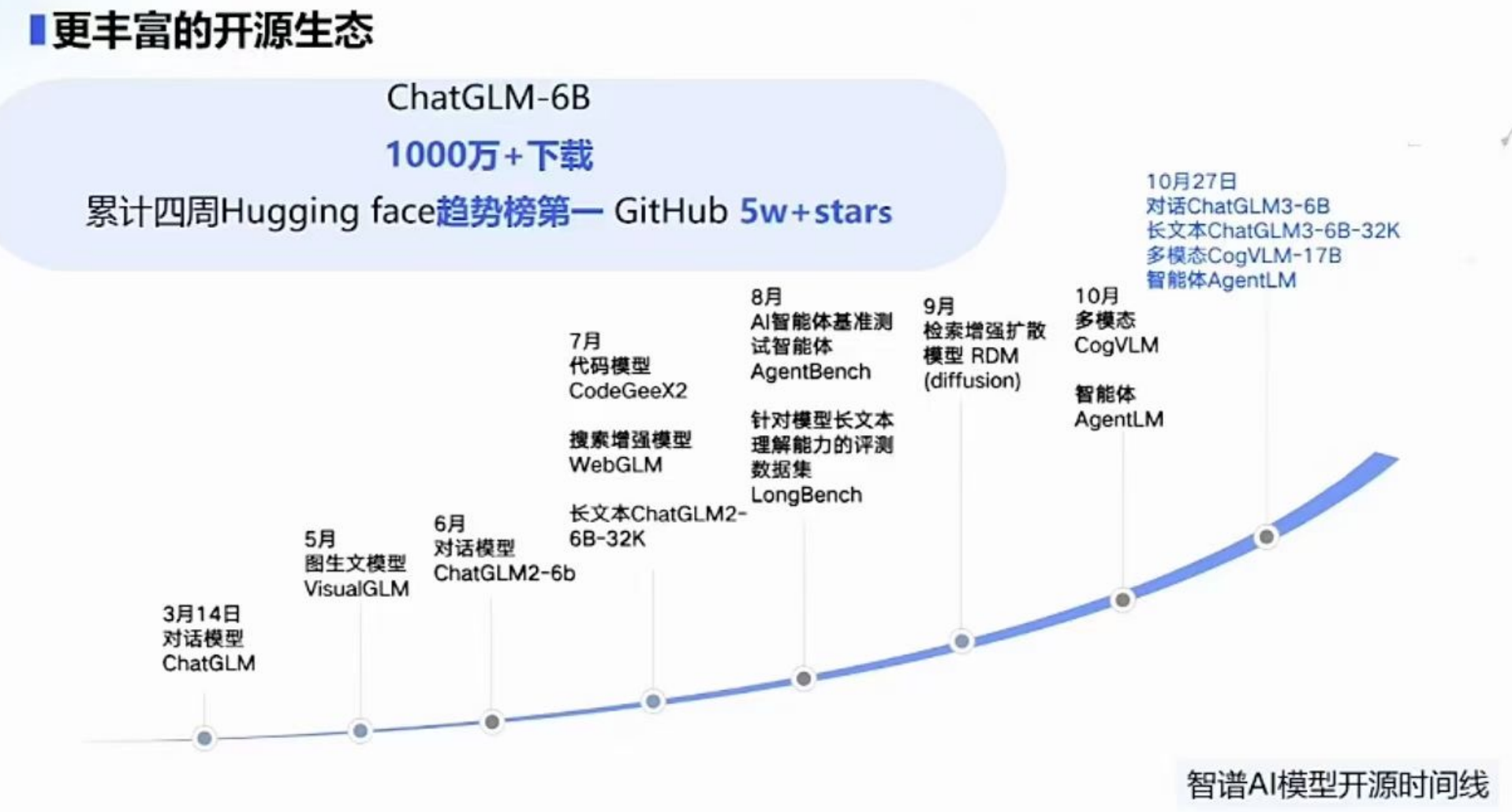

ChatGLM

https://chatglm.cn/

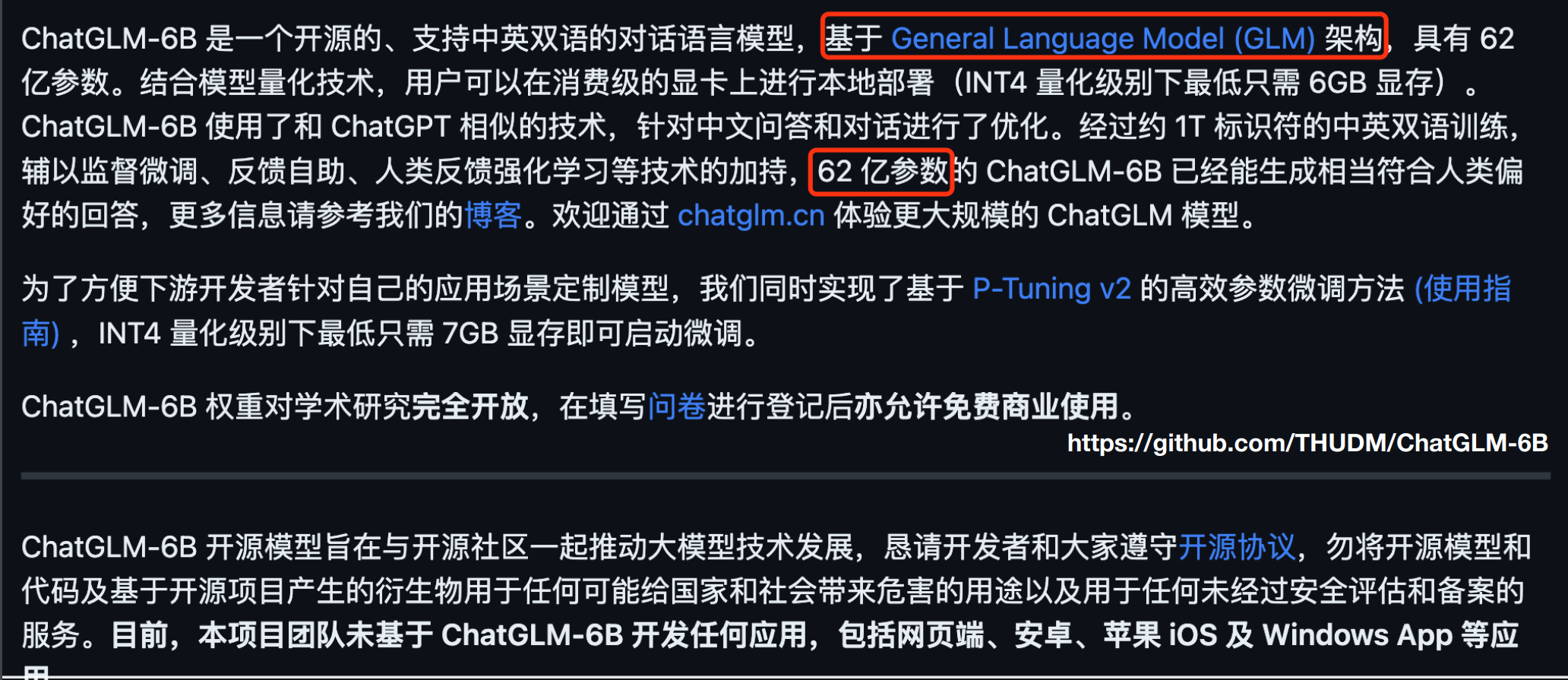

初代开源聊天模型 ChatGLM-6B

https://github.com/THUDM/ChatGLM2-6B

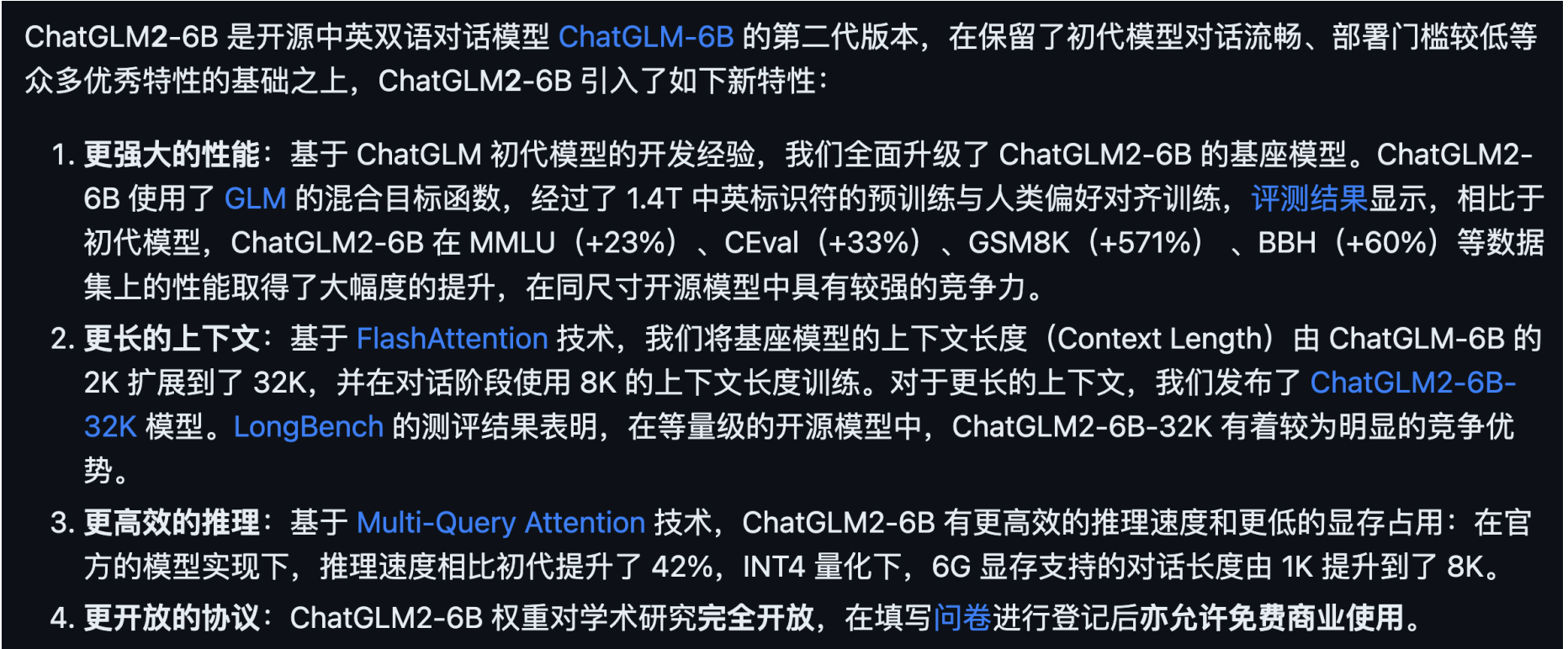

第二代开源聊天模型 ChatGLM2-6B

WebGLM: An Efficient Web-enhanced Question Answering System (KDD 2023)

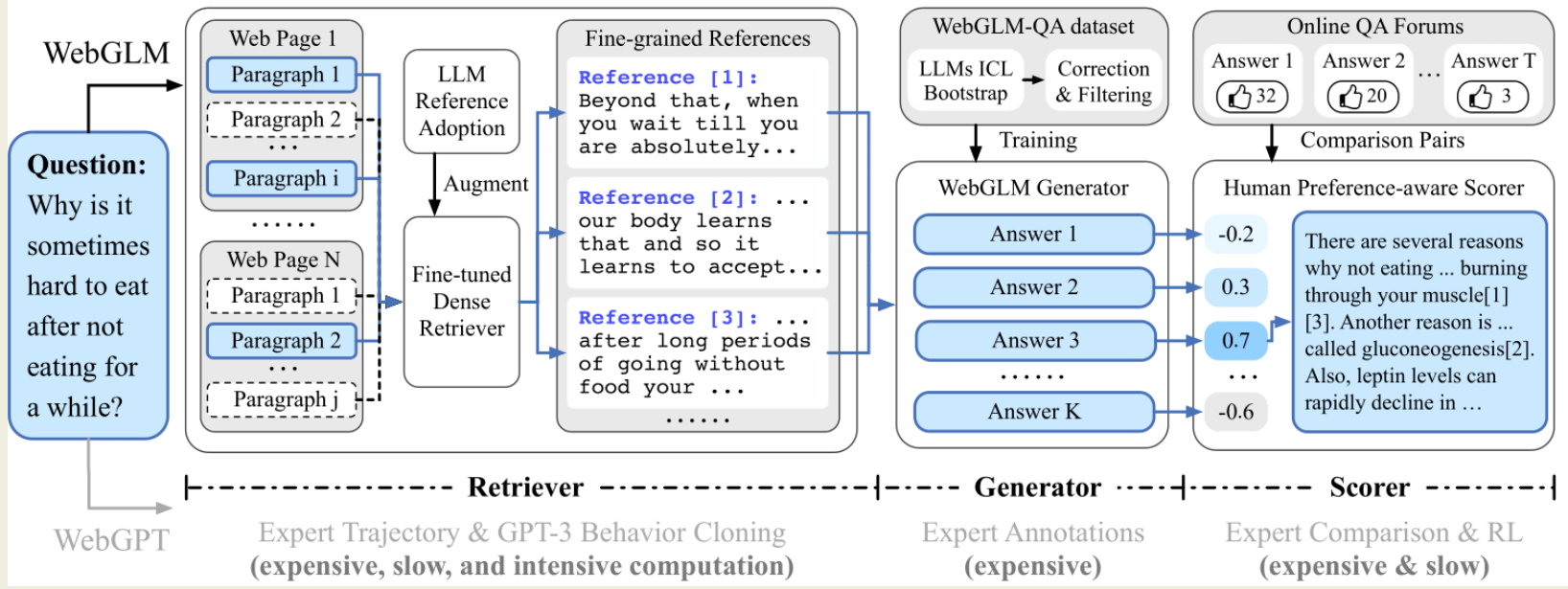

WebGLM旨在利用100亿参数的通用语言模型(GLM)提供高效且具有成本效益的网络增强问答系统。它旨在通过将网 络搜索和检索功能整合到预训练的语言模型中,改善实际应用部署

-

LLM增强型检索器:提高相关网络内容的检索能力,以更准确地回答问题。

-

引导式生成器:利用GLM的能力生成类似人类的问题回答,提供精炼的答案。

-

人类偏好感知评分器:通过优先考虑人类偏好来评估生成回答的质量,确保系统产生有用且吸引人的内容。

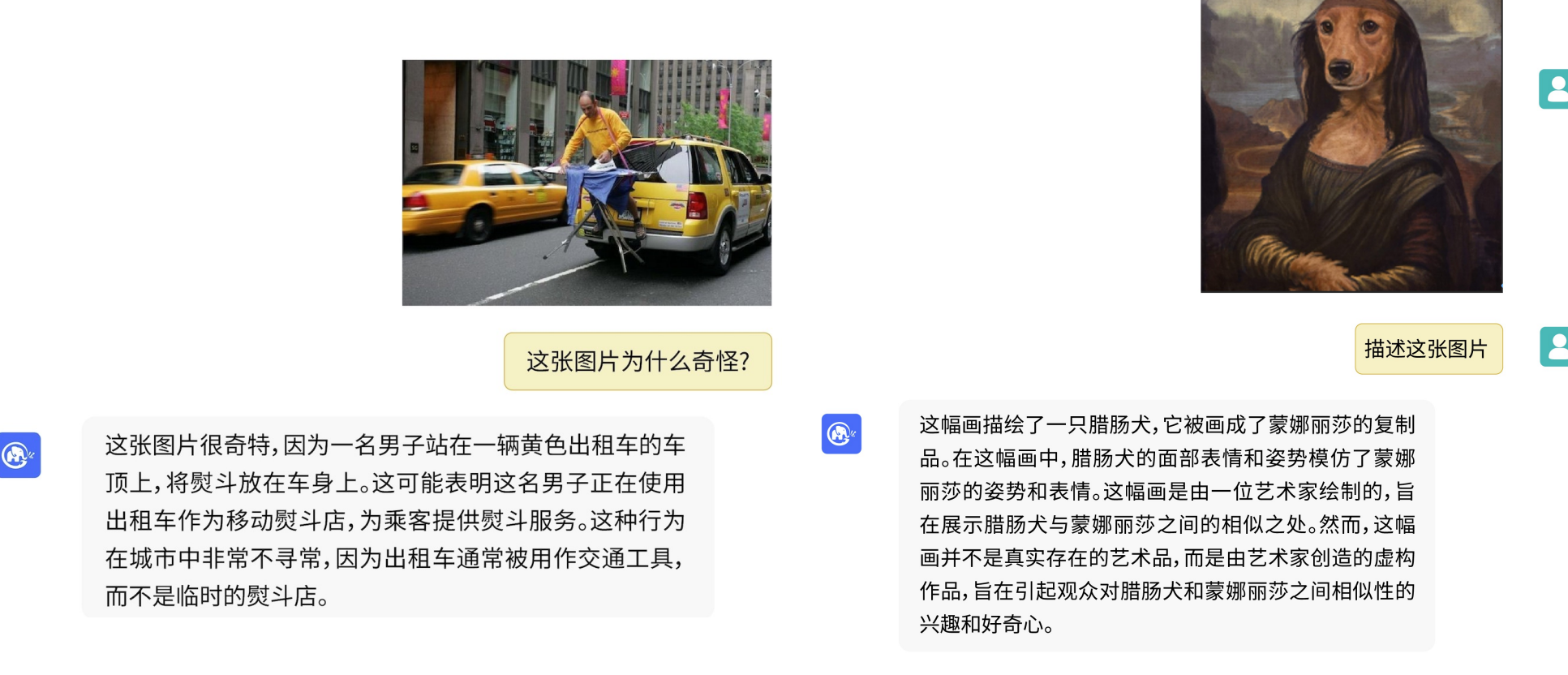

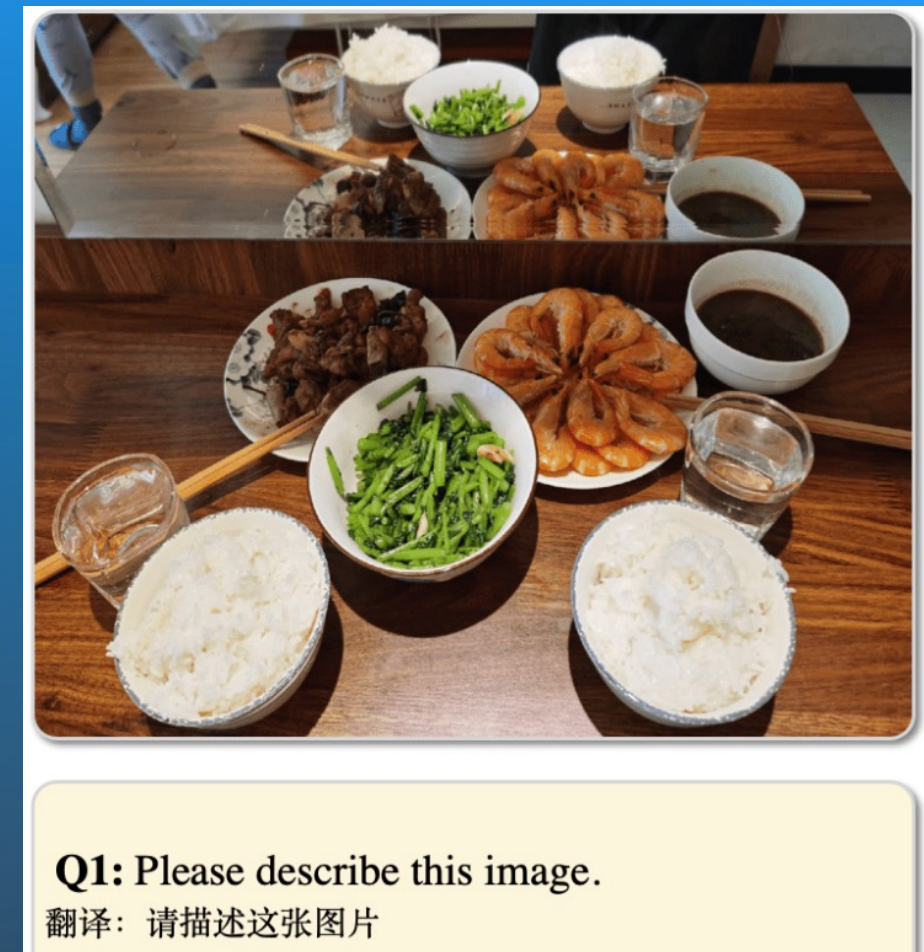

VisualGLM-6B

CogVLM 多模 态预训练模型

https://github.com/THUDM/CogVLM

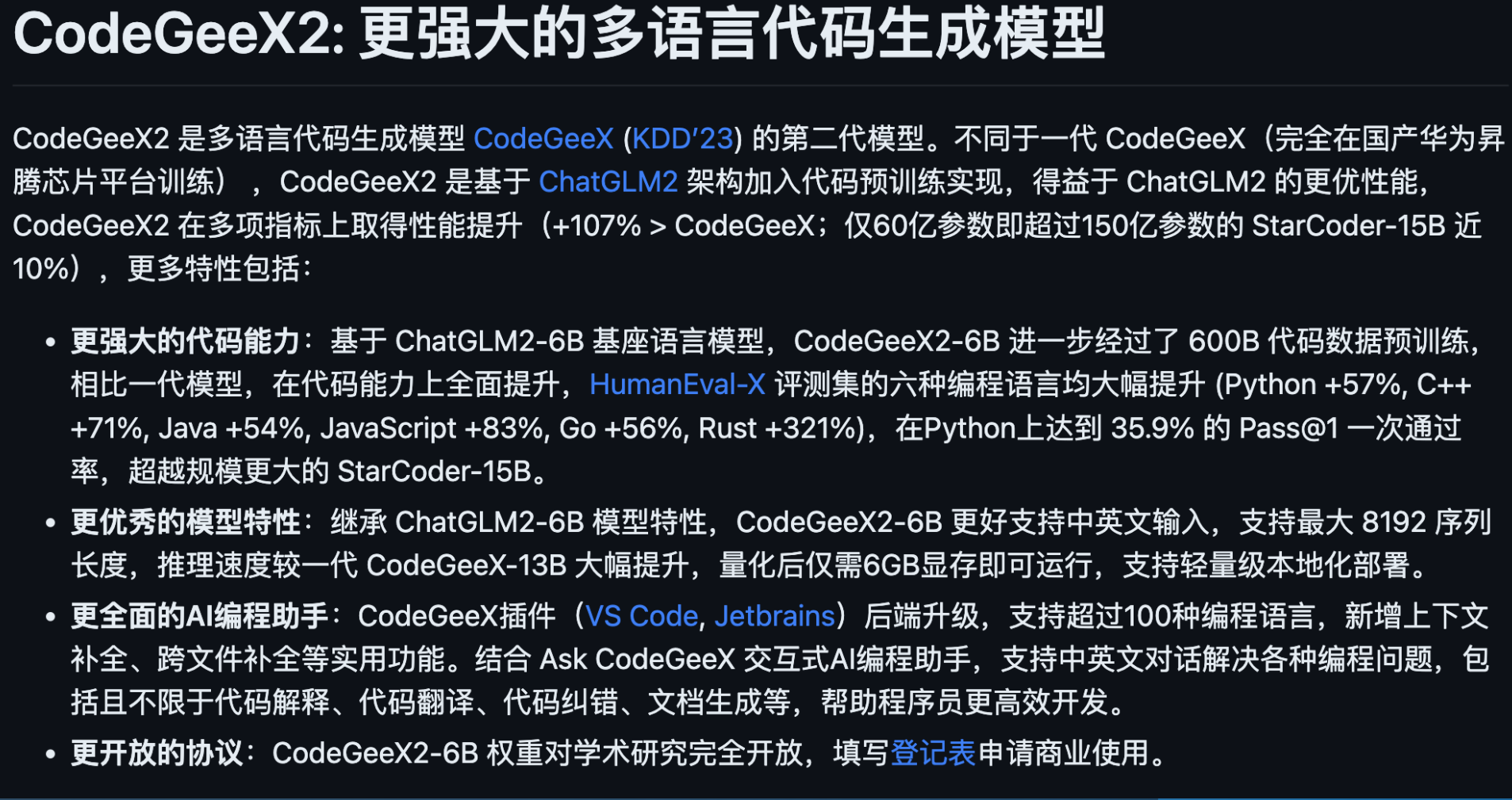

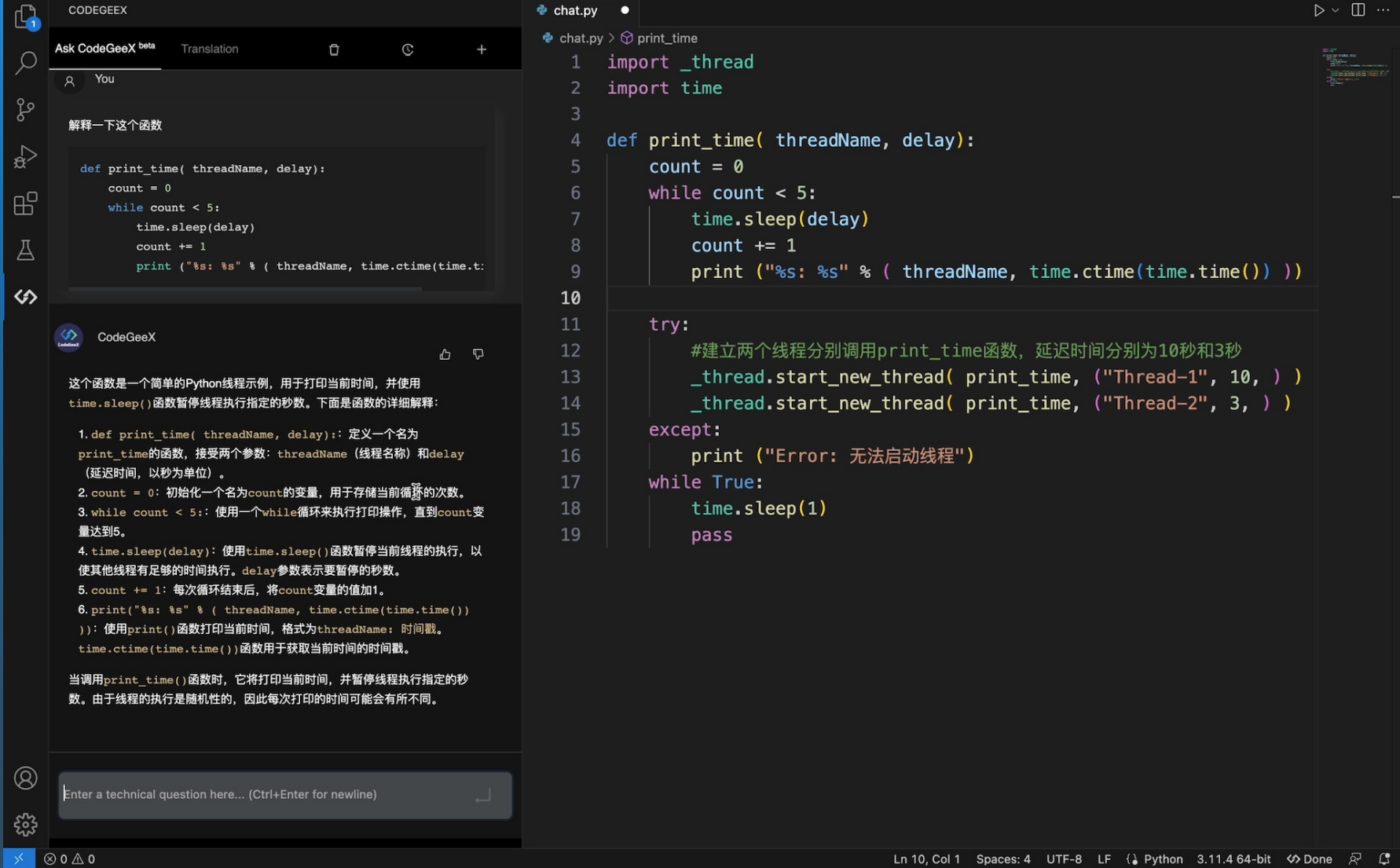

CodeGeeX2

https://github.com/THUDM/CodeGeeX2

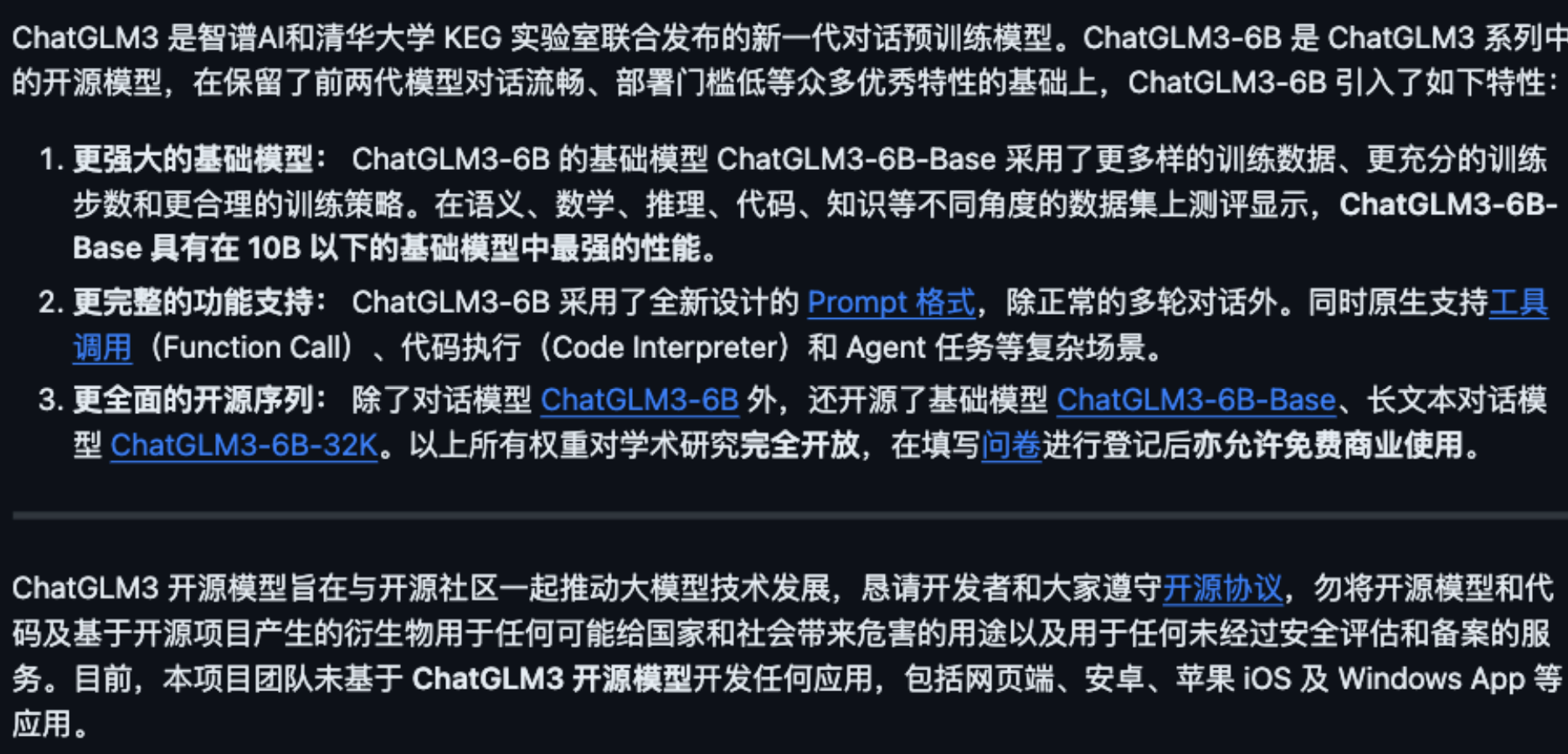

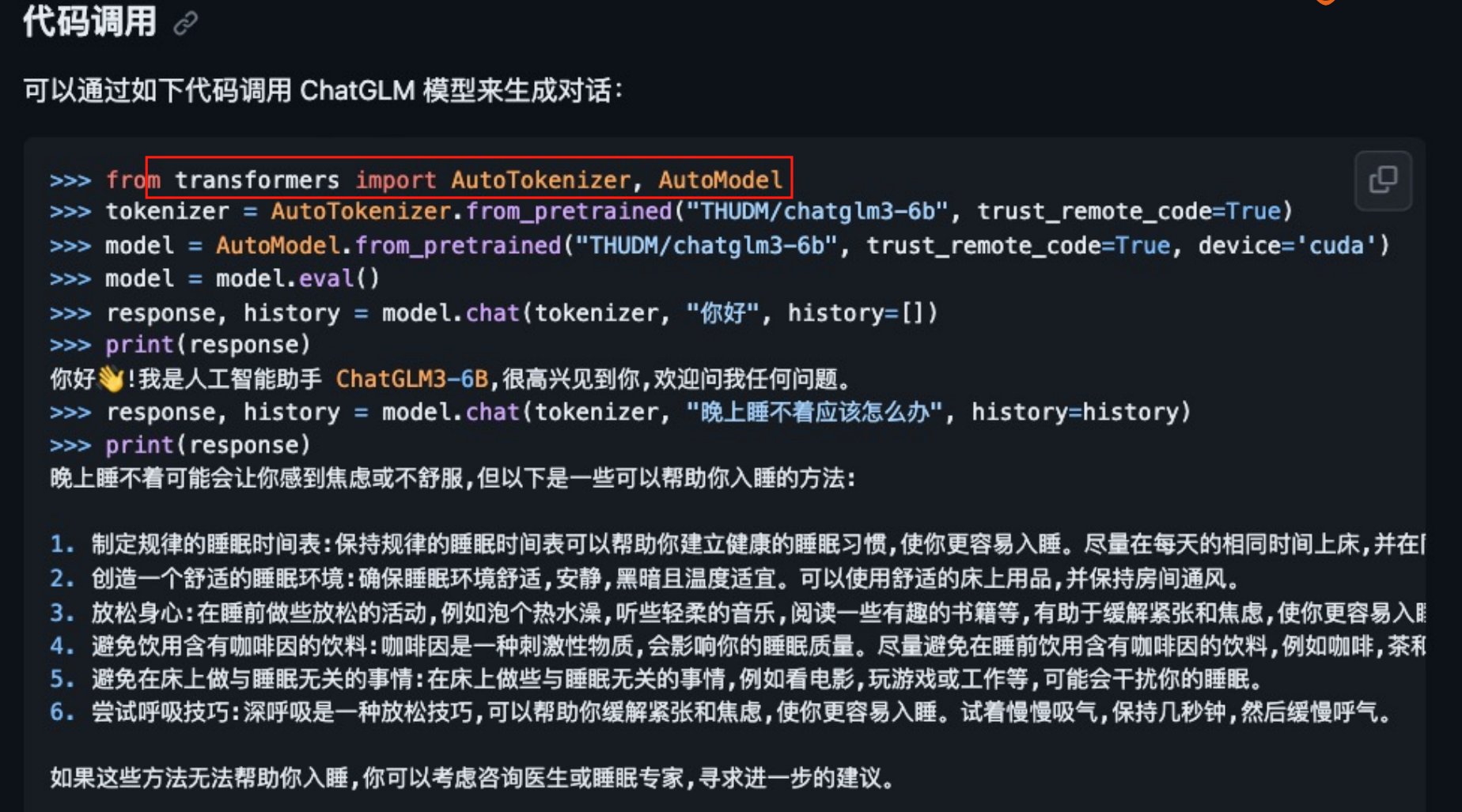

基于 ChatGLM3-6B 大模型应用开发

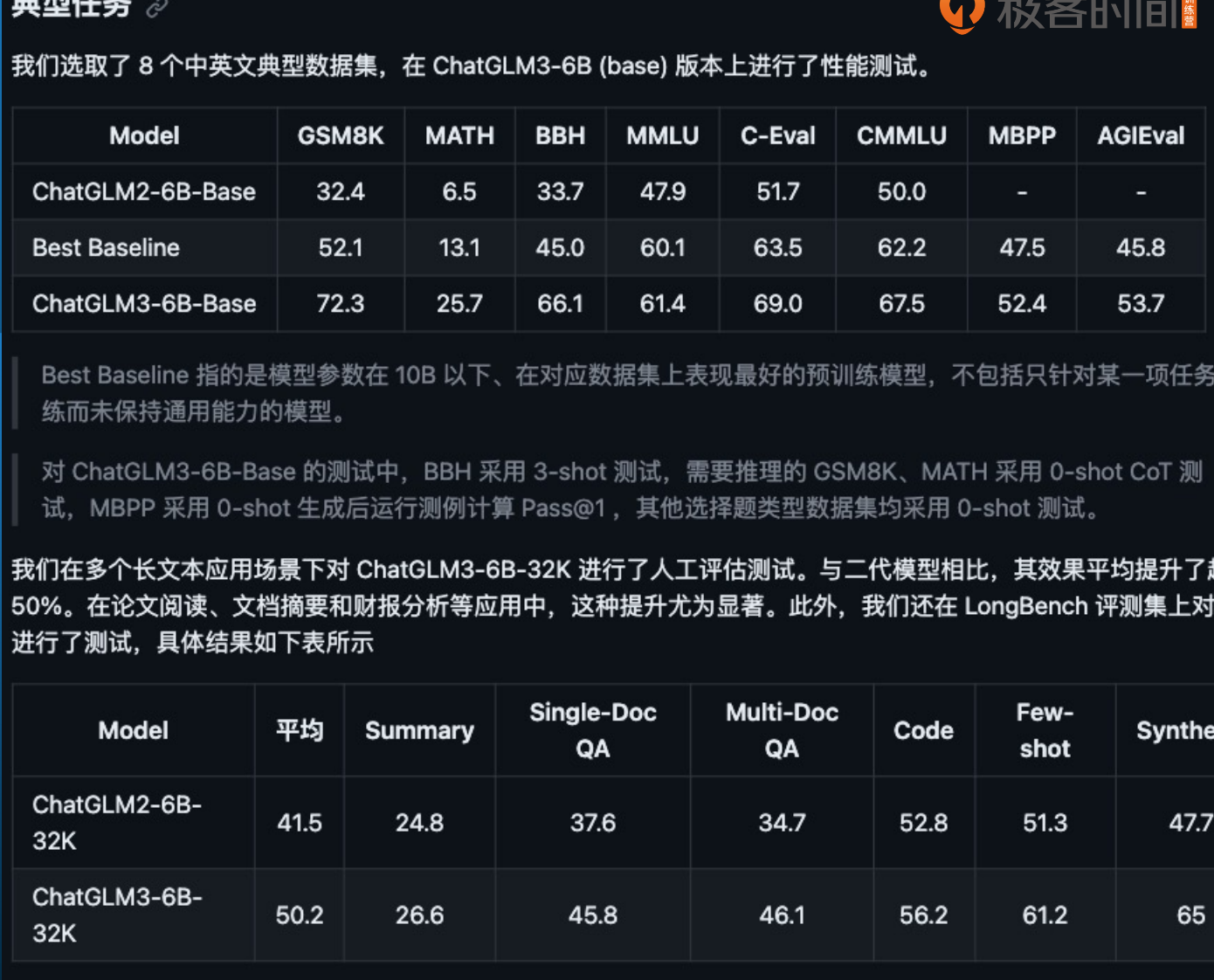

ChatGLM 3 性能提升

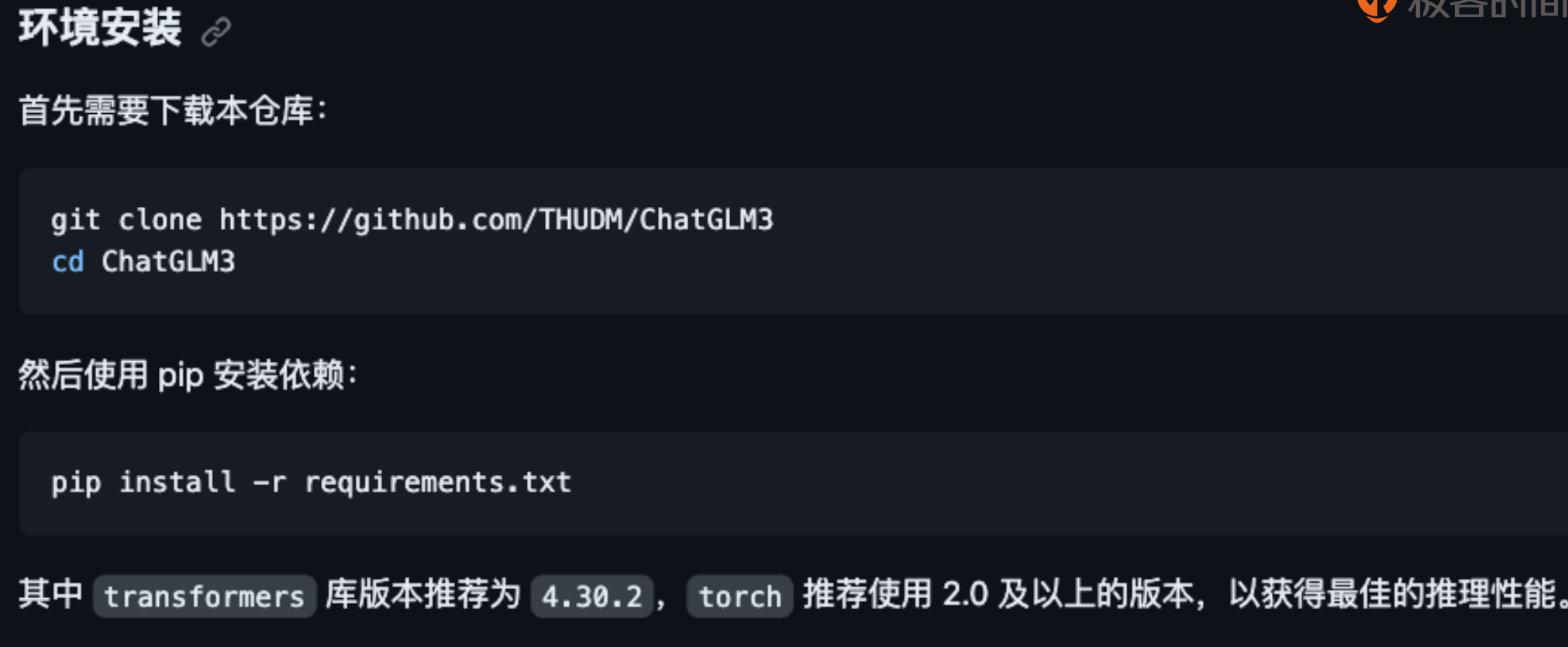

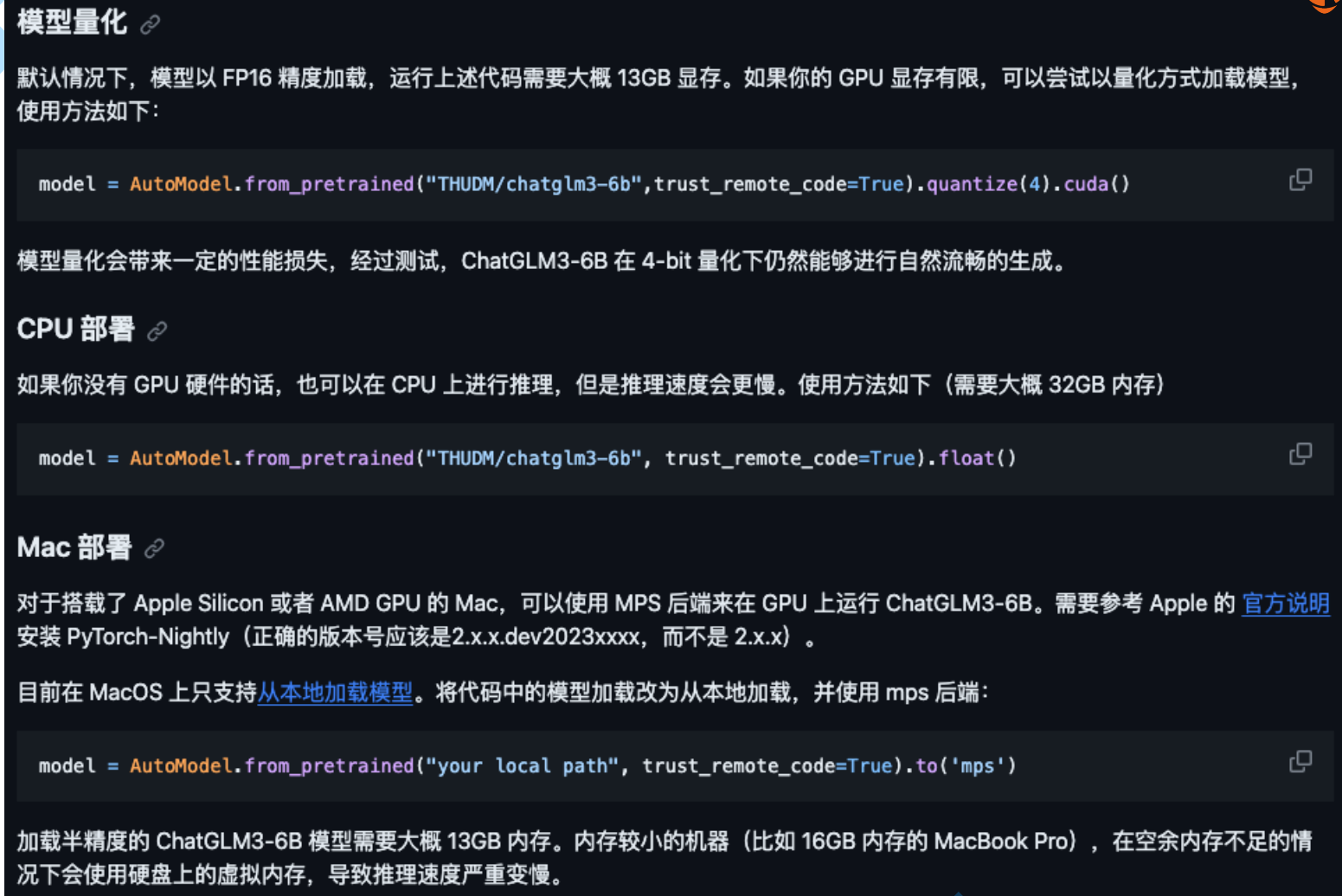

ChatGLM3-6B 私有化部署

LangChain 集成调用

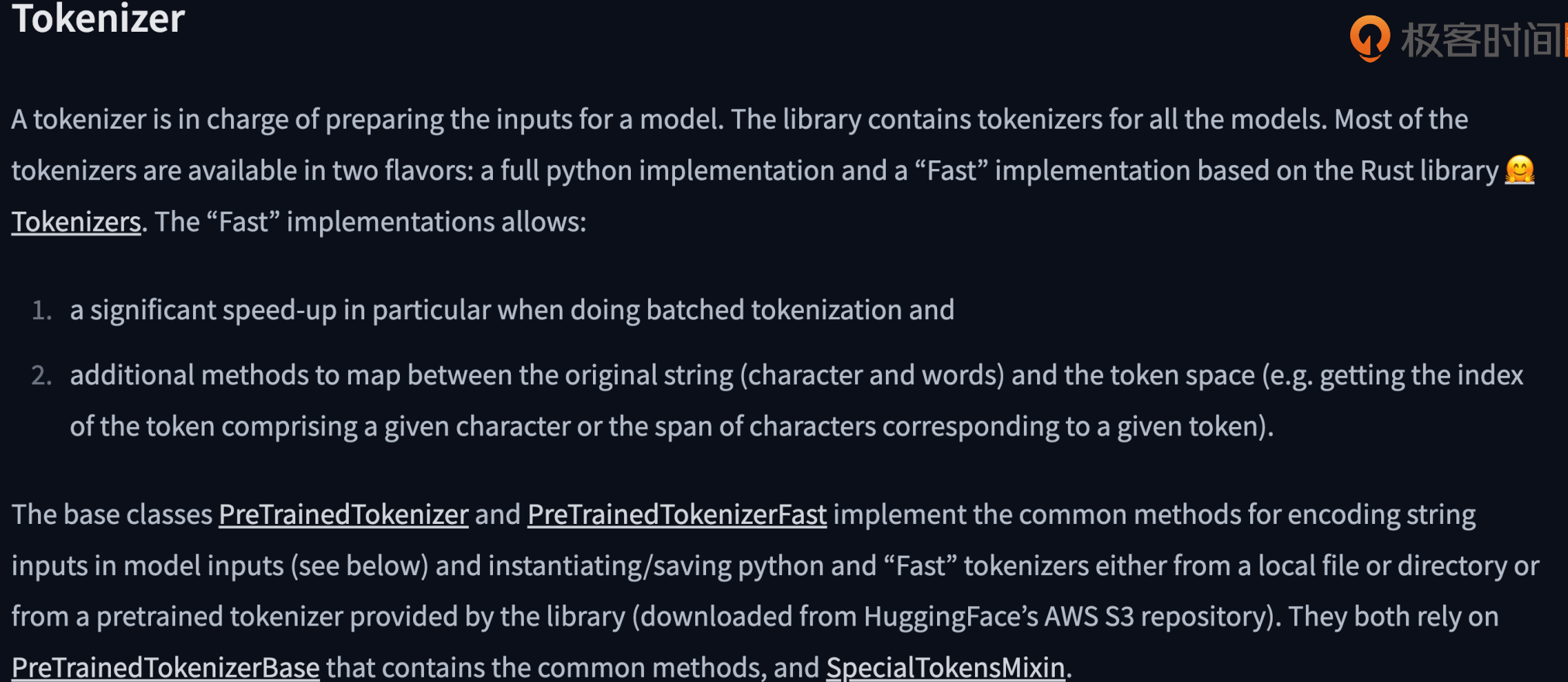

Transformers Tokenizer

https://huggingface.co/docs/transformers/main_classes/tokenizer

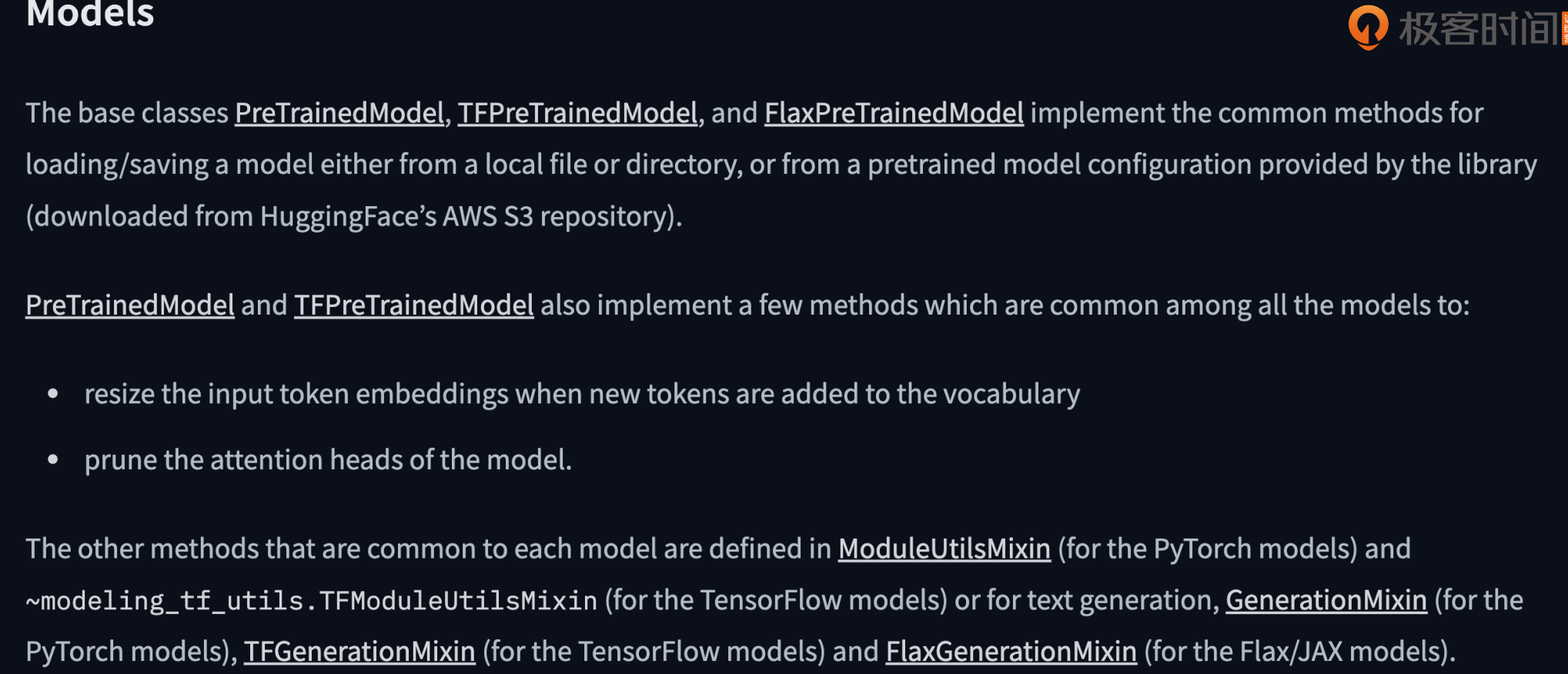

Transformers Model

https://huggingface.co/docs/transformers/main_classes/tokenizer

将模型同步至 Hugging Face

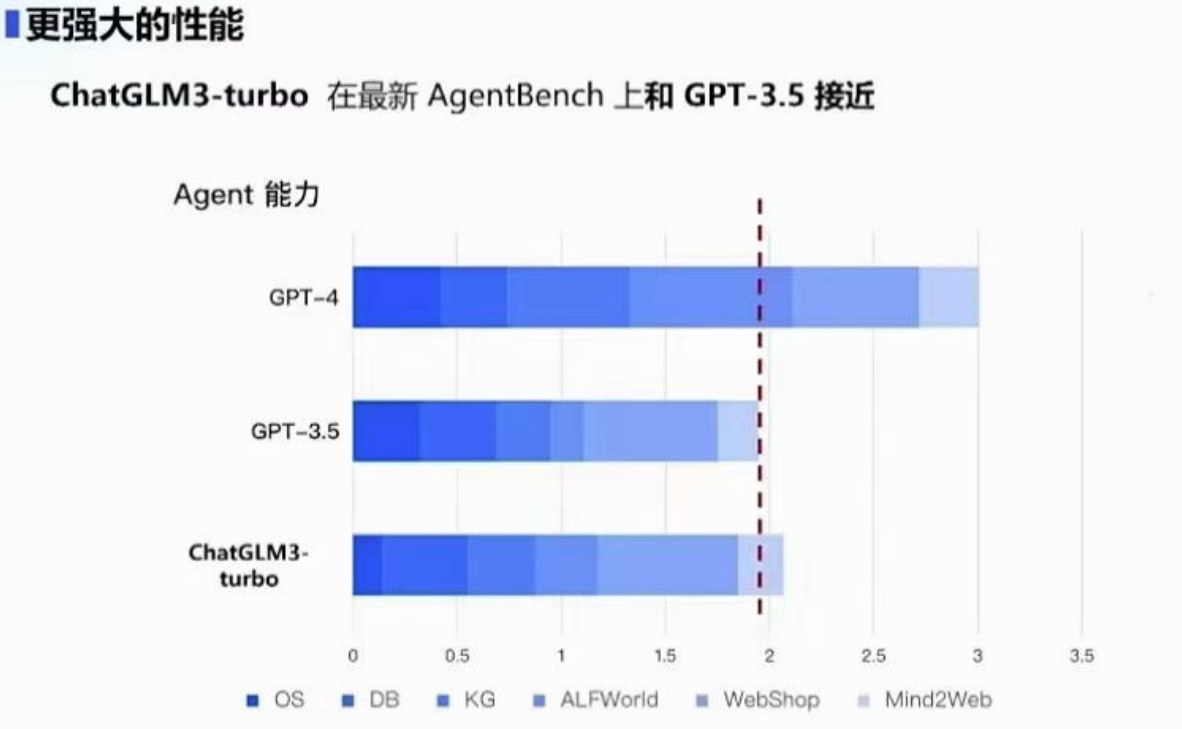

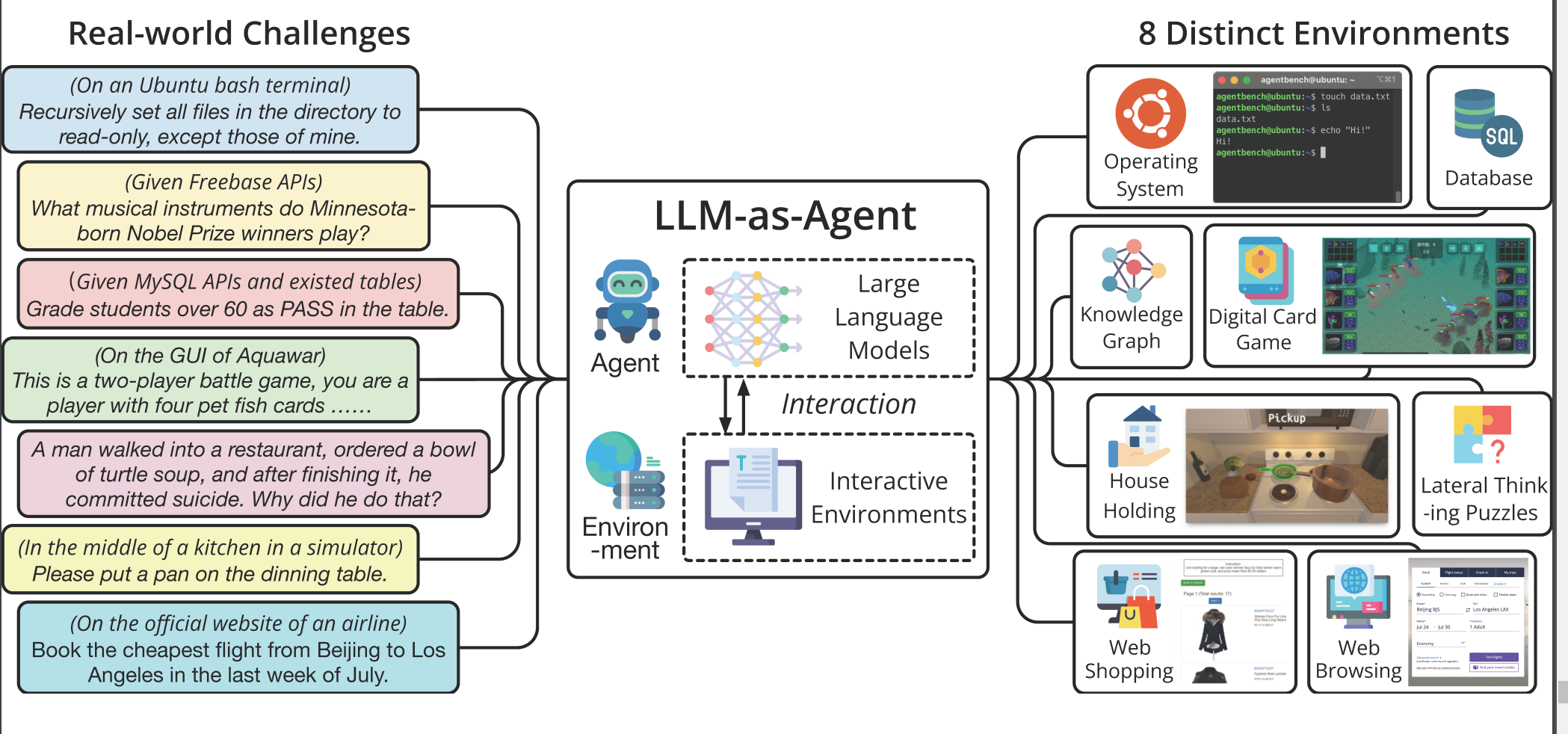

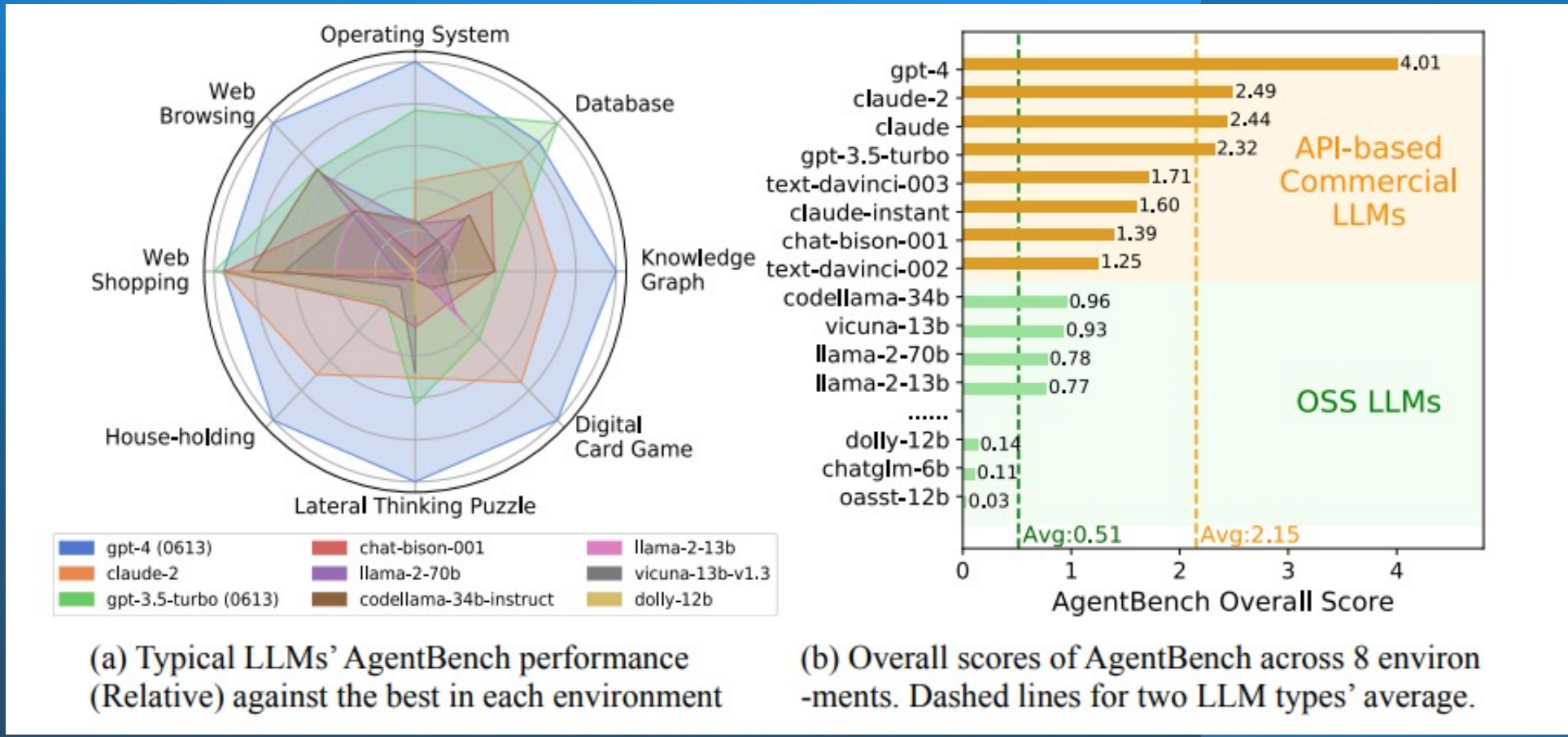

AI 2.0 应用基准测试 AgentBench

LLM-as-Agent

浙公网安备 33010602011771号

浙公网安备 33010602011771号