ElasticSearch之-集群搭建 数据分片

es使用两种不同的方式来发现对方:

-

广播

-

单播

也可以同时使用两者,但默认的广播,单播需要已知节点列表来完成。

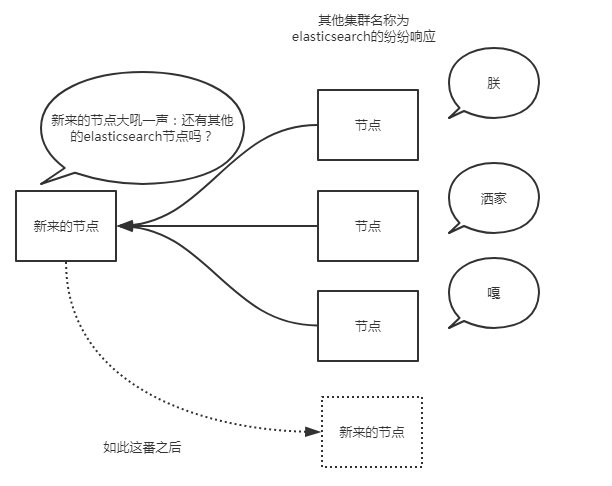

cluster_name对应的elasticsearch。通常而言,广播是个很好地方式。想象一下,广播发现就像你大吼一声:别说话了,再说话我就发红包了!然后所有听见的纷纷响应你。 只要es节点能ping通,自动加入到节点中。

但是,广播也有不好之处,过程不可控。 比如公司内网,每启动一个es就自动加入到节点中,就乱套了。

# 1 在本地单独的目录中,再复制一份elasticsearch文件

# 2 分别启动bin目录中的启动文件

# 3 在浏览器里输入:http://127.0.0.1:9200/_cluster/health?pretty

-通过number_of_nodes可以看到,目前集群中已经有了两个节点了

2 单播方式

elasticsearch.yml

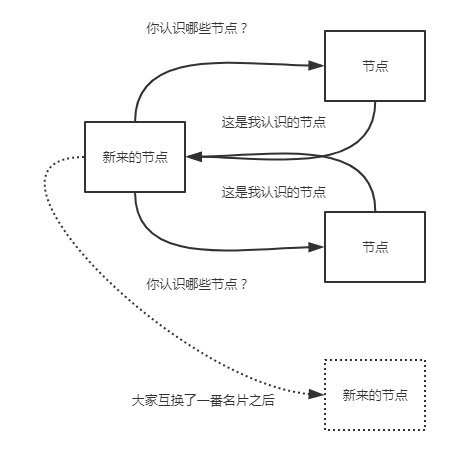

discovery.zen.ping.unicast.hosts: ["10.0.0.1", "10.0.0.3:9300", "10.0.0.6[9300-9400]"]大家就像交换微信名片一样,相互传传就加群了.....

一般的,我们没必要关闭单播发现,如果你需要广播发现的话,配置文件中的列表保持空白即可。

#现在,我们为这个集群增加一些单播配置,打开各节点内的\config\elasticsearch.yml文件。每个节点的配置如下(原配置文件都被注释了,可以理解为空,我写好各节点的配置,直接粘贴进去,没有动注释的,出现问题了好恢复):

#1 elasticsearch1节点,,集群名称是my_es1,集群端口是9300;节点名称是node1,监听本地9200端口,可以有权限成为主节点和读写磁盘(不写就是默认的)。

cluster.name: my_es1

node.name: node1

network.host: 127.0.0.1

http.port: 9200

transport.tcp.port: 9300

discovery.zen.ping.unicast.hosts: ["127.0.0.1:9300", "127.0.0.1:9302", "127.0.0.1:9303", "127.0.0.1:9304"]

# 2 elasticsearch2节点,集群名称是my_es1,集群端口是9302;节点名称是node2,监听本地9202端口,可以有权限成为主节点和读写磁盘。

cluster.name: my_es1

node.name: node2

network.host: 127.0.0.1

http.port: 9202

transport.tcp.port: 9302

node.master: true # 有权成为主节点

node.data: true # 有权读写磁盘

discovery.zen.ping.unicast.hosts: ["127.0.0.1:9300", "127.0.0.1:9302", "127.0.0.1:9303", "127.0.0.1:9304"]

# 3 elasticsearch3节点,集群名称是my_es1,集群端口是9303;节点名称是node3,监听本地9203端口,可以有权限成为主节点和读写磁盘。

cluster.name: my_es1

node.name: node3

network.host: 127.0.0.1

http.port: 9203

transport.tcp.port: 9303

discovery.zen.ping.unicast.hosts: ["127.0.0.1:9300", "127.0.0.1:9302", "127.0.0.1:9303", "127.0.0.1:9304"]

# 4 elasticsearch4节点,集群名称是my_es1,集群端口是9304;节点名称是node4,监听本地9204端口,仅能读写磁盘而不能被选举为主节点。

cluster.name: my_es1

node.name: node4

network.host: 127.0.0.1

http.port: 9204

transport.tcp.port: 9304

node.master: false # 不能成为主节点

node.data: true

discovery.zen.ping.unicast.hosts: ["127.0.0.1:9300", "127.0.0.1:9302", "127.0.0.1:9303", "127.0.0.1:9304"]

由上例的配置可以看到,各节点有一个共同的名字my_es1,但由于是本地环境,所以各节点的名字不能一致,我们分别启动它们,它们通过单播列表相互介绍,发现彼此,然后组成一个my_es1集群。谁是老大则是要看谁先启动了!

discovery.zen.minimum_master_nodes: 3一般的规则是集群节点数除以2(向下取整)再加一。比如3个节点集群要设置为2。这么着是为了防止脑裂(split brain)问题。

4 什么是脑裂

为了防止脑裂,我们对该集群设置参数:

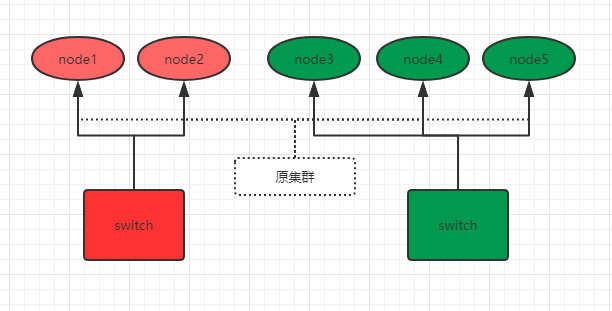

discovery.zen.minimum_master_nodes: 3 # 3=5/2+1node1,由于网络和负荷等原因,原集群被分为了两个switch:node1 、2和node3、4、5。因为minimum_master_nodes参数是3,所以node3、4、5可以组成集群,并且选举出了主节点node3。而node1、2节点因为不满足minimum_master_nodes条件而无法选举,只能一直寻求加入集群(还记得单播列表吗?),要么网络和负荷恢复正常后加入node3、4、5组成的集群中,要么就是一直处于寻找集群状态,这样就防止了集群的脑裂问题。 除了设置minimum_master_nodes参数,有时候还需要设置node_master参数,比如有两个节点的集群,如果出现脑裂问题,那么它们自己都无法选举,因为都不符合半数以上。这时我们可以指定node_master,让其中一个节点有资格成为主节点,另外一个节点只能做存储用。当然这是特殊情况。

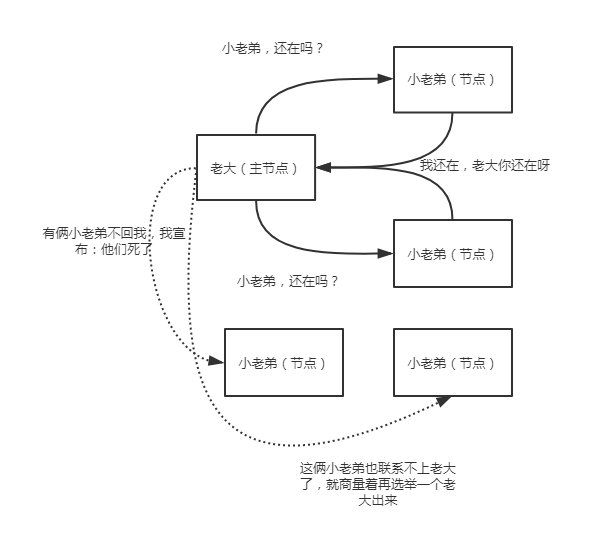

那么,主节点是如何知道某个节点还活着呢?这就要说到错误识别了。

但是,怎么看?多久没联系算是失联?这些细节都是可以设置的,不是一拍脑门子,就说某个小老弟挂了!在配置文件中,可以设置:

discovery.zen.fd.ping_interval: 1

discovery.zen.fd.ping_timeout: 30

discovery_zen.fd.ping_retries: 3每个节点每隔`discovery.zen.fd.ping_interval`的时间(默认1秒)发送一个ping请求,等待`discovery.zen.fd.ping_timeout`的时间(默认30秒),并尝试最多`discovery.zen.fd.ping_retries`次(默认3次),无果的话,宣布节点失联,并且在需要的时候进行新的分片和主节点选举。根据开发环境,适当修改这些值。