ubuntu安装spark

1、下载spark:http://spark.apache.org/downloads.html

进入:https://archive.apache.org/dist/spark/

安装spark

前提环境:scala、jdk1.8及以上

1、在家目录创建目录spark

mkdir spark

2、将spark移动到创建的目录,并解压

mv spark-2.2.0-bin-hadoop2.7.tgz spark

tar -zvxf spark-2.2.0-bin-hadoop2.7.tgz

3、打开/etc/profile,或者 ~/.bashrc 配置环境变量

sudo vim /etc/profile

或者:

sudo vim ~/.bashrc

在最后添加配置内容

export SPARK_HOME=/home/yzh/spark/spark-2.2.0-bin-hadoop2.7

export PATH=${SPARK_HOME}/bin:$PATH

使配置生效

source /etc/profile

或者:

source ~/.bashrc

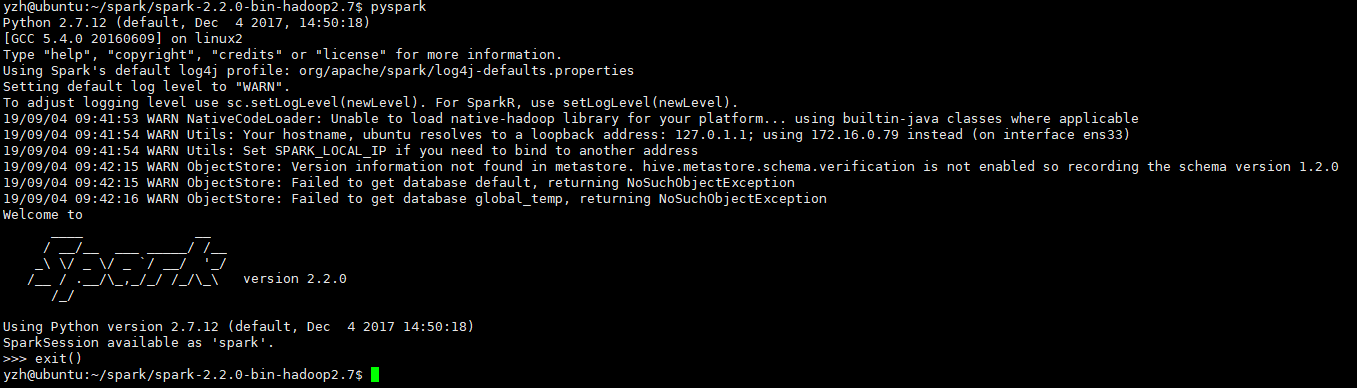

之后,执行

pyspark

通过Ctrl+D 或者 exit() 进行退出。