书生·浦语大模型全链路开源体系——学习笔记day2&day3--纯纯新手入门

学习链接:tutorial/helloworld/hello_world.md at main · InternLM/tutorial (github.com) 【精彩,照着做就能体验很多本来遥不可及的东西】

笔记分享链接:https://github.com/InternLM/tutorial/discussions/37

本笔记定位是对学习链接的补充和小白发牢骚,希望大佬能愿意点评一下,还有和刚入门的朋友们一起交流。

上回说到,俺是纯新手,先记录一些小白特有的体会:

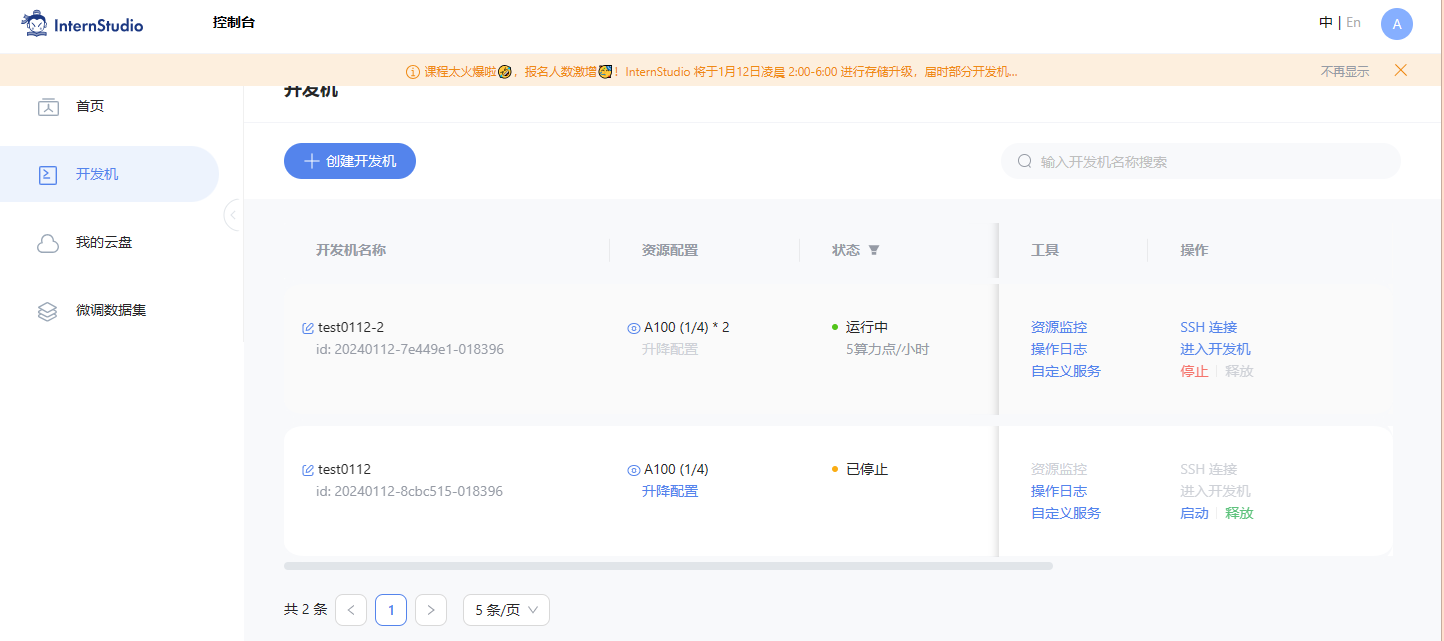

1、平台给的算力很充足。一开始很忐忑学得慢会不会浪费算力的时间,但是一步一步照着做,仔细看,其实一节课三四小时就够了。而目前为止,平台送了快20个小时。

2、云平台界面既简洁又完美。简洁的网站,完美的jupyter、终端、vscode三合一。day2主要使用jupyter和终端,所以不用担心平台不熟悉。感觉比colab好用。

说完初见印象,下面是学习过程

3、在终端界面,每个程序执行完会跳出格式为(XXX)XXX:XXX# 的句子,提示输入下一句,如果没跳出来,就等待他运行,或者ctrl+C停止,或者关了重开。下面就是等待的样子,不要像我这样干等着或者还没运行完就输入新句子。此外,粘贴键有shift+insert。如果ctrl+V用不了可以试试。

4、本地的powershell也是这样的,当输入链接命令后,就没有任何反应了。原来没有反应就表示他已经连上了。后来把intern的云主机关掉以后,本地链接自动断了,才提示说它断了。第一次用还犹豫了一会,难道这就成功了吗?

ssh -CNg -L 6006:127.0.0.1:6006 root@ssh.intern-ai.org.cn -p 34887

4、感觉学习的核心就是部署和使用,部署的话就是尽量复刻大佬的办法,避开潜在的坑。使用就是入门者最关心好奇的问题了,

做第四个的时候遇到的问题:

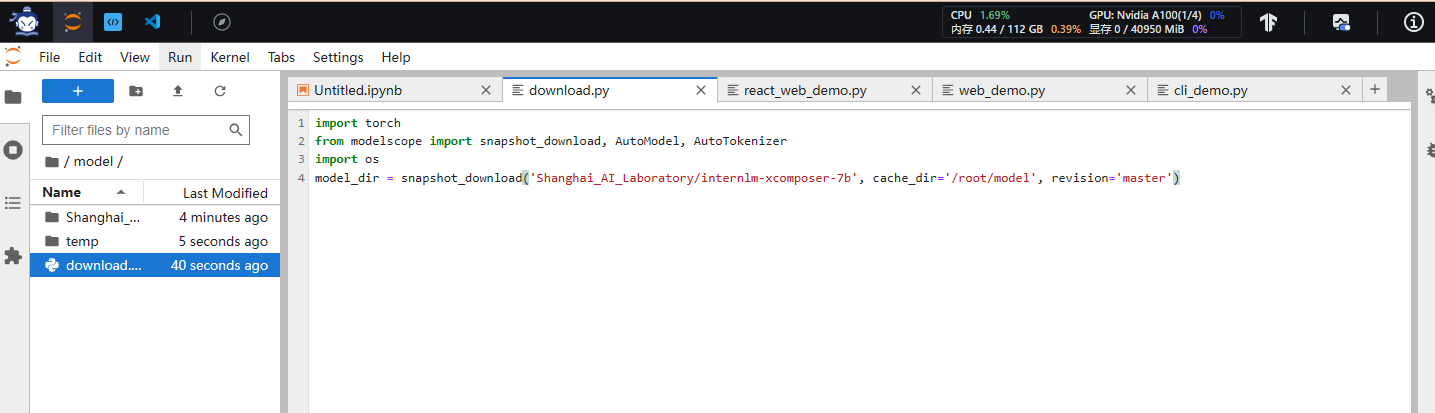

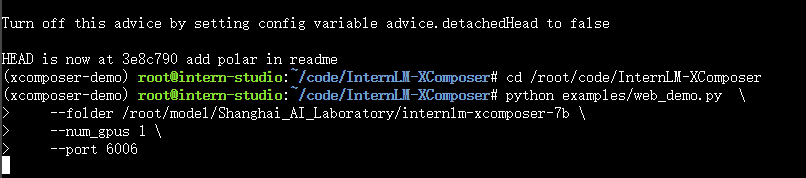

第四个项目快速复制

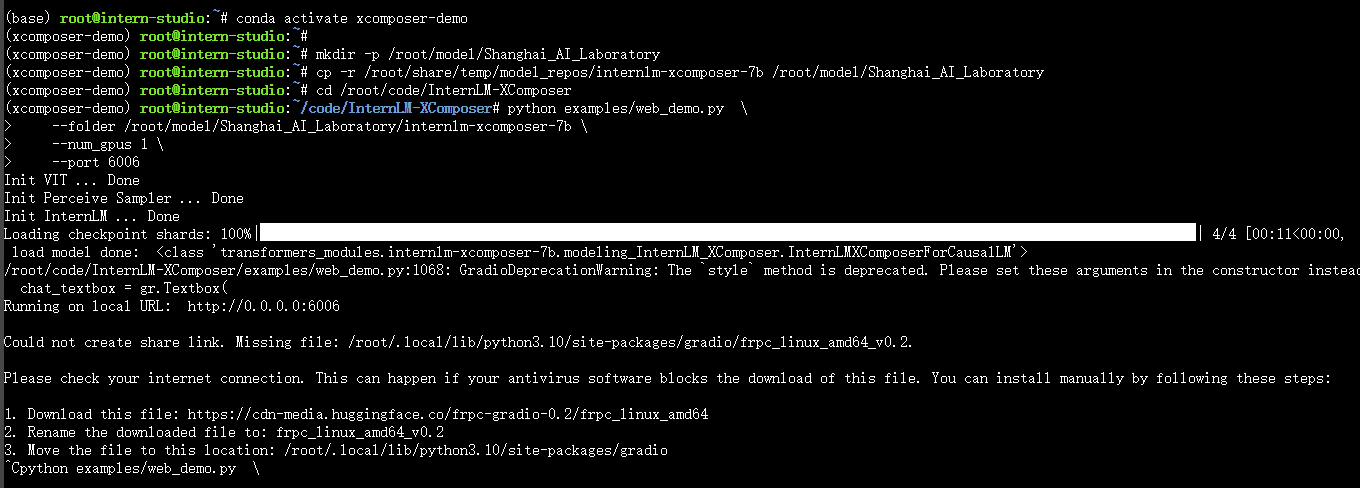

conda activate xcomposer-demo mkdir -p /root/model/Shanghai_AI_Laboratory cp -r /root/share/temp/model_repos/internlm-xcomposer-7b /root/model/Shanghai_AI_Laboratory cd /root/code/InternLM-XComposer python examples/web_demo.py \ --folder /root/model/Shanghai_AI_Laboratory/internlm-xcomposer-7b \ --num_gpus 1 \ --port 6006

lass 'transformers_modules.internlm-xcomposer-7b.modeling_InternLM_XComposer.InternLMXComposerForCausalLM'>

/root/code/InternLM-XComposer/examples/web_demo.py:1068: GradioDeprecationWarning: The `style` method is deprecated. Please set these arguments in the constructor instead.

chat_textbox = gr.Textbox(

Running on local URL: http://0.0.0.0:6006

Could not create share link. Missing file: /root/.local/lib/python3.10/site-packages/gradio/frpc_linux_amd64_v0.2.

Please check your internet connection. This can happen if your antivirus software blocks the download of this file. You can install manually by following these steps:

1. Download this file: https://cdn-media.huggingface.co/frpc-gradio-0.2/frpc_linux_amd64

2. Rename the downloaded file to: frpc_linux_amd64_v0.2

3. Move the file to this location: /root/.local/lib/python3.10/site-packages/gradio

方便复制2:

conda activate internlm-demo

cd /root/code/InternLM

ssh -CNg -L 6006:127.0.0.1:6006 root@ssh.intern-ai.org.cn -p 34887

ssh -CNg -L 6006:127.0.0.1:6006 root@ssh.intern-ai.org.cn -p 34890

bash

conda activate internlm-demo # 首次进入 vscode 会默认是 base 环境,所以首先切换环境

cd /root/code/InternLM

streamlit run web_demo.py --server.address 127.0.0.1 --server.port 6006

按照教程的步骤做,就做出来一个回答问题的机器人。挺好玩的,虽然说话比较慢,但是能写python代码。让它手撕平衡树。

day3的作业:部署一个知识库

整个流程大概是:

下载文本文件,主要是txt和md,作为数据库。

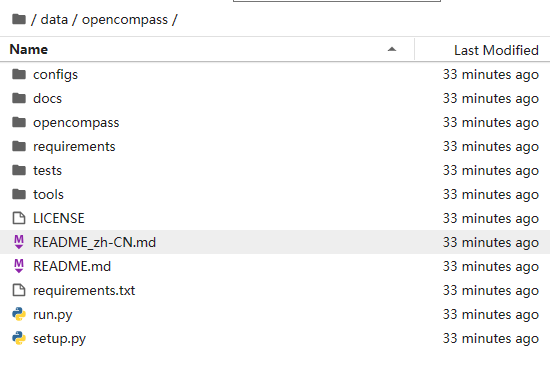

这些数据库来自:xtuner,opencompass,lagent等等。位置在root/data里面。但是对于其中的结构还是不太了解。

接着是,处理数据。包括:获取文件、加载文件、构建向量数据库、开源词向量模型。……

然后把internlm接入langchain中,构建检索问答链,

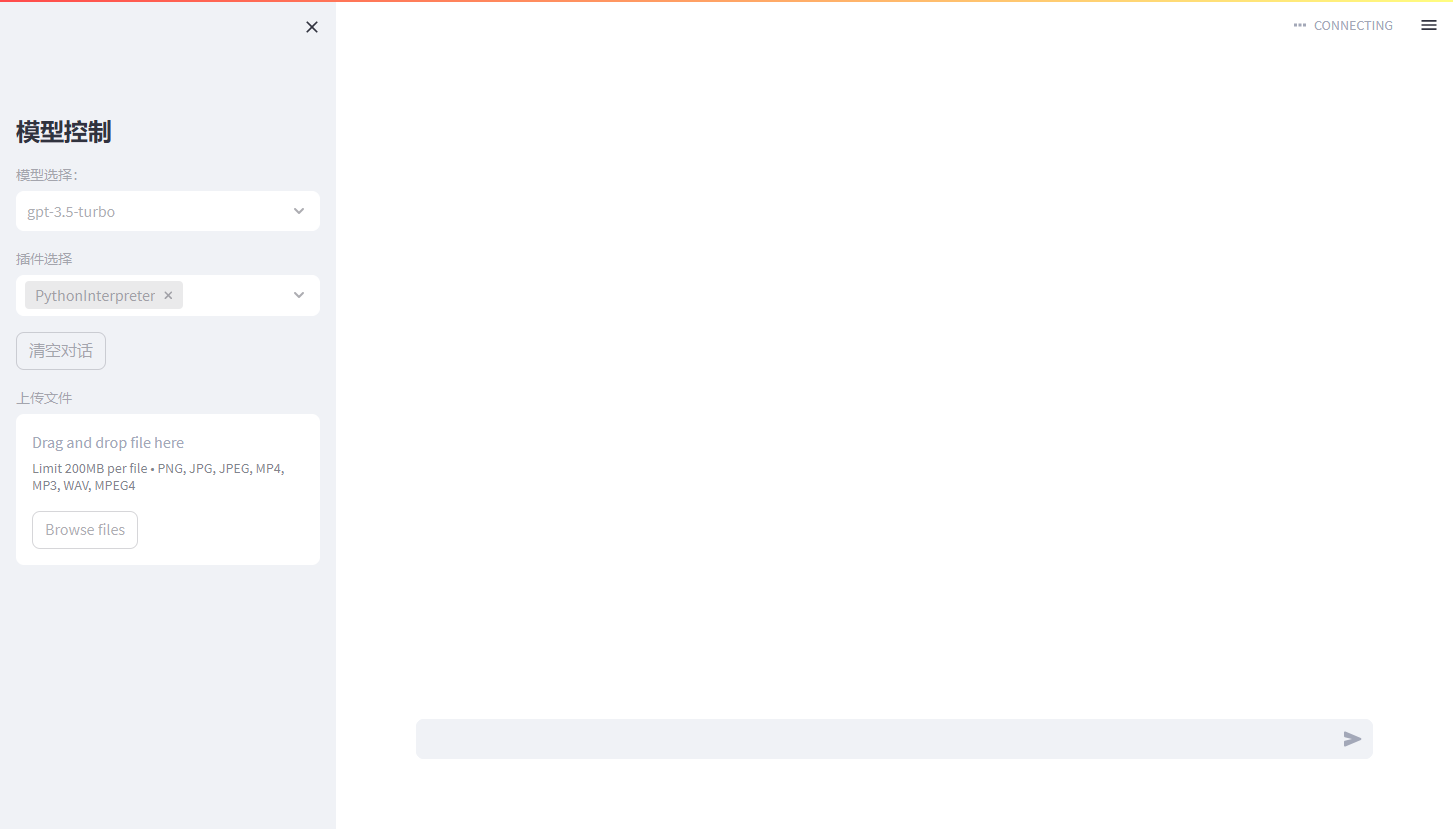

最后部署web demo,如上面截图。