摘要:

对于scrapy来说,也是有两个方法模拟登陆: 1. 直接携带cookie 2. 找到发送post请求的url地址,带上信息,发送请求 scrapy模拟登陆之携带cookie 应用场景: 1. cookie过期时间很长,常见于一些不规范的网站 2. 能在cookie过期之前把搜有的数据数据拿到 3. 阅读全文

2018年10月26日

摘要:

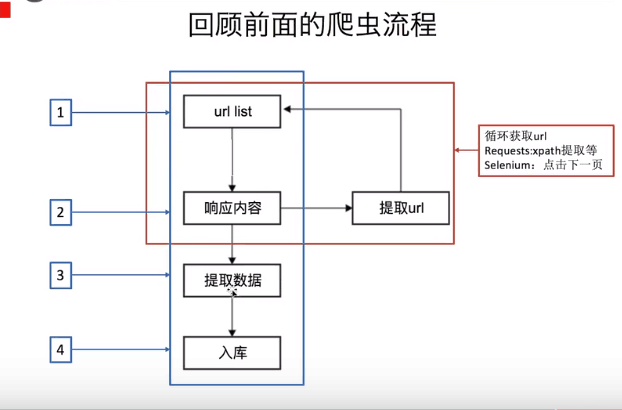

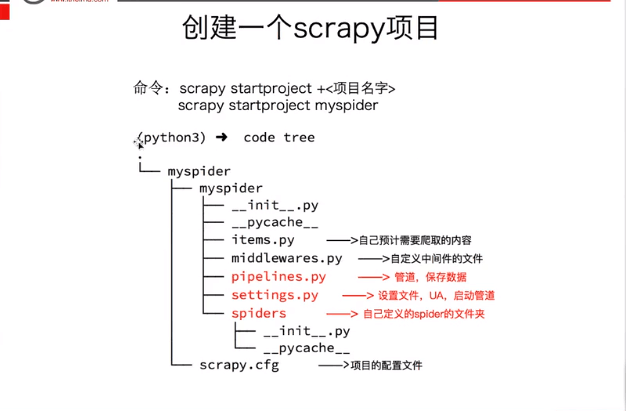

scrapy入门 1. 创建一个scrapy项目 scrapy startporject mySpider 2. 生产一个爬虫 scrapy genspider itcast "itcast.cn" 3. 提取数据 完善spider,使用xpath等方法 4. 保存数据 pipeline中保存数据 阅读全文

摘要:

2. 安装 sudo apt get install tesseract ocr 3. 在python中调用Tesseract pip install pyte 阅读全文

摘要:

后续爬虫代码的建议 尽量减少请求次数 1. 能抓列表页就不抓详情页 2. 保存获取的html页面,供差错和重复请求使用 关注网站的所有类型的页面 1. wap页面,触屏版页面 2. H5页面 3. APP 多伪装 1. 动态的UA 2. 代理ip 3. 不使用cookie 利用多线程分布式 在不被b 阅读全文

摘要:

寻找登录的post地址 在form表单中寻找action对应的url地址 post的数据是input标签中的name值作为键,真正的用户名密码作为值得字典,post的url地址就是action对应的url地址 抓包,寻找登录的url地址 勾选presever log按钮,防止页面跳转不到url 寻找 阅读全文

摘要:

requests使用入门 问题:为什么要学习requests,而不是urllib? 1. requests的底层实现就是urllib 2. requests在python2和python3中通用,方法完全一样 3. requests简单易用 4. requests能够自动帮助我们解压(gzip压缩的 阅读全文