多输入输出通道

在上一篇文章中我们讨论了,CNN中填充和步幅的作用。同时,我们所有的讨论都是基于二维的张量,即不考虑图片的RGB通道,然而在现实生活中我们往往需要处理多通道的图片,比如RGB图片,其通道数为3。那么,我们该如何处理多通道的图片呢?

这里我们为了处理多通道图片,将我们的输入和隐藏层表示都变成三维张量。例如,每个RGB输入图像具有\(3\times h \times w\)的形状。我们将这个大小为3的轴称为通道(channel)维度。下面我们将更深入的研究具有多输入和多输出通道的卷积核。

多输入通道

当输入包含多个通道时,需要构造一个与输入数据具有相同输入通道数的卷积核,以便与输入数据进行互相关运算。假设输入的通道数为\(c_i\),那么卷积核的输入通道数也需要为\(c_i\)。如果卷积核的窗口形状是\(k_h\times k_w\),那么当\(c_i=1\)时,我们可以把卷积核看作形状为\(k_h\times k_w\)的二维张量。

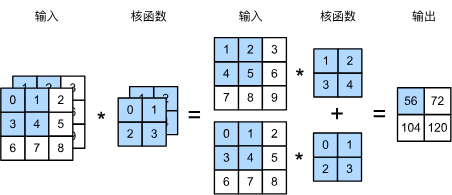

然而,当\(c_i>1\)时,我们卷积核的每个输入通道将包含形状为\(k_h\times k_w\)的张量。将这些张量\(c_i\)连结在一起可以得到形状为\(c_i\times k_h\times k_w\)的卷积核。由于输入和卷积核都有\(c_i\)个通道,我们可以对每个通道输入的二维张量和卷积核的二维张量进行互相关运算,再对通道求和(将\(c_i\)的结果相加)得到二维张量。这是多通道输入和多输入通道卷积核之间进行二维互相关运算的结果。

在下图中,我们演示了一个具有两个输入通道的二维互相关运算的示例。阴影部分是第一个输出元素以及用于计算这个输出的输入和核张量元素:\((1\times1+2\times2+4\times3+5\times4)+(0\times0+1\times1+3\times2+4\times3)=56\)。

为了加深理解,我们实现一下多输入通道互相关运算。 简而言之,我们所做的就是对每个通道执行互相关操作,然后将结果相加。

import torch

from d2l import torch as torch

# 定义一个函数,用于计算多个输入的卷积

def corr2d_multi_in(X, K):

# 先遍历X和K的第零个维度,再把他们加在一起

return sum(d2l.corr2d(X, K) for X, K in zip(X, K))

我们可以构造与上图的值相对应的输入张量X和核张量K,以验证互相关运算的输出。

X = torch.tensor([[[0.0, 1.0, 2.0], [3.0, 4.0, 5.0], [6.0, 7.0, 8.0]],

[[1.0, 2.0, 3.0], [4.0, 5.0, 6.0], [7.0, 8.0, 9.0]]])

K = torch.tensor([[[0.0, 1.0], [2.0, 3.0]], [[1.0, 2.0], [3.0, 4.0]]])

corr2d_multi_in(X, K)

输出

tensor([[ 56., 72.],

[104., 120.]])

多输出通道

到目前为止,不论有多少输入通道,我们还只有一个输出通道。然而,正如我们上面所讨论的,每一层有多个输出通道是至关重要的。在最流行的神经网络架构中,随着神经网络层数的加深,我们常会增加输出通道的维数,通过减少空间分辨率以获得更大的通道深度。直观地说,我们可以将每个通道看作对不同特征的响应。而现实可能更为复杂一些,因为每个通道不是独立学习的,而是为了共同使用而优化的。因此,多输出通道并不仅是学习多个单通道的检测器。

用\(c_i\)和\(c_o\)分别表示输入和输出通道的数目,并让\(k_h\)和\(k_w\)为卷积核的高度和宽度。为了获得多个通道的输出,我们可以为每个输出通道创建一个形状为\(c_i\times k_h\times k_w\)的卷积核张量,这样卷积核的形状是\(c_o\times c_i\times k_h\times k_w\)。在互相关运算中,每个输出通道先获取所有输入通道,再以对应该输出通道的卷积核计算出结果。

如下所示,我们实现一个计算多个通道的输出的互相关函数。

def corr2d_multi_in_out(X, K):

# 迭代“K”的第0个维度,每次都对输入“X”执行互相关运算。

# 最后将所有结果都叠加在一起

return torch.stack([corr2d_multi_in(X, k) for k in K], 0)

通过将核张量K与K+1(K中每个元素加\(1\))和K+2连接起来,构造了一个具有\(3\)个输出通道的卷积核。

K = torch.stack([K, K + 1, K + 2], 0)

K.shape

输出

torch.Size([3, 2, 2, 2])

现在,我们可以使用这个多输出通道的卷积核与输入X进行互相关运算。输出将具有\(3\)个通道。

corr2d_multi_in_out(X, K)

输出

tensor([[[ 56., 72.],

[104., 120.]],

[[ 76., 100.],

[148., 172.]],

[[ 96., 128.],

[192., 224.]]

])

1x1卷积

在二维卷积中,卷积核的高度和宽度为\(1\)时,卷积核只包含一个二维的过滤器。这种卷积核的形状是\(1\times1\)。这种卷积核可以改变输入的通道数,但不会改变输入的空间尺寸。因此,\(1\times1\)卷积核的输入和输出通道数相同。

\(1\times1\)卷积,即\(k_h=k_w\),看起来似乎没有多大意义。 毕竟,卷积的本质是有效提取相邻像素间的相关特征,而\(1\times1\)卷积显然没有此作用。 尽管如此,\(1\times1\)仍然十分流行,经常包含在复杂深层网络的设计中。下面,让我们详细地解读一下它的实际作用。

因为使用了最小窗口,\(1\times1\)卷积失去了卷积层的特有能力——在高度和宽度维度上,识别相邻元素间相互作用的能力。 其实\(1\times1\)卷积的唯一计算发生在通道上。

下图展示了使用展示了使用卷积核与3个输入通道和2个输出通道的互相关计算。 这里输入和输出具有相同的高度和宽度,输出中的每个元素都是从输入图像中同一位置的元素的线性组合。 我们可以将\(1\times1\)卷积层看作在每个像素位置应用的全连接层,以\(c_i\)个输入值转换为\(c_o\)个输出值。 因为这仍然是一个卷积层,所以跨像素的权重是一致的。 同时,\(1\times1\)卷积层需要的权重维度为\(c_i\times c_o\),再额外加上一个偏置。

下面我们使用全连接层实现\(1\times1\)卷积。注意,我们需要对输入和输出数据的形状进行调整

def corr2d_multi_in_out_1x1(X, K):

# 获取输入矩阵的通道数、高度和宽度

c_i, h, w = X.shape

# 获取卷积核的通道数

c_o = K.shape[0]

# 将输入矩阵展平为二维矩阵

X = X.reshape((c_i, h * w))

# 将卷积核展平为二维矩阵

K = K.reshape((c_o, c_i))

# 全连接层中的矩阵乘法

Y = torch.matmul(K, X)

# 将结果重新 reshape 为卷积后的矩阵

return Y.reshape((c_o, h, w))

当执行\(1\times1\)卷积运算时,上述函数相当于先前实现的互相关函数corr2d_multi_in_out。让我们用一些样本数据来验证这一点。

X = torch.normal(0, 1, (3, 3, 3))

K = torch.normal(0, 1, (2, 3, 1, 1))

Y1 = corr2d_multi_in_out_1x1(X, K)

Y2 = corr2d_multi_in_out(X, K)

assert float(torch.abs(Y1 - Y2).sum()) < 1e-6

总结

多输入通道的设计是为了融合不同特征:不同的输入通道可以代表不同的数据源或不同的特征类型。例如,在图像处理中,RGB通道分别代表红、绿、蓝三个颜色通道,融合这些信息可以更全面地理解图像内容。而对于多输出通道,不同的输出通道可以捕获输入数据的不同空间层次结构,如边缘、纹理和形状等,增加了模型的表达能力。\(1\times1\)卷积层通常用于调整网络层的通道数量和控制模型复杂性。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 【译】Visual Studio 中新的强大生产力特性

· 【设计模式】告别冗长if-else语句:使用策略模式优化代码结构

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义