Pytorch入门之Autograd: 自动微分 & 神经网络介绍

Autograd: 自动微分

深度学习的算法本质上是通过反向传播求导数,PyTorch 的Autograd模块实现了此功能。在Tensor上的所有操作,Autograd 都能为它们自动提供微分,避免手动计算导数的复杂过程。

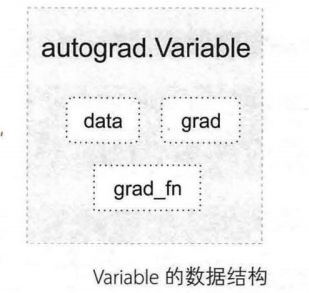

autograd.Variable是Autograd中的核心类,它简单封装了Tensor, 并支持几乎所有Tensor的操作。Tensor在被封装为Variable之后,可以调用它的backward实现反向传播,自动计算所有梯度。Variable的数据结构如图所示。

- Variable 变量

- Tensor 张量

Variable主要包含三个属性。

- data : 保存Variable所包含的Tensor。

- grad : 保存data对应的梯度,grad也是个Variable, 而不是Tensor,它和data的形状一样。

- grad_fn : 指向一个Function对象, 这个Function用来反向传播计算输入的梯度.

from torch.autograd import Variable

import torch as t

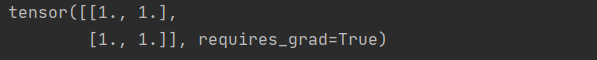

x = Variable(t.ones(2, 2), requires_grad=True)

print(x)

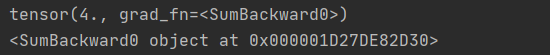

y = x.sum()

print(y)

print(y.grad_fn)

y.backward() # 反向传播 计算梯度

print(x.grad)

# 注意: grad在反向传播过程中是累加的(accumulated), 这意味着每次运行反向传播;

# 梯度都会累加之前的梯度,所以反向传播之前需把梯度清零。

y.backward()

print(x.grad)

y.backward()

print(x.grad)

# 梯度清零操作

x.grad.data.zero_()

print(x.grad)

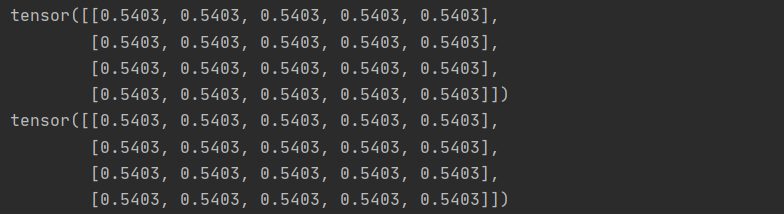

Variable和Tensor具有近乎一致的接口,在实际使用中可以无缝切换。

x = Variable(t.ones(4, 5))

y = t.cos(x)

x_tensor_cos = t.cos(x.data)

print(y)

print(x_tensor_cos)

神经网络LeNet示例

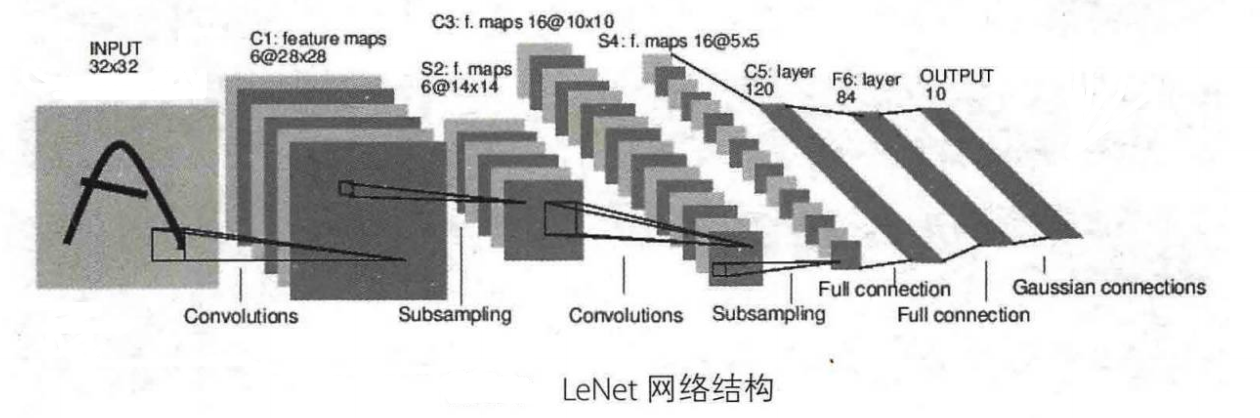

Autograd实现了反向传播功能,但是直接用来写深度学习的代码在很多情况下还是稍显复杂,torch.nn 是专门为神经网络设计的模块化接口。nn构建于Autograd之上,可用来定义和运行神经网络。nn.Module 是nn中最重要的类,可以把它看作一个网络的封装,包含网络各层定义及forward方法,调用forward(input)方法,可返回前向传播的结果。我们以最早的卷积神经网络LeNet为例,来看看如何用nn.Module实现。LeNet的网络结构如图所示。

这是一个基础的前向传播(feed-forward)网络:接收输人,经过层层传递运算,得到输出。

定义网络

定义网络时,需要继承nn.Module, 并实现它的forward方法,把网络中具有可学习参数的层放在构造函数__init__ 中。如果某一层(如ReLU)不具有可学习的参数,则既可以放在构造函数中,也可以不放。但建议不放在其中,而在forward中使用nn.functional代替。

import torch.nn as nn

import torch.nn.functional as F

class Net(nn.Module):

def __init__(self):

# nn.Module子类的函数必须在构造函数中执行父类的构造函数

# 下式等价于nn.Module.__init__(self)

super(Net, self).__init__()

# 卷积层 '1'表示输入图片为单通道, '6'表示输出通道数,'5'表示卷积核为5*5

self.conv1 = nn.Conv2d(1, 6, 5)

# 卷积层

self.conv2 = nn.Conv2d(6, 16, 5)

# 仿射层/全连接层,y = Wx + b

self.fc1 = nn.Linear(16 * 5 * 5, 120)

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 10)

def forward(self, x):

# 卷积 -> 激活 -> 池化

x = F.max_pool2d(F.relu(self.conv1(x)), (2, 2))

x = F.max_pool2d(F.relu(self.conv2(x)), 2)

# reshape,‘-1’表示自适应

x = x.view(x.size()[0], -1)

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

x = self.fc3(x)

return x

net = Net()

print(net)

只要在nn.Module的子类中定义了forward函数,backward函数就会自动被实现(利用autograd)。在forward 函数中可使用任何tensor支持的函数,还可以使用if、for循环、print、log等Python语法,写法和标准的Python写法一致。

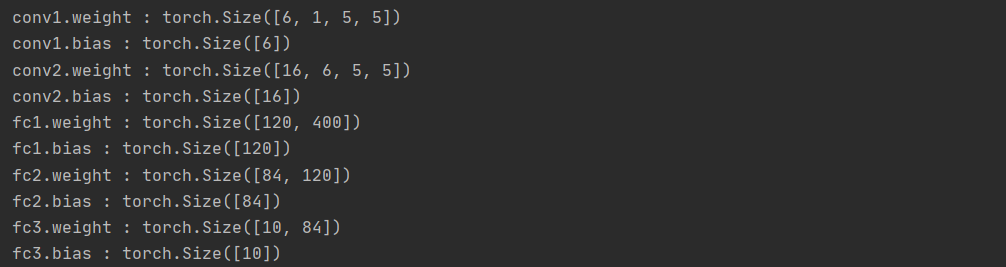

网络的可学习参数通过net.parameters()返回,net.named_parameters可同时返回可学习的参数及名称。

params = list(net.parameters())

print(len(params))

for name, parameter in net.named_parameters():

print(name, ':', parameter.size())

forward函数的输入和输出都是Tensor。

input = t.randn(1, 1, 32, 32)

out = net(input)

print(out.size())

net.zero_grad() # 所有参数的梯度清零

out.backward(t.ones(1, 10)) # 反向传播

需要注意的是,torch.nn只支持mini-batches,不支持一次只输入一个样本,即一次必须是一个batch。但如果只想输入一个样本,则用 input.unsqueeze(0)将batch_size设为1。例如 nn.Conv2d 输入必须是4维的,形如nSamplesnChannelsHeightWidth。可将nSample设为1,即1nChannelsHeightWidth。

损失函数

nn实现了神经网络中大多数的损失函数,例如nn.MSELoss用来计算均方误差,nn.CrossEntropyLoss用来计算交叉熵损失。

output = net(input)

target = t.arange(0, 10).view(1, 10).float()

criterion = nn.MSELoss()

loss = criterion(output, target)

print(loss)

如果对loss进行反向传播溯源(使用gradfn属性),可看到它的计算图如下:

input -> conv2d -> relu -> maxpool2d -> conv2d -> relu -> maxpool2d

-> view -> linear -> relu -> linear -> relu -> linear

-> MSELoss

-> loss

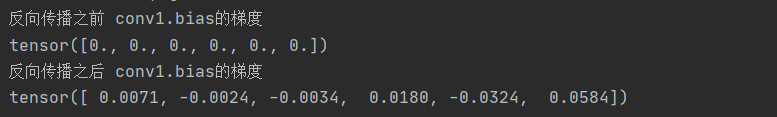

当调用loss.backward()时,该图会动态生成并自动微分,也即会自动计算图中参数(Parameter)的导数。

# 运行.backward,观察调用之前和调用之后的grad

net.zero_grad() # 把net中所有可学习参数的梯度清零

print('反向传播之前 conv1.bias的梯度')

print(net.conv1.bias.grad)

loss.backward()

print('反向传播之后 conv1.bias的梯度')

print(net.conv1.bias.grad)

优化器

在反向传播计算完所有参数的梯度后,还需要使用优化方法来更新网络的权重和参数,例如随机梯度下降法(SGD)的更新策略如下:

weight = weight - learning_rate * gradient

手动实现如下:

learning_rate = 0.01

for f in net.parameters():

f.data.sub_(f.grad.data * learning_rate) # inplace 减法

torch.optim中实现了深度学习中绝大多数的优化方法,例如RMSProp、Adam、SGD等,更便于使用,因此大多数时候并不需要手动写上述代码。

import torch.optim as optim

# 新建一个优化器,指定要调整的参数和学习率

optimizer = optim.SGD(net.parameters(), lr=0.01)

# 在训练过程中

# 先梯度清零(与net.zero_grad()效果一样)

optimizer.zero_grad()

# 计算损失

output = net(input)

loss = criterion(output, target)

# 反向传播

loss.backward()

# 更新参数

optimizer.step()

数据加载与预处理

在深度学习中数据加载及预处理是非常复杂繁琐的,但PyTorch提供了一些可极大简化和加快数据处理流程的工具。同时,对于常用的数据集,PyTorch也提供了封装好的接口供用户快速调用,这些数据集主要保存在torchvison中。

torchvision实现了常用的图像数据加载功能,例如Imagenet、CIFAR10、MNIST等,以及常用的数据转换操作,这极大地方便了数据加载,并且代码具有可重用性。

浙公网安备 33010602011771号

浙公网安备 33010602011771号