无任务连续学习的神经Dirichlet过程混合模型

A NEURAL DIRICHLET PROCESS MIXTURE MODEL FOR TASK-FREE CONTINUAL LEARNING

尽管人们对持续学习的兴趣日益浓厚,但大多数当代作品都是在相当局限的环境下进行研究的,其中任务可以清晰地区分,并且在训练过程中任务边界是已知的。但是,如果我们的目标是开发一种可以像人类一样学习的算法,则此设置远非现实可行,因此开发一种无任务方式工作的方法至关重要。同时,在持续学习的几个分支中,基于扩展的方法具有通过分配新资源来学习新数据来消除灾难性遗忘的优势。在这项工作中,我们提出了一种基于扩展的方法来进行无任务的持续学习。我们的模型称为连续神经Dirichlet过程混合(CN-DPM),由一组负责数据子集的神经网络专家组成。 CN-DPM在贝叶斯非参数框架下以有原则的方式扩大了专家的数量。通过广泛的实验,我们证明了我们的模型可以成功执行针对诸如图像分类和图像生成等判别性任务和生成性任务的无任务持续学习。

人类一生中都会不断遇到新信息。但是,提供信息的方式与传统的深度学习有很大的不同,在传统的深度学习中,每个微型批处理都是从整个数据集中进行iid采样的。时间相邻的数据点可以高度相关,并且随着训练的进行,数据的整体分布可能会发生巨大变化。持续学习(CL)的目的是模仿令人难以置信的人类从非AI数据流中学习的能力,而不会灾难性地忘记先前学习的知识。

多数CL方法(Aljundi等人,2018; 2017; Lopez-Paz&Ranzato,2017; Kirkpatrick等人,2017; Rusu等人,2016; Shin等人,2017; Yoon等人,2018)假设数据流被明确分为训练时已知的一系列任务。由于这种假设远非现实,因此无任务的CL更为实用和苛刻,但除了(Aljundi等人,2019a; b)的少数例外,它在很大程度上已被研究不足。在这种通用的CL中,不仅没有明确的任务定义,而且数据分配在没有明确的任务边界的情况下逐渐转移。

同时,现有的CL方法可以分为三类(Parisi等,2019):正则化,重播和扩展方法。正规化和重放方法分别通过正规化一组特定权重的更新或重放以前看到的数据来解决灾难性的遗忘。另一方面,扩展方法与两种方法的不同之处在于,它可以扩展模型体系结构以容纳新数据,而不必事先进行修复。因此,扩展方法可以通过防止新信息覆盖现有组件来避免灾难性遗忘。但是,现有扩展方法的关键局限性在于,何时扩展以及要大量使用哪种资源的决策取决于显式给出的任务定义和启发式方法。

在这项工作中,我们的目标是为无任务CL提出一种基于扩展的新颖方法。受专家混合(MoE)的启发(Jacobs等人,1991),我们的模型由一组专家组成,每个专家负责流中数据的子集。模型扩展(即增加专家)由贝叶斯非参数框架控制,该框架通过数据确定模型的复杂性,而不是在训练之前固定模型复杂性的参数方法。我们将无任务的CL公式化为由一组神经专家组成的Dirichlet过程混合模型的在线变分推断;因此,我们将我们的方法命名为连续神经Dirichlet过程混合(CN-DPM)模型。

我们重点介绍这项工作的主要贡献如下:

•我们是最早提出针对无任务CL的基于扩展的方法的团队之一。 因此,我们的模型不仅可以防止灾难性的遗忘,而且可以应用于在训练和测试时都没有给出任务定义和边界的情况。 我们名为CN-DPM的模型由一组神经网络专家组成,这些专家以有原则的方式进行了扩展,这些原则是基于一般CL研究中尚未采用的贝叶斯非参数建立的。

•我们的模型可以处理CL的生成任务和判别任务。 通过针对MNIST,SVHN和CIFAR 10/100的CL文献的几个基准实验,我们证明了我们的模型成功执行了多种类型的CL任务,包括图像分类和生成。

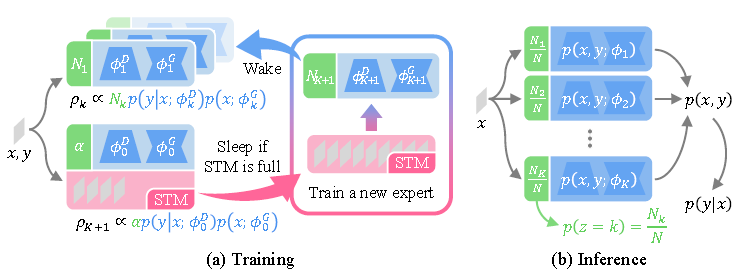

图1:我们的CN-DPM模型概述。 每个专家k(蓝色框)都包含一个判别式用于建模p(y | x;φkD)的组件和用于建模p(x;φkG)的生成组件,共同表示p(x,y;φk)。 我们还保留每个专家分配的数据计数Nk。 (a)在训练过程中,每个专家对序列中的每个样本(x,y)进行评估,以计算每个专家的责任ρk。 如果ρK+ 1足够高,即没有现有专家负责,则将数据存储到短期存储器(STM)中。 否则,由相应的专家学习。 STM填满后,将根据STM中的数据创建一个新的专家。 (b)由于CN-DPM是一个生成模型,因此我们首先计算给定x的联合分布p(x,y),从中可以轻易推断出p(y | x)。

图1:我们的CN-DPM模型概述。 每个专家k(蓝色框)都包含一个判别式用于建模p(y | x;φkD)的组件和用于建模p(x;φkG)的生成组件,共同表示p(x,y;φk)。 我们还保留每个专家分配的数据计数Nk。 (a)在训练过程中,每个专家对序列中的每个样本(x,y)进行评估,以计算每个专家的责任ρk。 如果ρK+ 1足够高,即没有现有专家负责,则将数据存储到短期存储器(STM)中。 否则,由相应的专家学习。 STM填满后,将根据STM中的数据创建一个新的专家。 (b)由于CN-DPM是一个生成模型,因此我们首先计算给定x的联合分布p(x,y),从中可以轻易推断出p(y | x)。

个人认为:实际并没有想象中的理想化,效果可能一般