论文精读—多智能体算法在无人机集群的运用

导:“在阅读一篇论文后,要对这几个方面有清晰的认识,动机、创新点和实验设计,外加自己对这篇论文有什么想法”

论文解读:本文组织如下:第二节介绍了相关工作,第三节介绍了大规模搜索场景和系统模型,第四节详细介绍了基于marl的无人机群搜索方法,第五节讨论了仿真设置和实验结果,第六节总结了本文。

建模思考理解:

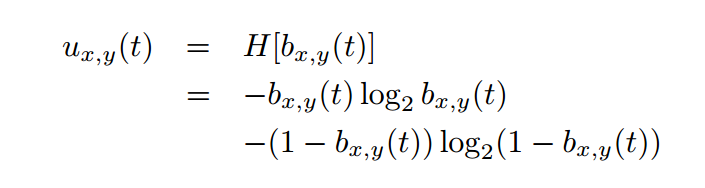

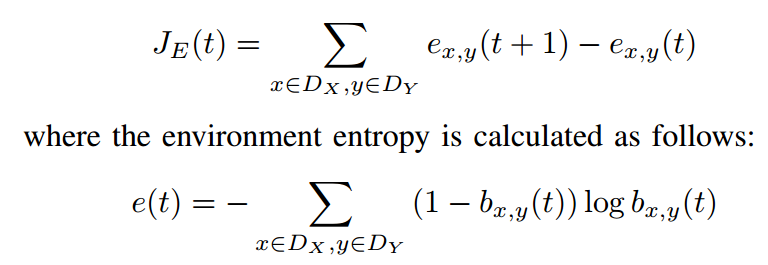

这个u就是一个在x,y状态下的一个不确定性,它使用香农熵来表示,其中,香农熵越大,不确定性越大,而bxyt,则是在该状态下,发现目标的一个概率

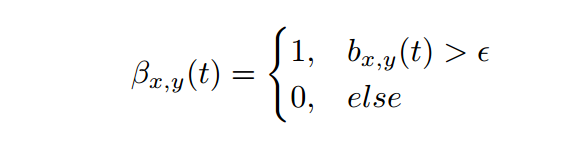

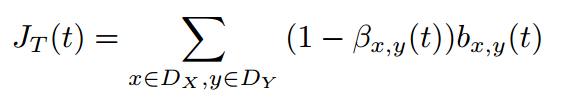

而这个β,就是用于判断此处是否有目标,并只有0和1,先设置一个阈值ϵ,ϵ越大,b就比较难以大于ϵ,那么无人机就比较“谨慎”,不敢随意判断此处有目标,但是,也容易“错付”,反之阈值越小,无人机就越“莽撞”,却更容易误判

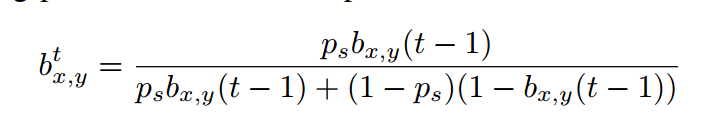

这是一个用来更新bxyt的算法,p是保真度。如果传感器未发现目标,则将ps替换为1 - p

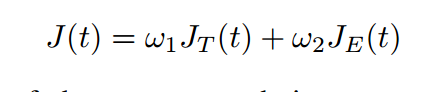

这是一个效能值的权衡方程,由环境效能和目标效能组成

由刚刚那个涉及阈值的方程得,阈值越小,β越大,误判概率越大,结过越不可靠,目标效能越小

而环境效能则由上一个时刻和这一个时刻的香农熵决定,比如说香农熵增加得比较大,那么环境效能就比较大

动机:

搜索场景的日益复杂,搜索场景的规模越来越大

1.现有无人机群搜索方法缺乏可拓展性和高效协同能力

2.全局信息的准确性和实时性难以保证,需要提供局部信息

3.随着环境和任务是不断变化,无人机和任务数量的增加,状态空间和动作空间也相应变大,传统的优化方法很难有效地找到最优解,因此开发更有效和适应性更强的优化方法至关重要

创新点

采用分布式方法:更适合于复杂的环境和任务情况,可以提高系统的可靠性和容错性,分布式方法的计算和通信开销也相对较低,更适合大规模的无人机群协作。

采用局部信息:高度适应环境的独特特征和挑战

1.基于marl(多智能体强化学习)的搜索优化

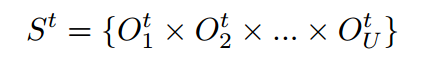

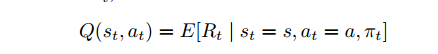

(1)结构,就是去建模,Agent:把每个无人机建模为一个智能体,按照强化学习的方式去训练,Observation:去观察环境,把观察的好几个维度的指标(t时刻的局部信息,t时刻最新的TPM, 为无人机u在t时刻的位置,除无人机u以外的所有无人机的位置,无人机u的飞行方向,以及除无人机u以外的所有无人机的飞行方向) ,(可以把Observation看成向量?个人观点)当然,可以把Observation建模为一个"state"但是,真正的state还得是所有的observation的综合,如下图所示

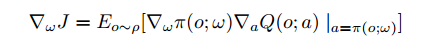

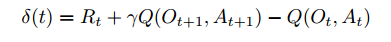

然后运用了MADDPG(多智能体深度确定性策略梯度)算法解决早期的MARL(包括DL,CL)带来的问题

2.用卷积神经网络(CNN)构建网络模型

3.基于maddpg的搜索方法

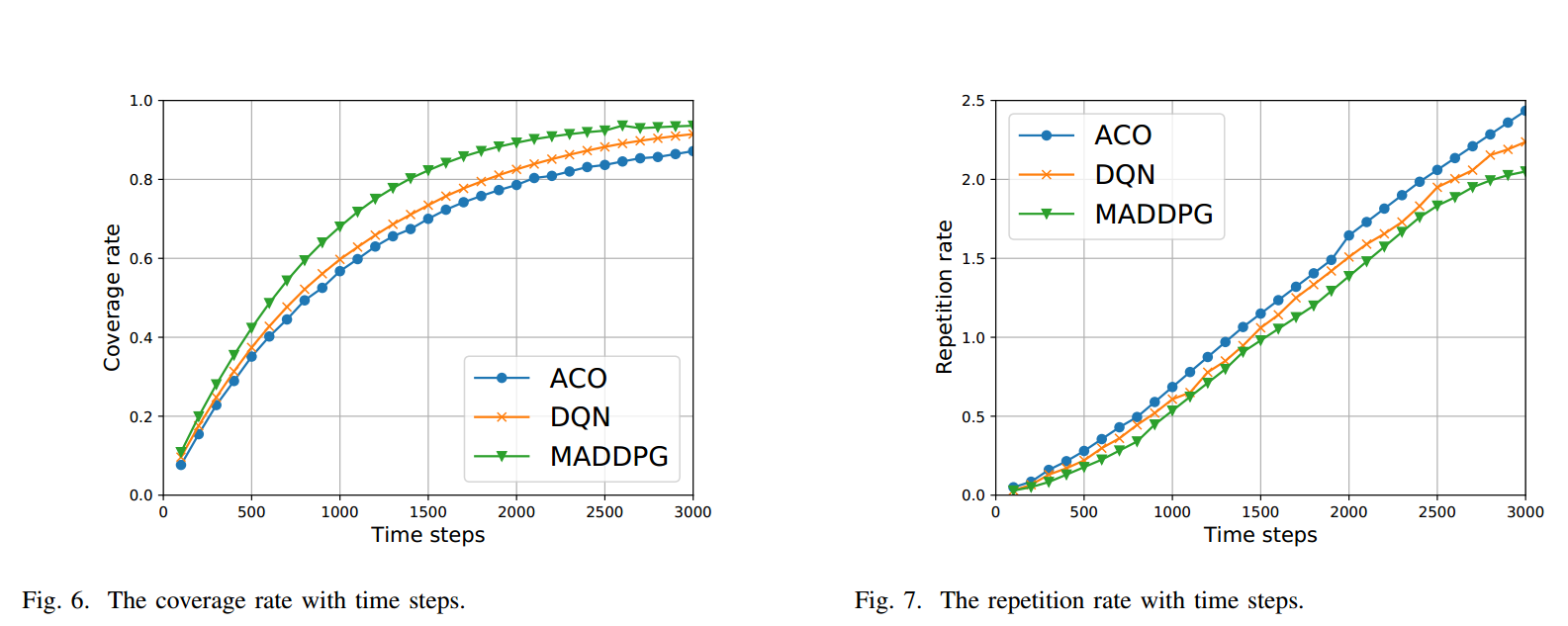

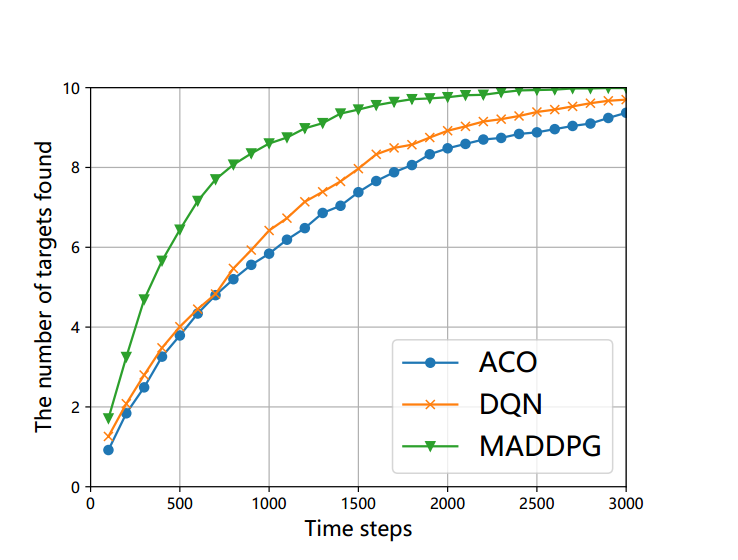

实验设计:使用了几条基线进行比较来验证所提出的基于madpg的搜索方法的性能

将MADDPG与蚁群算法,深度Q学习进行比较,得出MADDPG最好使

突出了基于maddpg的搜索方法在有效探索搜索空间、优化目标搜索任务和在给定时间限制内最大限度地检测到目标数量方面的优势。

两个问题:1.用建模分析场景属于实验设计吗:建模是把抽象的的问题具象化,是一种手段,比如说,搜寻场景很抽象,就建模起来成为研究对象

2.效能是指贡献程度吗

3.然后文中为什么要介绍DQN,MADDPG,MARL等这些书上有的方法?:这些是实验的研究方法

为什么甚至还有Q-learning等很基础的东西?

这些(研究方法)是为了介绍演员网络和评论家网络的更更新模式和细节

然后整篇说是介绍基于MARL的方法,先是说出DL,CL的缺陷,最后引出MADDPG,然后再用控制变量法和蚁群以及深度网络对比了一系列指标,得出MADDPG确实很牛逼