在Windows的idea上打包,然后在Linux的Hadoop集群上跑MapReduce

以Wordcount为例:

1.写MapReduce的流程是什么?

可以总结为三个过程:

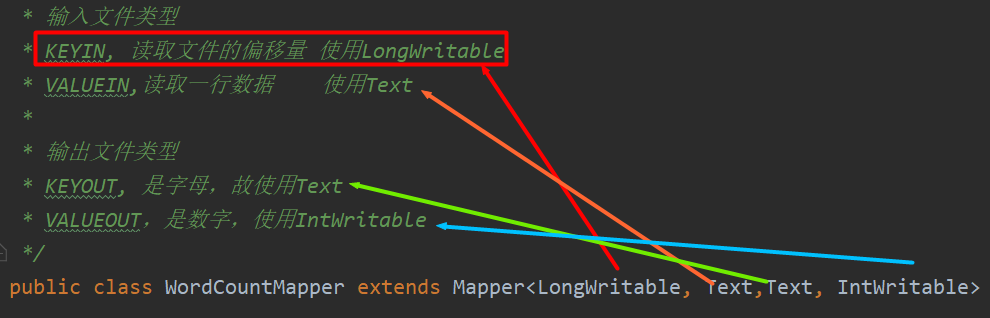

一是写Mapper,重写map方法时,是每输入一行数据就调用一次map方法,如第一行i am;第二行a student;那么总共会调用两次map方法

二是写Reducer,重写reduce方法时,是一组相同key的values就调用一次reduce方法,如mapper后的数据为a 1 1 1;b 1 1;c 1;可以看到有三组,那么总共就调用三次reduce方法

三是写Driver驱动类

写完后,对其进行打包,然后发送到Linux的Hadoop集群上

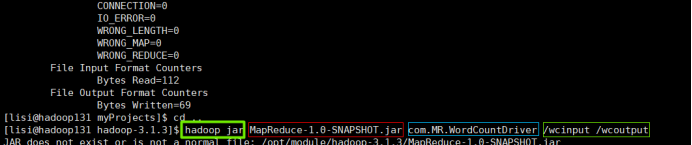

2.在Linux上写跑jar包的指令

hadoop jar是固定的;

红色框是jar包的名称;

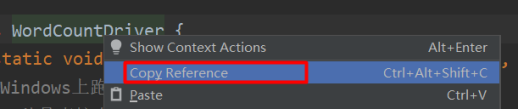

蓝色框是驱动类的类路径;

最后是输入路径和输出路径;

标签:

Hadoop

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 阿里最新开源QwQ-32B,效果媲美deepseek-r1满血版,部署成本又又又降低了!

· 开源Multi-agent AI智能体框架aevatar.ai,欢迎大家贡献代码

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· AI技术革命,工作效率10个最佳AI工具