golang环境中grpc与zipkin的集成

对于分布式系统服务,一个请求需要系统中多个模块,上百台机器配合才能完成。当进行系统调优时单靠分析日志是很难发现到系能瓶颈的,效率非常低下,为此google上线了分布式服务追踪系统Drapper。目前市面上的实现有Twitter的zipkin和阿里的鹰眼系统。最近我在做服务追踪,我们后台使用golang开发,grpc做服务通信,最终选择集成zipkin来做,这个公开资料比较少,写文章来总结一下,方便后来者。

一、首先zipkin的安装使用

1、下载

wget -O zipkin.jar 'https://search.maven.org/remote_content?g=io.zipkin.java&a=zipkin-server&v=LATEST&c=exec'

2、运行

java -jar zipkin.jar

3、在浏览器查看

http://localhost:9411 9411是zipkin默认端口

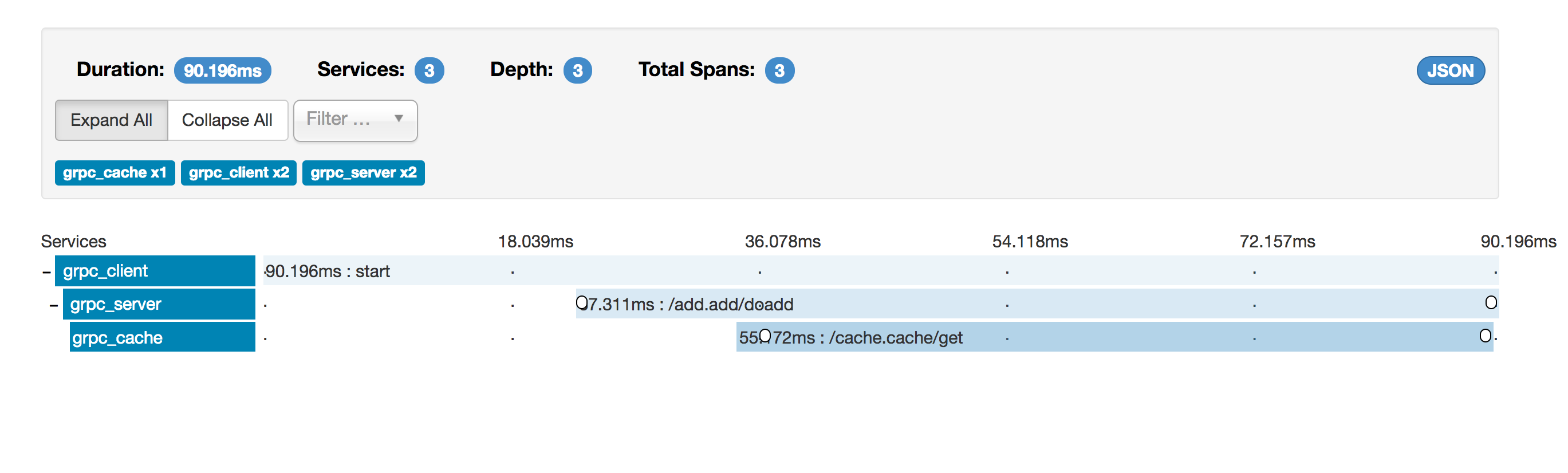

4、效果图如下:

对三个模块间的grpc通信做了追踪,请求的调用路径是这样的client---》server---》cache,从上面的图可以清楚看到每个模块出来花了多少时间。

二、例子的代码大概说明,以server为例,因为这个模块既包含server端也包含client端

代码可以在github上下载,路径:https://github.com/chukuang2004/gotest/tree/master/zipkin

使用到的第三方库有这三个

github.com/opentracing/opentracing-go

github.com/openzipkin/zipkin-go-opentracing

github.com/grpc-ecosystem/grpc-opentracing/go/otgrpc

1、server响应代码

func main() {

collector, err := zipkin.NewHTTPCollector("http://localhost:9411/api/v1/spans")

if err != nil {

log.Fatal(err)

return

}

tracer, err := zipkin.NewTracer(

zipkin.NewRecorder(collector, false, "localhost:0", "grpc_server"),

zipkin.ClientServerSameSpan(true),

zipkin.TraceID128Bit(true),

)

if err != nil {

log.Fatal(err)

return

}

opentracing.InitGlobalTracer(tracer)

lis, err := net.Listen("tcp", port)

if err != nil {

log.Fatalf("failed to listen: %v", err)

}

s := grpc.NewServer(grpc.UnaryInterceptor(otgrpc.OpenTracingServerInterceptor(tracer, otgrpc.LogPayloads())))

pb.RegisterAddServer(s, &AddServer{})

s.Serve(lis)

}

2、请求cache的代码,这个要注意的是新的请求使用的tracer和context要与之前的server的保持一致,这里面保存了一个调研链路里全剧唯一的tracerid

func (s *AddServer) DoAdd(ctx context.Context, in *pb.AddRequest) (*pb.AddReply, error) {

log.Printf("input %d %d", in.GetNum1(), in.GetNum2())

time.Sleep(time.Duration(10) * time.Millisecond)

tracer := opentracing.GlobalTracer()

val := cache.GetCache(ctx, tracer, in.GetNum1())

log.Printf("cache value %d", val)

return &pb.AddReply{Result: val + in.GetNum2()}, nil

}

func GetCache(ctx context.Context, tracer opentracing.Tracer, id int32) int32 {

conn, err := grpc.Dial(address, grpc.WithInsecure(), grpc.WithUnaryInterceptor(otgrpc.OpenTracingClientInterceptor(tracer)))

if err != nil {

log.Fatalf("did not connect: %v", err)

}

defer conn.Close()

c := pb.NewCacheClient(conn)

// Contact the server and print out its response.

r, err := c.Get(ctx, &pb.CacheRequest{Id: id})

if err != nil {

log.Fatalf("could not greet: %v", err)

return -1

}

return r.GetResult()

}

3、写的比较简单,因为细节太多,在一篇博客里没法一一说明,我懒癌复发了,但是把我的例子修改调试着感受一下,再看看三个库的文档,google drapper的论文基本也就明白了,推荐看一下这篇文章,他们貌似自己做了一套tracer,没有用开源的,当然也欢迎找我讨论。

http://www.cnblogs.com/zhengyun_ustc/p/55solution2.html