hadoop核心-Kerberos安全机制

在大数据领域,安全永远是一个绕不开的话题。

对于一个简单安装的hadoop集群,我们认为有如下安全隐患:

1、可以人为添加一个客户端节点,并以此假冒的客户来获取集群数据。

对于一个假冒的客户端节点,成功加入集群就能够伪装 datanode 让得到 namenode 指派的任务和数据。

2、创建hdfs用户账户,就可以得到hadoop文件系统的最高权限。

kerberos主要用来做网络通讯中的身份认证,帮助我们高效、安全的识别访问者。

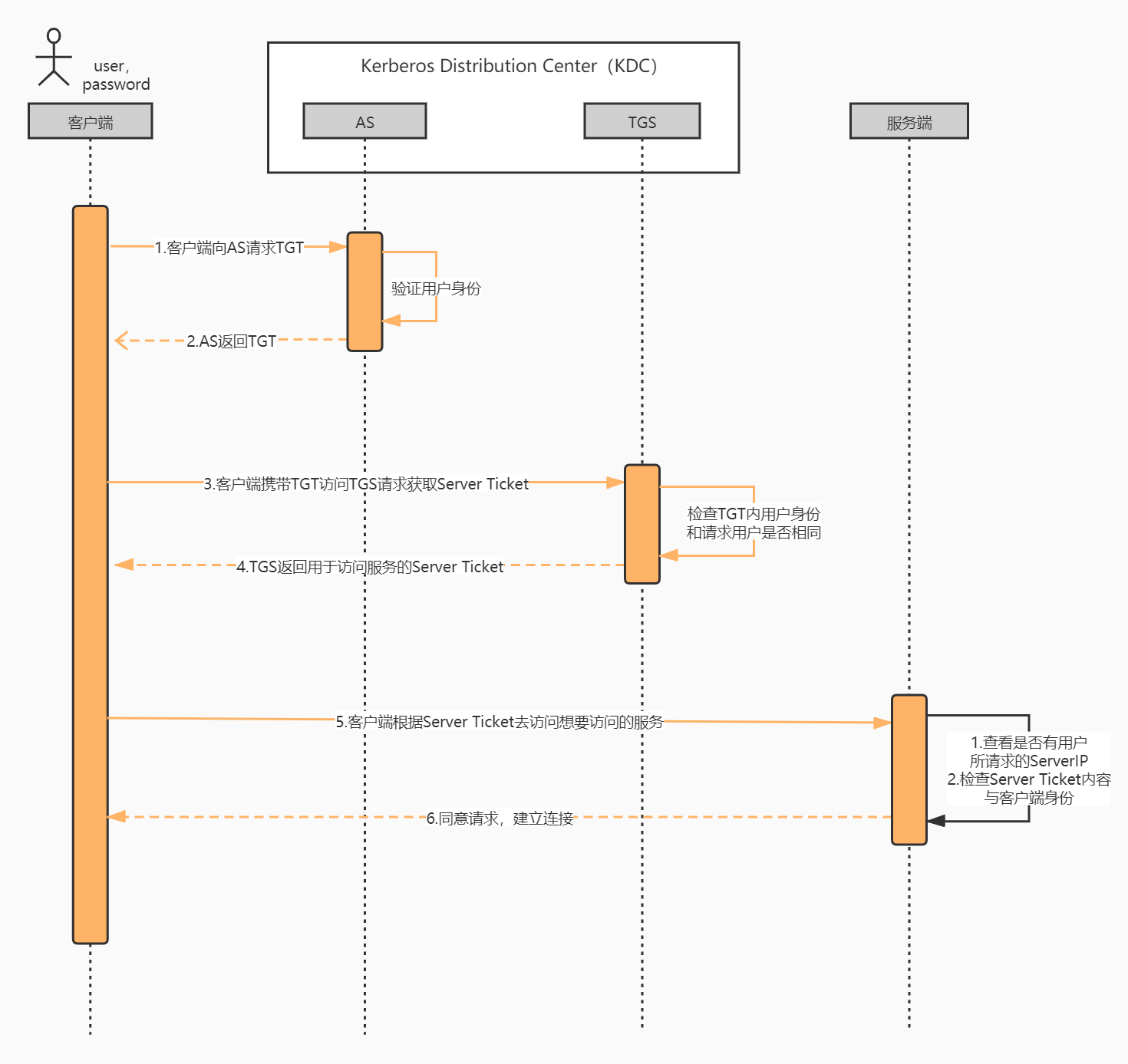

kerberos认证流程:

1、发送请求,表明要访问什么服务,使用自己的密码来对请求进行加密,得到一个临时的票据。

2、拿着临时票据,去票据中心得到一个真实的票据(ticket)。

3、服务提供者和kerberos进行通讯验证ticket的合法性、有效期(ticket只允许访问特定的服务在特定的时间)。

4、验证通过提供服务。

5、超出ticket的有效期后或者服务再次访问需要重新申请。

结论:kerberos的身份认证其实是基于ticket来完成的。客户端想要访问某些服务,最主要就是得到一张ticket。

kerberos执行流程:

原文链接:https://blog.csdn.net/weixin_38233104/article/details/122963237

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· winform 绘制太阳,地球,月球 运作规律

· AI与.NET技术实操系列(五):向量存储与相似性搜索在 .NET 中的实现

· 超详细:普通电脑也行Windows部署deepseek R1训练数据并当服务器共享给他人

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 上周热点回顾(3.3-3.9)

2021-10-18 crontab定时清除FastDFS图片