基于ELK的日志分析、存储、展示

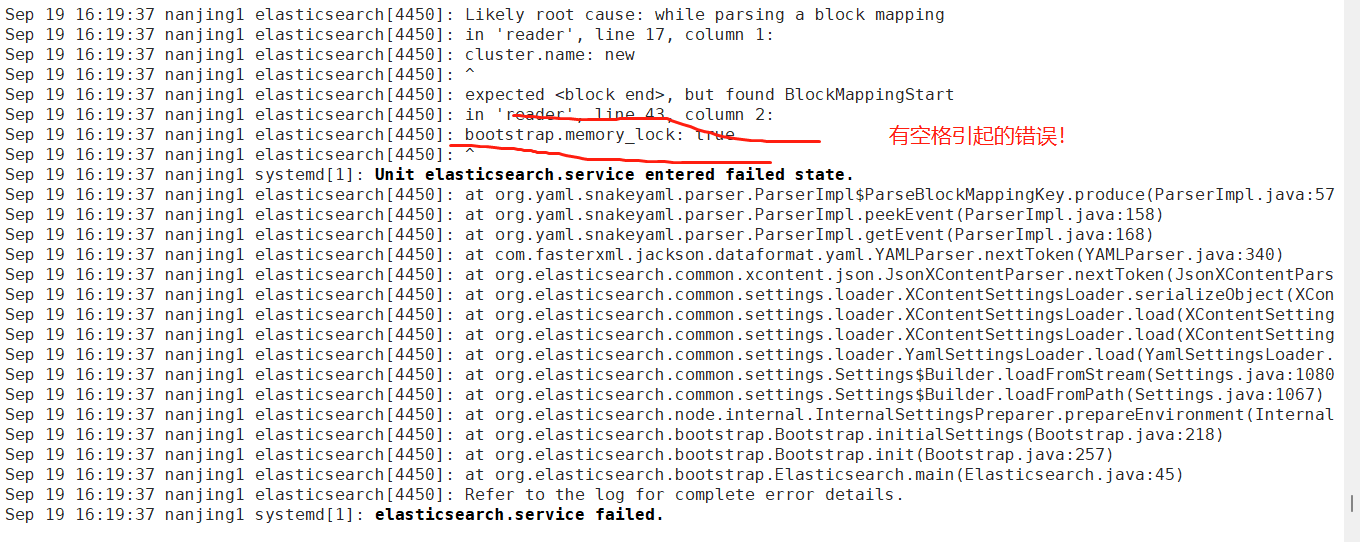

一定要顶格写elasticsearch.yml配置文件

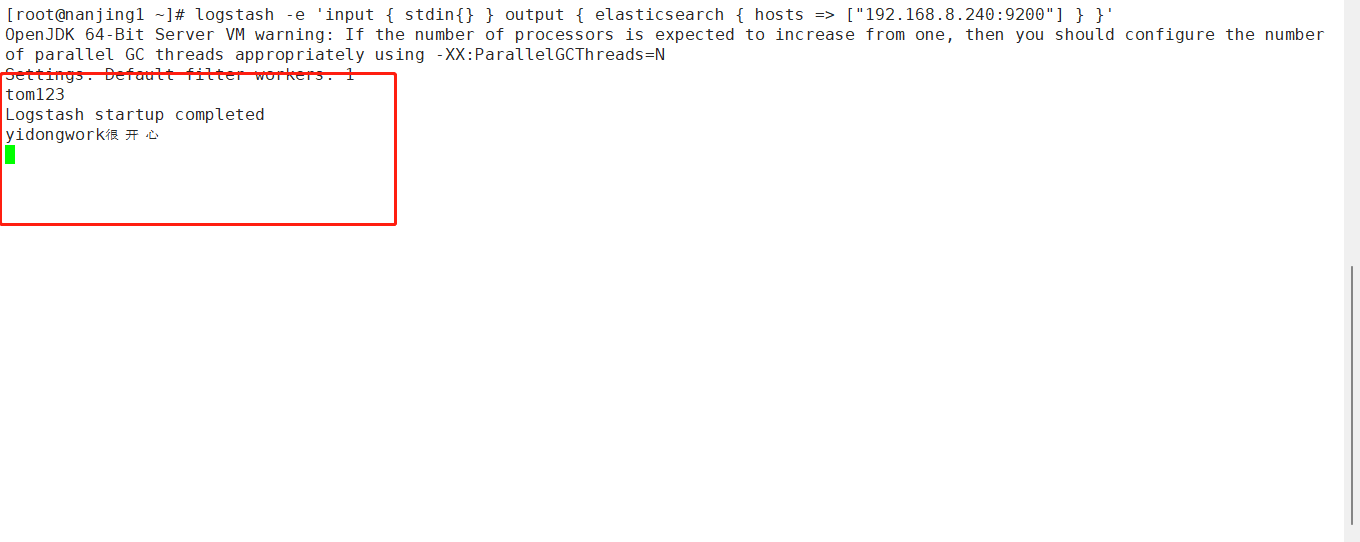

logstash -e 'input { stdin{} } output { elasticsearch { hosts => ["192.168.8.240:9200"] } }'

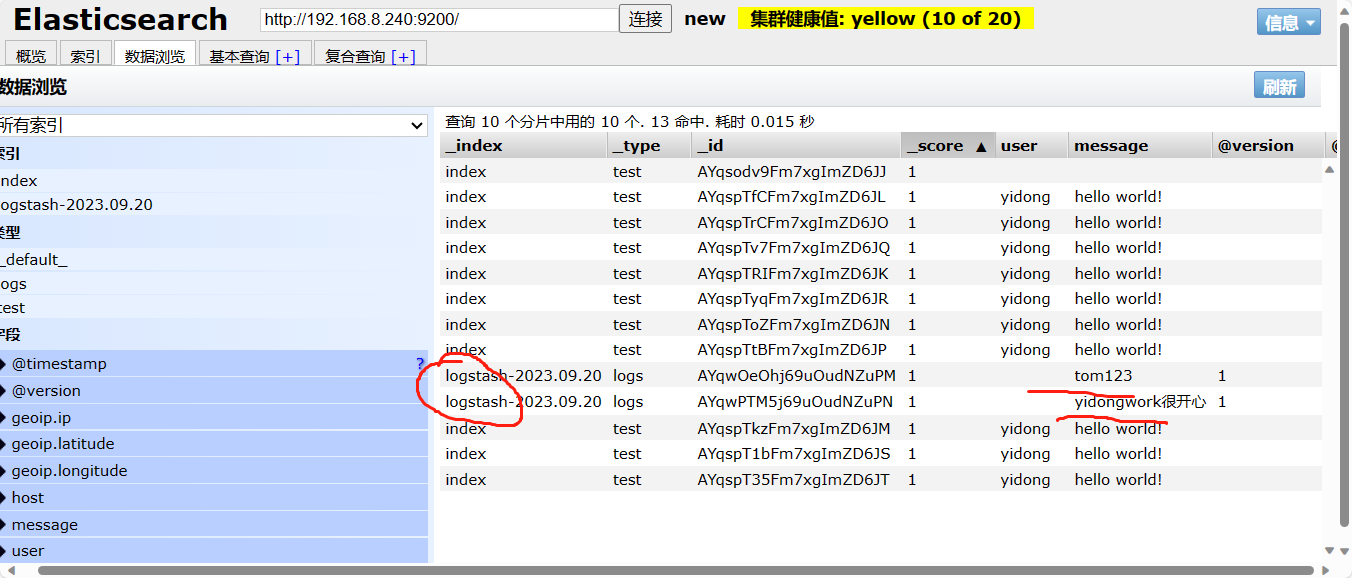

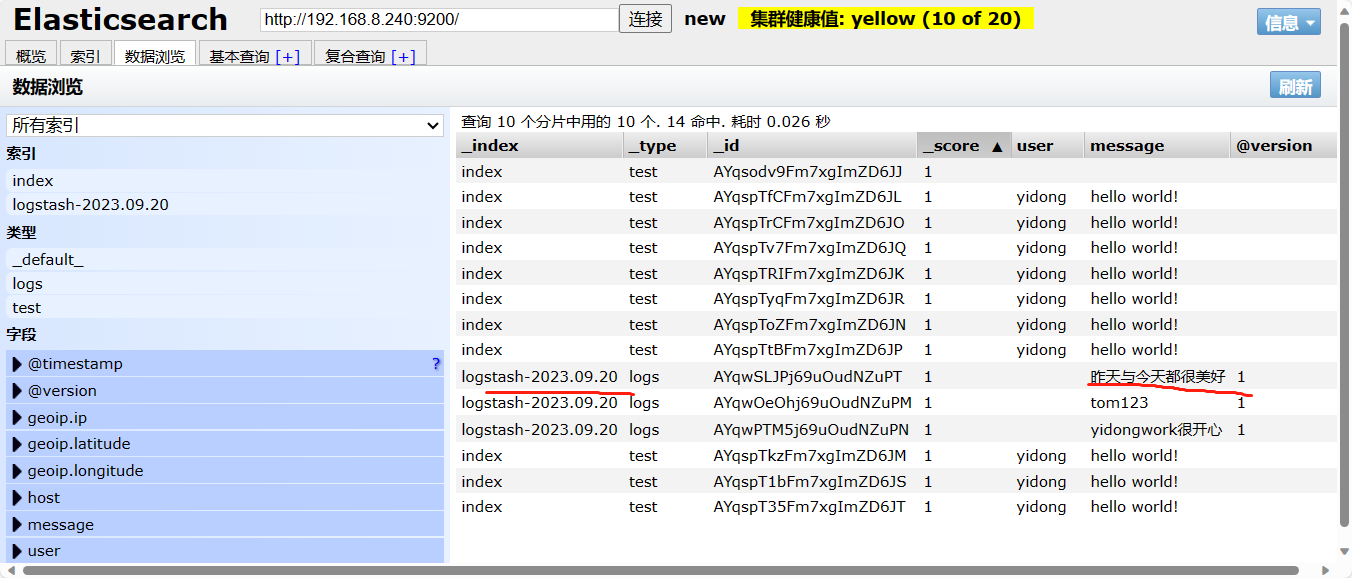

被记录到elk的数据当中:

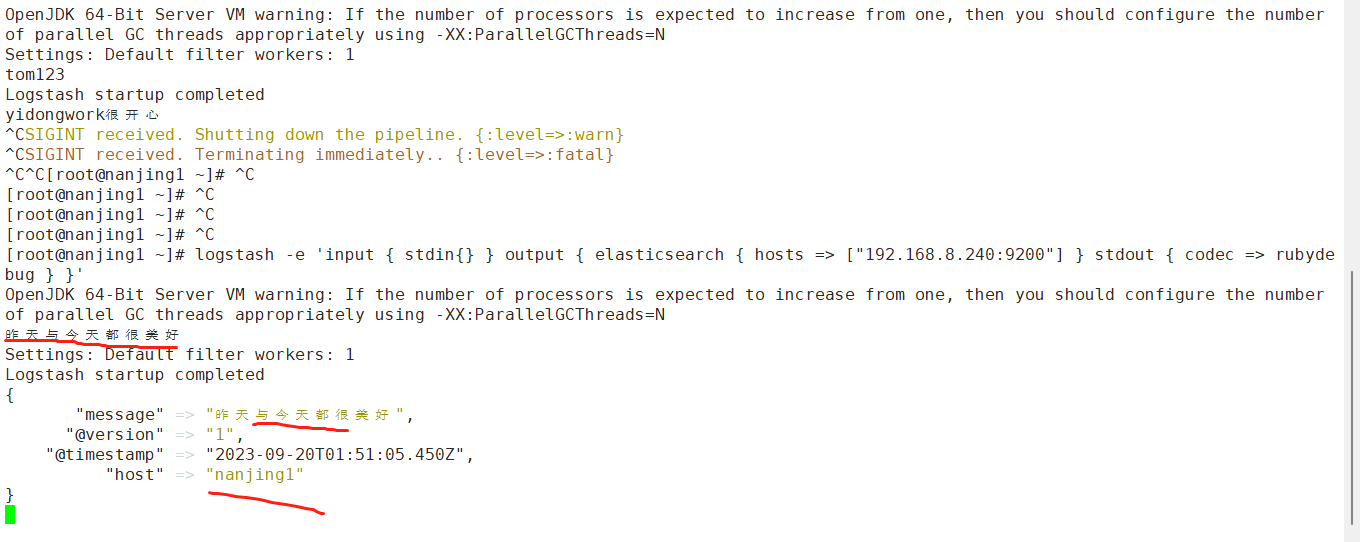

logstash -e 'input { stdin{} } output { elasticsearch { hosts => ["192.168.8.240:9200"] } stdout { codec => rubydebug } }'

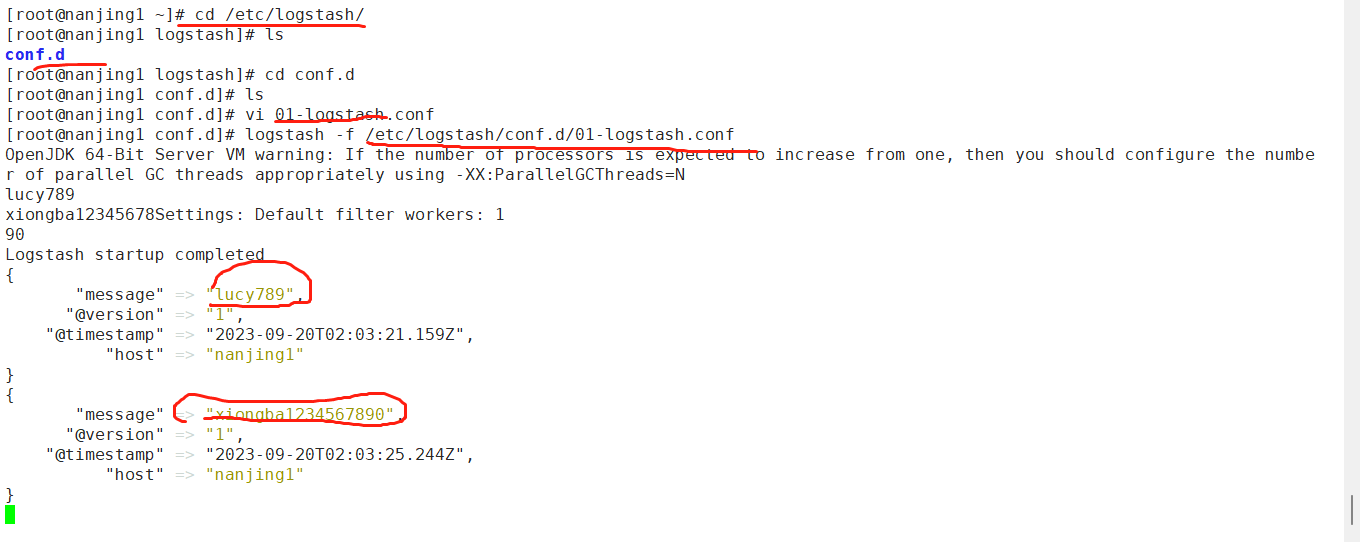

编写配置文件将事件生成到ES

vim /etc/logstash/conf.d/01-logstash.conf

input { stdin { } }

output {

elasticsearch { hosts => ["localhost:9200"] }

stdout { codec => rubydebug }

}

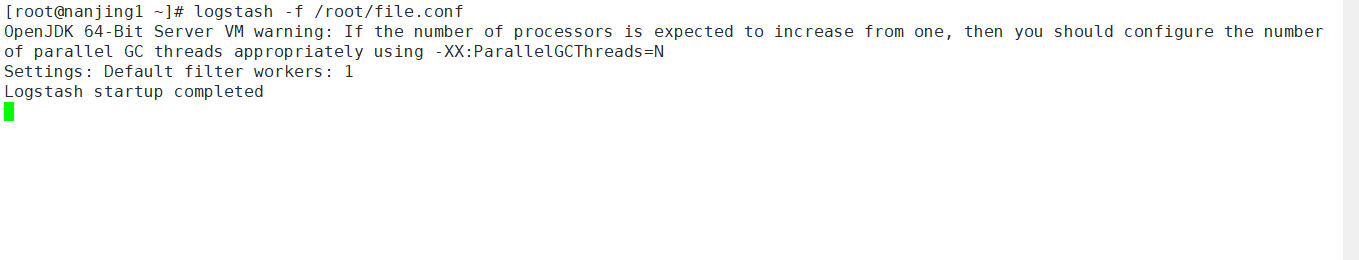

logstash -f /etc/logstash/conf.d/01-logstash.conf #配置文件生效

使用logstash收集日志(系统日志、java异常日志、事件优化处理)

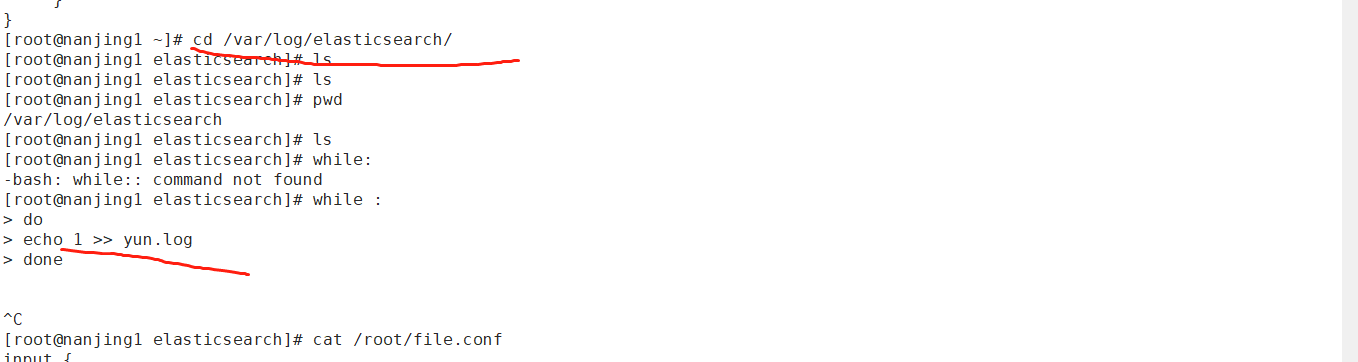

[root@nanjing1 elasticsearch]# cat /root/file.conf

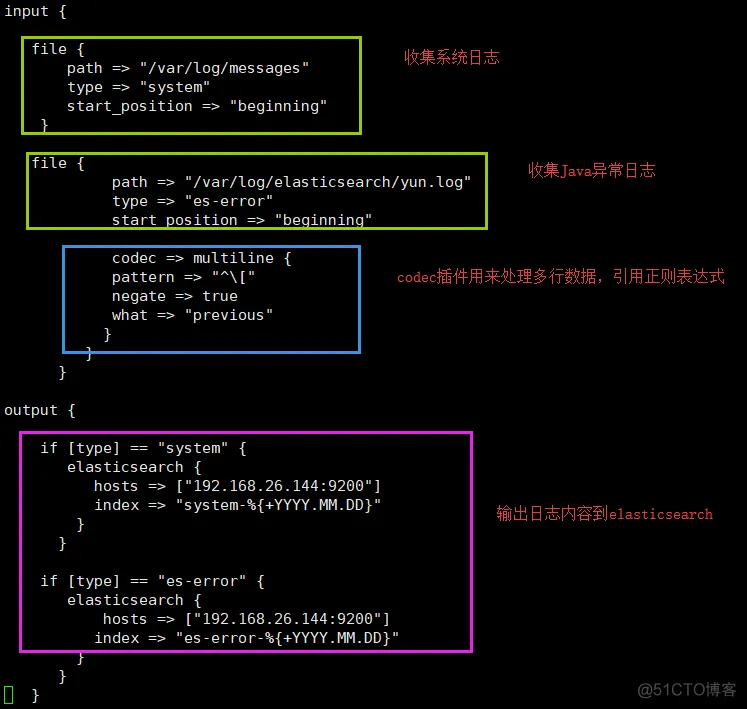

input {

file {

path => "/var/log/messages" #系统日志

type => "system"

start_position => "beginning"

}

file {

path => "/var/log/elasticsearch/yun.log" #java异常日志

type => "es-error"

start_position => "beginning"

codec => multiline { #多行优化处理

pattern => "^\["

negate => true

what => "previous"

}

}

}

output {

if [type] == "system" {

elasticsearch {

hosts => ["192.168.8.240:9200"]

index => "system-%{+YYYY.MM.dd}"

}

}

if [type] == "es-error" {

elasticsearch {

hosts => ["192.168.8.240:9200"]

index => "es-error-%{+YYYY.MM.dd}"

}

}

}

[root@nanjing1 elasticsearch]#

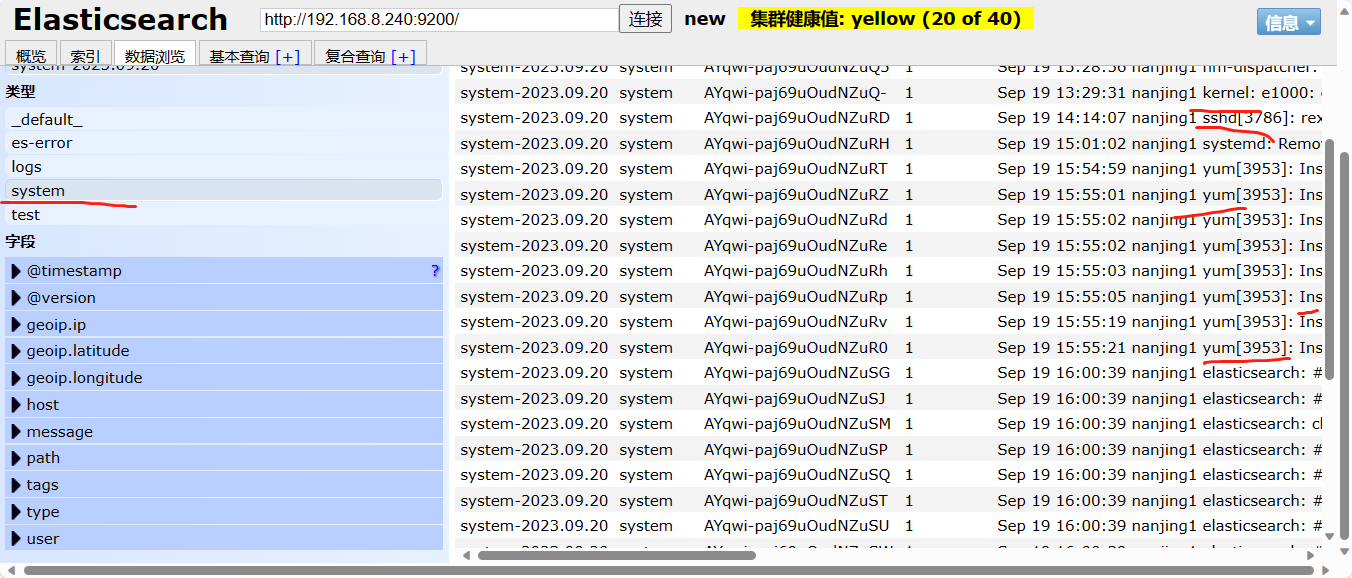

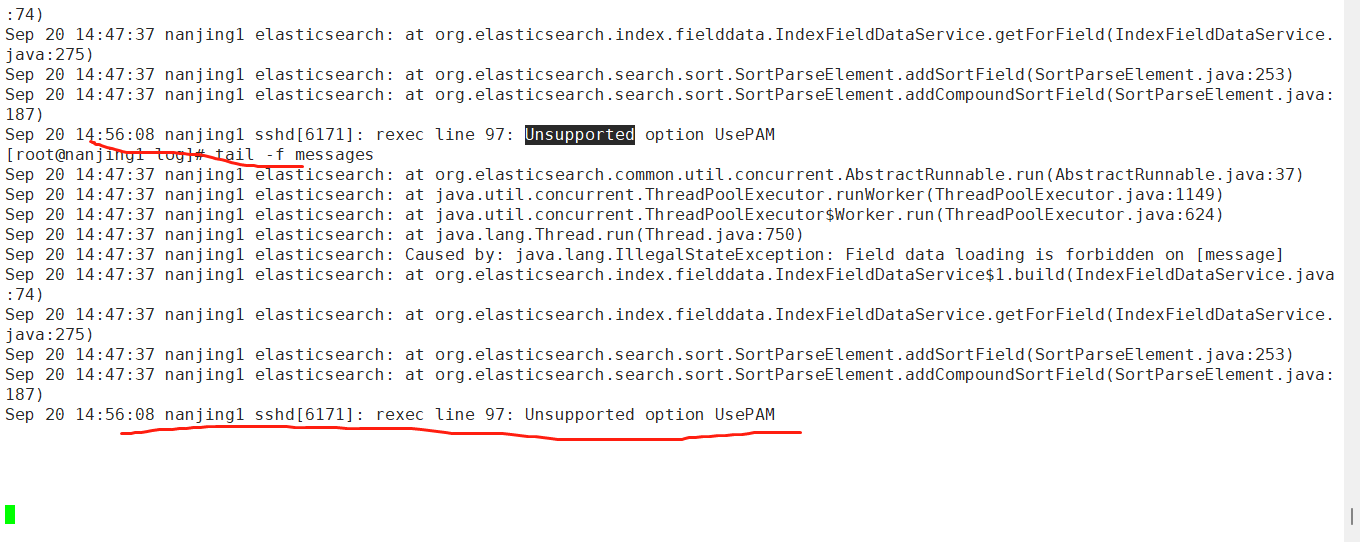

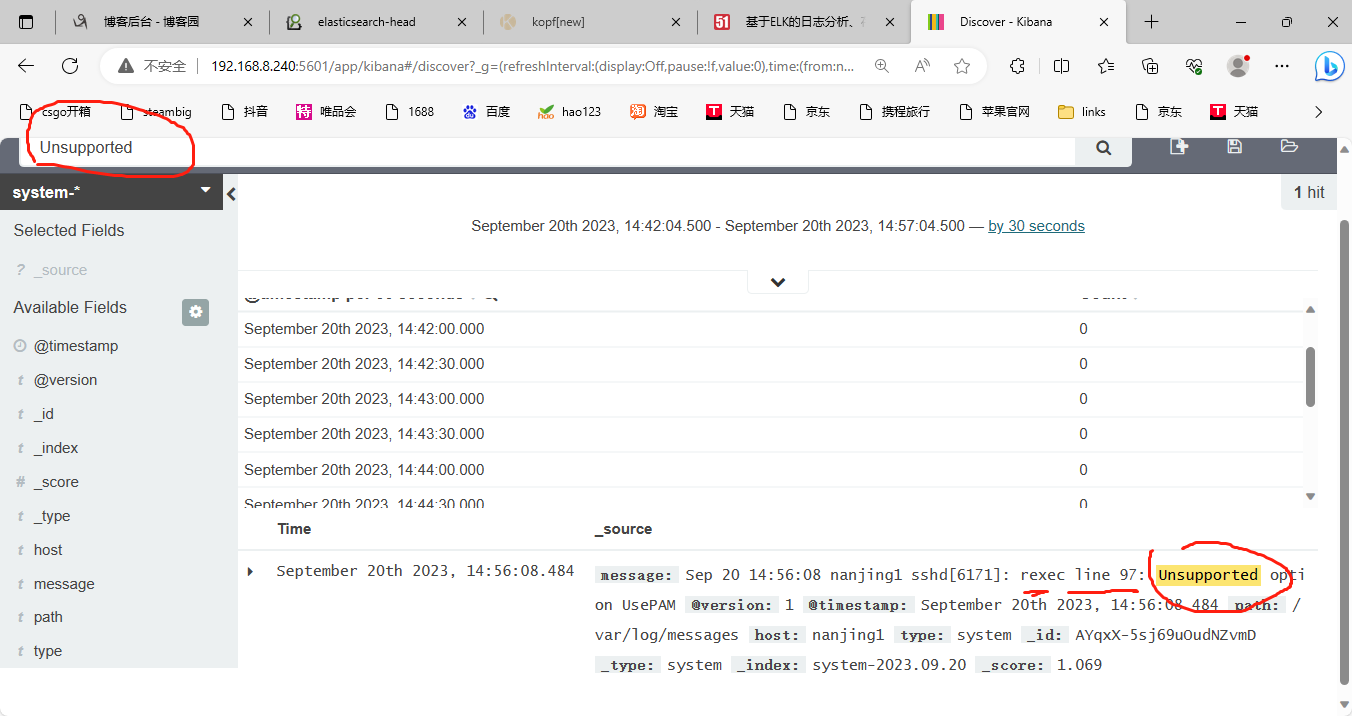

系统日志:

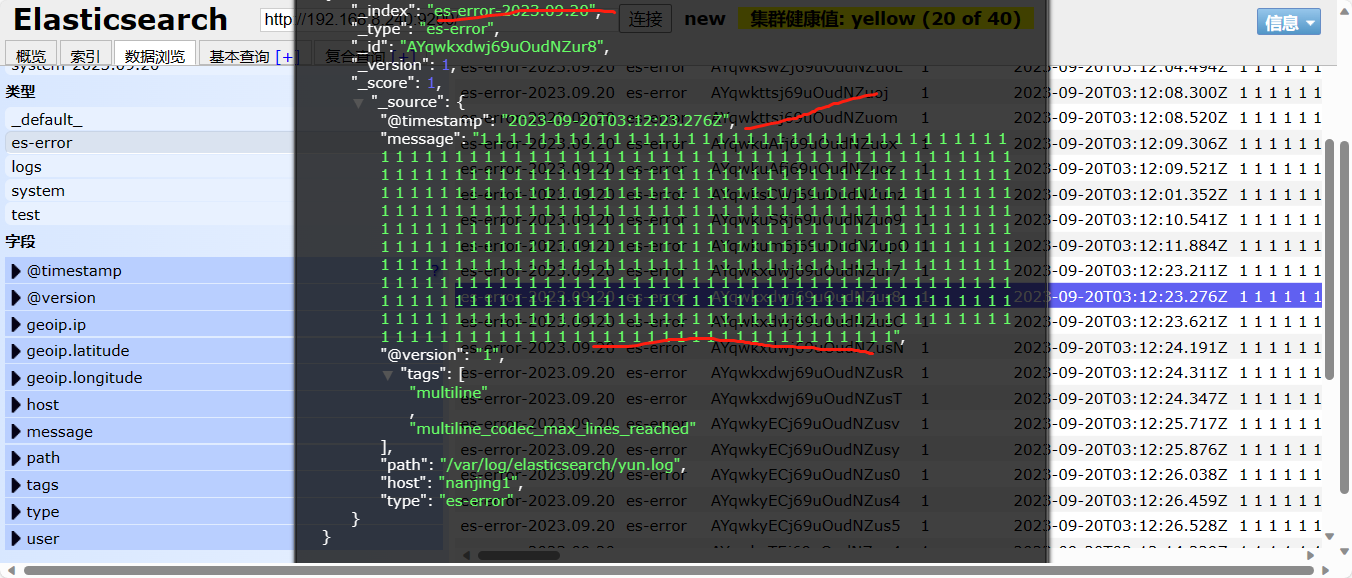

下面显示的是java日志::::

将日志链接到kibana服务当中去,如下

@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@

部署的完整过程:

基于ELK的日志分析、存储、展示

原创小樱桃Cherry2018-08-24 12:39:06博主文章分类:Docker容器与虚拟化技术©著作权

ELK简介

ELK是一套完整的日志解决方案,由ElasticSearch、Logstash、 Kibana

这三款开源软件组成。

- EastiSearch是基于Lucene开发的分布式存储检引擎,用来存储各类日志;

- Logstash对日志进行收集、分析,并将其存储供以后使用:

- Kibana 是基于Node.js开发的展示工具,为Logstah和ElasticSearch提供用于日志展示的Web界面,还用于帮助汇总、分析和搜索重要日志数据。

ELK官网https://www.elastic.co/products 分别提供包进行下载安装。

ELK工作原理

- 在所有需要收集日志的服务上部署Logstash,作为署Logstash agent用于监控并过滤所收集的日志,将过滤后的内容整合在一起,最终全部交给EastiSearch检索引擎;

- 用EastiSearch进行自定义检索;

- 再通过Kibana通过结合自定义检索内容生成图表,进行日志数据展示。

部署ElasticSearch

1.安装ElasticSearch

2.安装Java

3.修改配置文件elasticsearch.yml

4.创建配置文件中的工作目录,并修改其属性

5.启动ElasticSearch服务,并查看其端口9200

6.通过浏览器访问9200端口

7.ES交互

通过RESTful API (通过json格式交互)

`

8.安装插件

安装完成后在plugins目录下可以看到head和kopf

可以在web界面上输入数据,再查询

9.部署ES多集群

在第二台服务器上同时安装ES服务同上,需要注意的是修改配置文件elasticsearch.yml有些许不同。

启动elasticsearch

同样在第一台服务器node1中配置文件修改,再重启服务

访问head可以看到ES的主分片和副本分片

访问kopf可以看到ES的集群节点信息

9.生产环境注意内存解锁和文件限制

修改配置文件/etc/security/limits.conf

重启生效

部署Logstash

1.安装Logstash

2.创建链接,识别logstash命令

3.配置Logstash收集

Logstash使用input和output定义收集日志时的输入和输出。

- input常用的输入源有:

file、syslog、redis、log4j、apache log或nginx log,或者其他一些自定义的log格式。- output常用的输出有:

elasticsearch比较常用,fle:写入文件,redis: 写入队列,hdfs: 写入HDFS,需插件支持,zabbix: zabbix监控,mongodb: 写入mongodb库,除此之外编码插件codes也比较常用,经常用来处理json数据或者多行数据源。

(1)定义输入和输出流,类似管道

(2)详细格式显示

(3)写入到elasticsearch中

(4)写入ES和同时生成文本

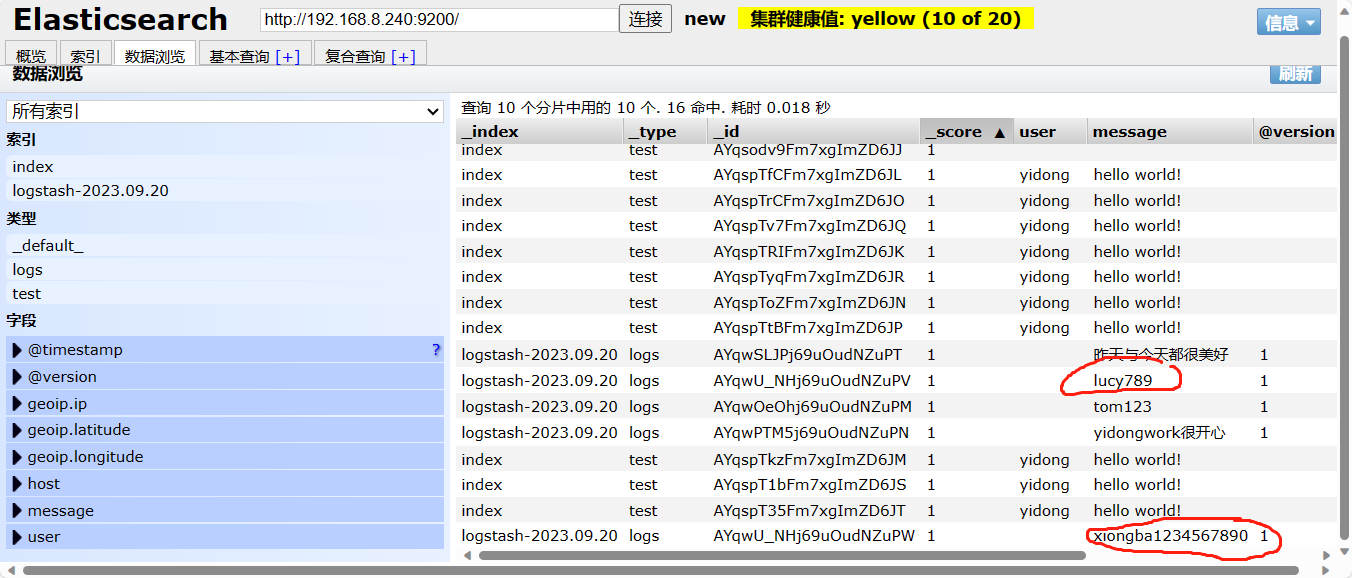

(5)编写配置文件将事件生成到ES

5.使用logstash收集日志(系统日志、java异常日志、事件优化处理)

编写配置文件将日志生成到ES中

部署kibana

1.安装kibana

2.编辑kibana配置文件

3.启动kibana

ctrl+a+d 进行丢入后台

4.访问kibana

- 打赏

- 2赞

- 2收藏

- 评论

- 举报